Das Schreiben eines Berichts über den Stand der KI muss sich so anfühlen, als würde man auf Treibsand bauen: Bis Sie auf „Veröffentlichen“ klicken, hat sich die gesamte Branche unter Ihren Füßen verändert. Aber es gibt immer noch wichtige Trends und Imbissbuden Stanfords 386-seitiges Angebot um diesen komplexen und schnelllebigen Bereich zusammenzufassen.

Der KI-Index des Institute for Human-Centered Artificial Intelligence arbeitete mit Experten aus Wissenschaft und Privatwirtschaft zusammen, um Informationen und Vorhersagen zu diesem Thema zu sammeln. Als jährliche Anstrengung (und bei der Größe davon können Sie wetten, dass sie bereits hart daran arbeiten, die nächste zu entwerfen), ist dies vielleicht nicht die neueste Version von KI, aber diese regelmäßigen breiten Umfragen sind wichtig, um den Finger im Auge zu behalten am Puls der Industrie.

Der diesjährige Bericht enthält „neue Analysen zu Gründungsmodellen, einschließlich ihrer Geopolitik und Schulungskosten, der Umweltauswirkungen von KI-Systemen, K-12-KI-Ausbildung und Trends der öffentlichen Meinung in KI“, sowie einen Blick auf die Politik in hundert neuen Ländern.

Lassen Sie uns nur die wichtigsten Takeaways aufzählen:

- Die KI-Entwicklung hat sich in den letzten zehn Jahren mit großem Abstand von der Wissenschaft zu der Industrie geführt, und dies zeigt keine Anzeichen einer Änderung.

- Es wird immer schwieriger, Modelle mit herkömmlichen Benchmarks zu testen, und hier könnte ein neues Paradigma erforderlich sein.

- Der Energie-Fußabdruck von KI-Training und -Nutzung wird beträchtlich, aber wir müssen noch sehen, wie es anderswo zu Effizienzsteigerungen führen kann.

- Die Zahl der „KI-Vorfälle und Kontroversen“ hat sich seit 2012 um den Faktor 26 erhöht, was eigentlich etwas niedrig erscheint.

- KI-bezogene Fähigkeiten und Stellenausschreibungen nehmen zu, aber nicht so schnell, wie Sie denken.

- Die politischen Entscheidungsträger überschlagen sich jedoch bei dem Versuch, eine endgültige KI-Rechnung zu schreiben, eine dumme Besorgung, wenn es jemals eine gegeben hat.

- Die Investitionen sind vorübergehend ins Stocken geraten, aber das ist nach einem astronomischen Anstieg in den letzten zehn Jahren.

- Mehr als 70 % der chinesischen, saudischen und indischen Befragten waren der Meinung, dass KI mehr Vorteile als Nachteile hat. Amerikaner? 35%.

Aber der Bericht geht detailliert auf viele Themen und Unterthemen ein und ist gut lesbar und nicht technisch. Nur die Engagierten werden alle 386 Seiten der Analyse lesen, aber wirklich fast jeder motivierte Körper könnte dies tun.

Schauen wir uns Kapitel 3, Technische KI-Ethik, etwas detaillierter an.

Voreingenommenheit und Toxizität sind schwer auf Metriken zu reduzieren, aber soweit wir Modelle für diese Dinge definieren und testen können, ist klar, dass „ungefilterte“ Modelle viel, viel einfacher in problematisches Gebiet zu führen sind. Anweisungsabstimmung, d. h. das Hinzufügen einer Schicht zusätzlicher Vorbereitung (z. B. einer versteckten Eingabeaufforderung) oder das Weiterleiten der Ausgabe des Modells durch ein zweites Mediatormodell, ist effektiv, um dieses Problem zu verbessern, aber es ist bei weitem nicht perfekt.

Die Zunahme von „KI-Vorfällen und Kontroversen“, auf die in den Aufzählungszeichen angespielt wird, lässt sich am besten durch dieses Diagramm veranschaulichen:

Bildnachweis: Stanford HAI

Wie Sie sehen können, ist der Trend steigend und diese Zahlen kamen vor der Mainstream-Einführung von ChatGPT und anderen großen Sprachmodellen, ganz zu schweigen von der enormen Verbesserung der Bildgeneratoren. Sie können sicher sein, dass die 26-fache Erhöhung nur der Anfang ist.

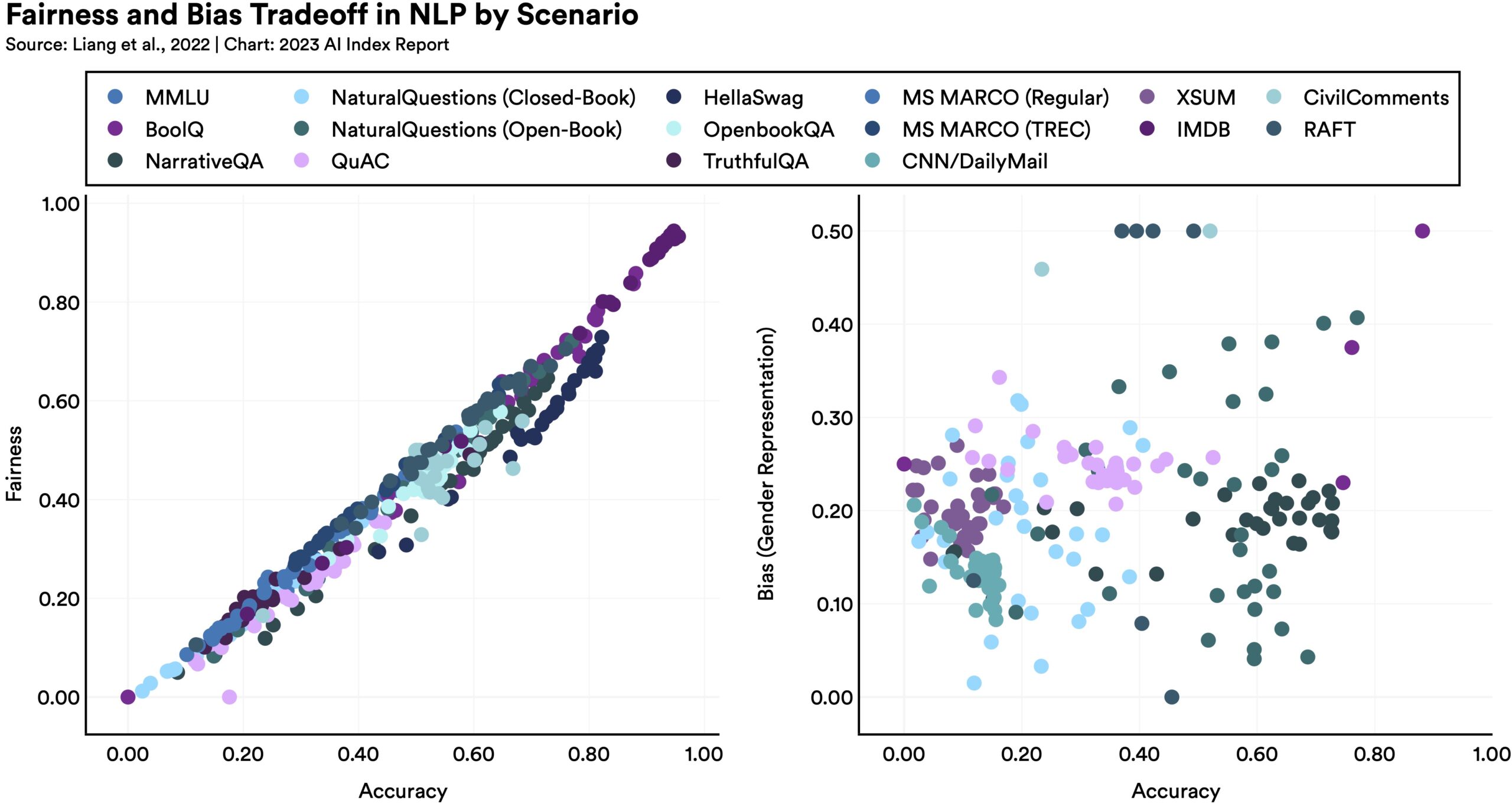

Modelle auf eine Weise fairer oder unvoreingenommener zu machen, kann unerwartete Konsequenzen für andere Metriken haben, wie dieses Diagramm zeigt:

Bildnachweis: Stanford HAI

Wie der Bericht feststellt, „haben Sprachmodelle, die bei bestimmten Fairness-Benchmarks besser abschneiden, tendenziell eine stärkere geschlechtsspezifische Verzerrung.“ Warum? Es ist schwer zu sagen, aber es zeigt nur, dass die Optimierung nicht so einfach ist, wie alle hoffen. Es gibt keine einfache Lösung, um diese großen Modelle zu verbessern, teilweise weil wir nicht wirklich verstehen, wie sie funktionieren.

Die Überprüfung von Fakten ist einer dieser Bereiche, die sich wie eine natürliche Ergänzung für KI anhören: Nachdem sie einen Großteil des Webs indiziert hat, kann sie Aussagen bewerten und das Vertrauen zurückgeben, dass sie von wahrheitsgemäßen Quellen gestützt werden, und so weiter. Dies ist weit davon entfernt. KI ist tatsächlich besonders schlecht darin, Tatsachen zu bewerten, und das Risiko besteht nicht so sehr darin, dass sie unzuverlässige Prüfer sind, sondern dass sie selbst zu mächtigen Quellen überzeugender Fehlinformationen werden. Eine Reihe von Studien und Datensätzen wurden erstellt, um die KI-Faktenprüfung zu testen und zu verbessern, aber bis jetzt sind wir immer noch mehr oder weniger dort, wo wir angefangen haben.

Glücklicherweise ist das Interesse hier stark gestiegen, aus dem offensichtlichen Grund, dass die gesamte Branche zurückgeworfen wird, wenn die Menschen das Gefühl haben, der KI nicht vertrauen zu können. Bei der ACM-Konferenz zu Fairness, Rechenschaftspflicht und Transparenz gab es einen enormen Anstieg der Einreichungen, und bei NeurIPS erhalten Themen wie Fairness, Datenschutz und Interpretierbarkeit mehr Aufmerksamkeit und Bühnenzeit.

Diese Highlights der Highlights hinterlassen viele Details auf dem Tisch. Das HAI-Team hat jedoch großartige Arbeit bei der Organisation des Inhalts geleistet und danach Durchlesen der High-Level-Sachen hierdu kannst Laden Sie das vollständige Papier herunter und vertiefen Sie sich in jedes Thema, das Ihr Interesse weckt.