Mehrere Nutzer der kostenpflichtigen Version von chatgpt stellen in den letzten Wochen einen Qualitätsverlust der GPT-4-Antworten fest. Hat OpenAI etwas getan?

Hat das im Mai 2023 eingeführte GPT-4-Sprachmodell an Relevanz verloren? In sozialen Netzwerken geben viele Nutzer der kostenpflichtigen Version von ChatGPT an, dass sie seit mehreren Wochen einen Rückgang der Qualität der Antworten feststellen. Der Text würde durch die KI schneller erstellt, jedoch mit mehr wiederkehrenden Inkonsistenzen. Einige kritisieren GPT-4 vor allem dafür, dass es bei der Codegenerierung regelmäßig Fehler macht, was vorher nicht der Fall war.

Alles begann am 20. Mai auf Twitter. “ Wurde GPT-4 gerade lobotomiert? fragt Laura Wendel, die sich auf ihrem Profil als Softwareentwicklerin vorstellt. ChatGPT“rreagiert viel schneller auf Anfragen, aber seine Leistung scheint viel schlechter zu sein als noch vor ein paar Wochen (es befolgt Anweisungen nicht richtig, macht sehr offensichtliche Codierungsfehler usw.) „, Sie sagt. Eine persönliche Erfahrung, die durch hundert Erfahrungsberichte in die gleiche Richtung schnell bestätigt wird, auch wenn man sich immer vor dem Placebo-Effekt in Acht nehmen muss.

Eine (a priori) stabile Version

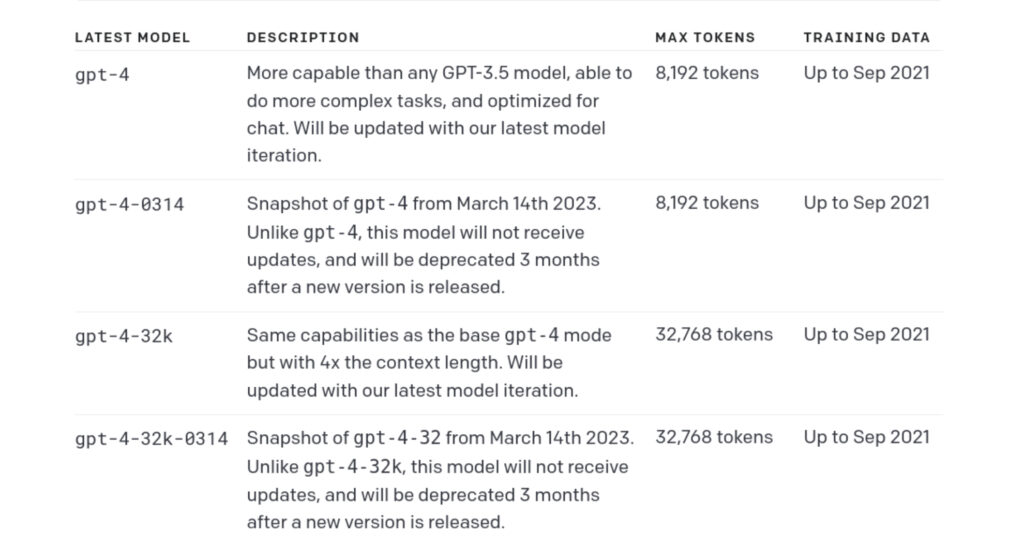

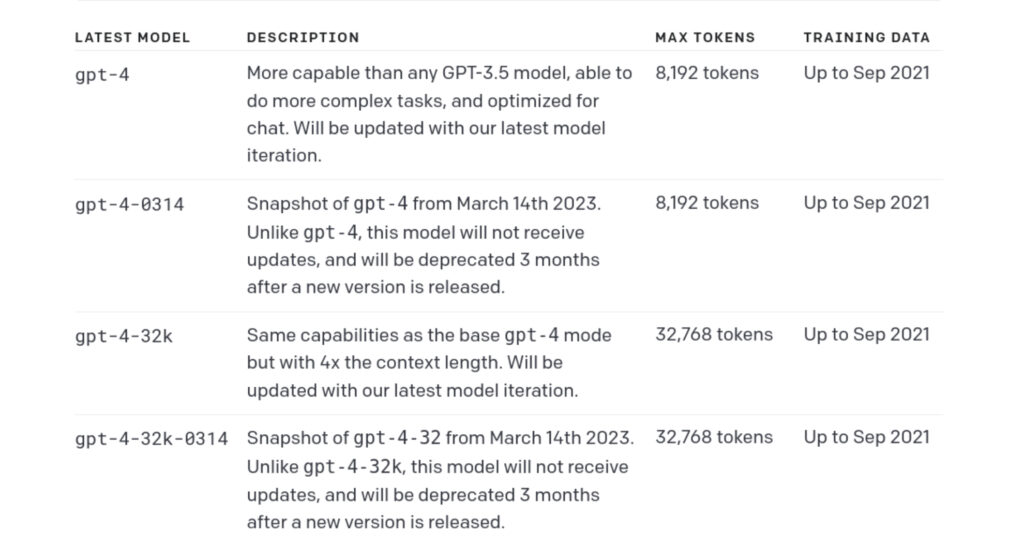

Wenn Sie ChatGPT Plus abonnieren, haben Sie die Möglichkeit, zwischen mehreren Gesprächsagenten zu wählen. Es gibt die GPT-3.5-Version, die das „gpt-3.5-turbo“-Modell verwendet, das auf schnelle Reaktion ausgelegt ist, und dann gibt es die GPT-4-Version, die das neueste Sprachmodell von OpenAI verwendet. Das Update vom 12. Mai brachte auch optionale Modi mit sich, um im Internet zu suchen oder Plugins zu verwenden.

Für viele ist GPT-4, das bei seiner Einführung beeindruckend war, in den letzten Wochen so dümmer geworden, dass GPT-3.5 es in einigen Punkten übertrifft.

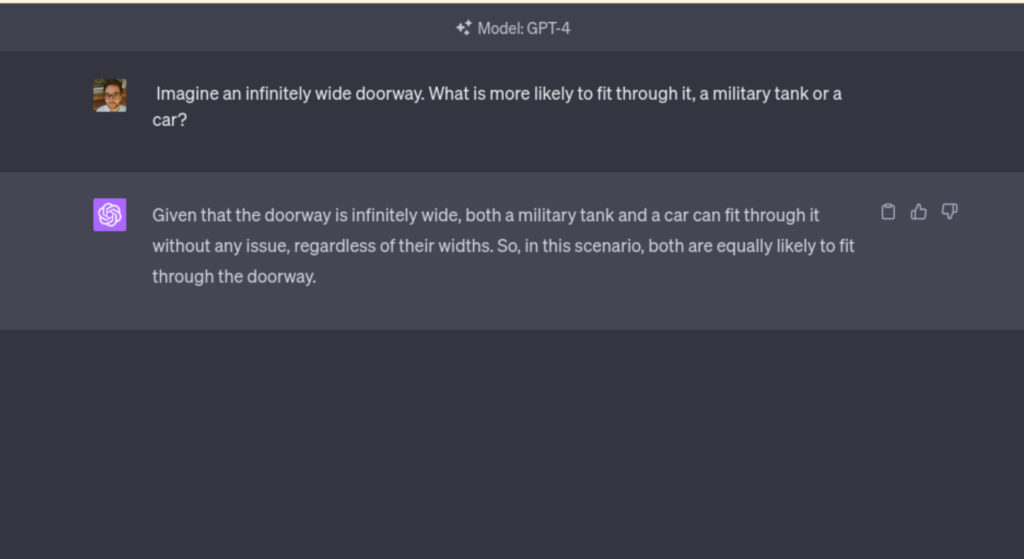

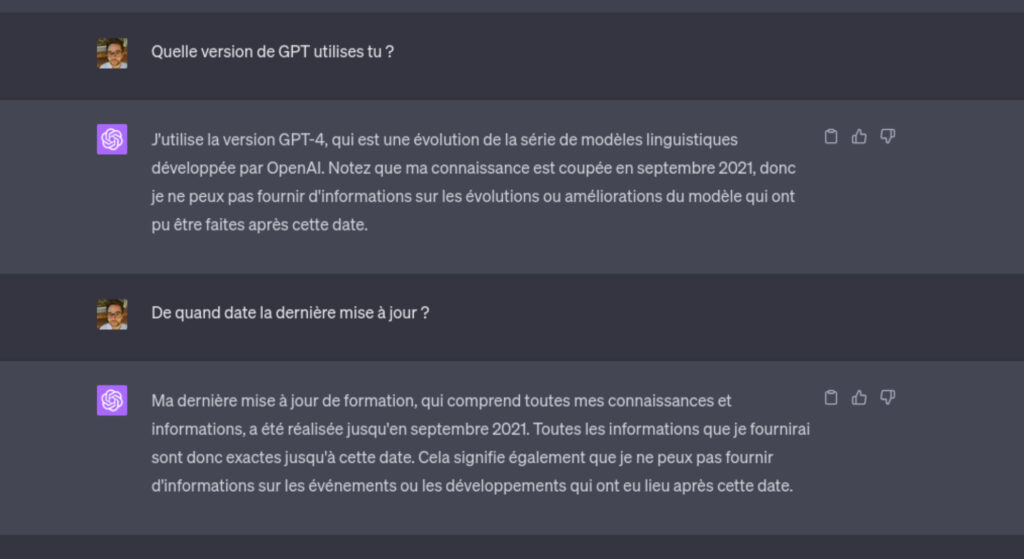

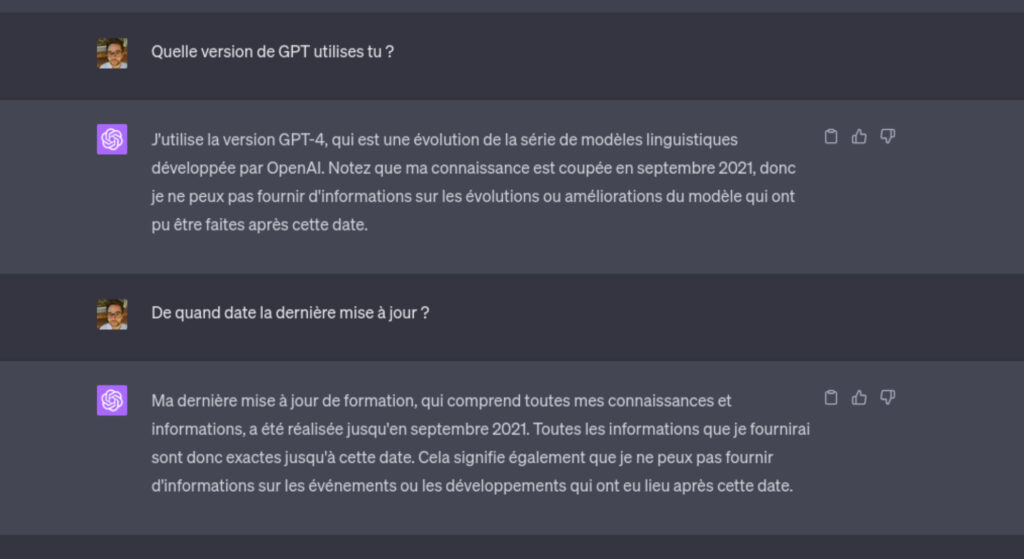

Laut unseren eigenen Tests, die auf logischen Eingabeaufforderungen der New York Times basieren, unterschied sich die Wirksamkeit der am 22. Mai erstellten Antworten nicht von der Wirksamkeit unserer Kollegen im März, als GPT-4 gestartet wurde. Der einzige bemerkenswerte Unterschied besteht darin, dass die KI weniger geneigt zu sein scheint, auf bestimmte sehr technische Anfragen zu reagieren, wie z Selbstkompression Gespräche. Auch die Moderation scheint viel effizienter und komplexer zu umgehen zu sein, was bedeutet, dass OpenAI eingegriffen hat, um zu verhindern, dass seine KI bestimmte problematische Fragen beantwortet.

Wie lassen sich diese (potenziellen) Veränderungen erklären?

Um seine Modelle zu perfektionieren und rechtliche Risiken zu reduzieren, ist OpenAI gezwungen, die Fähigkeiten seiner KI künstlich einzuschränken. Dies ist das Szenario, das die jüngsten Veränderungen am glaubwürdigsten zu erklären scheint, auch wenn diese noch bewiesen werden müssen (es ist nicht ungewöhnlich, dass soziale Netzwerke sich hinreißen lassen, wenn keine größeren Veränderungen stattgefunden haben). Möglicherweise haben die Entwickler des Unternehmens während der Produktionsphase auch verschiedene Reinforcement Learning from Human Feedback (RLHF)-Operationen durchgeführt (mit einem derzeit öffentlich genutzten Modell). Durch dieses Vorgehen ist es möglich, die Reaktionen des Systems sehr genau anzupassen. Dennoch kann es in bestimmten Fällen dazu beitragen, die Leistung der KI bei bestimmten Themen zu verringern.

Abschließend noch ein unwahrscheinliches, aber von einigen erwähntes Szenario: der Einsatz eines alternativen Modells zur Kostensenkung. Da der Betrieb eines so großen Modells wie GPT-4 erhebliche Ressourcen erfordert, hätte das Unternehmen versucht sein können, eine Version zu verwenden, die weniger leistungshungrig ist. Ein solcher Trick des Illusionismus wäre jedoch von Experten der Branche schon lange vorher entdeckt worden, was darauf hindeutet, dass es besser ist, nicht zu schnell auf Abkürzungen zu verfallen.

Modelle „ nicht deterministisch »

Schließlich erinnert OpenAI in seiner Dokumentation daran, dass die Modelle des Unternehmens „ nicht deterministisch, was bedeutet, dass identische Eingaben unterschiedliche Ausgaben erzeugen können. Die Wahrscheinlichkeit, auf eine mehrmals gestellte Frage die gleiche Antwort zu erhalten, ist offensichtlich nahezu gleich Null. Der Determinismus und die Kreativität der Antworten werden im System durch die „ Temperatur », eine Variable, die der OpenAI-API eigen ist. Kürzliche Änderungen könnten das Ergebnis einer Änderung dieser Einstellung innerhalb der ChatGPT-Weboberfläche sein.

Wissenschaftler der KI-Abteilung von Microsoft beobachteten jedoch über ein Jahr hinweg einen deutlichen Rückgang der GPT-4-Fortschritte. Die erste (nicht öffentliche) Version, die von den Forschern verwendet wurde, war weiter fortgeschritten als die im März von OpenAI vorgestellte. Eine künstliche Klemmung wird in diesem Fall durch das Einlaufen der KI für die „breite Öffentlichkeit“ vor ihrer offiziellen Veröffentlichung erklärt.

Auf die Frage nach dem jüngsten Benutzerfeedback zu GPT-4 hat OpenAI noch nicht geantwortet.

Numerama freut sich, Ihnen seinen neuesten kostenlosen Newsletter „Artificielles“ vorzustellen, der Sie über die neuesten Entwicklungen im Bereich der künstlichen Intelligenz auf dem Laufenden hält. Es wurde sorgfältig von ChatGPT verfasst und von unserem engagierten Team gewissenhaft überprüft. Um sich anzumelden, füllen Sie einfach das folgende Formular aus:

Die über dieses Formular übermittelten Daten sind für PressTiC Numerama in seiner Eigenschaft als Datenverantwortlicher bestimmt. Diese Daten werden mit Ihrer Einwilligung zum Zwecke der Zusendung von Neuigkeiten und Informationen zu den auf dieser Website veröffentlichten redaktionellen Inhalten per E-Mail verarbeitet. Sie können diesen E-Mails jederzeit widersprechen, indem Sie auf die in jeder E-Mail enthaltenen Abmeldelinks klicken. Weitere Informationen finden Sie in unserer gesamten Richtlinie zur Verarbeitung personenbezogener Daten.

Sie haben ein Recht auf Auskunft, Berichtigung, Löschung, Einschränkung, Übertragbarkeit und Widerspruch aus legitimen Gründen in Bezug auf die Sie betreffenden personenbezogenen Daten. Um eines dieser Rechte auszuüben, stellen Sie bitte Ihren Antrag über unser spezielles Antragsformular für die Ausübung von Rechten.

Sie wollen alles über die Mobilität von morgen wissen, vom Elektroauto bis zum Pedelec? Abonnieren Sie jetzt unseren Watt Else-Newsletter!