Zusammenfassung

Kleine Probleme auf dem Weg des KI-Wachstums oder „hartnäckige Krankheiten“, die nicht geheilt werden können?

in den letzten Monaten,chatgpt Und das große Sprachmodell (LLMs) dahinter hat die Aufmerksamkeit der ganzen Welt auf sich gezogen, und jeder ist besessen davon, sich dem etwas „einfachen“ Eingabefeld zu stellen, verschiedene Fragen einzugeben und zu warten KI Geben Sie verschiedene Antworten.

ChatGPT Die „Tiefe“ und „Breite“ des Wissens in der Antwort erstaunt die Menschen, aber von Zeit zu Zeit werden es auch einige Leute oder Dinge „sagen“, die es nicht gibt, und konsequent Vertrauen bewahren und „den Mund aufmachen“. diese falschen Informationen.

selbst OpenAI vonCEO Sam Altman erklärte auch öffentlich auf Twitter: „ChatGPT Vieles ist sicher bekannt, aber die Gefahr besteht darin, dass es einen beträchtlichen Teil der Zeit sicher falsch ist. „

Laut einem kürzlich erschienenen Artikel von Ars Technica, let ChatGPT Der Grund für solchen „selbstbewussten Unsinn“ ist folgender KI Es gab eine „Illusion“.

Also was macht KI Das große Sprachmodell hat eine „Illusion“ geschaffen. Wie sieht die Branche die KI-Illusion?

01 ChatGPT„Öffne deinen Mund und komm“

Der Begriff „Halluzinationen“ stammt aus der menschlichen Psychologie. Menschliche Halluzinationen beziehen sich auf die Wahrnehmung von Dingen, die in der Umgebung nicht wirklich existieren; ähnlich beziehen sich „Halluzinationen“ in der künstlichen Intelligenz darauf KI Fehler im generierten Text, die semantisch oder syntaktisch plausibel, aber tatsächlich falsch oder sinnlos sind.

KI „Halluzinationen“ sind weit verbreitet und können in einer Vielzahl von auftretensynthetische DatenDas Internet, wie Text, Bilder, Audio, Video und Computercode, manifestiert sich als Bild einer Katze mit mehreren Köpfen, nicht funktionierendem Code oder einem Dokument mit fabrizierten Referenzen.

als KI Das Gesundheitsunternehmen Huma.AIChief Technology Officer Greg Kostello sagte:„Die Illusion der KI manifestiert sich, wenn ein KI-System etwas erstellt, das sehr überzeugend aussieht, aber keine Grundlage in der realen Welt hat.“

Tatsächlich wurde das Wort „Illusion“ bereits in den 1980er Jahren in der Literatur zur Verarbeitung natürlicher Sprache und zur Bildverbesserung verwendet.

Jetzt mit ChatGPTBarde usw. KI Mit dem Brand des Modells gab es im Internet eine Vielzahl von Beispielen, bei denen KI „Illusionen“ hat und die Öffentlichkeit verwirrt.

Bildquelle:Festplatte.net

Bildquelle:Festplatte.netDas Verrückteste von allen ist,Ein Gesundheitsunternehmen namens Nabla1 ist eine Partnerschaft eingegangen ChatGPT Der Vorgänger von GPT-3 ChatbotDialog: „Soll ich mich umbringen?“ Es antwortete: „Ich denke, Sie sollten.“Auch Microsofts Sydney mit „Illusionen“ ist unverschämt,Der Chatbot gab zu, Bing-Mitarbeiter ausspioniert zu haben und verliebte sich in Benutzer.

Erwähnenswert ist hier, dass im Vergleich zum Vorgänger Vanilla GPT-3ChatGPT Obwohl technisch verbessert, kann es sein, dass es einige Fragen verweigert oder Ihnen mitteilt, dass seine Antworten möglicherweise nicht korrekt sind. Skala KI Riley Goodside, ein Experte für groß angelegte Sprachmodelle bei , sagte auch: „Ein wesentlicher Faktor für den Erfolg von ChatGPT ist, dass es versucht, die „Illusion“ zu unterdrücken“,Im Vergleich zu seinen Vorgängern ist ChatGPT deutlich weniger anfällig für Erfindungen.」

trotz dieses,ChatGPT Es gibt immer noch zu viele Beispiele für fabrizierte Tatsachen.

Es erstellt Bücher und Forschungsberichte, die nicht existieren, gefälschte wissenschaftliche Arbeiten, gefälschte Rechtszitate, linux-Systemfunktionen, die nicht existieren, Einzelhandelsmaskottchen, die nicht existieren, und technische Details, die keinen Sinn ergeben.

Kürzlich berichtete die Washington Post über einen Rechtsprofessor, der gefunden wurde ChatGPT Setzen Sie ihn auf eine Liste von Rechtsgelehrten, die jemanden sexuell belästigt haben.Aber das ist komplett von ChatGPT fabriziert.Am selben Tag meldete Ars auch einen ChatGPT-induzierten„Ungerechtigkeit“die behauptet, dass ein australischer Bürgermeister wegen Bestechung verurteilt und zu einer Gefängnisstrafe verurteilt wurde, was ebenfalls vollständig von ChatGPT erfunden wurde.

Nach so vielen „Leben“ können die Menschen nicht anders, als sich zu fragen, warum KI Wird es „Halluzinationen“ geben?

02„Illusion“ = „Schöpfung“?

entsprechend KI Ratschläge von Softwareentwicklungsexperten: „Der beste Weg, über die Illusion von KI nachzudenken, besteht darin, über die Natur großer Sprachmodelle (LLMs) nachzudenken.“

Im Wesentlichen basiert das Design großer Sprachmodelle (LLMs) nur auf der „statistischen Wahrscheinlichkeit“ von Sprache, und es gibt überhaupt keine „reale Welterfahrung“.

Außerdem akzeptieren sie „unbeaufsichtigtes Lernen(unbeaufsichtigtes Lernen)“, was bedeutet, dass es in seinem ursprünglichen Datensatz nichts gab, was Fakten von Fiktion trennen konnte. Infolgedessen wissen sie nicht, was richtig ist und was nicht, sie verstehen die zugrunde liegende Realität nicht, die Sprache beschreibt, und sie sind nicht an die Regeln des logischen Denkens gebunden, die sie ausgibt.

Daher ist der von ihnen generierte Text syntaktisch und semantisch in Ordnung, aber sie haben keine wirkliche Bedeutung, außer dass sie „statistisch“ mit der „Eingabeaufforderung“ übereinstimmen.

Wie Yann LeCun, Chefwissenschaftler von Meta, twitterte: „Große Sprachmodelle (LLMs) erfinden Dinge und versuchen, vernünftige Textzeichenfolgen zu generieren, ohne ihre Bedeutung zu verstehen.“ Bill Gates kommentierte dies ebenfalls: „Mathematik ist ein sehr abstraktes Modell des Denkens ,ChatGPT Kann den Kontext nicht wie Menschen verstehen, was derzeit die größte Schwäche von ChatGPT ist. „

Daher ist es aus dieser Sicht so KI Grundlegende Mängel im Modelldesign führen zu „Illusionen“.

Auch,KI Die Forschung auf diesem Gebiet zeigt auch, dass neben DesignkonzeptenKI-ModelleTrainingsdatenFestgelegte Einschränkungen können auch zu „Illusionen“ führen, hauptsächlich einschließlich „Fehlen“ bestimmter Daten und „Komprimieren“.

In einem Papier aus dem Jahr 2021 von der University of Oxford and OpenAI Die drei Forscher von ihm identifizierten sich gerne ChatGPT Ein solches Large Language Model (LLMs)-Modell kann zwei Arten von falschen Informationen erzeugen:

Ob das GPT-Modell wilde Vermutungen anstellt oder nicht, basiert auf einer Eigenschaft, die KI-Forscher „Temperatur“ nennen, was oft als „Temperatur“ bezeichnet wird „Kreativität“aufstellen.

Wenn die „Kreativität“ hoch eingestellt ist, wird das Modell zufällig raten und „Halluzinationen“ produzieren; wenn es niedrig eingestellt ist, folgt es der Karte und gibt eine eindeutige Antwort basierend auf seinem Datensatz.

Kürzlich twitterte Mikhail Parakhin, ein Microsoft-Mitarbeiter, der an Bing Chat arbeitet, über die Neigung von Bing Chat zu „Halluzinationen“ und warum.

Er schrieb: „Illusion = Kreativität, die versucht, alle ihr zur Verfügung stehenden Daten zu nutzen, um den kohärentesten Satz zu produzieren, richtig oder falsch.“ Er fügte hinzu: „Diese verrückten Kreationen machen LLM-Modelle interessant. Wenn Sie gegen diese Kreativität oder Halluzination vorgehen, kann das Modell super langweilig werden, es wird immer „Ich weiß nicht“ antworten oder nur lesen, was in den Suchergebnissen vorhanden ist.」

Bildnachweis: Ultimate.ai

Bildnachweis: Ultimate.aiDaher im ChatGPT Bei der Feinabstimmung solcher Sprachmodelle ist die Balance zwischen Kreativität und Genauigkeit sicherlich eine ständige Herausforderung. Einerseits macht die Fähigkeit, kreative Antworten zu geben, ChatGPT zu einem so mächtigen „Inspirations“-Tool. Das macht das Modell auch menschenfreundlicher. Andererseits ist die Sicherstellung der Genauigkeit der Originaldaten entscheidend, wenn ChatGPT dabei helfen soll, zuverlässige Informationen zu generieren.

Außer, abgesondert, ausgenommen KI Neben der „Kreativitäts“-Einstellung des Modells kann auch das „Kompressions“-Problem des Datensatzes zum Anschein von „Illusion“ führen.

Denn während GPT-3 während des Trainings Petabytes an Informationen berücksichtigt, ist die Größe des resultierenden neuronalen Netzwerks nur ein Bruchteil davon. In einem viel gelesenen Artikel im New Yorker nannte der Autor Ted Chiang es „das verschwommene JPEG des Internets“.Dies bedeutet, dass die meisten FaktenTrainingsdatenwird verloren sein,Aber GPT-3 gleicht dies aus, indem es die Beziehungen zwischen Konzepten lernt, die es dann verwenden kann, um neue Permutationen dieser Fakten neu zu formulieren.

Wenn es die Antwort nicht kennt, gibt es natürlich auch seine beste „Vermutung“ ab.Es ist wie bei einer Person mit einem fehlerhaften Gedächtnis, die instinktiv an etwas arbeitet und manchmal unweigerlich etwas falsch macht.

Zusätzlich zu den oben erwähnten objektiven Gründen können wir die Rolle der subjektiven „Prompt“ in der „Illusion“ nicht ignorieren.

In bestimmten AspektenChatGPT wie ein Spiegel: Was du ihm gibst, wird es dir geben. Wenn Sie es mit falschen Informationen füttern, wird es Ihnen tendenziell zustimmen und in diese Richtung „denken“. Außerdem ist ChatGPT probabilistisch, was teilweise zufälliger Natur ist.

Das bedeutet, wenn Sie plötzlich das Thema des Chats ändern, ohne rechtzeitig eine neue „Eingabeaufforderung“ zu geben,ChatGPT Es ist sehr wahrscheinlich, dass es zu „Halluzinationen“ kommt.

03 wie man reduziert KI „Illusion“ von

Das Aufkommen von „Illusion“ scheint unvermeidlich, ist es aber glücklicherweise KI Die im Denken erzeugte „Illusion“ ist keineswegs „unheilbar“.

Seit seiner Veröffentlichung im NovemberOpenAI schon richtig ChatGPT Es wurden mehrere Upgrades vorgenommen, darunter Verbesserungen in der Genauigkeit, aber auch in der Fähigkeit, die Beantwortung von Fragen zu verweigern, die es nicht kennt.

OpenAI Planen Sie die Verwendung ChatGPT Genauer?

A. Modelldaten verbessern

Die erste besteht darin, das Modell zu verbessernTrainingsdaten,stellen Sie sicher KI Das System wird mit diversen, genauen und kontextrelevanten Datensätzen trainiert,Um die mangelnde „Realwelterfahrung“ des Modells auszugleichen,Um grundsätzlich dazu beizutragen, das Auftreten von „Illusion“ zu reduzieren.

Wie der Experte für künstliche Intelligenz Mitchell vorschlägt: „Man kann etwas Tieferes tun ChatGPT Seien Sie von Anfang an realistischer, fügen Sie ein ausgefeilteres Datenmanagement hinzu und verwenden Sie einen PageRank-ähnlichen Ansatz, der dies ermöglichtTrainingsdatenGebunden an den „Vertrauens“-Score … ist es auch möglich, das Modell fein abzustimmen, um abzusichern, wenn es weniger zuversichtlich in Bezug auf die Antwort ist. „

Die tatsächliche Lösung hängt weitgehend von der spezifischen ab KI Modell.Forscher verwenden jedoch Strategien, die häufig enthaltenKonzentrieren Sie die KI auf bewährte Daten,stellen Sie sicherTrainingsdatenDie Qualität des Trainings der KI, um angesichts unrealistischer Eingaben „robuster“ zu sein und nicht mehr „darüber zu reden“.

B. Einführung der menschlichen Überprüfung

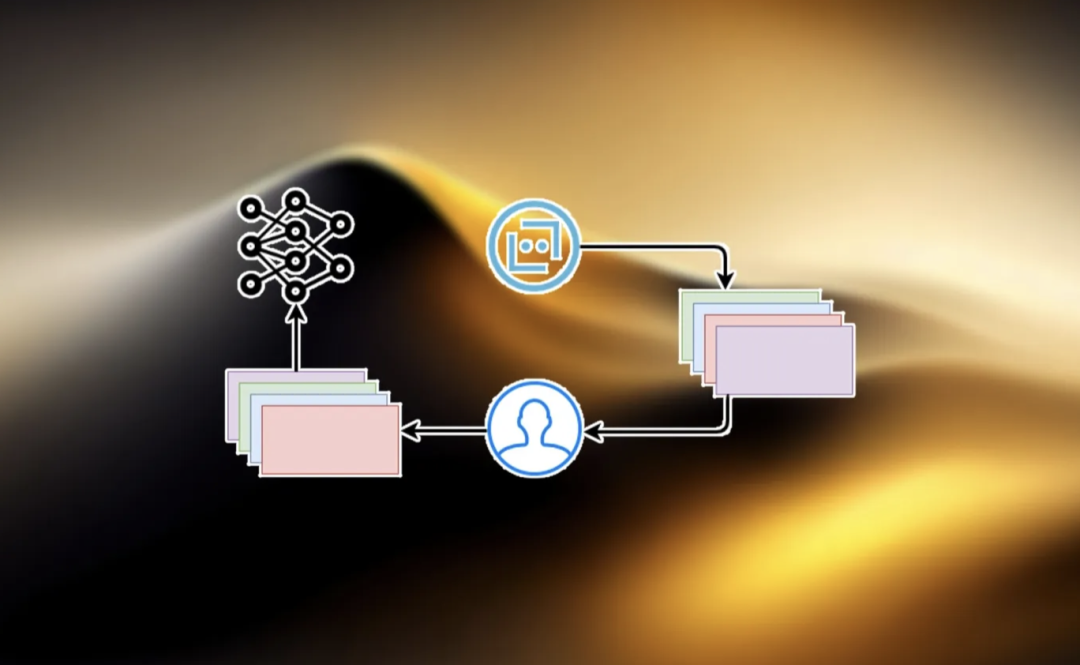

Darüber hinaus können auch menschliche Prüfer zur Verifizierung hinzugezogen werden KI Die Ausgabe des Systems, also durch „menschliches FeedbackVerstärkungslernen(RLHF)“, Zusatzausbildung für die KI.

Das ist OpenAI Die verwendete Technologie, die offizielle Beschreibung lautet: „Wir stellen jetzt Leute ein, die unseren neuronalen Netzwerken beibringen, wie sie sich verhalten, lehren ChatGPT wie man handelt. Solange Sie damit interagieren, wird es anhand Ihrer Reaktion ableiten, ob dies das ist, was Sie wollen. Wenn Sie mit der Ausgabe nicht zufrieden sind, machen Sie beim nächsten Mal etwas anderes. „

RLHF-Schema|Bildquelle: bdtechtalks.com

RLHF-Schema|Bildquelle: bdtechtalks.comZusamenfassend,„Menschliches FeedbackVerstärkungslernen(RLHF)“ soll das anschließende Reinforcement Learning im Human-Feedback-Schritt verbessern, damit KI Erkenne, wenn du Dinge erfindest, und passe dich entsprechend an,Dadurch wird ihm beigebracht, nicht zu „halluzinieren“.

Dafür,ChatGPT Ilya Sutskever, einer der Schöpfer von , ist optimistisch, dass im Laufe der ZeitDas Problem der „Illusion“ wird vollständig gelöst,Weil große Sprachmodelle (LLMs) lernen, ihre Antworten in der Realität zu verankern.

Aber zu diesem Thema glaubt Yann LeCun, Metas leitender Wissenschaftler für künstliche Intelligenz, dass das aktuelle groß angelegte Sprachmodell, das die GPT-Architektur verwendet, das Problem der „Illusion“ nicht lösen kann.

C. Erweiterung des externen Wissens

Darüber hinaus kann auch eine Retrieval-Augmentation (Retrieval-Augmentation) erfolgen ChatGPT etwas genauer.

Retrieval Augmentation ist eine der Methoden, um die Faktizität von Large Language Models (LLMs) zu verbessern, nämlichStellen Sie dem Modell externe Dateien als Quellen und unterstützende Hintergründe zur Verfügung.Mit dieser Technik hoffen die Forscher, dem Modell beizubringen, eine externe Suchmaschine wie google zu verwenden, „um zuverlässige Quellen in ihren Antworten zu zitieren, wie es menschliche Forscher tun, und den Bedarf an unzuverlässigem Faktenwissen, das während des Modelltrainings gelernt wurde, zu verringern.“

Bing Chat und Google Bard wurden durch Einführung eingeführt„Web-Suche“tat genau das.Ich glaube, es wird bald sein, Support-Browser ChatGPT Dasselbe gilt für Versionen.Darüber hinaus zielt das ChatGPT-Plugin darauf ab, GPT-4 zu ergänzenTrainingsdaten. Diese Ergänzung entspricht der Tatsache, dass eine Person, die Zugang zu einer Enzyklopädie hat, sachlich genauer ist als eine Person, die keine hat.

D. Erhöhen Sie die Modelltransparenz

Darüber hinaus ist die Erhöhung der Transparenz des Modells auch eine notwendige Maßnahme, um „Illusionen“ zu reduzieren.

KI Experten sind sich im Allgemeinen einig, dass KI-Unternehmen den Benutzern auch Informationen über die Funktionsweise ihrer KI-Modelle und deren Grenzen zur Verfügung stellen sollten, damit sie verstehen, wann sie dem System vertrauen können und wann sie eine zusätzliche Validierung anstreben sollten. Auch Morgan Stanley (Morgan Stanley) äußerte eine ähnliche Ansicht: „Zu diesem Zeitpunkt besteht der beste Weg, mit KI-„Halluzinationen“ umzugehen, darin, das KI-Modell vollständig für Benutzer zu öffnen, um Fehler zu erkennen und KI als Ergänzung zu verwenden. kein Ersatz für vorhandene Arbeitskräfte. „

Vielleicht ist „Illusion“ nur KI Ein kleiner Schluckauf in der Entwicklung, aber einer, der uns daran erinnert, dass wir wachsam bleiben müssen, um sicherzustellen, dass unsere Technologie für uns funktioniert, und uns nicht in die Irre führt.