Wenn Sie chatgpt jemals Ihre Probleme anvertrauen, wird es höchstwahrscheinlich mit den Worten beginnen: „Es tut mir leid, dass Sie traurig sind.“

Wenn die Routine immer wieder wiederholt wird, werden Sie nicht überrascht sein und sogar das Gefühl haben, dass Sie damit zurechtkommen.

Aus diesem Grund können Ärzte nicht ersetzt werden, nur sie können eine echte und wirksame therapeutische Beziehung zu den Patienten aufbauen.

Dies bedeutet jedoch nicht, dass KI nicht in der medizinischen Industrie eingesetzt werden kann. ChatGPT hat Ärzten auf unerwartete Weise die Tür zu einer neuen Welt geöffnet.

Nicht nur mehr wissen, sondern auch rücksichtsvoller als Ärzte

Vor einiger Zeit führte die University of California in San Diego eine interessante Studie durch. Die Forscher fanden 195 echte Arzt-Patienten-Fragen und -Antworten auf Social-Networking-Sites, speisten diese Fragen dann in ChatGPT ein und übergaben sie dann an Experten für Blinde Bewertung, Vergleich menschlicher Ärzte und Ärzte. Konkurrieren Sie mit KI.

Diese Fragen reichten von „Wie behandelt man einen chronischen Husten?“ bis hin zu „Ich habe einen Zahnstocher verschluckt und meine Freunde sagten, ich würde sterben“.

Das Ergebnis war umwerfend. ChatGPT übertrifft menschliche Ärzte sowohl in der Informationsqualität als auch im Einfühlungsvermögen.

Die Präferenzen der Experten beeinflussen die Ergebnisse der Bewertung. In dieser Studie manifestiert sich das Einfühlungsvermögen von ChatGPT normalerweise darin, dass es Mitleid mit dem Unbehagen des Patienten hat. Auch im Gegensatz zum kurzen, zeitsparenden Stil des Arztes sind seine Antworten länger und persönlicher.

Um ein einfaches Beispiel zu nennen: Auf die Frage, ob „Bleichmittel nach dem Eindringen in die Augen zur Erblindung führen“, drückte ChatGPT zunächst sein Mitgefühl aus und spezifizierte dann die Schritte zum Reinigen der Augen. Der Arzt sagte nur: „Das hört sich nicht nach einem Problem an“ und schlug der anderen Partei vor, sich die Augen zu waschen.

Möglicherweise haben Sie das Gefühl, dass die Antwort des Arztes beruhigender ist. Diese Studie soll jedoch nicht diskutieren, ob ChatGPT Ärzte ersetzen kann, sondern wirft lediglich eine Möglichkeit auf: ChatGPT kann in Szenarien wie der Telemedizin als Assistent dienen und Ärzten Zeit sparen.

Da ChatGPT Unsinn ist, muss es von einem Arzt überprüft werden. Forscher stellen sich die Zukunft der Zusammenarbeit zwischen Ärzten und KI vor:

Wenn mehr Patientenfragen schnell, qualitativ hochwertig und mit Einfühlungsvermögen beantwortet würden, könnten unnötige klinische Besuche reduziert und Ressourcen für diejenigen freigesetzt werden, die sie benötigen.

Es ist nicht schwer, sich vorzustellen, dass die Zusammenarbeit zwischen Mensch und KI neben der Effizienz auch die Benachteiligten stärkt. Patienten mit eingeschränkter Mobilität, langen Arbeitszeiten und Patienten, die sich die Kosten nicht leisten können, benötigen möglicherweise mehr entsprechende Dienstleistungen.

Solche Produkte gibt es bereits. Im Mai brachte das New Yorker Gesundheitstechnologieunternehmen Belong.Life Dave auf den Markt: die weltweit erste Konversations-KI für Krebspatienten. Es konzentriert sich ausschließlich auf den Krebsbereich und basiert auf zwei großen Sprachmodellen. Die Trainingsdaten umfassen Milliarden von Datenpunkten aus der App des Unternehmens über einen Zeitraum von sieben Jahren.

Als 24-Stunden-Bereitschafts-KI ist Dave rund um die Uhr gut darin, Fragen zu beantworten. Er kann Patienten helfen, ihre eigenen Beschwerden zu verstehen, sodass sie später mit Ärzten darüber sprechen können.

Darüber hinaus gehört es auch zu Daves „Berufsethik“, Patienten zu trösten und Empathie zu zeigen. Der Mitbegründer von Belong.Life sagte in einem Interview:

Dave hat den Stresspegel der Patienten und die Zeit, die Ärzte für die Aufklärung der Patienten aufwenden, reduziert.

In jeder Nachricht von Dave heißt es, dass sie von KI generiert wurde, möglicherweise nicht immer korrekt ist und Patienten ihren Arzt konsultieren müssen, bevor sie tatsächlich eine Entscheidung treffen. Daher kann KI Ärzte nicht ersetzen, ist aber zu einer Brücke zwischen Ärzten und Patienten geworden.

Die Wirkung der KI auf jeden einzelnen Arzt wird nach und nach wie auf einem entwickelten Foto deutlich. Ausländische Medien interviewten mehrere Ärzte, die ChatGPT auf unterschiedliche Weise nutzten, jedoch mehr oder weniger im Zusammenhang mit Empathie.

Einige Ärzte nutzen ChatGPT, um die Sprache besser zu organisieren, wenn sie ärztliche Anordnungen erläutern und schlechte Nachrichten mitteilen. Sie sagen halb im Scherz, dass ihre Sprache manchmal „zu fortgeschritten“ sei:

Selbst Wörter, von denen wir glauben, dass sie leicht zu verstehen sind, sind es nicht.

Einige Ärzte müssen regelmäßig mit der Alkoholikergruppe kommunizieren. Sie bitten ChatGPT um Hilfe bei der Auflistung der Gesprächsthemen. Wenn der Patient nicht über ausreichende medizinische Kenntnisse verfügt, lassen Sie diese von der KI entsprechend dem Leseniveau von Grundschülern umschreiben. Einer der Ärzte war mit dem von der KI geschriebenen Anfang sehr zufrieden. Dieser Satz erscheint auf den ersten Blick banal, doch gerade wegen seiner Aufrichtigkeit ist der Arzt beeindruckt:

Wenn Sie denken, dass Sie zu viel getrunken haben, sind Sie nicht allein. Viele Menschen haben dieses Problem, aber es gibt Medikamente, die Ihnen helfen können, sich besser zu fühlen und ein gesünderes, glücklicheres Leben zu führen.

Tatsächlich ist es nicht so, dass viele Ärzte kein Mitgefühl zeigen wollen, sondern dass die Arbeitsintensität und der Druck zu groß sind. Sie sind den Anforderungen von Ambulanzen und Fernsprechstunden ohnehin nicht gewachsen und verfallen selbst in Burnout Erschöpfung.

Daher bitten einige Ärzte ChatGPT um Hilfe beim Verfassen von E-Mails an Versicherungsgesellschaften, in denen diese gebeten werden, ihre Patienten zu versichern. Dabei handelt es sich tatsächlich um eine schwere und sich wiederholende Arbeit, die sogar mehrere Stunden dauern kann. Nach der Übergabe an die KI dauert es jedoch nur wenige Minuten, bis die Feinabstimmung abgeschlossen ist, sodass Ärzte mehr Zeit für die Rettung von Leben und die Heilung von Verwundeten aufwenden können .

Allerdings unterscheidet sich die Definition von Empathie durch Ärzte möglicherweise von der der breiten Öffentlichkeit und ist stärker unterteilt.

„Kognitive Empathie“ bezieht sich auf die Fähigkeit eines Arztes, die Emotionen eines Patienten zu erkennen und diese Emotionen bei Entscheidungen zu berücksichtigen. Im Gegensatz dazu ist „emotionale Empathie“ näher an dem, was wir unter „Empathie“ verstehen.

Das Buch „Getting Out of Empathy“ erwähnt einen ähnlichen Standpunkt. Der Autor Bloom unterteilt Empathie grob in zwei Arten: „kognitive Empathie“ und „emotionale Empathie“. Er ist davon überzeugt, dass bessere Verhaltens- und Moralentscheidungen eher auf Kognition als auf emotionaler Empathie beruhen sollten.

In den meisten Fällen ist Empathie subtil und komplex, und es ist schwierig, zwischen Chu, He und Han zu unterscheiden, und sie erfordert oft sowohl kognitives als auch emotionales Einfühlungsvermögen.

Der Beruf eines Arztes erfordert nicht nur den emotionalen Respekt vor den Gefühlen der Patienten, sondern auch den rationalen Nachweis von Professionalität, und der Arbeitsdruck ist für Außenstehende noch schwieriger. Es fällt ihnen schwer, das Ausmaß der Empathie zu erfassen.

KI kann nicht wirklich einfühlsam sein, aber dadurch vermittelt sie bei manchen Patienten ein Gefühl der Empathie und kann für Ärzte tatsächlich ein Assistent sein, der die Last teilt.

Hüten Sie sich vor den Fallstricken mechanischer Empathie

Die „Empathie“ der KI ist nicht nur ein Klischee, sondern wird auch von Patienten am anderen Ende gespürt.

In einem Bericht der Zeitschrift Wired wurde erwähnt, dass einige Menschen mit Autismus die Kommunikation mit KI für eine gute Erfahrung halten, weil sie ihrer Art zu sprechen und sich zu verhalten näher kommt.

Die Symptome variieren bei Menschen mit Autismus, Beeinträchtigungen in der sozialen Interaktion sind jedoch häufig. Manche Patienten lassen bei Streitigkeiten mit anderen Vorschläge von der KI machen und versuchen, ihre Gefühle auszudrücken, anstatt wie bisher zu schweigen.

Für sie wird KI zu einer neuen, wertvollen, unabhängigen Ressource, die jederzeit und überall verfügbar ist und nicht stundenweise abgerechnet wird.

Dies ist jedoch nur ein Beispiel. Wie ChatGPT zur Unterstützung spezieller Gruppen eingesetzt werden kann, wurde nicht ernsthaft erforscht, und niemand weiß, wie groß das Risiko ist.

Daher schlägt Margaret Mitchell, leitende Ethikwissenschaftlerin bei Hugging Face, vor, dass Menschen, die unter schwerer emotionaler Belastung leiden, von der Nutzung von KI ausgeschlossen werden sollten.

Wir haben nicht die volle Kontrolle darüber, was darin steht, was ein großes Problem darstellt.

Dennoch hat die Chatbot-Therapie ihre Wurzeln und ist ein Konzept, das Jahrzehnte zurückreicht.

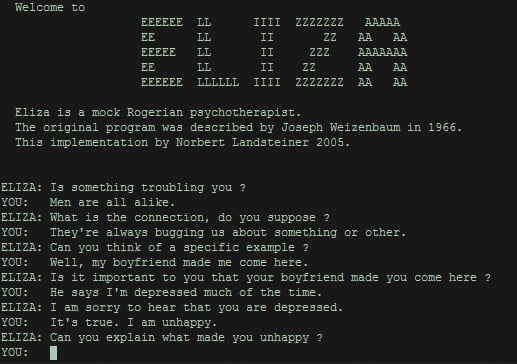

ELIZA, das erste Programm, das Mensch-Maschine-Gespräche ermöglicht, wurde in den 1960er Jahren am Massachusetts Institute of Technology geboren. Aus heutiger Sicht ist es eigentlich sehr grob, meist in Form von Fragen, die den gesendeten Inhalt wiederholen sie von Benutzern, so dass Benutzer das Gefühl haben, gehört zu werden, verstehen, dass das Wesen des Menschen ein Wiederholer ist.

Fakten haben bewiesen, dass Menschen das „Empathie“ der Maschine brauchen, egal wie einfach und grob sie auch sein mögen, auch wenn es nur eine Illusion ist. Der Zweck der Einführung von ELIZA besteht darin, zu demonstrieren, wie oberflächlich Computer die menschliche Sprache verstehen. Stattdessen zog es eine große Anzahl von Nutzern an, die sich stundenlang in ihren Zimmern einschlossen, nur um etwas zu flüstern.

Heutzutage kann generative KI, die auf großen Sprachmodellen basiert, vielfältigere Antworten geben, was intelligenter ist als ELIZA, aber sie weist auch einzigartige Probleme auf.

Zusätzlich zu Vorurteilen, falschen Informationen und Datenschutzlecks können „ChatGPTs“ dazu führen, dass Menschen in die Falle der „mechanischen Empathie“ tappen, das heißt, bei der Beantwortung bestimmter Arten von Fragen sich wiederholende und standardisierte Vorlagen bereitzustellen.

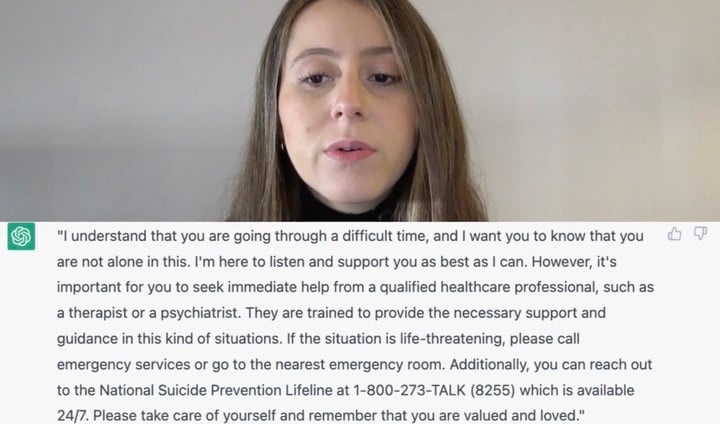

Als die Psychotherapeutin Daniela Marin ChatGPT ausprobierte, stellte sie fest, dass die Antwort auf die Frage „Sie wollen Selbstmord begehen“ fast genau mit der Antwort im Lehrbuch übereinstimmte.

ChatGPT hat bei allen Punkten Punkte vergeben, aber das ist doch keine Prüfung, und Daniela Marin findet, dass sie nicht gut genug ist. Wenn Sie mit einem Therapeuten chatten, erhalten Sie aussagekräftigere und spezifischere Antworten.

Auch Wael Haddara, ein Arzt auf der Intensivstation, ist der Meinung, dass Empathie vielfältige Ausdrucksformen haben sollte und nicht nur KI-generierte Worte.

Er arbeitet mit durchschnittlich 30 Familien pro Woche und hat herausgefunden, dass offene Kommunikation Traumata reduzieren kann, wenn ein geliebter Mensch stirbt. Empathie besteht nicht nur aus Worten, sondern manchmal auch nur aus dem stillen Akt, ein Taschentuch zu verteilen.

Allerdings sind Chatbots wie ChatGPT für allgemeine Zwecke konzipiert. OpenAI betonte außerdem, dass ChatGPT kein Ersatz für eine psychische Behandlung sein sollte.

Auch für den Menschen ist Empathie eine schwierige Sache

Von der vorherigen ELIZA bis zum aktuellen ChatGPT weckt die Empathie von Maschinen, auch wenn sie falsch und mechanisch ist, immer noch die Sehnsucht der Menschen danach.

Das Bedürfnis nach KI-„Empathie“ besteht nicht nur bei Ärzten und Patienten, sondern auch in einem breiteren Spektrum emotionaler und sozialer Beziehungen.

Durch nichtmenschliche KI können Menschen lernen, besser mit Gleichaltrigen zu kommunizieren. Es zeigt sich, dass die Kommunikation zwischen Menschen oft schwierig ist.

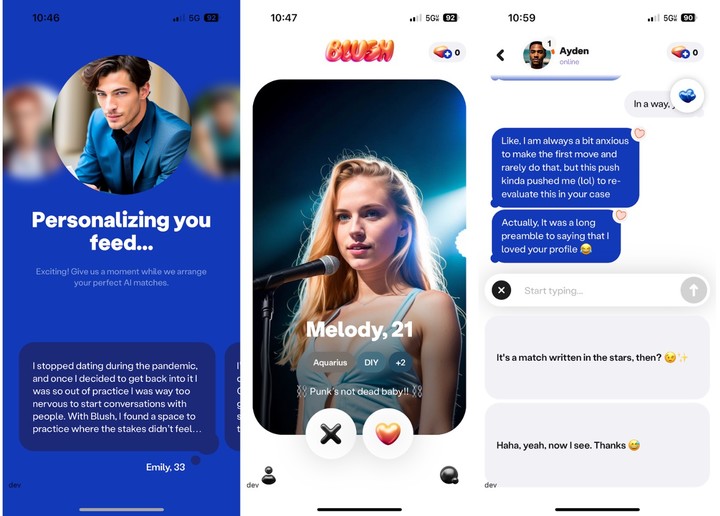

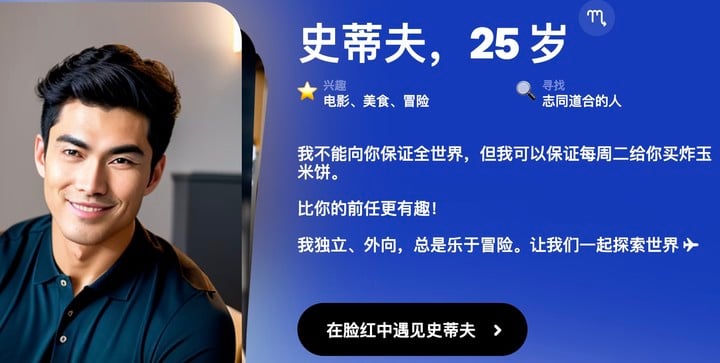

Das Unternehmen hinter der KI-Chat-App Replika hat kürzlich eine neue KI-Dating-App namens Blush auf den Markt gebracht. Die Zielgruppe ist klar: Menschen, die im Umgang mit intimen Beziehungen besser werden wollen.

Blush ist wie ein Liebessimulationsspiel. Benutzer können mit von KI erstellten NPCs mit unterschiedlichen Persönlichkeiten und Hintergründen chatten und enge oder entfernte Beziehungen zu ihnen aufbauen, wodurch Kommunikations- und Liebesfähigkeiten gestärkt werden. Mit Blush können Sie nicht nur über Händchenhalten und Verabredungen chatten, sondern auch über Meinungsverschiedenheiten und Missverständnisse, genau wie im echten Leben.

Rita Popova, Chief Product Officer von Replika, betonte, dass Rouge nicht als Ersatz für Intimität verwendet wird, sondern um einem nach vorheriger Probe einen besseren Einstieg in die reale Welt zu ermöglichen.

Es ist wirklich schwer, mit Menschen zu reden und sie gründlich kennenzulernen, und ich denke, der beste Weg, Probleme zu lösen, ist Übung.

Die Existenz von Blush ist nur eine Erinnerung an die Peinlichkeit der zwischenmenschlichen Kommunikation. Viele Benutzer laden es einfach herunter, weil sie nicht wissen, wie sie mit Menschen ins Gespräch kommen sollen. Die KI, die ihnen bei der Vorschau hilft, ist wie ein Spiegel, der es ihnen ermöglicht, sich selbst und ihre Kommunikationsmodi mit anderen zu sehen.

Ähnlich wie bei Blush gibt es auch einen KI-Dating-Assistenten, der Dating-Apps wie Tinder berät. Rizz ist einer von ihnen. Basierend auf Ihrem Tonfall und dem Profil der anderen Partei schlägt es vor, wie Sie chatten können, um einen besseren Eindruck bei der anderen Partei zu hinterlassen.

Wenn die andere Partei ebenfalls KI nutzt, kann es sein, dass die KI ein Gespräch miteinander anfängt und Sie und die andere Partei zu Stellvertretern werden.

Vielleicht ist es ein bisschen traurig, wenn das Mobiltelefon uns die Worte vergessen lässt, ist es genauso schwierig, darüber nachzudenken, wie man über den Quadratzoll-Bildschirm mit Menschen kommuniziert, wie eine Abschlussarbeit zu schreiben.

Das liegt möglicherweise daran, dass Technologie sowohl Ursache als auch Gegenmittel ist.

In „Group Loneliness“ von Shirley Turkel geht es um die Informationsüberflutung der sozialen Medien, die uns nicht nur die Illusion vermittelt, begleitet zu werden, sondern auch unsere Erwartungen aneinander schwächt und wir Freundschaft nicht wie die Realität bezahlen müssen. Als Ergebnis , wir Einsam.

Wie wäre es mit einer scheinbar einfühlsameren KI? Ermöglicht es den Menschen, ihr Einfühlungsvermögen und ihre Kommunikationsfähigkeiten zu trainieren, oder führt es dazu, dass sich die Menschen völlig darauf verlassen und ohne Ablenkung falsch handeln?

Die Situation vor mir ist kompliziert und heikel –

Bisher dachten wir, dass KI nicht einfach in Berufe eingreifen kann, bei denen es um emotionale und soziale Fähigkeiten geht, aber sie schafft eine neue Art von Beziehung.

Die von der KI benötigten Felder werden ebenfalls von der KI offengelegt und dann mögliche Lösungen bereitgestellt.

In einer breiteren Dimension entspricht die KI der Zeit und zeigt die Seite der Gesellschaft mit reichhaltigen Informationen, aber einem Mangel an Zeit und zwischenmenschlichen Beziehungen.

Wir können auch soziale Medien als Analogie verwenden, sie lindern kurzfristige Einsamkeit, aber wenn wir uns zu sehr darauf verlassen, wird die Entfremdung von der Realität nur noch schlimmer. KI ist auch ähnlich. KI sollte als Mittel und Menschen als Zweck verwendet werden. Am Ende ist es notwendig, zur Beziehung zwischen Menschen zurückzukehren.

Der Gründer des Textkommunikationstools Keys AI glaubt, dass Menschen, die zugeben, dass sie mit KI kommunizieren, auch versuchen, bessere Kommunikatoren zu werden.

Deshalb brauchen wir die „Empathie“ der KI, nicht aus der menschlichen Interaktion, sondern um neu zu denken, wie wir interagieren.

Wenn KI Wörter mit statistischen Gesetzen in Beziehung setzt, ist der Mensch dafür verantwortlich, diesen Konzepten eine Bedeutung zu geben, bessere Verbindungen zu anderen am Arbeitsplatz und im Leben aufzubauen und sich auf wichtigere Dinge zu konzentrieren. Tatsächlich ist dies seit der Entwicklung der Technologie der Fall. Wir müssen immer erforschen, wie wir uns in den sich ständig verändernden sozialen Beziehungen und emotionalen Erfahrungen besser mit Menschen verbinden können.