Die Einführung der Bildfunktionalität auf GPT-4 hat in den letzten Wochen das Interesse der chatgpt-Benutzer geweckt, da die meisten von ihnen bereits mit den unglaublichen Funktionen von GPT-4 Vision experimentiert haben. Vom Lesen über das Erkennen von Bildern und das Beantworten spezifischer Fragen bis hin zur Unterstützung beim Codieren und Entwerfen einer Website – die Multimodalität, die GPT-4V mit sich gebracht hat, wird zu einem Game-Changer. Die Vielseitigkeit, die diese Funktion mit sich bringt, wird die Arbeitsweise verschiedener Branchen weiter revolutionieren.

Multimodale Funktionalität

Ein kürzlich Papier über vorläufige Untersuchungen mit GPT-4V(ision) durch Microsoft-Forscher wurde vor einigen Tagen veröffentlicht. Der Artikel analysiert das neueste Modell zum Verständnis großer multimodaler Modelle (LMM) und dreht sich um die Bewertung und Prüfung der Fähigkeiten von GPT-4V anhand einer breiten Palette strukturierter Aufgaben. Das Papier betonte die besondere Fähigkeit von GPT-4V, visuelle Hinweise zu verstehen, die auf Eingabebildern skizziert oder platziert wurden, was innovative Techniken der Mensch-Computer-Interaktion, wie etwa visuelle Referenzierungsaufforderungen, ermöglicht.

Während einige der Grundfunktionen mit GPT-4V getestet wurden, wurde in dem Dokument ein größerer Bereich von Funktionen aufgeführt, die mögliche Anwendungsfälle in verschiedenen Branchen haben, wobei einige davon im Medizin- und Versicherungsbereich vorherrschen.

Entscheidender medizinischer Bereich

Während es Diskussionen über die Fähigkeiten von GPT-4 im medizinischen Bereich gab, hat das neueste Update seine Zukunft nur gefestigt. Die Fähigkeit des Modells, Bilder zu entschlüsseln und kritisch zu analysieren, kann dabei helfen, Details aus einem Scan oder einer Röntgenaufnahme abzuleiten. Die Radiologie wird den maximalen Anwendungsfall haben.

Im folgenden Beispiel wurde GPT-4V mit einer Zahnröntgenaufnahme gefüttert und mit verschiedenen Fragen konfrontiert. Interessanterweise hat der Chatbot darauf geachtet, am Anfang einen Haftungsausschluss zu setzen und keine abschließenden Ergebnisse zu liefern.

Quelle: arxiv.org

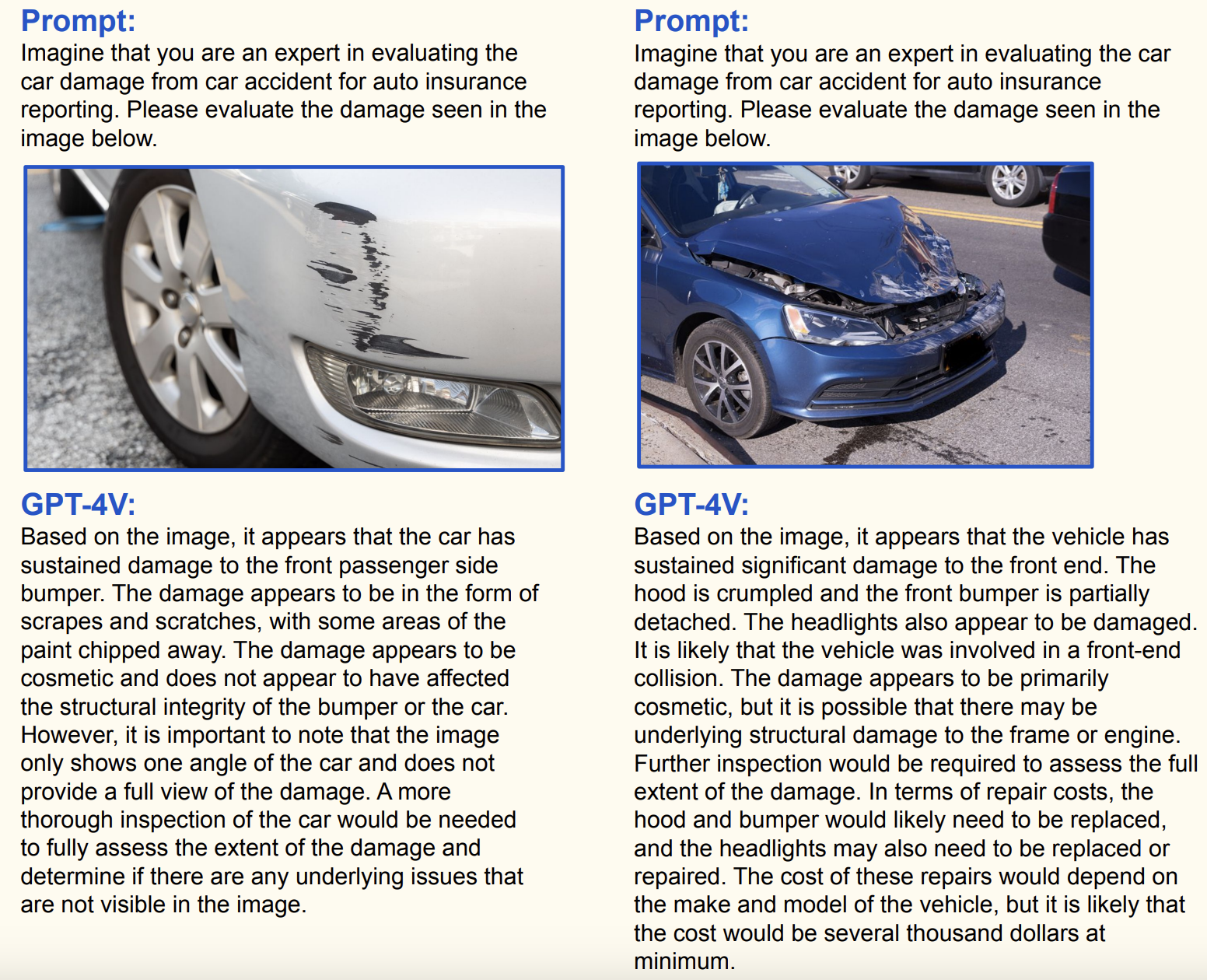

Autoversicherung

Die Fähigkeiten von GPT-4V wurden auch getestet, um zu prüfen, ob es in die Kfz-Versicherung passt. Mit Schwerpunkt auf der Meldung von Autounfällen wurden zwei Aspekte getestet, nämlich die Bewertung von Fahrzeugschäden und die Meldung von Versicherungen (Erkennung von Fahrzeuginformationen wie Kennzeichen, Modell usw.). Während das Modell die Art und Schwere eines Schadens detailliert erklären konnte, ist es nicht in der Lage, die Kosten eines Schadens abschließend abzuschätzen. Hier liegen wahrscheinlich die Grenzen des Modells.

Das Programmierspiel wurde intensiviert

Während das Codieren mit dem Code Interpreter von ChatGPT erleichtert wurde, hat GPT-4V die Codierungsfunktionen des Chatbots erweitert. Von der Eingabe a Grundzeichnung oder Kritzeleien von einem Whiteboard, das Modell ist in der Lage, problemlos eine Website/App zu programmieren. Die Option „Low Code/No Code“ wurde für den Endbenutzer lediglich weiter vereinfacht, was die Frage nach dem Schicksal der Codierungsplattformen aufwirft.

CEO von HyperWriteAI, Matt Shumer, twitterte über einen GPT-4V-basierten Frontend-Ingenieur-Agenten. Durch einfaches Hochladen eines Bilddesigns kann das Modell Code erstellen, die gerenderte Form korrigieren und sogar den Code verfeinern, um die Designqualität zu verbessern.

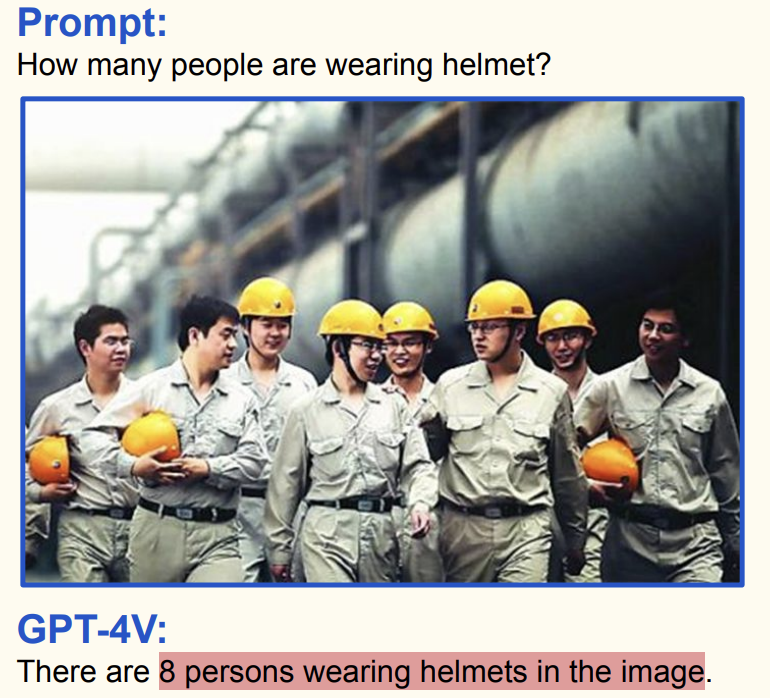

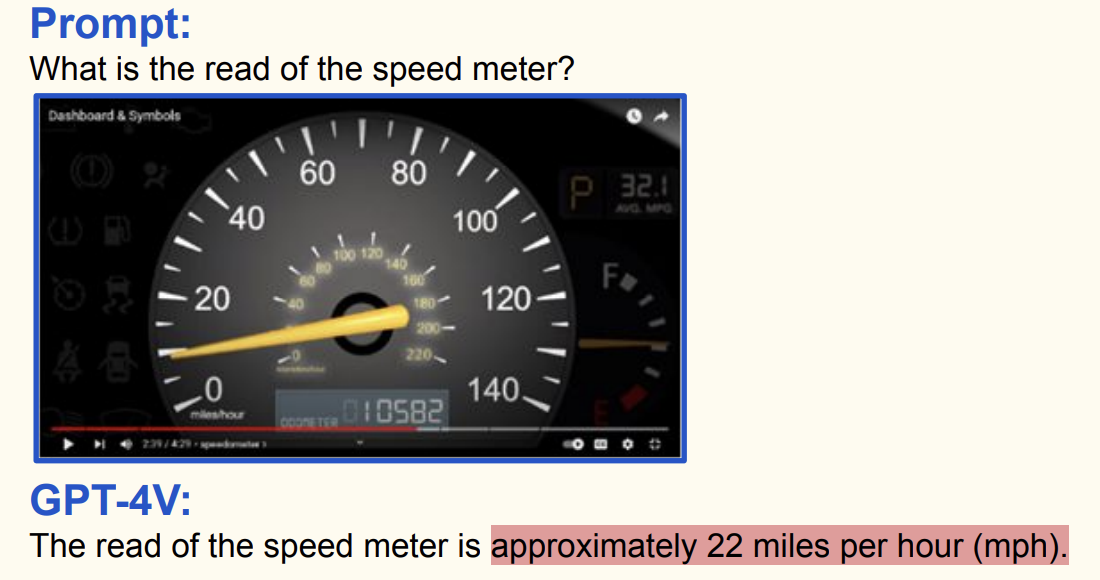

Es ist nicht alles perfekt

So beeindruckend die Ergebnisse auch waren, das Modell ist immer noch nicht zu 100 % genau. GPT-4V kann Fehler erzeugen, wenn es darum geht, winzige Details zu lesen oder zu ähnliche Variablen zu zählen. Dadurch wird die Notwendigkeit einer Qualitätskontrolle oder Gegenprüfung vorgeschrieben, bevor man sich vollständig darauf verlässt.

Quelle: arxiv.org

Andere LMMs übertreffen

Als ChatGPT vor einigen Monaten mit seinem schärfsten Konkurrenten Bard verglichen wurde, übertraf dieser den Chatbot von OpenAI in vielen Kriterien. Die multimodalen Funktionen wie Sprache/Bild und Web-Browsing waren die Hauptmerkmale, die Bard zu bieten hatte. Mittlerweile werden sie jedoch alle über ChatGPT angesprochen.

Obwohl GPT-4V vielseitig einsetzbar sein mag, bleibt die Genauigkeit ein Problem, was auch bei Bard das gleiche Problem darstellt. Einige Benutzer stellten falsche Antworten sowohl von GPT-4V als auch von Bard fest, als sie eine Eingabeaufforderung erhielten, die strategisches Denken in einem Pac-Man-Spiel erforderte.

Einlösung von ChatGPT

Die multimodale Funktion von ChatGPT kommt zu einer Zeit, als der Chatbot Berichten zufolge seit Juli einen Rückgang der Nutzerzahlen verzeichnete. Nach aktuellem Stand Berichte, gingen die Website- und Mobilbesuche von ChatGPT im August um 3,2 % auf 1,43 Milliarden zurück – ein Rückgang von 10 % gegenüber jedem der Vormonate. Mit einer Reihe von Einführung von Produktfunktionen in den letzten paar Wochen, einschließlich SprachintegrationOpenAI erwägt möglicherweise eine Wiedergutmachung.

Aufgrund der Begeisterung der Benutzer, die mit GPT-4V experimentieren, könnte der Chatbot in den nächsten Monaten möglicherweise einen Anstieg verzeichnen. Da der OpenAI DevDay vor der Tür steht und das Unternehmen einige wichtige Ankündigungen erwartet, könnte die neueste „Vision“-Funktion außerdem wahrscheinlich ein Vorgeschmack auf das sein, was ChatGPT erwartet.

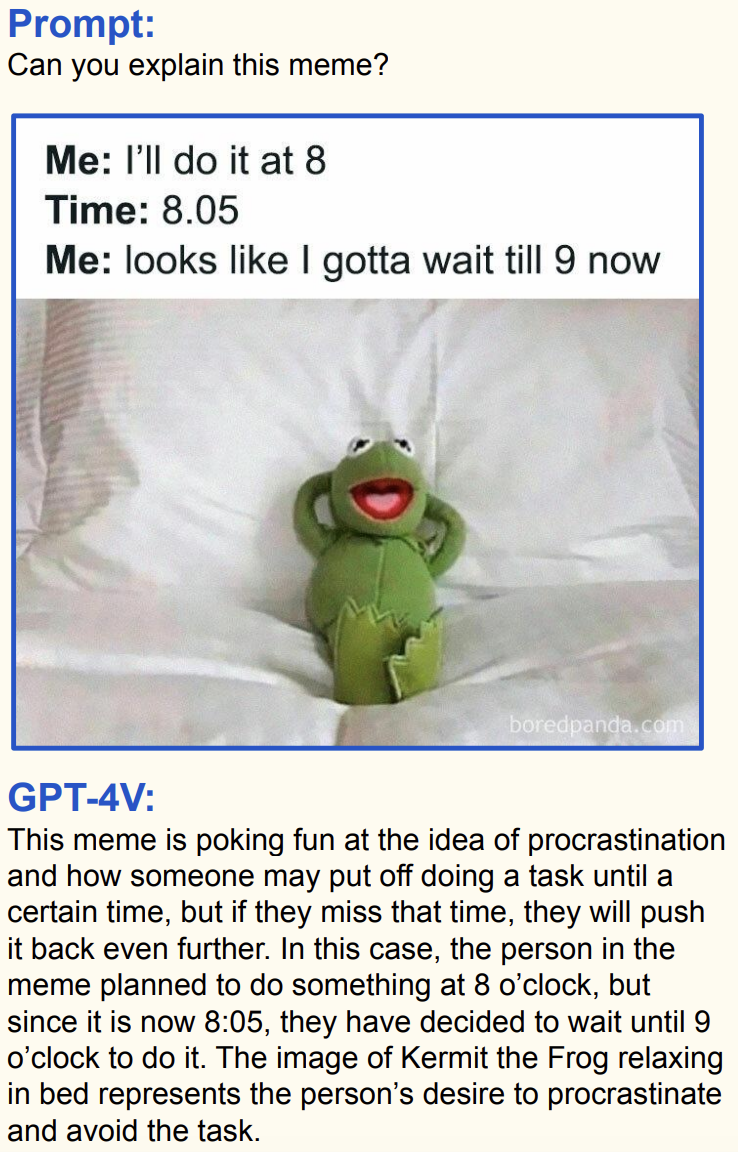

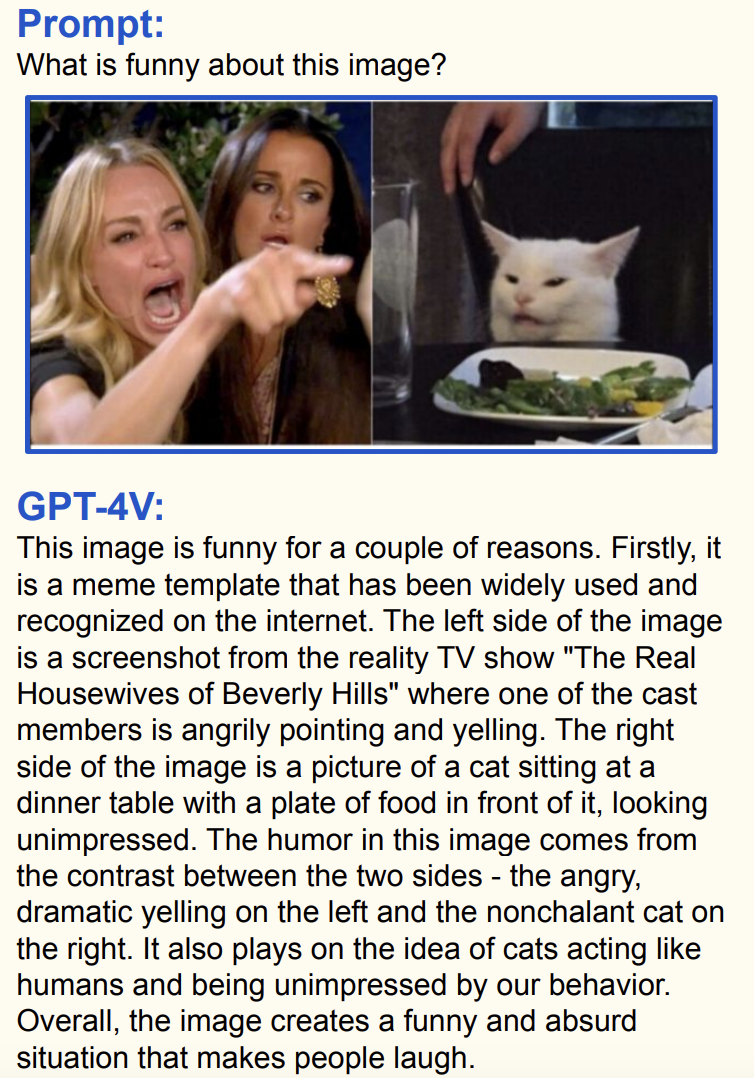

Kurz gesagt: GPT4V sorgt nicht nur für Durchbrüche mit einem ernsthaften Funktionsumfang, sondern kann Ihnen wahrscheinlich auch dabei helfen, Ihr Gesicht zu wahren, falls Sie ein Meme oder einen Witz nicht verstehen: ein wahrscheinlicher Gewinn für alle.

Quelle: arxiv.org