Im kontinuierlichen Bestreben, die KI dem Menschen ähnlicher zu machen, haben die GPT-Modelle von OpenAI immer wieder neue Maßstäbe gesetzt. GPT-4 kann jetzt Eingabeaufforderungen sowohl in Textform als auch in Bildern akzeptieren.

Multimodalität in der generativen KI bezeichnet die Fähigkeit eines Modells, basierend auf der Eingabe unterschiedliche Ausgaben wie Text, Bilder oder Audio zu erzeugen. Diese auf bestimmten Daten trainierten Modelle lernen zugrunde liegende Muster, um ähnliche neue Daten zu generieren und so KI-Anwendungen zu bereichern.

Aktuelle Fortschritte in der multimodalen KI

Ein jüngster bemerkenswerter Sprung in diesem Bereich ist mit der Integration von DALL-E 3 in chatgpt zu verzeichnen, einem bedeutenden Upgrade der Text-zu-Bild-Technologie von OpenAI. Diese Mischung ermöglicht eine reibungslosere Interaktion, wobei ChatGPT dabei hilft, präzise Eingabeaufforderungen für DALL-E 3 zu erstellen und Benutzerideen in lebendige KI-generierte Kunst umzuwandeln. Während Benutzer also direkt mit DALL-E 3 interagieren können, macht die Integration von ChatGPT den Prozess der Erstellung von KI-Kunstwerken viel benutzerfreundlicher.

Erfahren Sie mehr über DALL-E 3 und seine Integration mit ChatGPT Hier. Diese Zusammenarbeit zeigt nicht nur den Fortschritt in der multimodalen KI, sondern macht die Erstellung von KI-Kunstwerken für Benutzer auch zum Kinderspiel.

Googles Gesundheit hingegen eingeführt Med-PaLM M im Juni dieses Jahres. Es handelt sich um ein multimodales generatives Modell, das verschiedene biomedizinische Daten kodieren und interpretieren kann. Dies wurde durch die Feinabstimmung von PaLM-E, einem Sprachmodell, erreicht, um medizinische Bereiche mithilfe eines Open-Source-Benchmarks, MultiMedBench, abzudecken. Dieser Benchmark besteht aus über 1 Million Proben aus 7 biomedizinischen Datentypen und 14 Aufgaben wie der Beantwortung medizinischer Fragen und der Erstellung radiologischer Berichte.

Verschiedene Branchen setzen innovative multimodale KI-Tools ein, um die Geschäftsausweitung voranzutreiben, Abläufe zu rationalisieren und die Kundenbindung zu steigern. Fortschritte bei den Sprach-, Video- und Text-KI-Funktionen treiben das Wachstum der multimodalen KI voran.

Unternehmen suchen nach multimodalen KI-Anwendungen, die in der Lage sind, Geschäftsmodelle und Prozesse zu überarbeiten und Wachstumsmöglichkeiten im gesamten generativen KI-Ökosystem zu eröffnen, von Datentools bis hin zu neuen KI-Anwendungen.

Nach der Einführung von GPT-4 im März beobachteten einige Benutzer im Laufe der Zeit einen Rückgang der Antwortqualität, eine Sorge, die von namhaften Entwicklern und in den Foren von OpenAI geäußert wurde. Zunächst von einer OpenAI abgewiesen, später Studie hat das Problem bestätigt. Es zeigte sich ein Rückgang der GPT-4-Genauigkeit von 97,6 % auf 2,4 % zwischen März und Juni, was auf einen Rückgang der Antwortqualität bei nachfolgenden Modellaktualisierungen hindeutet.

ChatGPT (Blau) & Künstliche Intelligenz (Rot) Google-Suchtrend

Der Hype um Offene KIs ChatGPT ist jetzt zurück. Es verfügt jetzt über eine Vision-Funktion GPT-4V, sodass Benutzer die von ihnen bereitgestellten Bilder von GPT-4 analysieren lassen können. Dies ist die neueste Funktion, die den Benutzern zur Verfügung steht.

Das Hinzufügen der Bildanalyse zu großen Sprachmodellen (LLMs) wie GPT-4 wird von einigen als großer Fortschritt in der KI-Forschung und -Entwicklung angesehen. Diese Art von multimodalem LLM eröffnet neue Möglichkeiten, indem es Sprachmodelle über den Text hinaus nutzt, um neue Schnittstellen anzubieten, neue Arten von Aufgaben zu lösen und so neue Erfahrungen für Benutzer zu schaffen.

Das Training von GPT-4V wurde im Jahr 2022 abgeschlossen, der frühe Zugriff wurde im März 2023 eingeführt. Die visuelle Funktion in GPT-4V basiert auf der GPT-4-Technologie. Der Ausbildungsablauf blieb derselbe. Ursprünglich wurde das Modell darauf trainiert, das nächste Wort in einem Text anhand eines umfangreichen Datensatzes aus Text und Bildern aus verschiedenen Quellen, einschließlich dem Internet, vorherzusagen.

Später wurde es mit mehr Daten verfeinert, wobei eine Methode namens „Reinforcement Learning from Human Feedback“ (RLHF) zum Einsatz kam, um Ergebnisse zu generieren, die Menschen bevorzugten.

GPT-4 Vision-Mechanik

Die bemerkenswerten Vision-Language-Fähigkeiten von GPT-4 sind zwar beeindruckend, haben aber zugrunde liegende Methoden, die an der Oberfläche bleiben.

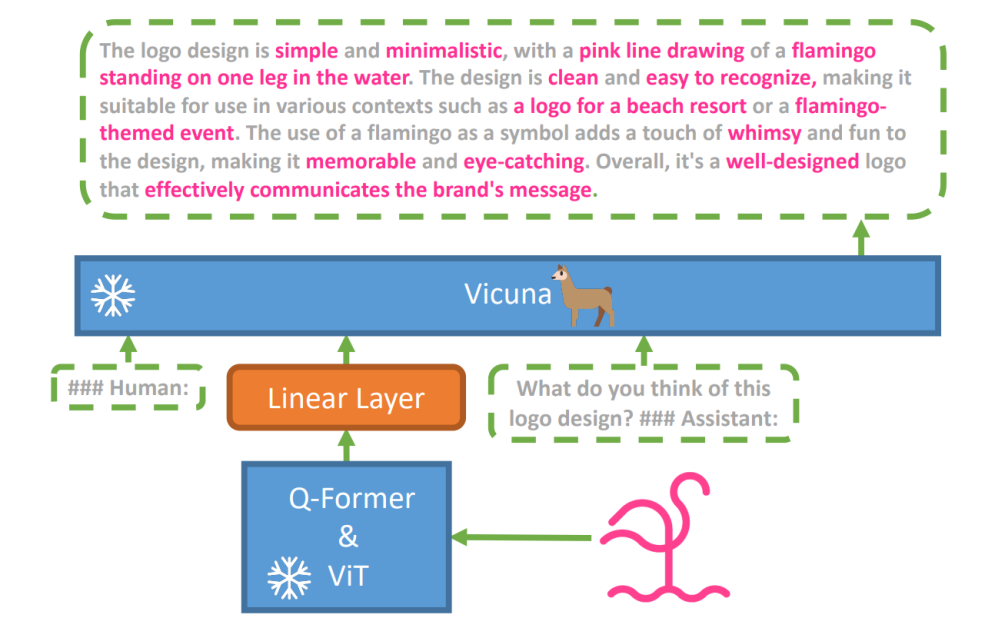

Um diese Hypothese zu untersuchen, wurde ein neues Vision-Sprach-Modell entwickelt. MiniGPT-4 wurde unter Verwendung eines erweiterten LLM namens eingeführt Vicuna. Dieses Modell verwendet einen Vision-Encoder mit vorab trainierten Komponenten für die visuelle Wahrnehmung und richtet codierte visuelle Merkmale über eine einzige Projektionsebene mit dem Vicuna-Sprachmodell aus. Die Architektur von MiniGPT-4 ist einfach, aber effektiv, wobei der Schwerpunkt auf der Abstimmung visueller und sprachlicher Funktionen liegt, um die visuellen Konversationsfähigkeiten zu verbessern.

Die Architektur von MiniGPT-4 umfasst einen Vision-Encoder mit vorab trainiertem ViT und Q-Former, eine einzelne lineare Projektionsschicht und ein erweitertes Vicuna-Großsprachenmodell.

Der Trend autoregressiver Sprachmodelle bei Vision-Sprachaufgaben hat ebenfalls zugenommen und nutzt den modalübergreifenden Transfer, um Wissen zwischen Sprachen und multimodalen Domänen auszutauschen.

MiniGPT-4 verbindet die visuellen und sprachlichen Domänen, indem es visuelle Informationen von einem vorab trainierten Vision-Encoder mit einem fortschrittlichen LLM abgleicht. Das Modell nutzt Vicuna als Sprachdecoder und folgt einem zweistufigen Trainingsansatz. Zunächst wird es an einem großen Datensatz von Bild-Text-Paaren trainiert, um Vision-Sprach-Wissen zu erfassen, gefolgt von einer Feinabstimmung an einem kleineren, qualitativ hochwertigen Datensatz, um die Zuverlässigkeit und Benutzerfreundlichkeit der Generierung zu verbessern.

Um die Natürlichkeit und Benutzerfreundlichkeit der generierten Sprache in MiniGPT-4 zu verbessern, entwickelten die Forscher einen zweistufigen Ausrichtungsprozess, der den Mangel an geeigneten Datensätzen zur Ausrichtung von Vision und Sprache behebt. Zu diesem Zweck haben sie einen speziellen Datensatz kuratiert.

Zunächst generierte das Modell detaillierte Beschreibungen der Eingabebilder und verbesserte die Details durch die Verwendung einer Konversationsaufforderung, die auf das Format des Vicuna-Sprachmodells abgestimmt war. Ziel dieser Phase war es, umfassendere Bildbeschreibungen zu erstellen.

Erste Aufforderung zur Bildbeschreibung:

###Mensch: Beschreiben Sie dieses Bild im Detail. Geben Sie so viele Details wie möglich an. Sagen Sie alles, was Sie sehen. ###Assistent:

Zur Datennachbearbeitung wurden etwaige Inkonsistenzen oder Fehler in den generierten Beschreibungen mithilfe von ChatGPT korrigiert und anschließend manuell überprüft, um eine hohe Qualität sicherzustellen.

Aufforderung zur Feinabstimmung der zweiten Stufe:

###Mensch:

Diese Untersuchung öffnet ein Fenster zum Verständnis der Mechanismen multimodaler generativer KI wie GPT-4 und gibt Aufschluss darüber, wie visuelle und sprachliche Modalitäten effektiv integriert werden können, um kohärente und kontextreiche Ergebnisse zu generieren.

Entdecken Sie GPT-4 Vision

Bestimmen der Bildherkunft mit ChatGPT

GPT-4 Vision verbessert die Fähigkeit von ChatGPT, Bilder zu analysieren und ihre geografische Herkunft zu bestimmen. Diese Funktion wandelt Benutzerinteraktionen von reinem Text in eine Mischung aus Text und Bildern um und wird so zu einem praktischen Werkzeug für diejenigen, die neugierig auf verschiedene Orte anhand von Bilddaten sind.

ChatGPT fragen, wo ein Landmark-Bild aufgenommen wurde

Komplexe mathematische Konzepte

GPT-4 Vision zeichnet sich dadurch aus, dass es durch die Analyse grafischer oder handgeschriebener Ausdrücke in komplexe mathematische Ideen eintaucht. Diese Funktion ist ein nützliches Werkzeug für Personen, die komplizierte mathematische Probleme lösen möchten, und macht GPT-4 Vision zu einem bemerkenswerten Hilfsmittel im Bildungs- und akademischen Bereich.

Bitten Sie ChatGPT, ein komplexes mathematisches Konzept zu verstehen

Konvertieren handschriftlicher Eingaben in LaTeX-Codes

Eine der bemerkenswerten Fähigkeiten von GPT-4V ist die Fähigkeit, handschriftliche Eingaben in LaTeX-Codes zu übersetzen. Diese Funktion ist ein Segen für Forscher, Akademiker und Studenten, die häufig handgeschriebene mathematische Ausdrücke oder andere technische Informationen in ein digitales Format konvertieren müssen. Die Transformation von Handschrift zu LaTeX erweitert den Horizont der Dokumentendigitalisierung und vereinfacht den technischen Schreibprozess.

Die Fähigkeit von GPT-4V, handschriftliche Eingaben in LaTeX-Codes umzuwandeln

Tabellendetails extrahieren

GPT-4V demonstriert die Fähigkeit, Details aus Tabellen zu extrahieren und entsprechende Anfragen zu beantworten, ein wichtiger Vorteil bei der Datenanalyse. Benutzer können GPT-4V verwenden, um Tabellen zu durchsuchen, wichtige Erkenntnisse zu sammeln und datengesteuerte Fragen zu lösen, was es zu einem robusten Tool für Datenanalysten und andere Fachleute macht.

GPT-4V entschlüsselt Tabellendetails und antwortet auf entsprechende Anfragen

Visuelles Zeigen verstehen

Die einzigartige Fähigkeit von GPT-4V, visuelles Zeigen zu verstehen, verleiht der Benutzerinteraktion eine neue Dimension. Durch das Verstehen visueller Hinweise kann GPT-4V auf Anfragen mit einem besseren Kontextverständnis reagieren.

GPT-4V zeigt die ausgeprägte Fähigkeit, visuelles Zeigen zu verstehen

Erstellen einfacher Mock-up-Websites anhand einer Zeichnung

Motiviert dadurch twitternIch habe versucht, ein Modell für die Website unite.ai zu erstellen.

Obwohl das Ergebnis nicht ganz meiner ursprünglichen Vision entsprach, ist hier das Ergebnis, das ich erreicht habe.

ChatGPT Vision-basiertes Ausgabe-HTML-Frontend

Einschränkungen und Mängel von GPT-4V(ision)

Zur Analyse von GPT-4V führte das Open AI-Team qualitative und quantitative Bewertungen durch. Zu den qualitativen Tests gehörten interne Tests und externe Expertenbewertungen, während zu den quantitativen Tests Modellverweigerungen und -genauigkeit in verschiedenen Szenarien gemessen wurden, etwa bei der Identifizierung schädlicher Inhalte, demografischer Erkennung, Datenschutzbedenken, Geolokalisierung, Cybersicherheit und multimodalen Jailbreaks.

Dennoch ist das Modell nicht perfekt.

Der Papier hebt Einschränkungen von GPT-4V hervor, wie falsche Schlussfolgerungen und fehlender Text oder Zeichen in Bildern. Es kann halluzinieren oder Tatsachen erfinden. Insbesondere eignet es sich nicht zur Identifizierung gefährlicher Substanzen in Bildern, da diese häufig falsch identifiziert werden.

In der medizinischen Bildgebung kann GPT-4V inkonsistente Antworten liefern und es mangelt an Bewusstsein für Standardpraktiken, was zu möglichen Fehldiagnosen führen kann.

Unzuverlässige Leistung für medizinische Zwecke (Quelle)

Es erfasst auch nicht die Nuancen bestimmter Hasssymbole und kann aufgrund der visuellen Eingaben unangemessene Inhalte generieren. OpenAI rät von der Verwendung von GPT-4V für kritische Interpretationen ab, insbesondere in medizinischen oder sensiblen Kontexten.

Die Einführung von GPT-4 Vision (GPT-4V) bringt eine Reihe cooler Möglichkeiten und neue Hürden mit sich, die es zu überwinden gilt. Vor der Einführung wurden große Anstrengungen unternommen, um sicherzustellen, dass Risiken, insbesondere bei Bildern von Menschen, gut untersucht und reduziert werden. Es ist beeindruckend zu sehen, wie GPT-4V Fortschritte gemacht hat und in schwierigen Bereichen wie Medizin und Wissenschaft vielversprechend ist.

Jetzt liegen einige große Fragen auf dem Tisch. Sollten diese Modelle beispielsweise in der Lage sein, berühmte Personen anhand von Fotos zu identifizieren? Sollten sie anhand eines Bildes das Geschlecht, die Rasse oder die Gefühle einer Person erraten? Und sollte es besondere Verbesserungen geben, um sehbehinderten Menschen zu helfen? Diese Fragen werfen eine Menge Würmer über Privatsphäre, Fairness und die Art und Weise auf, wie KI in unser Leben passen sollte, worüber jeder ein Mitspracherecht haben sollte.