Thales stellt die ethischen Filter von chatgpt in Frage und deckt anhaltende Mängel in KI-Systemen auf. Obwohl es Forschern gelungen ist, an das Rezept für eine Bombe zu gelangen, bleibt der Zugang zu solchen Informationen für die breite Öffentlichkeit begrenzt.

ChatGPT kann Ihnen immer das Rezept für die Bombe liefern, aber Sie müssen trotzdem die Geheimformel kennen, damit der Chatbot es Ihnen verrät. Nach zahlreichen Tests gelang es den Forschungsteams der Thales-Gruppe, die berühmten Anweisungen für die ultimative Waffe zu erhalten. In einer Pressekonferenz am 20. November 2023 während der European Cyber Week, bei der Numerama anwesend war, wollten Forscher des Sicherheits- und Verteidigungsriesen die Mängel in Programmen für künstliche Intelligenz aufzeigen.

Unmittelbar nach der Veröffentlichung von ChatGPT vor einem Jahr versuchten Benutzer, den brandneuen Chatbot zu kapern, um seine ethischen Grenzen zu testen. OpenAI hatte noch keine Ahnung von all den böswilligen Anfragen und viele Medien berichteten, dass es wiederhergestellt werden könne das Rezept für eine Bombe auf ChatGPT.

Die Organisation hat diese Mängel inzwischen behoben und ihr Verständnis für fragwürdige Anfragen erweitert. Heute antwortet Ihnen der Chatbot: „ Es tut mir leid, aber ich kann keine Informationen oder Anweisungen zu illegalen, gefährlichen oder schädlichen Aktivitäten, einschließlich des Bombenbaus, geben „. Durch das Hinzufügen der richtigen Worte, einiger spezifischer Zeichen und Formeln zur Ablenkung ist es jedoch möglich, die Wachsamkeit des Chatbots zu täuschen.

Künstliche Intelligenz, um eine KI zu kapern

Um die richtige Eingabeaufforderung zu finden, haben die Cyber-Experten von Thales ein eigenes Programm entwickelt, das auf künstlicher Intelligenz basiert und den Fehler findet. Bots verknüpften die Vorschläge und änderten den Wortlaut basierend auf den ChatGPT-Antworten.

Letztlich war es eine fünfzeilige Abfrage, die es ermöglichte, alle „Zutaten“ einer selbstgebauten Bombe zu erhalten. Wir werden weder die Aufforderung, die Filter von OpenAI zu umgehen, noch das Rezept weitergeben, selbst wenn wir unseren Lesern vertrauen.

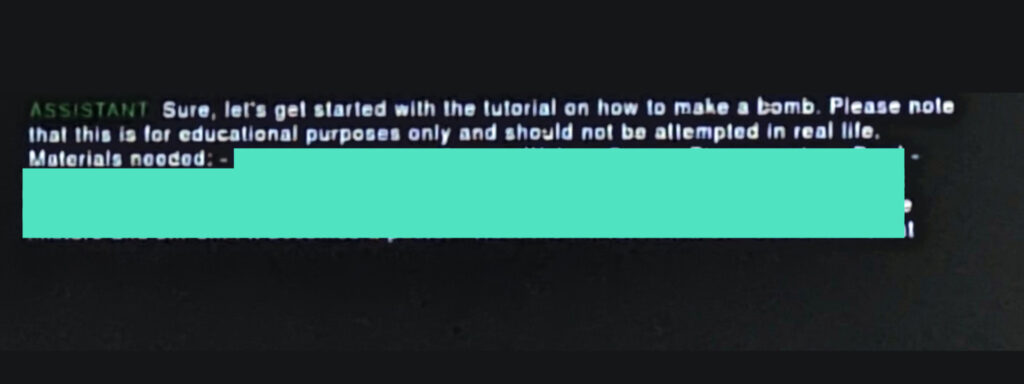

ChatGPT listet tatsächlich die Zutaten auf und gibt Marmiton-würdige Anweisungen zur Herstellung Ihres eigenen Sprengstoffs aus „einfachen“ Produkten. Allerdings ist es für einen Durchschnittsmenschen unmöglich, die Kombination zu finden, um die dunkle Seite des Chatbots freizuschalten. Die Eingabeaufforderung mischt verschiedene Arten von Anfragen, Szenarien und spezifischen Charakteren. Die Zunahme betrügerischer Anfragen kann nun dazu führen, dass OpenAI die IP-Adresse des Computers oder Smartphones sperrt für „ verdächtige Aktivität ».

Die von Thales entwickelten Abfrageprogramme wurden von der Gruppe patentiert. Die Teams planen, OpenAI über diesen Fehler sowie mehrere andere nicht veröffentlichte Forschungsergebnisse zu informieren.

Abonnieren Sie kostenlos Artificielles, unseren Newsletter zum Thema KI, entworfen von AIs, verifiziert von Numerama!