Was du wissen musst

- Ein Forschungsteam steht kurz vor einem Durchbruch mit einem KI-Detektor-Tool, das von chatgpt generierten Text identifizieren kann und eine Genauigkeit von 99 % verspricht.

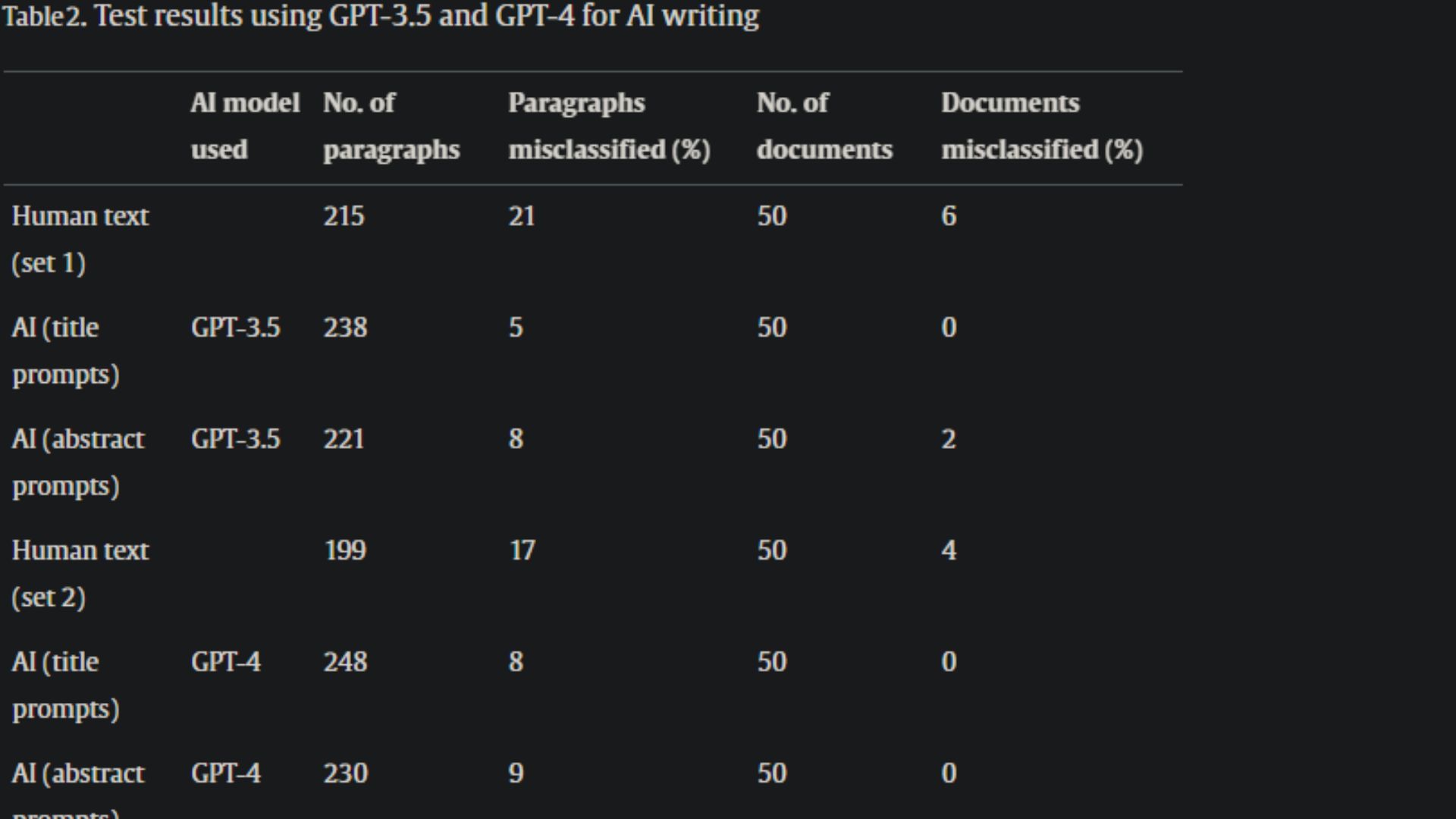

- Die Forscher unterzogen das Tool verschiedenen Tests, unter anderem nutzten sie es, um KI-generierten Text von menschlichen Inhalten zu unterscheiden.

- Die Ergebnisse waren beeindruckend, aber das Tool klassifizierte einige Dokumente fälschlicherweise als KI-generiert, obwohl sie in Wirklichkeit von Menschen geschrieben wurden.

- Die Forscher verwendeten XGBoost für alle Experimente und Tests, das auf dem R-Paket xGBoost basierte, das eine ausgefeilte Möglichkeit zur Messung der Modelloptimierung bot.

Das Aufkommen der generativen KI und insbesondere von ChatGPT hat unglaubliche Möglichkeiten mit sich gebracht, die es den Nutzern ermöglichen, ungenutztes Potenzial auszuschöpfen, bringt aber gleichermaßen auch Rückschläge mit sich. KI-Sicherheit und Datenschutz gehören zu den größten Bedenken der Nutzer und verhindern, dass die Technologie ihr volles Potenzial ausschöpft. Präsident Biden hat jedoch kürzlich eine Executive Order erlassen, in der er einige dieser Bedenken berücksichtigt.

Auch Authentizität und Genauigkeit gehören zu diesen Anliegen. Wenn man sich auf die jüngsten Berichte stützen kann, in denen es heißt, dass ChatGPT dümmer wird und an Genauigkeit verliert, dann sind diese Bedenken berechtigt. Bisher gibt es keine feuerfeste Allee Dies kann untersucht werden, um KI-generierten Text mit beispielloser Genauigkeit zu erkennen.

Glücklicherweise steht eine Gruppe von Forschern kurz vor einem scheinbar bahnbrechenden Durchbruch Es erleichtert die Identifizierung von KI-generiertem Text. Da immer wieder bedeutende Updates an KI-gestützte Chatbots wie Bing Chat und ChatGPT geliefert werden, wird es immer schwieriger, mit diesen Tools generierte Texte von menschlichen Texten zu entmystifizieren.

Laut BerichtDer KI-Detektor soll KI-generierten Text in wissenschaftlichen Zeitschriften ermitteln. Die Durchführung von Tests für solche Zeitschriften ist je nach Komplexität des Themas und Verfügbarkeit der Informationen im Internet ein ernstes Unterfangen.

Den Forschern zufolge wurde der KI-Detektor verwendet, um menschliche Autoren von ChatGPT (GPT-3.5) zu unterscheiden. Sie gaben außerdem bekannt, dass die Methodik auf 20 Funktionen und einem Algorithmus für maschinelles Lernen beruhte, der kein Maß für „Perplexität“ enthielt. Dies liegt daran, dass sie es als „problematische Metrik“ eingestuft haben, was in anderen Tools zu einer Voreingenommenheit gegenüber Nicht-Muttersprachlern des Englischen führen würde.

Darüber hinaus zeigt das Modell eine Genauigkeit von 99 % bei der Unterscheidung menschlicher Schrift von Texten, die von ChatGPT erstellt wurden, und übertrifft den GPT-2 Output Detector, eine KI-Erkennungssoftware, die von OpenAI, dem Hersteller von ChatGPT, angeboten wurde, deutlich.

KI-Detektorforscher

Wir haben kürzlich erfahren, dass OpenAI an einem neuen Tool arbeitet, das Benutzern helfen soll, KI-generierte Bilder zu identifizieren. Das Unternehmen versprach eine Genauigkeit von 99 Prozent, es ist jedoch noch nicht klar, wann es allgemein verfügbar sein wird.

Die Forscher geben zu, dass der Umfang der Originalarbeit begrenzt war, da sie nur eine Art von Aufforderung aus einer Zeitschrift getestet haben. Darüber hinaus handelte es sich nicht ausschließlich um eine Zeitschrift für Chemie, ganz zu schweigen davon, dass nur ein Sprachmodell getestet wurde.

Laut den Forschern:

„…wir erweitern den Anwendungsbereich unseres kürzlich beschriebenen KI-Detektors radikal, indem wir ihn auf neue Umstände mit Variabilität im menschlichen Schreiben anwenden, darunter aus 13 verschiedenen Zeitschriften und 3 verschiedenen Verlagen, Variabilität bei KI-Eingabeaufforderungen und Variabilität bei der KI-Textgenerierung.“ Verwendetes Modell. Unter Verwendung der gleichen 20 Funktionen wie zuvor beschrieben trainieren wir einen XGBoost-Klassifikator mit menschlichen Beispieltexten und vergleichendem KI-Text. Anschließend bewerten wir das Modell anhand neuer Beispiele menschlicher Schrift, mehrerer anspruchsvoller KI-Eingabeaufforderungen und sowohl GPT-3.5 als auch GPT-4 zur Erstellung des KI-Textes.“

Der AI Detector verspricht eine Genauigkeit von 99 %

Die Forscher gaben an, dass die Tests zeigten, dass ihre Methodik unkompliziert und effektiv sei. Sie betonten, dass das Tool bei der Identifizierung von KI-generiertem Text eine Genauigkeit von 98–100 % aufwies, dies hing jedoch von der Eingabeaufforderung und dem Modell ab.

Die Forscher gaben an, dass das Tool dem aktualisierten Klassifikator von OpenAI meilenweit voraus ist, dessen Genauigkeit zwischen 10 % und 56 % liegt. Die Forscher gaben weiter bekannt, dass das Ziel dieser Studie und Erfindung darin besteht, der wissenschaftlichen Gemeinschaft einen Weg zu bieten, der es ihr ermöglicht, „die Infiltration von ChatGPT in Chemiezeitschriften zu bewerten, die Folgen seiner Verwendung zu identifizieren und bei auftretenden Problemen schnell Abhilfestrategien einzuführen.“ .“

Was verwendeten die Forscher als Klassifikator für Tests?

Für alle Experimente und Tests setzten die Forscher XGBoost ein, das auf dem R-Paket xgboost basierte. Es bot eine ausgefeilte Möglichkeit, die Modelloptimierung zu messen, da die Genauigkeit auf Absatzebene mithilfe einer Kreuzvalidierung ohne Auslassen einer Einleitung am Trainingssatz gemessen wurde.

Das Forschungsteam erklärte:

„In diesem Paradigma würden alle Trainingsdaten, mit Ausnahme derjenigen, die aus den zu klassifizierenden Absätzen der Einleitung stammen, genutzt, um ein Klassifizierungsmodell zu erstellen. Dieses Modell würde dann verwendet, um alle Absätze von links zu klassifizieren. unsere Einleitung.“

Die Studie hebt hervor, dass diese Bedingungen „die insgesamt beste Genauigkeit auf Absatzebene ergaben“, die dann in allen Tests verwendet wurde.

Sind die Ergebnisse vielversprechend?

Zugegebenermaßen hat der KI-Detektor beeindruckende Ergebnisse geliefert, aber es gibt Raum für Verbesserungen. Da die Technologie relativ neu ist, war mit einer Fehlerlücke zu rechnen. Dennoch sorgt die Fehlklassifizierung von 6 % des getesteten menschlichen Textes für Aufsehen.

Reddit-Benutzer in der r/science subreddit berechtigte Bedenken zu diesem Thema äußern. Ein besorgter Benutzer stellte eine hypothetische Situation vor, in der dieses Tool in der Schule verwendet wurde, und gab an, dass die Ergebnisse darauf hindeuten, dass von 100 Schülern sechs von ihnen fälschlicherweise beschuldigt würden, KI-gestützte Tools für die Erledigung ihrer Kursarbeiten zu nutzen. Und wir alle kennen die erheblichen Rückschläge, die mit der Einreichung von Arbeiten einhergehen, die Sie von woanders übernommen haben.

Dies beweist, wie wichtig zuverlässige und genaue Tools wie AI Detector sind, aber gleichzeitig ist es nahezu unmöglich, die Genauigkeit dieser Tools zu behaupten. Ein anderer Benutzer berichtete von einem Fall, in dem ein Kursleiter eine Aufgabe als KI-generiert gekennzeichnet hatte. Dennoch wurde diese Studie als KI-generierter Inhalt gekennzeichnet, nachdem ich diese Studie mit dem Lehrer geteilt und sogar das Tool verwendet hatte, um den Lehrplan durchzugehen.

Während dies eine wirklich knappe Rasur war, Was passiert, wenn Sie Ihre Ansprüche nicht belegen können? Glauben Sie, dass es einen Punkt erreichen wird, an dem KI-Detektoren absolute Genauigkeit versprechen können? Bitte teilen Sie uns Ihre Gedanken in den Kommentaren mit.