Apple GPT auf einem iPhone?

Mehrere Leaks haben Aufschluss gegeben dass Apple aktiv an der Integration wichtiger Sprachmodelle in seine verschiedenen Systeme arbeitete. Die Cupertino-Teams entwickeln derzeit einen Konversationsroboter und ein großes Sprachmodell, das mit chatgpt von OpenAI, Gemini von google und LLaMA 2 von Meta konkurrieren kann. Wenn Apple nicht die Absicht hat, in diesem wachsenden Markt zurückzubleiben, hat das Unternehmen sicherlich nicht die Absicht, sein Image aufgrund der Wahrung der Vertraulichkeit zu schädigen sollte daher versuchen, sein großes Sprachmodell lokal auszuführen, insbesondere auf iPhones.

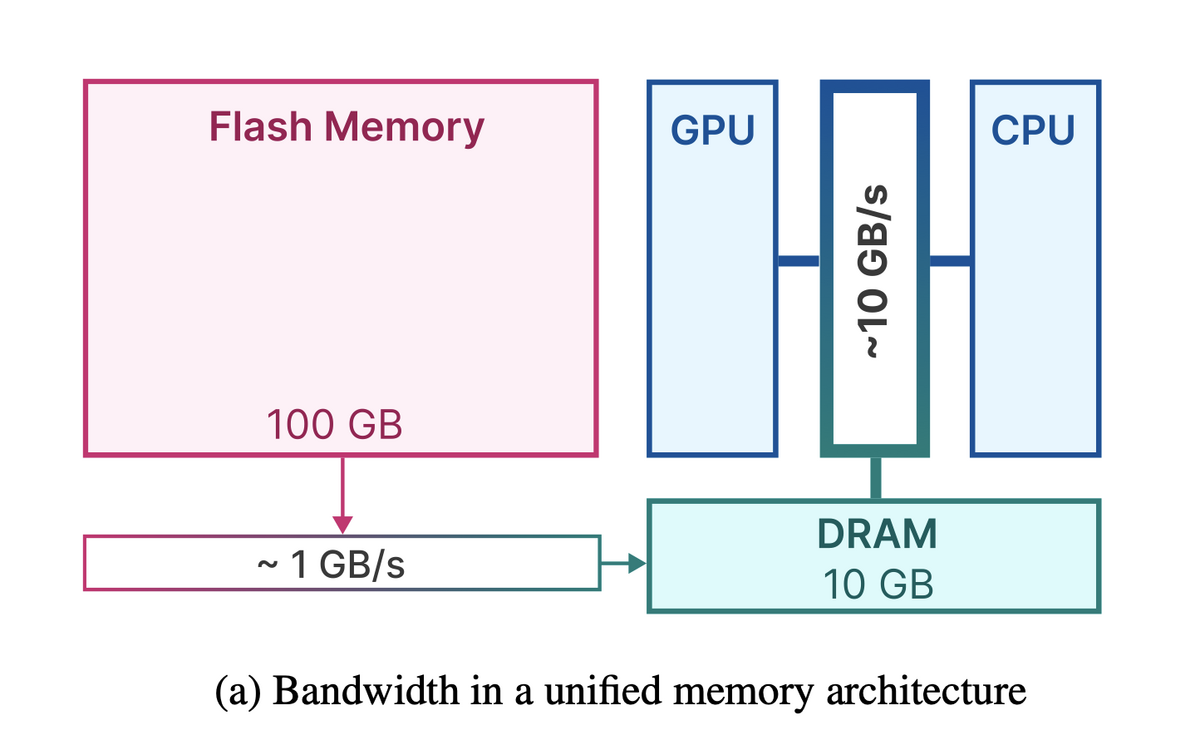

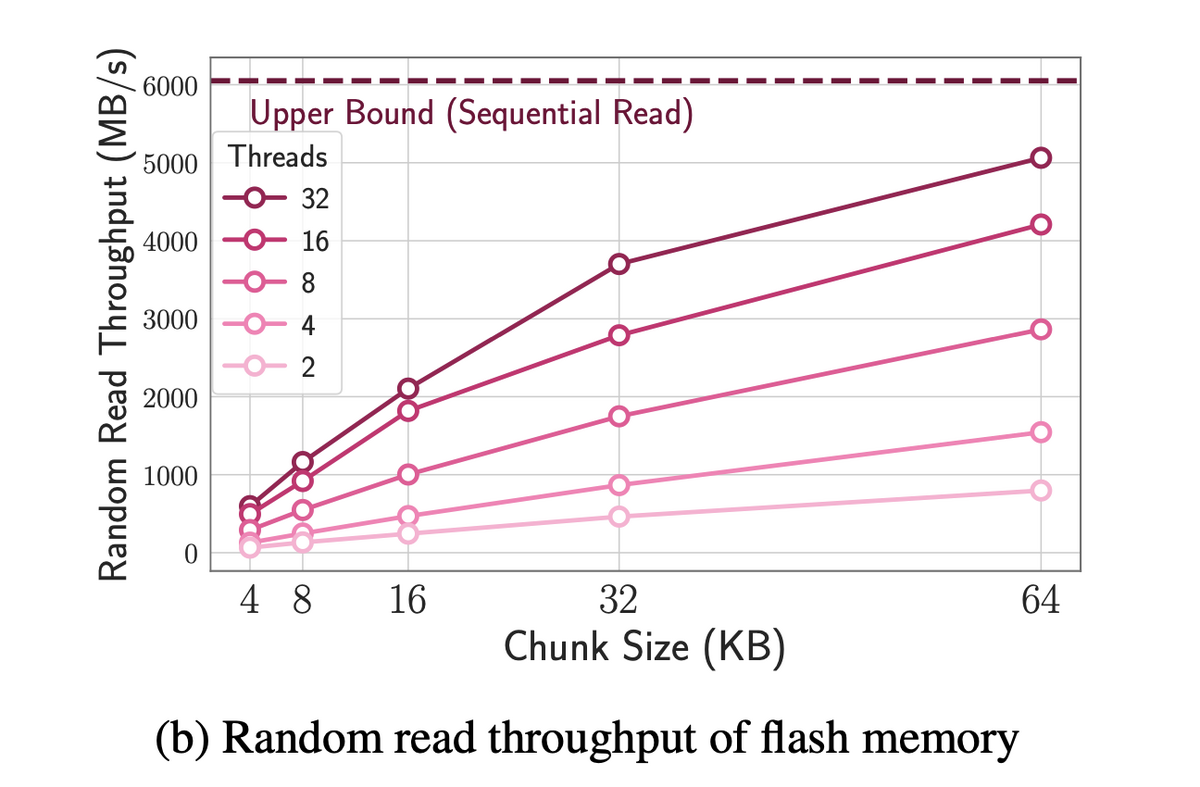

Große Sprachmodelle sind jedoch RAM-intensiv und Apple muss einen Weg finden, seine Technologie auf seinen Smartphones zum Laufen zu bringen, die nicht über viel Speicher verfügen. Cupertino hat Arbeiten zu diesem Thema veröffentlicht. Betitelt LLM im HandumdrehenIn diesem Dokument wird die Möglichkeit der Nutzung des internen Speichers von Geräten erwähnt, was viel wichtiger ist (Es ist dann jedoch erforderlich, einen Teil des Speichers für diese Nutzung zu reservieren), bei gleichzeitiger Begrenzung der RAM-Nutzunginsbesondere dank der Techniken von Fensterbau

und von Zeilen-Spalten-Bündelung

in der Datei beschrieben.

Beheben Sie RAM-Mangel

Durch die Kombination dieser beiden Methoden wäre Apple nicht nur dazu in der Lage Um das Problem des Speichermangels zu umgehen, indem Sie Modelle verwenden, die doppelt so viel Platz beanspruchen wie der verfügbare RAM, können Sie aber auch eine effiziente Verarbeitung erzielen. Das Dokument erwähnt eine vier- bis fünfmal schnellere Verarbeitung mit der CPU und eine 20- bis 25-mal schnellere Verarbeitung mit der GPU als mit der herkömmlichen Methode.

Apple konnte sich daher auf diese Arbeit verlassen, um eine lokale Verarbeitung anzubieten und so die unantastbare Vertraulichkeit der Daten seiner Benutzer zu respektieren sowie eine zufriedenstellende Leistung zu erzielen. Es bleibt abzuwarten, wann und wie Apple in den Kampf der Konversationsroboter einsteigt (Werden wir endlich eine erfolgreiche Siri haben?) und auf welchem Niveau wird ihr Modell mit der Konkurrenz verglichen werden?

![Call of Duty speichert den Fortschritt nicht [Fix]](https://static.futuriq.de/uploads/2024/04/call-progress-180x135.jpg)