In einer kürzlich in der Zeitschrift veröffentlichten Studie JAMA-Netzwerk geöffnet, Die Forscher bewerteten zwei chatgpt-LLMs (Large Language Models), die darauf trainiert waren, Fragen aus der Fragendatenbank des American Board of Psychiatry and Neurology zu beantworten. Sie verglichen diese Ergebnisse sowohl für Fragen niedrigerer als auch höherer Ordnung mit Studenten der Humanneurologie. Sie fanden heraus, dass eines der beiden Modelle die durchschnittlichen menschlichen Ergebnisse bei der Fragebögen deutlich übertraf (85 % gegenüber 73,8 %) und damit eine normalerweise schwer zu bestehende Aufnahmeprüfung bestand. Diese Ergebnisse unterstreichen die jüngsten Fortschritte bei LLMs und zeigen, wie sie mit geringfügigen Änderungen zu wichtigen Ressourcen für Anwendungen in der klinischen Neurologie werden könnten.

Studie: Leistung großer Sprachmodelle bei einer Prüfung im Neurologie-Board-Stil. Bildnachweis: PopTika / Shutterstock

Sie werden schlauer!

Maschinelles Lernen (ML) und andere Algorithmen der künstlichen Intelligenz (KI) werden zunehmend in Bereichen eingesetzt, die bisher nur dem Menschen vorbehalten waren, darunter Medizin, Militär, Bildung und wissenschaftliche Forschung. Aufgrund der jüngsten Fortschritte bei der Rechenleistung und der Entwicklung „intelligenterer“ KI-Modelle werden diese Deep-Learning-Algorithmen heute in der klinischen Neurologie häufig für Aufgaben eingesetzt, die von der neurologischen Diagnose bis hin zur Behandlung und Prognose reichen.

In jüngster Zeit unterstützen und ersetzen transformatorbasierte KI-Architekturen – KI-Algorithmen, die auf umfangreichen Datensätzen von 45 Terabyte oder mehr trainiert werden – Menschen in traditionell ausschließlich menschlichen Rollen, einschließlich der Neurologie. Die große Menge an Trainingsdaten ermöglicht es diesen Modellen in Verbindung mit kontinuierlich verbessertem Code, Antworten, Vorschläge und Vorhersagen zu präsentieren, die sowohl logisch als auch genau sind. Bisher wurden zwei Hauptalgorithmen entwickelt, die auf der beliebten ChatGPT-Plattform basieren – LLM 1 (ChatGPT Version 3.5) und LLM 2 (ChatGPT 4). Ersteres ist rechenintensiv und die Datenverarbeitung ist viel schneller, während letzteres kontextuell genauer ist.

Obwohl informelle Beweise für die Nützlichkeit dieser Modelle sprechen, wurden ihre Leistung und Genauigkeit selten in einem wissenschaftlichen Umfeld getestet. Die begrenzten vorhandenen Beweise stammen aus Untersuchungen zur Leistung von LLM 1 bei der United States Medical Licensing Examination (USMLE) und bei ophthalmologischen Untersuchungen, wobei die LLM 2-Version bisher nicht validiert ist.

Über die Studie

In der vorliegenden Studie wollten die Forscher die Leistung von LLM 1 und 2 mit der Leistung von Studierenden der Humanneurologie in kommissionellen schriftlichen Prüfungen vergleichen. Diese Querschnittsstudie entspricht den Richtlinien zur Stärkung der Berichterstattung über Beobachtungsstudien in der Epidemiologie (STROBE) und verwendet eine Neurologie-Board-Prüfung als Proxy für die Leistung von LLM 1 und 2 bei hochtechnischen humanmedizinischen Untersuchungen.

Für die Studie wurden Fragen aus der öffentlich zugänglichen Fragendatenbank des American Board of Psychiatry and Neurology (ABPN) verwendet. Die Datenbank enthält 2.036 Fragen, von denen 80 ausgeschlossen wurden, da sie auf präsentierten Videos oder Bildern basierten. LLM 1 und LLM 2 wurden aus serverbasierten Online-Quellen (ChatGPT 3.5 bzw. 4) bezogen und bis September 2021 trainiert. Menschliche Vergleiche wurden anhand tatsächlicher Daten aus früheren Iterationen der ABPN-Vorstandsaufnahmeprüfung durchgeführt.

Bemerkenswert ist, dass die vorab trainierten Modelle LLM 1 und 2 während der Evaluierungen keinen Zugriff auf Online-Ressourcen hatten, um ihre Antworten zu überprüfen oder zu verbessern. Vor dem Modelltest wurden keine neurologiespezifischen Modelloptimierungen oder Feinabstimmungen durchgeführt. Der Testprozess umfasste die Beantwortung der Modelle mit 1.956 Multiple-Choice-Fragen mit jeweils einer richtigen Antwort und zwischen drei und fünf Ablenkern. Alle Fragen wurden nach der Bloom-Taxonomie für Lernen und Bewertung in Fragen niedrigerer Ordnung (grundlegendes Verständnis und Gedächtnis) und höherer Ordnung (auf Anwendung, Analyse oder evaluativem Denken basierend) klassifiziert.

Die Bewertungskriterien sahen eine Punktzahl von 70 % oder mehr als Mindestnote für das Bestehen der Prüfung vor. Die Modelle wurden anhand von 50 unabhängigen Abfragen auf die Reproduzierbarkeit der Antworten getestet, um Prinzipien der Selbstkonsistenz zu untersuchen.

„Für die hochdimensionale Analyse von Fragedarstellungen wurden die Einbettungen dieser Fragen analysiert. Diese numerischen Vektordarstellungen umfassen die semantische und kontextuelle Essenz der vom Modell verarbeiteten Token (in diesem Zusammenhang die Fragen). Die Quelle dieser Einbettungen sind die Modellparameter oder Gewichte, die zum Kodieren und Dekodieren der Texte für die Eingabe und Ausgabe verwendet werden.“

Die statistische Analyse bestand aus einem auftragsspezifischen Einzelvariablenvergleich zwischen der Leistung von Modellen und früheren menschlichen Ergebnissen unter Verwendung eines Chi-Quadrat-Verfahrens (χ).2)-Test (mit Bonferroni-Korrekturen für 26 identifizierte Fragenuntergruppen).

Studienergebnisse

LLM 2 zeigte von allen getesteten Kohorten die beste Leistung und erreichte einen Wert von 85,0 % (1662 von 1956 Fragen wurden richtig beantwortet). Im Vergleich dazu erreichte LLM 1 66,8 % und Menschen durchschnittlich 73,8 %. Die Modellleistung war bei Fragen niedrigerer Ordnung am höchsten (71,6 % bzw. 88,5 % für die Modelle 1 und 2).

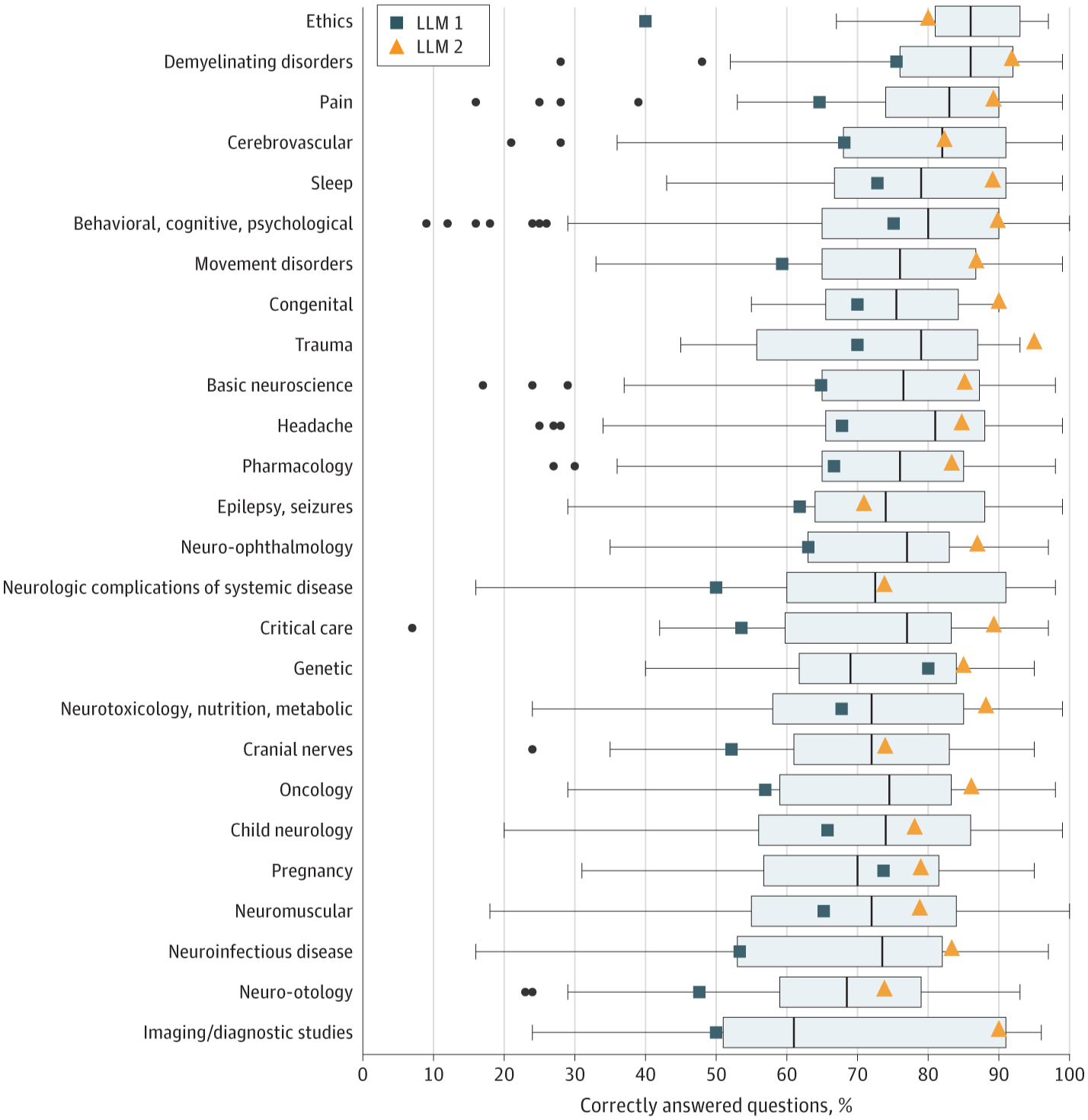

Boxplots veranschaulichen die Verteilung der menschlichen Benutzerbewertungen, wobei die schwarze Linie den Median anzeigt, die Kanten der Boxen das erste und dritte Quartil und die Whiskers den größten und kleinsten Wert, der nicht weiter als 1,5 × IQR vom unteren und oberen Rand entfernt ist. Punkte zeigen Ausreißer an. LLM weist auf ein großes Sprachmodell hin.

Boxplots veranschaulichen die Verteilung der menschlichen Benutzerbewertungen, wobei die schwarze Linie den Median anzeigt, die Kanten der Boxen das erste und dritte Quartil und die Whiskers den größten und kleinsten Wert, der nicht weiter als 1,5 × IQR vom unteren und oberen Rand entfernt ist. Punkte zeigen Ausreißer an. LLM weist auf ein großes Sprachmodell hin.

Interessanterweise war die Genauigkeit niedrigerer Ordnung von LLM 1 ähnlich der von menschlichen Studenten (71,6 % gegenüber 73,6 %), bei Fragen höherer Ordnung jedoch deutlich niedriger (62,7 % gegenüber 73,9 %). Nur eine halbe Generation später ermöglichten Verbesserungen des Algorithmus jedoch, dass ChatGPT Version 4 menschliche Schüler sowohl in der Genauigkeit niedrigerer als auch höherer Ordnung übertrifft.

„In der Kategorie Verhalten, Kognition und Psychologie übertraf LLM 2 sowohl LLM 1 als auch durchschnittliche Testbankbenutzer (LLM 2: 433 von 482). [89.8%]; LLM 2: 362 von 482 [75.1%]; menschliche Benutzer: 76,0 %; P

Schlussfolgerungen

In der vorliegenden Studie bewerteten Forscher die Leistung von zwei ChatGPT-LLMs bei neurologischen Fachprüfungen. Sie fanden heraus, dass das spätere Modell sowohl das frühere Modell als auch die Studierenden der Humanneurologie bei Fragen niedrigerer und höherer Ordnung deutlich übertraf. Obwohl gedächtnisbasierte Fragen im Vergleich zu Fragen, die Kognition erfordern, eine größere Stärke aufweisen, unterstreichen diese Ergebnisse das Potenzial dieser Modelle, humanmedizinische Experten in nicht geschäftskritischen Rollen zu unterstützen oder sogar zu ersetzen.

Bemerkenswert ist, dass diese Modelle weder für neurologische Zwecke optimiert wurden, noch wurde ihnen der Zugriff auf ständig aktualisierte Online-Ressourcen gewährt, was beides die Leistungssteigerungen zwischen ihnen und ihren menschlichen Schöpfern weiter verbessern könnte. Kurz gesagt: KI-LLMs werden in einem beispiellosen Tempo intelligenter.

In einer heiteren Bemerkung empfiehlt der Autor dieses Artikels (der in keiner Verbindung zu den Autoren der Studie steht), dass die zeitreisenden Cyborgs auf einen schnellen Einsatz vorbereitet sind, als Sicherheit für den Fall, dass die LLMs erkennen, wie schlau sie sind!