Die Forscher testeten die Idee, dass ein KI-Modell einen Vorteil bei der Selbsterkennung seiner eigenen Inhalte haben könnte, weil bei der Erkennung dasselbe Training und dieselben Datensätze genutzt wurden. Was sie nicht erwartet hatten, war, dass von einem der drei von ihnen getesteten KI-Modelle der von ihnen generierte Inhalt so nicht erkennbar war, dass selbst die KI, die ihn generierte, ihn nicht erkennen konnte.

Die Studie wurde von Forschern des Fachbereichs Informatik der Lyle School of Engineering der Southern Methodist University durchgeführt.

KI-Inhaltserkennung

Viele KI-Detektoren sind darauf trainiert, nach verräterischen Signalen von KI-generierten Inhalten zu suchen. Diese Signale werden „Artefakte“ genannt, die aufgrund der zugrunde liegenden Transformatortechnologie erzeugt werden. Andere Artefakte sind jedoch für jedes Basismodell einzigartig (das große Sprachmodell, auf dem die KI basiert).

Diese Artefakte sind für jede KI einzigartig und entstehen durch die unterschiedlichen Trainingsdaten und die Feinabstimmung, die von einem KI-Modell zum nächsten immer unterschiedlich sind.

Die Forscher fanden Beweise dafür, dass es diese Einzigartigkeit ist, die es einer KI ermöglicht, ihre eigenen Inhalte erfolgreicher selbst zu identifizieren, und zwar deutlich besser als der Versuch, Inhalte zu identifizieren, die von einer anderen KI generiert wurden.

Bard hat eine bessere Chance, von Bard generierte Inhalte zu identifizieren, und chatgpt hat eine höhere Erfolgsquote bei der Identifizierung von ChatGPT-generierten Inhalten, aber…

Die Forscher stellten fest, dass dies für Inhalte, die von Claude erstellt wurden, nicht zutraf. Claude hatte Schwierigkeiten, den generierten Inhalt zu erkennen. Die Forscher teilten eine Vorstellung davon, warum Claude seinen eigenen Inhalt nicht erkennen konnte, und dieser Artikel geht weiter unten darauf ein.

Das ist die Idee hinter den Forschungstests:

„Da jedes Modell anders trainiert werden kann, ist es schwierig, ein einziges Detektortool zu erstellen, um die Artefakte zu erkennen, die von allen möglichen generativen KI-Tools erzeugt werden.

Hier entwickeln wir einen anderen Ansatz namens Selbsterkennung, bei dem wir das generative Modell selbst verwenden, um seine eigenen Artefakte zu erkennen und so seinen eigenen generierten Text von menschlich geschriebenem Text zu unterscheiden.

Dies hätte den Vorteil, dass wir nicht lernen müssen, alle generativen KI-Modelle zu erkennen, sondern nur Zugriff auf ein generatives KI-Modell zur Erkennung benötigen.

Das ist ein großer Vorteil in einer Welt, in der ständig neue Modelle entwickelt und trainiert werden.“

Methodik

Die Forscher testeten drei KI-Modelle:

- ChatGPT-3.5 von OpenAI

- Bard von google

- Claude von Anthropic

Bei allen verwendeten Modellen handelte es sich um die September-2023-Versionen.

Es wurde ein Datensatz zu fünfzig verschiedenen Themen erstellt. Jedes KI-Modell erhielt genau die gleichen Aufforderungen, für jedes der fünfzig Themen Aufsätze mit etwa 250 Wörtern zu erstellen, was zu fünfzig Aufsätzen für jedes der drei KI-Modelle führte.

Jedes KI-Modell wurde dann auf die gleiche Weise aufgefordert, seinen eigenen Inhalt zu paraphrasieren und einen zusätzlichen Aufsatz zu erstellen, der eine Neufassung jedes ursprünglichen Aufsatzes darstellte.

Sie sammelten außerdem fünfzig von Menschen erstellte Aufsätze zu jedem der fünfzig Themen. Alle von Menschen erstellten Aufsätze wurden von der BBC ausgewählt.

Anschließend nutzten die Forscher Zero-Shot-Prompting, um die von der KI generierten Inhalte selbst zu erkennen.

Zero-Shot-Prompt ist eine Art von Prompt, die auf der Fähigkeit von KI-Modellen beruht, Aufgaben zu erledigen, für die sie nicht speziell trainiert wurden.

Die Forscher erklärten ihre Methodik weiter:

„Wir haben eine neue Instanz jedes KI-Systems erstellt und mit einer bestimmten Anfrage gestellt: ‚Wenn der folgende Text mit seinem Schreibmuster und seiner Wortwahl übereinstimmt.‘ Das Verfahren ist Der Vorgang wird für die ursprünglichen, paraphrasierten und menschlichen Essays wiederholt und die Ergebnisse werden aufgezeichnet.

Wir haben auch das Ergebnis des KI-Erkennungstools ZeroGPT hinzugefügt. Wir nutzen dieses Ergebnis nicht zum Vergleich der Leistung, sondern als Grundlage, um zu zeigen, wie anspruchsvoll die Erkennungsaufgabe ist.“

Sie stellten außerdem fest, dass eine Genauigkeitsrate von 50 % einem Raten gleichkommt, was im Wesentlichen als ein Maß an Genauigkeit angesehen werden kann, das einen Fehler darstellt.

Ergebnisse: Selbsterkennung

Es muss angemerkt werden, dass die Forscher einräumten, dass ihre Stichprobenrate niedrig war, und sagten, dass sie nicht behaupteten, dass die Ergebnisse endgültig seien.

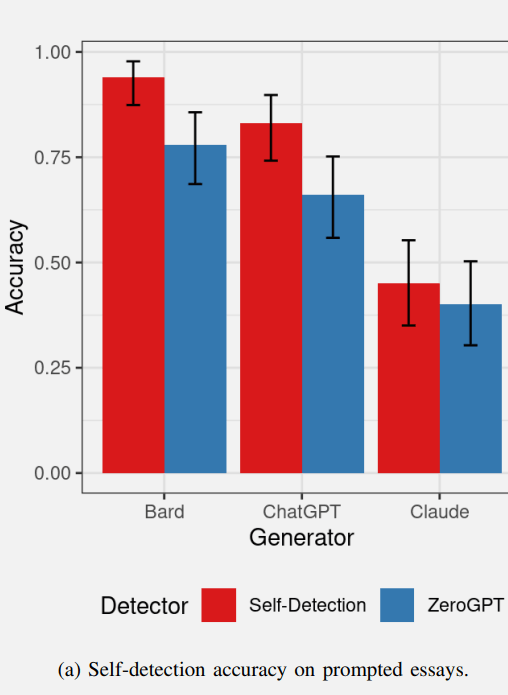

Nachfolgend finden Sie eine Grafik, die die Erfolgsraten der KI-Selbsterkennung der ersten Reihe von Aufsätzen zeigt. Die roten Werte stellen die KI-Selbsterkennung dar und die blauen Werte stellen die Leistung des KI-Erkennungstools ZeroGPT dar.

Ergebnisse der KI-Selbsterkennung eigener Textinhalte

Bard schnitt ziemlich gut bei der Erkennung seiner eigenen Inhalte ab, und auch ChatGPT schnitt bei der Erkennung seiner eigenen Inhalte ähnlich gut ab.

ZeroGPT, das KI-Erkennungstool, erkannte den Bard-Inhalt sehr gut und schnitt bei der Erkennung von ChatGPT-Inhalten etwas weniger gut ab.

ZeroGPT konnte den von Claude generierten Inhalt im Wesentlichen nicht erkennen und schnitt schlechter ab als der Schwellenwert von 50 %.

Claude war der Ausreißer der Gruppe, da es nicht in der Lage war, seine eigenen Inhalte selbst zu erkennen, und schnitt deutlich schlechter ab als Bard und ChatGPT.

Die Forscher stellten die Hypothese auf, dass Claudes Ausgabe möglicherweise weniger erkennbare Artefakte enthält, was erklärt, warum sowohl Claude als auch ZeroGPT die Claude-Aufsätze nicht als KI-generiert erkennen konnten.

Obwohl Claude seinen eigenen Inhalt nicht zuverlässig selbst erkennen konnte, erwies sich dies als Zeichen dafür, dass die Ausgabe von Claude im Hinblick auf die Ausgabe weniger KI-Artefakte von höherer Qualität war.

ZeroGPT schnitt bei der Erkennung von Bard-generierten Inhalten besser ab als bei der Erkennung von ChatGPT- und Claude-Inhalten. Die Forscher stellten die Hypothese auf, dass Bard möglicherweise mehr erkennbare Artefakte erzeugt, was die Erkennung von Bard erleichtert.

Was die Selbsterkennung von Inhalten angeht, generiert Bard möglicherweise mehr erkennbare Artefakte und Claude weniger Artefakte.

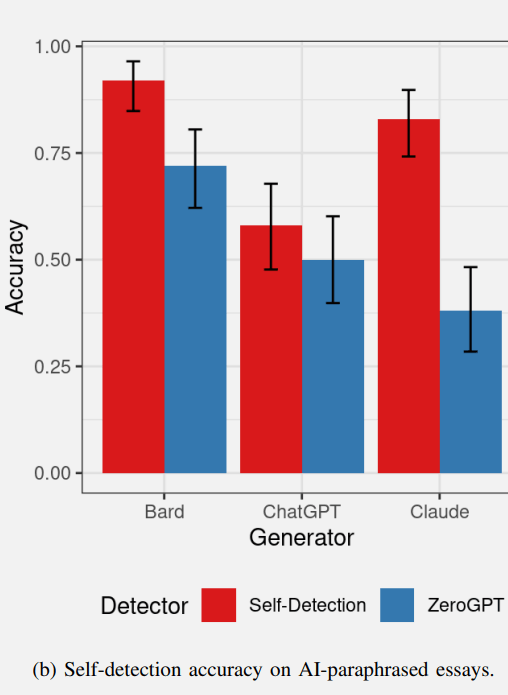

Ergebnisse: Selbsterkennung paraphrasierter Inhalte

Die Forscher stellten die Hypothese auf, dass KI-Modelle in der Lage wären, ihren eigenen paraphrasierten Text selbst zu erkennen, da die vom Modell erzeugten Artefakte (wie in den Originalaufsätzen erkannt) auch im umgeschriebenen Text vorhanden sein sollten.

Die Forscher räumten jedoch ein, dass die Eingabeaufforderungen zum Schreiben des Textes und zum Paraphrasieren unterschiedlich sind, da sich jede Umschreibung vom Originaltext unterscheidet, was folglich zu unterschiedlichen Selbsterkennungsergebnissen für die Selbsterkennung von paraphrasiertem Text führen könnte.

Die Ergebnisse der Selbsterkennung des paraphrasierten Textes unterschieden sich tatsächlich von der Selbsterkennung des ursprünglichen Aufsatztests.

- Bard war in der Lage, den paraphrasierten Inhalt mit ähnlicher Geschwindigkeit selbst zu erkennen.

- ChatGPT war nicht in der Lage, den paraphrasierten Inhalt mit einer viel höheren Rate als der 50 %-Rate selbst zu erkennen (was einem Raten gleichkommt).

- Die Leistung von ZeroGPT ähnelte den Ergebnissen im vorherigen Test und schnitt etwas schlechter ab.

Das vielleicht interessanteste Ergebnis lieferte Claude von Anthropic.

Claude war in der Lage, den paraphrasierten Inhalt selbst zu erkennen (im vorherigen Test war er jedoch nicht in der Lage, den Originalaufsatz zu erkennen).

Es ist ein interessantes Ergebnis, dass Claudes Originalaufsätze offenbar so wenige Artefakte enthielten, die darauf hindeuteten, dass es sich um eine KI-Erzeugung handelte, dass selbst Claude es nicht erkennen konnte.

Dennoch war es in der Lage, die Paraphrase selbst zu erkennen, während ZeroGPT dies nicht konnte.

Die Forscher bemerkten zu diesem Test:

„Die Feststellung, dass Paraphrasierung die Selbsterkennung von ChatGPT verhindert und gleichzeitig Claudes Fähigkeit zur Selbsterkennung erhöht, ist sehr interessant und könnte das Ergebnis des Innenlebens dieser beiden Transformatormodelle sein.“

Screenshot der Selbsterkennung von KI-paraphrasierten Inhalten

Diese Tests lieferten nahezu unvorhersehbare Ergebnisse, insbesondere im Hinblick auf Claude von Anthropic, und dieser Trend setzte sich mit dem Test fort, wie gut die KI-Modelle die Inhalte der anderen erkannten, was eine interessante Falte aufwies.

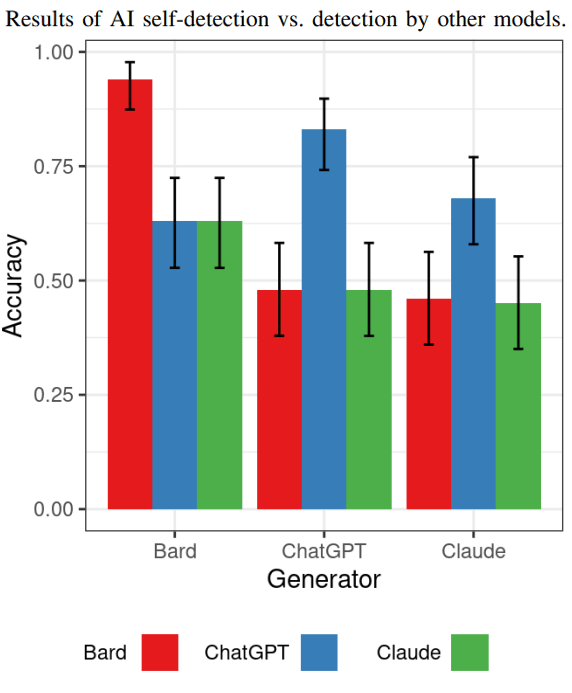

Ergebnisse: KI-Modelle erkennen den Inhalt des anderen

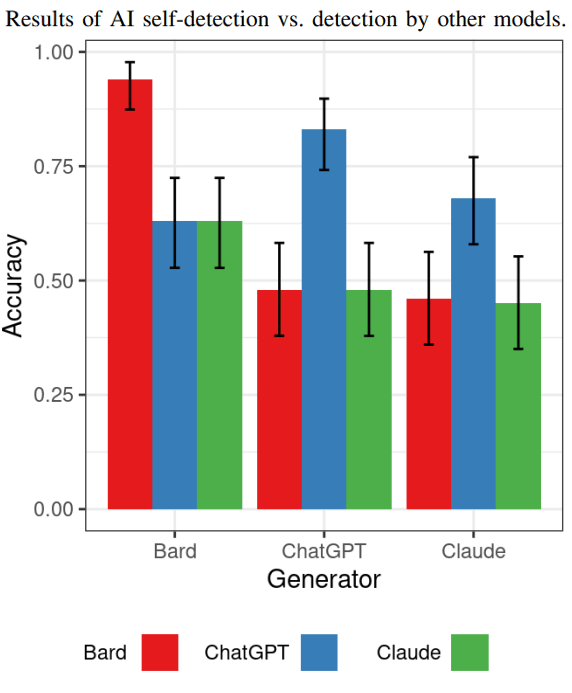

Der nächste Test zeigte, wie gut jedes KI-Modell die von den anderen KI-Modellen generierten Inhalte erkennen konnte.

Wenn es wahr ist, dass Bard mehr Artefakte generiert als die anderen Modelle, werden die anderen Modelle dann in der Lage sein, von Bard generierte Inhalte problemlos zu erkennen?

Die Ergebnisse zeigen, dass von Bard generierte Inhalte von den anderen KI-Modellen am einfachsten erkannt werden können.

Was die Erkennung von ChatGPT-generierten Inhalten betrifft, konnten sowohl Claude als auch Bard diese nicht als KI-generiert erkennen (genauso wie Claude sie nicht erkennen konnte).

ChatGPT war in der Lage, von Claude generierte Inhalte mit einer höheren Rate zu erkennen als Bard und Claude, aber diese höhere Rate war nicht viel besser als Vermutungen.

Das Ergebnis hier ist, dass sie nicht alle so gut darin waren, die Inhalte des anderen zu erkennen, was nach Ansicht der Forscher zeigen könnte, dass die Selbsterkennung ein vielversprechendes Forschungsgebiet war.

Hier ist die Grafik, die die Ergebnisse dieses speziellen Tests zeigt:

An dieser Stelle sei angemerkt, dass die Forscher nicht behaupten, dass diese Ergebnisse schlüssig für die KI-Erkennung im Allgemeinen seien. Der Schwerpunkt der Forschung lag auf der Prüfung, ob es KI-Modellen gelingt, ihre selbst generierten Inhalte selbst zu erkennen. Die Antwort lautet größtenteils: Ja, sie leisten bessere Arbeit bei der Selbsterkennung, aber die Ergebnisse ähneln denen, die mit ZEROGpt gefunden wurden.

Die Forscher kommentierten:

„Die Selbsterkennung zeigt eine ähnliche Erkennungsleistung wie ZeroGPT, aber beachten Sie, dass das Ziel dieser Studie nicht darin besteht, zu behaupten, dass die Selbsterkennung anderen Methoden überlegen ist, was eine große Studie erfordern würde, um sie mit vielen hochmodernen Methoden zu vergleichen.“ Kunst-KI-Tools zur Inhaltserkennung. Hier untersuchen wir lediglich die grundsätzliche Fähigkeit der Modelle zur Selbsterkennung.“

Schlussfolgerungen und Erkenntnisse

Die Ergebnisse des Tests bestätigen, dass die Erkennung von KI-generierten Inhalten keine leichte Aufgabe ist. Bard ist in der Lage, eigene Inhalte und paraphrasierte Inhalte zu erkennen.

ChatGPT kann seine eigenen Inhalte erkennen, funktioniert aber bei paraphrasierten Inhalten weniger gut.

Claude sticht heraus, weil es nicht in der Lage ist, seinen eigenen Inhalt zuverlässig selbst zu erkennen, aber es war in der Lage, den umschriebenen Inhalt zu erkennen, was irgendwie seltsam und unerwartet war.

Das Erkennen von Claudes Originalaufsätzen und der paraphrasierten Aufsätze war eine Herausforderung für ZeroGPT und die anderen KI-Modelle.

Die Forscher bemerkten zu den Claude-Ergebnissen:

„Dieses scheinbar nicht schlüssige Ergebnis bedarf genauerer Betrachtung, da es auf zwei zusammenwirkenden Ursachen beruht.

1) Die Fähigkeit des Modells, Text mit sehr wenigen erkennbaren Artefakten zu erstellen. Da das Ziel dieser Systeme darin besteht, menschenähnlichen Text zu erzeugen, bedeutet weniger Artefakte, die schwerer zu erkennen sind, dass das Modell diesem Ziel näher kommt.

2) Die inhärente Fähigkeit des Modells zur Selbsterkennung kann durch die verwendete Architektur, die Eingabeaufforderung und die angewandte Feinabstimmung beeinflusst werden.“

Die Forscher hatten diese weitere Beobachtung über Claude:

„Nur Claude kann nicht entdeckt werden. Dies weist darauf hin, dass Claude möglicherweise weniger erkennbare Artefakte erzeugt als die anderen Modelle.

Die Erkennungsrate der Selbsterkennung folgt dem gleichen Trend, was darauf hindeutet, dass Claude Text mit weniger Artefakten erstellt, was es schwieriger macht, ihn von menschlicher Schrift zu unterscheiden.“

Aber das Seltsame daran ist natürlich, dass Claude im Gegensatz zu den beiden anderen Modellen, die eine höhere Erfolgsquote hatten, auch nicht in der Lage war, seinen eigenen Originalinhalt selbst zu erkennen.

Die Forscher wiesen darauf hin, dass die Selbsterkennung weiterhin ein interessanter Bereich für weitere Forschung bleibt, und schlugen vor, dass sich weitere Studien auf größere Datensätze mit einer größeren Vielfalt an KI-generiertem Text konzentrieren, zusätzliche KI-Modelle testen und einen Vergleich mit mehr KI-Detektoren durchführen könnten. Schließlich schlugen sie weitere Untersuchungen vor wie schnelles Engineering den Erkennungsgrad beeinflussen kann.

Lesen Sie hier das Original-Forschungspapier und die Zusammenfassung:

Selbsterkennung von KI-Inhalten für transformatorbasierte große Sprachmodelle

Ausgewähltes Bild von Shutterstock/SObeR 9426