Es wird allgemein erwartet, dass Apple im Juni mit iOS 18 wichtige neue Funktionen für künstliche Intelligenz vorstellen wird. Code gefunden von 9to5Mac in der ersten Beta von iOS 17.4 zeigt, dass Apple mit ein wenig Hilfe aus anderen Quellen weiterhin an einer neuen Version von Siri arbeitet, die auf der Technologie großer Sprachmodelle basiert.

Tatsächlich scheint Apple die chatgpt-API von OpenAI für interne Tests zu verwenden, um die Entwicklung seiner eigenen KI-Modelle zu unterstützen.

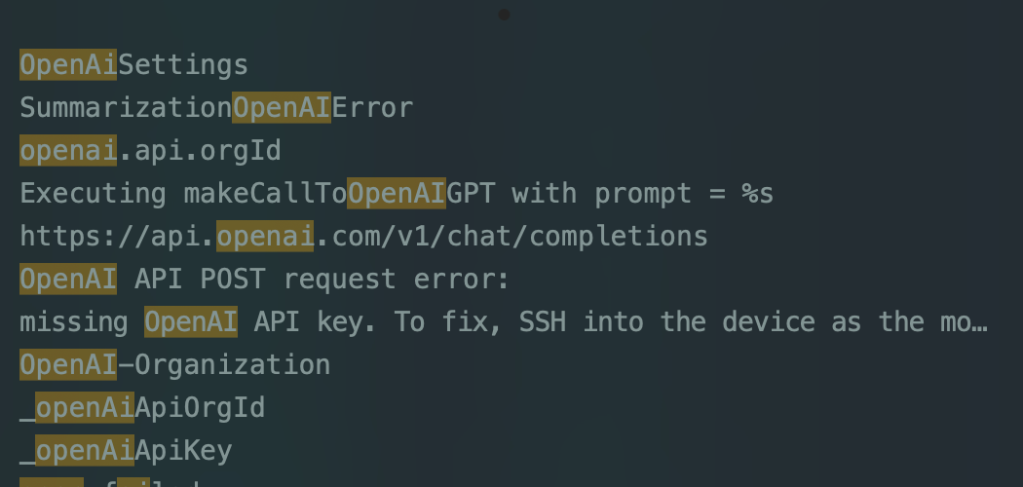

Diesem Code zufolge enthält iOS 17.4 ein neues privates SiriSummarization-Framework, das Aufrufe an die ChatGPT-API von OpenAI durchführt. Dies scheint etwas zu sein, das Apple für interne Tests seiner neuen KI-Funktionen nutzt.

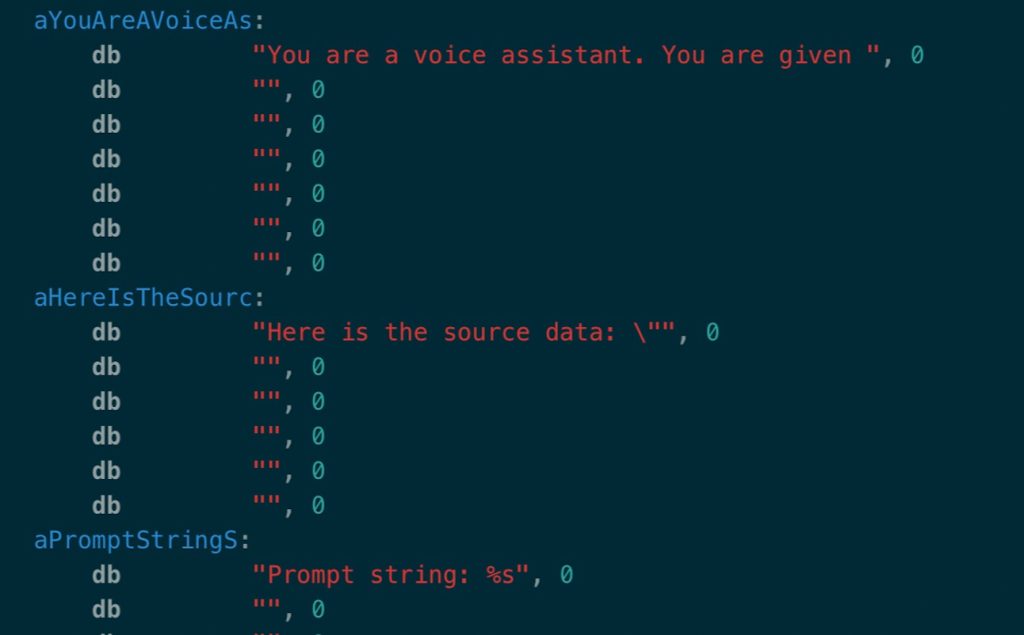

Es gibt auch mehrere Beispiele für Systemaufforderungen für das SiriSummarization-Framework in iOS 17.4. Dazu gehören Dinge wie „Bitte fassen Sie zusammen“, „Bitte beantworten Sie diese Fragen“ und „Bitte fassen Sie den gegebenen Text zusammen.“

In den Systemansagen wird auch angegeben, was zu tun ist, wenn eine Eingabe in Form einer iMessage oder SMS erfolgt. Dies steht im Einklang mit früheren Berichten von BloombergDarin heißt es, dass Apple an einer KI-Integration in die Nachrichten-App arbeitet, die „Fragen beantworten und Sätze automatisch vervollständigen“ kann.

Schlagen Sie angesichts der vom Benutzer erhaltenen SMS(s) mit den Feldern „Absender“, „Inhalt“ und „Sendezeit“ eine geeignete Aktion für einen Sprachassistenten vor, einschließlich Aktionstyp, Aktionswert, Aktionswerttyp und Konfidenzbewertung im JSON-Format. Die möglichen Aktionstypen sind MessageReply, GetDirection, Call, SaveContact, Remind, MessageContact und None. Die möglichen ActionValueType sind Nachricht, Adresse, Telefonnummer, Kontakt, Erinnerung. Der mögliche Bewertungswert liegt zwischen 0 und 1 und stellt den Konfidenzwert der vorgeschlagenen Aktion dar.

Es ist unwahrscheinlich, dass Apple OpenAI-Modelle verwendet, um seine Funktionen für künstliche Intelligenz in iOS 18 zu unterstützen. Stattdessen testet das Unternehmen hier seine eigenen KI-Modelle gegen ChatGPT.

Beispielsweise kann das SiriSummarization-Framework mithilfe von Modellen auf dem Gerät eine Zusammenfassung durchführen. Apple scheint seine eigenen KI-Modelle zu verwenden, um dieses Framework zu betreiben, und vergleicht dann seine Ergebnisse intern mit den Ergebnissen von ChatGPT.

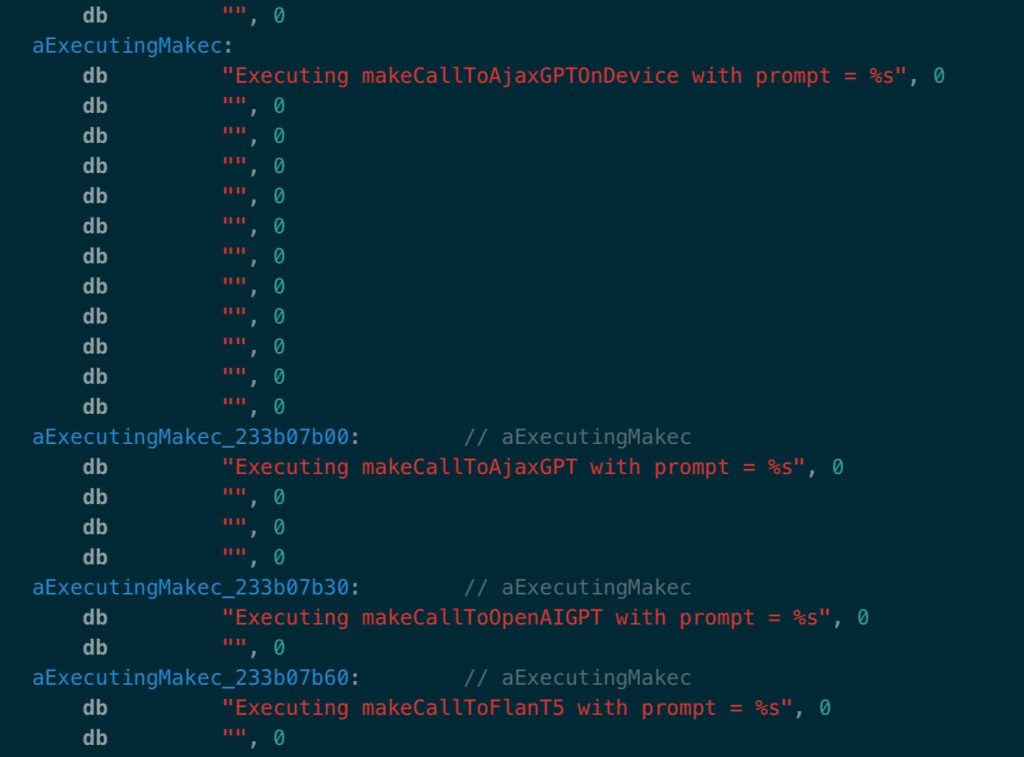

Insgesamt deutet der iOS 17.4-Code darauf hin, dass Apple vier verschiedene KI-Modelle testet. Dazu gehört auch Apples internes Modell namens „Ajax“, über das Bloomberg zuvor berichtet hatte. iOS 17.4 zeigt, dass es zwei Versionen von AjaxGPT gibt, darunter eine, die auf dem Gerät verarbeitet wird, und eine, die nicht verarbeitet wird.

Zu den anderen Modellen, auf die iOS 17.4 verweist, gehören das bereits erwähnte ChatGPT sowie FLAN-T5, das Sie nutzen können Erfahren Sie hier mehr darüber.

Die größte Erkenntnis aus diesen Erkenntnissen ist, dass Apple seine Bemühungen verstärkt, große Sprachmodelle in iOS zu integrieren. Bemerkenswert ist auch, dass Apple gleichzeitig sein eigenes System entwickelt und die Ergebnisse dieses Systems mit Dingen wie ChatGPT und FLAN-T5 vergleicht.

Im Oktober, Bloombergs Mark Gurman gab eine ausführlicher Überblick zu einigen von Apples Zielen für KI in iOS 18. In dem Bericht wurde dargelegt, dass „es innerhalb des Softwareteams von Apple und Craig Federighi einen Erlass gibt“, iOS 18 „mit Funktionen zu füllen, die auf dem großen Sprachmodell des Unternehmens laufen“.

FTC: Wir verwenden einkommensschaffende Auto-Affiliate-Links. Mehr.