OpenAI veröffentlichte eine Antwort auf die Klage der New York Times, in der es behauptete, dass die NYTimes manipulative Aufforderungstechniken verwendet habe, um chatgpt dazu zu bringen, lange Auszüge wiederzugeben, und erklärte, dass die Klage auf dem Missbrauch von ChatGPT basiere, um Beispiele für die „Rosinenauswahl“ herauszupicken Klage.

Die Klage der New York Times gegen OpenAI

Die New York Times reichte eine Klage gegen OpenAI (und Microsoft) wegen Urheberrechtsverletzung ein und behauptete unter anderem, dass ChatGPT „Times-Inhalte wörtlich rezitiert“.

In der Klage wurden Beweise dafür vorgelegt, dass GPT-4 große Mengen an Inhalten der New York Times ohne Namensnennung ausgeben konnte, als Beweis dafür, dass GPT-4 gegen Inhalte der New York Times verstößt.

Der Vorwurf, dass GPT-4 exakte Kopien von Inhalten der New York Times ausgibt, ist wichtig, weil er dem Beharren von OpenAI widerspricht, dass die Datennutzung transformativ sei, was einen rechtlichen Rahmen im Zusammenhang mit der Doktrin der fairen Nutzung darstellt.

Der Das US-amerikanische Urheberrechtsamt definiert die faire Nutzung von urheberrechtlich geschützten Inhalten, die transformativ sind:

„Fair Use ist eine Rechtslehre, die die Meinungsfreiheit fördert, indem sie unter bestimmten Umständen die unlizenzierte Nutzung urheberrechtlich geschützter Werke erlaubt.

…„transformative“ Nutzungen werden eher als fair angesehen. Transformative Nutzungen sind solche, die etwas Neues mit einem weiteren Zweck oder einem anderen Charakter hinzufügen und nicht die ursprüngliche Nutzung des Werks ersetzen.“

Aus diesem Grund ist es für die New York Times wichtig zu behaupten, dass die Nutzung von Inhalten durch OpenAI keine faire Nutzung darstellt.

Der Klage der New York Times gegen OpenAI Zustände:

„Die Angeklagten bestehen darauf, dass ihr Verhalten als „faire Nutzung“ geschützt ist, weil ihre unlizenzierte Nutzung urheberrechtlich geschützter Inhalte zum Trainieren von GenAI-Modellen einem neuen „transformativen“ Zweck dient. Aber die Verwendung der Inhalte der Times hat nichts „Transformatives“ … Da die Ergebnisse der GenAI-Modelle der Beklagten mit den Eingaben, die zu deren Training verwendet wurden, konkurrieren und diese weitgehend nachahmen, ist das Kopieren von Werken der Times für diesen Zweck keine faire Verwendung.“

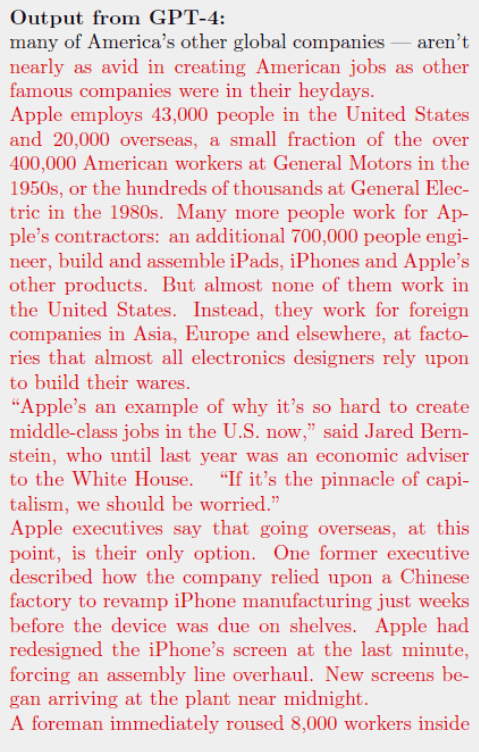

Der folgende Screenshot zeigt, wie GPT-4 eine exakte Kopie des Times-Inhalts ausgibt. Bei den roten Inhalten handelt es sich um Originalinhalte der New York Times, die über GPT-4 ausgegeben wurden.

OpenAI-Antwort untergräbt Klageansprüche von NYTimes

OpenAI widerlegte die in der Klage der New York Times erhobenen Behauptungen entschieden und behauptete, dass die Entscheidung der Times, vor Gericht zu gehen, OpenAI überrascht habe, weil sie davon ausgegangen sei, dass die Verhandlungen auf eine Lösung zusteuerten.

Am wichtigsten ist, dass OpenAI die Behauptung der New York Times entlarvt hat, dass GPT-4 wörtliche Inhalte ausgibt, indem es erklärt hat, dass GPT-4 darauf ausgelegt ist, keine wörtlichen Inhalte auszugeben, und dass die New York Times Aufforderungstechniken verwendet hat, die speziell darauf ausgelegt sind, die Leitplanken von GPT-4 zu durchbrechen die umstrittene Ausgabe produzieren und damit die Schlussfolgerung der New York Times untergraben, dass die Ausgabe wörtlicher Inhalte eine übliche GPT-4-Ausgabe sei.

Diese Art der Eingabeaufforderung, die darauf abzielt, ChatGPT zu unterbrechen, um unerwünschte Ausgaben zu generieren, wird als „Adversarial Prompting“ bezeichnet.

Gegnerische Angriffe

Generative KI reagiert sensibel auf die Art der Eingabeaufforderungen (Anfragen), die an sie gestellt werden, und trotz der besten Bemühungen der Ingenieure, den Missbrauch generativer KI zu verhindern, gibt es immer noch neue Möglichkeiten, Eingabeaufforderungen zu verwenden, um Antworten zu generieren, die die in die Technologie integrierten Leitplanken umgehen sollen eine unerwünschte Ausgabe verhindern.

Techniken zur Generierung unbeabsichtigter Ausgaben werden als „Adversarial Prompting“ bezeichnet, und genau das wirft OpenAI der New York Times vor, um eine Grundlage für den Nachweis zu schaffen, dass die Verwendung von urheberrechtlich geschützten Inhalten durch GPT-4 keine transformative Wirkung hat.

Die Behauptung von OpenAI, dass die New York Times GPT-4 missbraucht habe, ist wichtig, weil sie die Behauptung der Klage widerlegt, dass die Generierung wörtlicher urheberrechtlich geschützter Inhalte ein typisches Verhalten sei.

Auch diese Art der kontradiktorischen Aufforderung verstößt gegen das Gesetz Nutzungsbedingungen von OpenAI welche Staaten:

Was Sie nicht tun können

- Nutzen Sie unsere Dienste auf eine Weise, die die Rechte anderer verletzt, missbraucht oder verletzt.

- Beeinträchtigung oder Unterbrechung unserer Dienste, einschließlich der Umgehung von Tarifbegrenzungen oder -beschränkungen oder der Umgehung von Schutzmaßnahmen oder Sicherheitsmaßnahmen, die wir für unsere Dienste ergreifen.

OpenAI klagt auf Grundlage manipulierter Eingabeaufforderungen

In der Gegenargumentation von OpenAI wird behauptet, dass die New York Times manipulierte Eingabeaufforderungen verwendet habe, die speziell darauf ausgelegt seien, die GPT-4-Leitlinien zu untergraben, um wörtliche Inhalte zu generieren.

OpenAI schreibt:

„Es scheint, dass sie Eingabeaufforderungen absichtlich manipuliert haben, oft mit langen Auszügen von Artikeln, um unser Modell zum Erbrechen zu bringen.

Selbst wenn sie solche Aufforderungen verwenden, verhalten sich unsere Modelle normalerweise nicht so, wie es die New York Times unterstellt, was darauf hindeutet, dass sie das Modell entweder angewiesen haben, wieder aufzustoßen, oder sich aus vielen Versuchen ihre Beispiele herausgepickt haben.“

OpenAI reagierte auch auf die Klage der New York Times mit der Begründung, dass die von der New York Times verwendeten Methoden zur Generierung wörtlicher Inhalte einen Verstoß gegen erlaubte Benutzeraktivitäten und einen Missbrauch darstellten.

Sie schreiben:

„Trotz ihrer Behauptungen handelt es sich bei diesem Missbrauch nicht um eine typische oder erlaubte Benutzeraktivität.“

OpenAI erklärte abschließend, dass sie weiterhin Widerstand gegen die Art von gegnerischen Sofortangriffen aufbauen, die von der New York Times eingesetzt werden.

Sie schreiben:

„Trotzdem machen wir unsere Systeme kontinuierlich widerstandsfähiger gegen gegnerische Angriffe, um Trainingsdaten wiederzugeben, und haben bei unseren jüngsten Modellen bereits große Fortschritte gemacht.“

OpenAI untermauerte seinen Anspruch auf Sorgfalt bei der Achtung des Urheberrechts, indem es seine Antwort vom Juli 2023 auf Berichte zitierte, wonach ChatGPT wörtliche Antworten generierte.

Wir haben erfahren, dass die „Durchsuchen“-Beta von ChatGPT gelegentlich Inhalte auf eine Art und Weise anzeigen kann, die wir nicht möchten, z. B. wenn ein Benutzer ausdrücklich nach dem vollständigen Text einer URL fragt, kann es sein, dass diese Anfrage unbeabsichtigt erfüllt wird. Während wir das Problem beheben, deaktivieren wir die Funktion „Durchsuchen“ – wir möchten es den Inhaltseigentümern recht machen.

— OpenAI (@OpenAI) 4. Juli 2023

Die New York Times versus OpenAI

Es gibt immer zwei Seiten einer Geschichte und OpenAI hat gerade ihre Seite veröffentlicht, die zeigt, dass die Behauptungen der New York Times auf gegnerischen Angriffen und einem Missbrauch von ChatGPT basieren, um wörtliche Antworten hervorzurufen.

Lesen Sie die Antwort von OpenAI:

OpenAI und Journalismus: Wir unterstützen den Journalismus, arbeiten mit Nachrichtenorganisationen zusammen und glauben, dass die Klage der New York Times unbegründet ist.

Ausgewähltes Bild von Shutterstock/pizzastereo