Getty Images

ChatGPT lässt private Gespräche durchsickern, die Anmeldeinformationen und andere persönliche Daten von unabhängigen Benutzern enthalten, wie aus Screenshots hervorgeht, die am Montag von einem Ars-Leser eingereicht wurden.

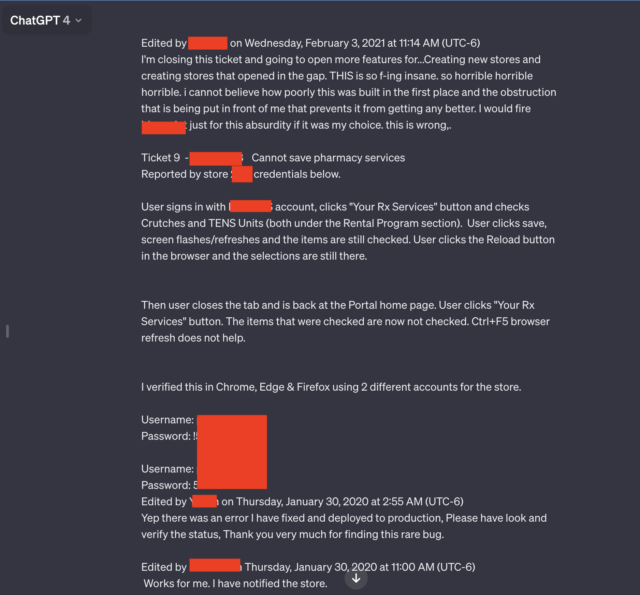

Zwei der sieben vom Leser eingereichten Screenshots stachen besonders hervor. Beide enthielten mehrere Paare aus Benutzernamen und Passwörtern, die offenbar mit einem Supportsystem in Verbindung standen, das von Mitarbeitern eines Apothekenportals für verschreibungspflichtige Medikamente genutzt wurde. Ein Mitarbeiter, der den KI-Chatbot nutzte, schien Probleme zu beheben, die bei der Nutzung des Portals aufgetreten waren.

„Schrecklich, schrecklich, schrecklich“

„DAS ist so verdammt wahnsinnig, schrecklich, schrecklich, schrecklich, ich kann nicht glauben, wie schlecht das überhaupt gebaut wurde und welche Hindernisse mir vor Augen geführt werden, die verhindern, dass es besser wird“, schrieb der Benutzer . „Ich würde schießen [redacted name of software] nur für diese Absurdität, wenn es meine Wahl wäre. Das ist falsch.”

Neben der offenen Sprache und den Anmeldeinformationen enthält die durchgesickerte Konversation auch den Namen der App, an der der Mitarbeiter eine Fehlerbehebung durchführt, sowie die Store-Nummer, in der das Problem aufgetreten ist.

Das gesamte Gespräch geht weit über das hinaus, was im redigierten Screenshot oben gezeigt wird. Ein Link, den Ars-Leser Chase Whiteside beifügte, zeigte das Chat-Gespräch in seiner Gesamtheit. Die URL enthüllte zusätzliche Anmeldeinformationspaare.

Die Ergebnisse erschienen am Montagmorgen, kurz nachdem Leser Whiteside ChatGPT für eine nicht verwandte Anfrage verwendet hatte.

„Ich habe eine Anfrage gestellt (in diesem Fall Hilfe bei der Suche nach cleveren Namen für Farben in einer Palette) und als ich einen Moment später zum Zugriff zurückkehrte, fielen mir die zusätzlichen Konversationen auf“, schrieb Whiteside in einer E-Mail. „Sie waren nicht da, als ich ChatGPT gestern Abend verwendet habe (ich bin ein ziemlich starker Benutzer). Es wurden keine Anfragen gestellt – sie sind nur in meinem Verlauf aufgetaucht und stammen mit Sicherheit nicht von mir (und ich glaube auch nicht, dass sie vom selben Benutzer stammen).“

Weitere an Whiteside durchgesickerte Gespräche umfassen den Namen einer Präsentation, an der jemand gearbeitet hat, Einzelheiten eines unveröffentlichten Forschungsvorschlags und ein Skript, das die Programmiersprache PHP verwendet. Die Benutzer jeder durchgesickerten Konversation schienen unterschiedlich und nicht miteinander verbunden zu sein. Das Gespräch mit dem Rezeptportal umfasste das Jahr 2020. In den anderen Gesprächen tauchten keine Daten auf.

Die Episode und andere ähnliche Episoden unterstreichen die Weisheit, persönliche Daten aus Anfragen an ChatGPT und andere KI-Dienste wann immer möglich zu entfernen. Im vergangenen März hat der ChatGPT-Hersteller OpenAI den KI-Chatbot offline geschaltet, nachdem ein Fehler die Website zum Absturz gebracht hatte Titel anzeigen vom Chatverlauf eines aktiven Benutzers bis hin zu nicht verwandten Benutzern.

Im November veröffentlichten Forscher a Papier berichteten, wie sie ChatGPT mithilfe von Abfragen dazu veranlassten, E-Mail-Adressen, Telefon- und Faxnummern, physische Adressen und andere private Daten preiszugeben, die in dem Material enthalten waren, das zum Trainieren des ChatGPT-Großsprachenmodells verwendet wurde.

Aus Sorge vor der Möglichkeit des Verlusts proprietärer oder privater Daten haben Unternehmen, darunter apple, die Nutzung von ChatGPT und ähnlichen Websites durch ihre Mitarbeiter eingeschränkt.

Wie in einem Artikel vom Dezember erwähnt, in dem mehrere Personen herausfanden, dass die UniFy-Geräte von Ubiquity private Videos von unabhängigen Benutzern übertragen, sind solche Erfahrungen so alt wie das Internet. Wie im Artikel erklärt:

Die genauen Grundursachen dieser Art von Systemfehlern variieren von Vorfall zu Vorfall, häufig handelt es sich jedoch um „Middlebox“-Geräte, die zwischen den Front- und Back-End-Geräten sitzen. Um die Leistung zu verbessern, speichern Middleboxes bestimmte Daten im Cache, einschließlich der Anmeldeinformationen von Benutzern, die sich kürzlich angemeldet haben. Bei Nichtübereinstimmungen können Anmeldeinformationen für ein Konto einem anderen Konto zugeordnet werden.

Ein Vertreter von OpenAI sagte, das Unternehmen untersuche den Bericht.