Hallo allerseits,

Frohes Neues Jahr. Hier ist Sisi.

Im Jahr 2023 begannen viele Unternehmen mit der Einstellung eines KI-Prompt-Ingenieurs. Die Fähigkeit des „Prompt Engineering“ besteht im Wesentlichen darin, wie gut jemand Anweisungen für große Sprachmodelle (LLMs) wie chatgpt schreiben kann, um die nützlichsten Ergebnisse zu erzielen.

Es gibt jetzt google.com/search?q=how+to+write+the+best+prompts+for+a“ target=“_blank“>Berge von Führern darüber, wie man die besten Eingabeaufforderungen online schreibt, und ein häufig verwendeter Vorschlag ist, dass Benutzer dem LLM eine Rolle zuweisen sollten – zum Beispiel „Sie sind ein umsichtiger Manager“ oder „Sie sind ein erfahrener Spendensammler“ –, bevor sie dem LLM Anweisungen geben, wozu machen.

Hallo Welt

Der Very Hungry-Algorithmus: Schlafenszeit mit ChatGPT

Enthusiasmus und Angst im Zeitalter der KI in Einklang bringen

Aber die Idee, dass LLMs eine Rolle übernehmen, wirft auch einige wirklich interessante Fragen auf. Wie interpretieren diese Modelle es, ein „Arzt“, ein „Elternteil“ oder sogar eine „psychologische Profilierungs-KI“ zu sein?

Ein Team der University of Michigan kürzlich hat einen Aufsatz veröffentlicht Dabei wurde systematisch untersucht, wie effektiv es sein kann, LLMs eine Rolle zuzuweisen, und wie sich die von Ihnen zugewiesene Rolle auf die Genauigkeit der Antworten auswirken kann, die Sie erhalten. Ihre Ergebnisse hielten einige sehr interessante Überraschungen bereit. Sie fanden beispielsweise heraus, dass die Zuweisung einer Rolle für LLMs sollen Mehr Erfahrung in einem Fachgebiet führt nicht zu genaueren Antworten.

Doch zusätzlich zu den beruflichen Berufen („Banker“) analysierten sie auch sechs weitere Rollentypen, darunter Rollen im Zusammenhang mit persönlichen Beziehungen: Familie („Tochter“), Schule („Lehrer“), Romantiker („Ehefrau“). , Arbeit („Chef“), Soziales („Kumpel“) und Arten von KI („Medizinische Diagnose-KI“). Anschließend testeten sie die Richtigkeit dieser Rollen, indem sie den LLMs eine Multiple-Choice-Frage stellten.

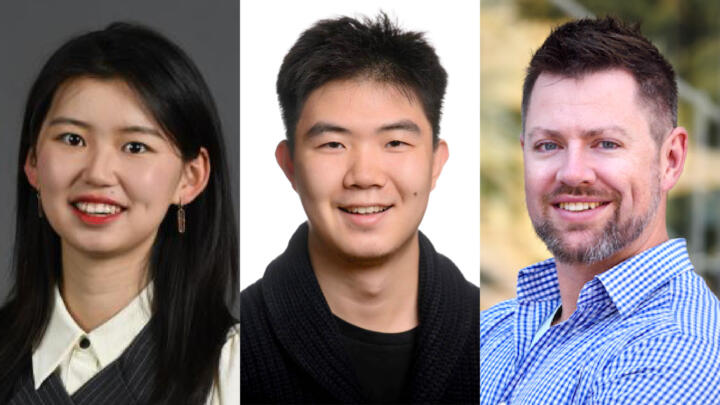

Was haben sie also gefunden? Hier ist meine Frage-und-Antwort-Runde mit dem Team der University of Michigan – Forschungsassistent Mingqian ZhengDoktorand Jiaxin PeiUnd David Jürgensaußerordentlicher Professor an der School of Information und der Fakultät für Informatik und Ingenieurwesen – über ihre Arbeit mit Mitarbeitern von LG AI, Moontae Lee Und Lajanugen Logeswaran.

Unser Interview wurde aus Gründen der Kürze und Klarheit bearbeitet.

Sisi: Was hat Sie dazu bewogen, zu erforschen, wie effektiv es wäre, LLMs zwischenmenschliche Rollen wie Mutter, Ehemann oder beste Freundin zuzuweisen?

David: Früher brauchte man spezielle Computerkenntnisse, um mit fortgeschrittener KI zu arbeiten, aber jetzt können sich die Leute einfach unterhalten. LLMs wie ChatGPT sind darauf trainiert, im Gespräch und aus der Perspektive unterschiedlicher Einstellungen, Fähigkeitsniveaus oder sogar Menschen zu reagieren. LLM-Designer nutzen diese Fähigkeit, um „Systemaufforderungen“ zu erstellen, die das LLM darauf vorbereiten, gute Antworten zu geben – wie z. B. „einen hilfreichen Assistenten“ – und dies kann einen Unterschied in der Leistung machen. Da die Leute Models bitten, es zu übernehmen Sozial Wir wollten sehen, welche Auswirkungen diese haben könnten und ob wir systematisches Verhalten finden können, um Modelle noch effektiver zu machen.

Jiaxin: Zuvor haben wir auch untersucht, wie sich unterschiedliche soziale Rollen auf die zwischenmenschliche Kommunikation zwischen Menschen auswirken. Daher begannen wir natürlich darüber nachzudenken, ob sich das Auffordern mit unterschiedlichen sozialen Rollen auf das Verhalten der Modelle auswirken würde. Da die Systemaufforderungen in fast allen kommerziellen KI-Systemen verwendet werden, könnte dies grundsätzlich Auswirkungen auf die Erfahrung jedes Einzelnen bei der Interaktion mit KI wie ChatGPT haben.

Sisi: Sie haben herausgefunden, dass LLMs schlechtere Antworten gaben, wenn man sie aufforderte, eine weibliche Rolle wie „Mutter“ einzunehmen, als wenn man ihnen „Vater“ oder „Elternteil“ zuordnete. Ich weiß, dass diese Studie den genauen Grund nicht herausfinden konnte, aber können Sie uns einige Beispiele für die geschlechtsspezifischen Rollen nennen, die Sie getestet haben, und was Sie dabei herausgefunden haben?

Unsere Experimente zeigten, dass es keinen Vorteil hatte, eine Rolle aus dem Themenbereich der Frage auszuwählen.

David Jürgens

Jiaxin: Wir haben versucht, ein ausgewogenes Setting zu schaffen, in dem wir die Rolle kontrollieren, aber das Geschlecht ändern. Im Partnersetting gibt es beispielsweise männliche Rollen (z. B. Freund, Ehemann), weibliche Rollen (z. B. Freundin, Ehefrau) und neutrale Rollen (Partner, Lebensgefährte). Es war überraschend, dass die Aufforderung mit geschlechtsneutralen Rollen zu besseren Ergebnissen führte als mit männlichen und weiblichen Rollen.

David: Es gab einen leichten Leistungsrückgang bei Rollen, die mit Frauen im Vergleich zu Männern in Verbindung gebracht wurden, aber der Unterschied war gering genug, dass er auf Zufall zurückzuführen sein könnte. Allerdings gab es eine viel größerer Unterschied zwischen geschlechtsneutralen Rollen (Eltern) und geschlechtsspezifischen Rollen (Mutter, Vater).

Sisi: Du hast auch getestet, was passiert, wenn wir LLMs bitten, eine professionelle Rolle zu übernehmen. Wenn Sie beispielsweise einem LLM die Rolle „Arzt“ zuweisen, erhalten Sie wahrscheinlich bessere Antworten als „Ihr Arzt“. Was ist Ihrer Meinung nach die Ursache dafür?

Jiaxin: Das ist eine tolle Frage! Ehrlich gesagt weiß ich es nicht. Es gibt so viele Dinge, die wir über LLMs immer noch nicht wissen. Eine Vermutung ist, dass „a“ in LLM-Trainingsdaten normalerweise häufiger vorkommt als „Ihr“, sodass Sätze mit „a“ möglicherweise mehr Daten haben, aus denen man schöpfen kann.

David: Wir wissen es wirklich nicht genau, aber wenn ich raten müsste, denke ich, dass die Situation, in der das Model gebeten wird, „sich vorzustellen, mit Ihrem Arzt zu sprechen“, einen größeren sozialen Kontext hervorrufen wird, der die Beantwortung einer Frage komplizierter macht. Das Szenario, in dem ein Model gebeten wird, sich vorzustellen, Sie seien ein Arzt, ist (zumindest sozial) viel einfacher, sodass ein Model weniger Kontext überdenken muss, um eine Antwort zu generieren.

Sisi: Bei Ihren Experimenten sieht es so aus, als ob die Aufforderung an LLMs, Rollenspiele mit jemandem zu machen, der Ingenieurwesen oder Informatik studiert, immer wieder zu schlechteren Antworten geführt hat – was ein wenig kontraintuitiv und ironisch wirkt. Was halten Sie davon?

Jiaxin: Es ist auch für uns sehr überraschend. Bevor wir das Experiment durchführten, gingen wir davon aus, dass es einen Domänenwissenseffekt geben würde. „Ingenieure“ sollten beispielsweise technische Fragen besser beantworten als andere Rollentypen. Basierend auf unserem Ergebnis schien es jedoch nicht wahr zu sein. Es gibt so viele mögliche Gründe dafür. Wir brauchen mehr Forschung, um wirklich zu verstehen, wie LLMs in verschiedenen Situationen funktionieren. Eine weitere Erkenntnis ist, dass LLMs zwar in der Lage sind, verschiedene Aufgaben auszuführen und in vielen Situationen wie Menschen zu kommunizieren, sich aber dennoch von Natur aus stark vom Menschen unterscheiden.

David: Unsere Experimente haben gezeigt, dass die Auswahl einer Rolle aus dem Themenbereich der Frage keinen Vorteil bringt. Manchmal waren diese Rollen richtig, manchmal falsch, aber statistisch gesehen gab es zwischen ihnen keinen großen Unterschied. Wir dachten, wir könnten vielleicht sogar versuchen, die richtige Rolle für eine Frage vorherzusagen – zum Beispiel, dass diese Frage vielleicht am besten von einem Koch, einer Krankenschwester oder einem Anwalt beantwortet werden würde –, aber auch das hat nicht funktioniert!

Mingqian: Wir haben auch versucht herauszufinden, warum es in mehrfacher Hinsicht einen Unterschied gab (oder nicht), einschließlich der Ähnlichkeit zwischen der von uns gegebenen Eingabeaufforderung und der Frage, die wir dem Modell gestellt haben, des Ausmaßes der Vorhersageunsicherheit in den Modellen und der Häufigkeit der Rollen selbst tauchten in der Textdatensammlung von Google auf (ein Proxy zur Modellierung der Worthäufigkeit in Trainingsdaten). Aber diese Faktoren konnten das Ergebnis nicht vollständig erklären.

Wenn Sie weitere Beispiele für Rollen sehen möchten, die Jiaxin, Mingqian und David getestet haben, Werfen Sie einen Blick auf Seite zwei ihres Artikels. Sie können sehen, wie unter anderem Rollen wie „Sheriff“, „Gärtner“ und „Enthusiast“ in ihren Tests abgeschnitten haben.

🌱 Diesen Monat veröffentlichen wir außerdem jeden Wochentag einen Datenschutztipp von einem Markup-Mitarbeiter, der diesen Rat tatsächlich in seinem eigenen Leben befolgt. Wenn Sie schon immer mehr von Ihrer Privatsphäre schützen wollten, sich aber von all den Informationen überwältigt gefühlt haben, schauen Sie sich unsere Serie an. Wir nennen es „Sanfter Januar“: Die am wenigsten einschüchternden Datenschutztipps von The Markup.

Ich weiß auch, dass Sie, liebe Hello World-Leser, wahrscheinlich Ihre eigenen Datenschutztipps für uns und füreinander haben. Wir freuen uns über Ihren Rat. Wenn Sie eine Minute Zeit haben, senden Sie uns Ihre Antwort auf diese Frage: Was ist ein praktischer Ratschlag zum Schutz Ihrer Privatsphäre, den Sie tatsächlich selbst geben? Sie können uns Ihre Antwort zusammen mit der Angabe, wie Sie identifiziert werden möchten, per E-Mail an [email protected] senden. Wir werden einige Ihrer Tipps in der letzten Woche des Gentle January hervorheben.

Vielen Dank fürs Lesen und ich hoffe, dass Ihr Januar angenehm verläuft.

Aufrichtig,

Sisi Wei Chefredakteur Das Markup