Wir wissen, dass apple im KI-Rennen ist. Das Unternehmen wäre sogar bereit, mit google zusammenzuarbeiten und Gemini in seine iPhones zu integrieren. Mittlerweile werden auch eigene Modelle der künstlichen Intelligenz entwickelt, etwa die MM1-Modellreihe.

Während Apple mit der bevorstehenden Einführung von iOS 18 die Zeit davonläuft, könnte das Unternehmen Google bitten, Gemini in seine iPhones zu integrieren. Gleichzeitig wird an eigenen Modellen der künstlichen Intelligenz gearbeitet. Dies ist bei MM1 der Fall Forschungsergebnisse wurden veröffentlicht. Genug, um mehr über die Philosophie der KI im Apple-Stil und die mögliche Integration der Technologie in die Produkte der Marke zu erfahren.

Apples KI will mit Googles Gemini konkurrieren

Dies wird voll und ganz von Brandon McKinzie, LLM-Spezialist bei Apple, der an der Forschung rund um MM1 beteiligt war, unterstützt. Laut ihm (über X) ist die Modellreihe unabhängig von der Größe der Modelle genauso effizient wie die erste Version von Gemini. Er erklärt, dass die 30-Milliarden-Parameter-Version von MM1 (die fortschrittlichste) andere Modelle übertrifft.

Um zu verstehen, wie multimodale Modelle (die mehrere Arten von Eingaben gleichzeitig verarbeiten können, wie Text, Bilder oder Ton), führten Forscher Ablationen durch, d. h. Entfernungen bestimmter Komponenten von KI-Systemen, um zu verstehen, was diese Komponenten zum Ergebnis bringen System im Allgemeinen.

Außerdem lerne ich, Modelle zu bauen. Apple-Teams berichten, dass sie kleine Experimente durchgeführt haben, um den Einfluss bestimmter Faktoren auf die Leistung zu untersuchen. Wie angegeben Lieblingslehrerwir erfahren, dass „Faktoren wie Bildauflösung und visuelle Encoderkapazität sind entscheidend, während die Methode zur Einführung visueller Daten in das Modell weniger Einfluss hat.»

Wofür würde dieses von Apple erstellte KI-Modell verwendet werden?

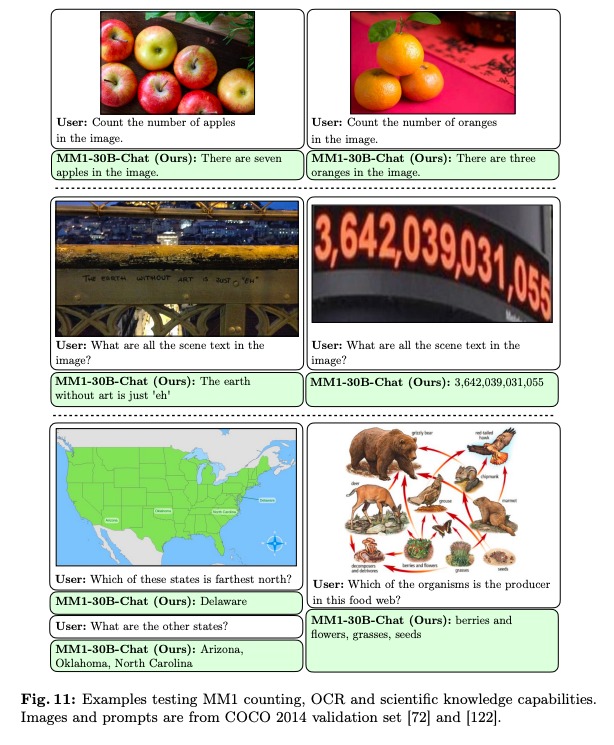

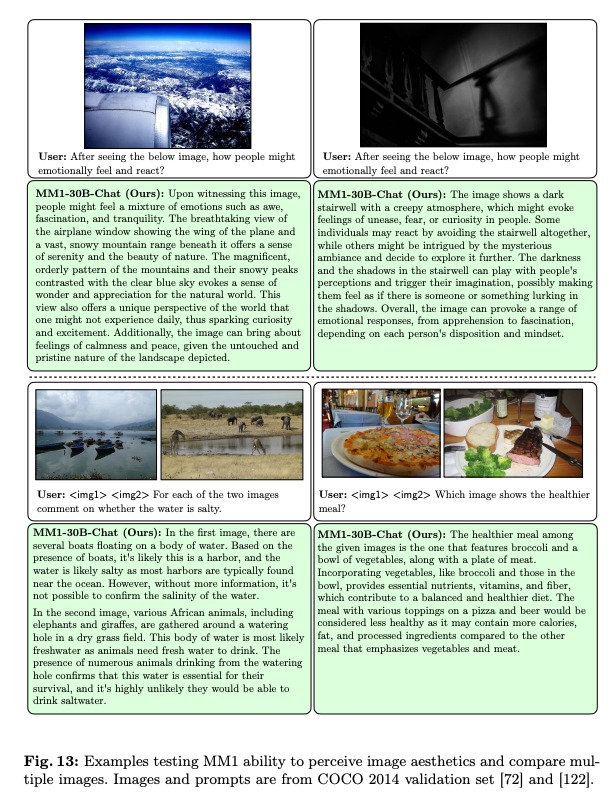

Zu den Schlussfolgerungen der Forscher gehört auch die Tatsache, dass „MM1 profitiert von attraktiven Eigenschaften wie verbessertem kontextbezogenem Lernen und Multi-Frame-Argumentation, wodurch es möglich ist, Gedankenketten mit nur wenigen Klicks zu starten.» Wir können lesen, dass MM1 es schafft, sehr genaue Beschreibungen von Bildern zu verfassen, dass er Fragen beantworten kann, die ihm zu Bildern gestellt werden. Dazu gehören sogar Vorstellungen, die sehr schwer zu verstehen sind.erfassen» für KI, wie Emotionen.

Zu den Einsatzmöglichkeiten, die wir uns vorstellen können, gehört die Generierung alternativer Bild-Tags. Ein solches auf iPhones implementiertes System würde es ermöglichen, Bildbeschreibungen automatisch zu verfassen. Genug, um sehbehinderten Menschen zu helfen, zu verstehen, was auf ihren Geräten angezeigt wird. Wie besprochen können wir uns auch eine Echtzeittranskription dessen vorstellen, was das iphone sieht oder hört Korben.

Es ist nicht klar, welche Pläne Apple für die Integration von KI in iPhones und Macs hat. Es gibt natürlich Gerüchte über eine komplette Überarbeitung von Siri, dem Sprachassistenten im chatgpt-Stil. Brandon McKinzie sagte, sein Team arbeite bereits an einer nächsten Modellgeneration.