Große Modelle, die durch GPT-4 repräsentiert werden, haben Gehirne gebaut, und der nächste Schritt besteht darin, einen Roboterkörper zu benötigen, der dieses Gehirn tragen kann.

Letzte Nacht veröffentlichte das Starunternehmen Figure AI für humanoide Roboter überraschenderweise ein Video, das eine Reihe von Gesprächsinteraktionen zeigt, die ihr Roboter Figure 01 mit Unterstützung des leistungsstarken Modells von OpenAI durchführt.

Der Roboter im Video zeigt flexible Bedienreaktionen und seine Kommunikationsfähigkeiten mit Menschen sind fast mit denen echter Menschen vergleichbar.

Dies ist weniger als einen halben Monat, nachdem Figure AI Investitionen von OpenAI, Microsoft, Nvidia und anderen Unternehmen erhalten hat. Dadurch konnte ich auch sehen, wie das leistungsstärkste multimodale große Modell von OpenAI mit einem Körper aussehen würde.

Abbildung 01, der humanoide Roboter, der Sie am besten versteht?

Dank der leistungsstarken Unterstützung des multimodalen Großmodells von OpenAI steht Figure 01 nun als Experte für Objekterkennung auf dem Tisch. Äpfel, Abtropfflächen, Tassen und Teller sind damit ein Kinderspiel!

Wenn Sie hungrig sind und möchten, dass es einen ganzen Bissen frisst, wird es Ihre Gedanken sofort verstehen und Ihnen reibungslos einen Apfel reichen.

Darüber hinaus kann es sogar den weggeworfenen Müll einsammeln und Ihnen erklären, warum es Ihnen gerade den Apfel geschenkt hat. Mithilfe großer Modelle kann Abbildung 01 das einzige Lebensmittel auf dem Tisch verstehen – Äpfel.

Auf Befehl eines Menschen kann Figur 01 auch die Hausarbeit erledigen und das Geschirr abräumen. Dieser Roboter ist einfach der beste Partner im Familienleben.

Nachdem sie dieses atemberaubende Video gesehen hatten, reagierten die Internetnutzer unterschiedlich.

Internetnutzer können es kaum erwarten, Abbildung 01 Aufgaben zuzuweisen. Wie kommt es, dass Filme über Roboter-Vorgänger in die Aufgabenliste eingemischt sind?

Haben die Konkurrenten Angst davor, dies zu sehen, sind sie in ihrem Herzen besorgt und bereiten sie sich heimlich auf einen großen technischen Wettbewerb vor?

Begeisterte Internetnutzer sagten, dass der Beginn von AGI unmittelbar bevorstehe.

Natürlich gibt es immer auch kritische Stimmen. Einige Internetnutzer beschwerten sich, warum stammelt dieser Roboter?

Auch die Internetnutzer ließen es sich nicht nehmen, Witze zu machen.

Brett Adock, der Leiter von Figure AI, wollte nicht allein sein und sprang auf X zurück, um eine wunderbare Interpretation zu liefern.

Das Video demonstriert die Anwendung von End-to-End-Neuronalen Netzen. Bei diesem Vorgang wird keine Fernbedienung (Teleop) verwendet. Das Video wird mit der tatsächlichen Geschwindigkeit (1,0-fache Geschwindigkeit) aufgenommen und ist kontinuierlich.

Wie Sie im Video sehen können, hat sich die Geschwindigkeit der Roboter deutlich verbessert und wir erreichen nach und nach Geschwindigkeiten, die denen von Menschen ähneln.

Keine Fernbedienung erforderlich, Autodidakt

Wie macht Abbildung 01 das?

Der Leiter des Figure AI-Teams, Corey Lynch, erklärte es auf X.

Insbesondere wurden alle im Video gezeigten Verhaltensweisen erlernt (nicht ferngesteuert) und mit realistischer Geschwindigkeit (1,0-fache Geschwindigkeit) ausgeführt.

Figure AI speist Bilder, die von der Kamera des Roboters aufgenommen wurden, und sprachtranskribierten Text, der über das integrierte Mikrofon aufgezeichnet wurde, in ein von OpenAI trainiertes multimodales Modell ein, das sowohl Bild- als auch Textinformationen verstehen kann.

Das Modell verarbeitet den gesamten Gesprächsverlauf, einschließlich früherer Bilder, um eine verbale Antwort zu generieren und per Text-to-Speech mit dem Menschen zu sprechen. Dasselbe Modell ist auch dafür verantwortlich, zu entscheiden, welches erlernte Closed-Loop-Verhalten als Reaktion auf einen bestimmten Befehl ausgeführt werden soll. Es lädt bestimmte neuronale Netzwerkgewichte auf die GPU und führt die entsprechende Richtlinie aus.

Die Verbindung von Abbildung 01 mit einem großen vorab trainierten multimodalen Modell bringt viele interessante neue Funktionen mit sich.

Abbildung 01 + OpenAI kann nun:

- Detaillieren Sie die Umgebung.

- Treffen Sie Entscheidungen mit gesundem Menschenverstand. Zum Beispiel: „Die Gegenstände auf dem Tisch, wie der Teller und die Tasse, werden höchstwahrscheinlich als nächstes auf den Wäscheständer gestellt.“

- Wandeln Sie vage allgemeine Anweisungen, wie zum Beispiel „Ich habe Hunger“, in situationsgerechtes Verhalten um, wie zum Beispiel „Gib dieser Person einen Apfel.“

- Erklären Sie in einfachem Englisch, warum eine bestimmte Aktion ausgeführt wird. Zum Beispiel: „Dies ist der einzige essbare Artikel, den ich vom Tisch anbieten kann.“

Wenn es um die feinen praktischen Fähigkeiten geht, die Abbildung 01 durch Lernen erlernt hat, stecken tatsächlich eine Reihe komplexer und subtiler Prinzipien dahinter.

Alle Verhaltensweisen werden durch die Vision-zu-Motor-Konvertierungsstrategie des neuronalen Netzwerks gesteuert, die Bildpixel direkt Aktionen zuordnet. Diese Netzwerke empfangen in den Roboter integrierte Bilder mit einer Rate von 10 Bildern pro Sekunde und erzeugen 200 Bewegungen mit 24 Freiheitsgraden (einschließlich Handgelenkshaltungen und Fingergelenkwinkel) 200 Mal pro Sekunde.

Diese Bewegungen dienen als Hochgeschwindigkeits-„Sollwerte“ für die Verfolgung durch schnellere Ganzkörpersteuerungen und gewährleisten so eine präzise Ausführung der Bewegungen.

Durch dieses Design wird eine effektive Trennung der Belange erreicht:

- Im Internet vorab trainierte Modelle führen vernünftige Überlegungen zu Bildern und Texten durch, um einen übergeordneten Plan zu erstellen.

- Die erlernte visuomotorische Strategie führt diesen Plan aus und führt schnelle, reaktive Verhaltensweisen aus, die manuell schwer zu spezifizieren sind, wie beispielsweise die Manipulation eines verformbaren Beutels in jeder Position.

- Gleichzeitig ist der Ganzkörpercontroller für die Sicherheit und Stabilität der Bewegungen verantwortlich, beispielsweise für die Aufrechterhaltung des Gleichgewichts des Roboters.

Bezüglich der großen Fortschritte, die Figure 01 gemacht hat, beklagte Corey Lynch:

Noch vor ein paar Jahren hätte ich gedacht, dass ein ausführliches Gespräch mit einem humanoiden Roboter, der in der Lage ist, erlernte Verhaltensweisen autonom zu planen und auszuführen, Jahrzehnte in der Zukunft liegen würde. Offensichtlich haben sich viele Dinge dramatisch verändert.

Könnte dies der GPT-Moment humanoider Roboter sein?

Man muss sagen, dass die Entwicklungsgeschwindigkeit von Abbildung 01 so ist, als würde man aufs Gaspedal treten und den ganzen Weg rasen.

Im Januar dieses Jahres beherrschte Abbildung 01 die Fähigkeit, Kaffee zuzubereiten. Dieser Erfolg war auf die Einführung eines durchgängigen neuronalen Netzwerks zurückzuführen, das es dem Roboter ermöglichte, mit nur 10 Stunden Training autonom zu lernen und Fehler zu korrigieren.

Einen Monat später hatte Abbildung 01 die neue Fähigkeit erlernt, Kisten anzuheben und auf ein Förderband zu liefern, allerdings nur mit 16,7 % der Geschwindigkeit von Menschen.

Während dieses Prozesses hat das Kommerzialisierungstempo von Figure AI nicht aufgehört. Das Unternehmen hat eine Handelsvereinbarung mit der BMW Manufacturing Company zur Integration von KI und Robotertechnologie in die Automobilproduktionslinie unterzeichnet und sich im BMW-Werk niedergelassen.

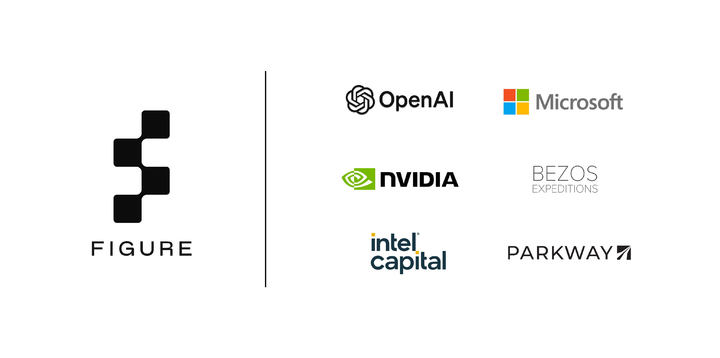

Dann, erst vor zwei Wochen, gab Figure den Abschluss einer Serie-B-Finanzierungsrunde in Höhe von 675 Millionen US-Dollar bekannt, wodurch die Unternehmensbewertung auf 2,6 Milliarden US-Dollar anstieg.

Investoren decken fast die Hälfte des Silicon Valley ab – Microsoft, OpenAI Venture Fund, NVIDIA, Jeff Bezos, Parkway Venture Capital, Intel Capital und Align Ventures usw.

Zu diesem Zeitpunkt gaben OpenAI und Figure außerdem bekannt, dass sie gemeinsam das KI-Modell für humanoide Roboter der nächsten Generation entwickeln werden. Das multimodale Modell von OpenAI wird auf die Wahrnehmung, das Denken und die Interaktion von Robotern ausgeweitet.

Aus Abbildung 01 scheinen wir nun einen Blick auf das zukünftige Leben werfen zu können.

Tatsächlich waren Roboter vor großen Modellen Spezialgeräte. Mit den allgemeinen Fähigkeiten großer Modelle tauchen nun allgemeine Roboter auf. Jetzt brauchen wir nicht nur chatgpt, sondern auch WorkGPT.

Diese Entwicklungen bestätigen indirekt einen klar erkennbaren Weg: Nachdem das große KI-Modell Wurzeln geschlagen hat, wird es schließlich in die reale Welt eintreten, und verkörperte Intelligenz ist der beste Weg.

Nvidia-Gründer Jensen Huang, der an vorderster Front der KI aktiv war, sagte einmal: „Verkörperte Intelligenz wird die nächste Welle der künstlichen Intelligenz anführen.“

Die Integration des großen OpenAI-Modells in Abbildung 01 ist ebenfalls ein bewusstes strategisches Layout.

Ausgereifte KI-Großmodelle fungieren als künstliche Gehirne, simulieren das komplexe neuronale Netzwerk des menschlichen Gehirns, realisieren kognitive Funktionen wie Sprachverständnis, visuelle Erkennung und Situationsschlussfolgern und lösen kognitive und Entscheidungsprobleme auf höherer Ebene für Roboter.

Gleichzeitig werden verschiedene Sensoren, Aktoren und Recheneinheiten in den Roboterkörper integriert, um die Wahrnehmung und Interaktion mit der Umgebung zu realisieren. Bildverarbeitungssysteme können beispielsweise Bilder und Videos erfassen und taktile Sensoren können die Form und Textur von Objekten erfassen.

Der Gründer von Figure AI, Brett Adcock, erklärte zuvor in einem Interview, dass sich Figure AI in den nächsten ein bis zwei Jahren auf die Entwicklung bahnbrechender Produkte konzentrieren wird und erwartet, die Forschungs- und Entwicklungsergebnisse humanoider Roboter in den nächsten ein bis zwei Jahren der Öffentlichkeit vorzuführen. Dabei geht es um KI-Systeme, Low-Level-Steuerung usw. und schließlich entsteht ein Roboter, der seine Talente im täglichen Leben unter Beweis stellen kann.

Er enthüllte auch, dass ein humanoider Roboter aus Kostengründen etwa 1.000 Teile hat und etwa 150 Pfund (68 kg) wiegt, während ein Elektroauto etwa 10.000 Teile haben und 4.000–5.000 Pfund (1.800–2.250 kg) wiegen kann. Daher wird erwartet, dass die Kosten für humanoide Roboter langfristig niedriger sein werden als die für billige Elektroautos, abhängig von den Kosten für Aktuatoren, Motorkomponenten, Sensoren und Rechenkosten.

Der Roboterexperte Eric Jang brachte einmal seine Erkenntnis zum Ausdruck: „Obwohl viele KI-Forscher glauben, dass es Jahrzehnte dauern wird, bis universelle Roboter populär werden, vergessen Sie nicht, dass ChatGPT fast über Nacht geboren wurde.“

Heute vor einem Jahr veröffentlichte OpenAI GPT-4 und bewies damit der Welt die Leistungsfähigkeit großer Modelle.

Heute, ein Jahr später, haben wir nicht auf GPT-5 gewartet, sondern auch Abbildung 01 begrüßt. Wird dies der GPT-4-Moment für humanoide Roboter sein?