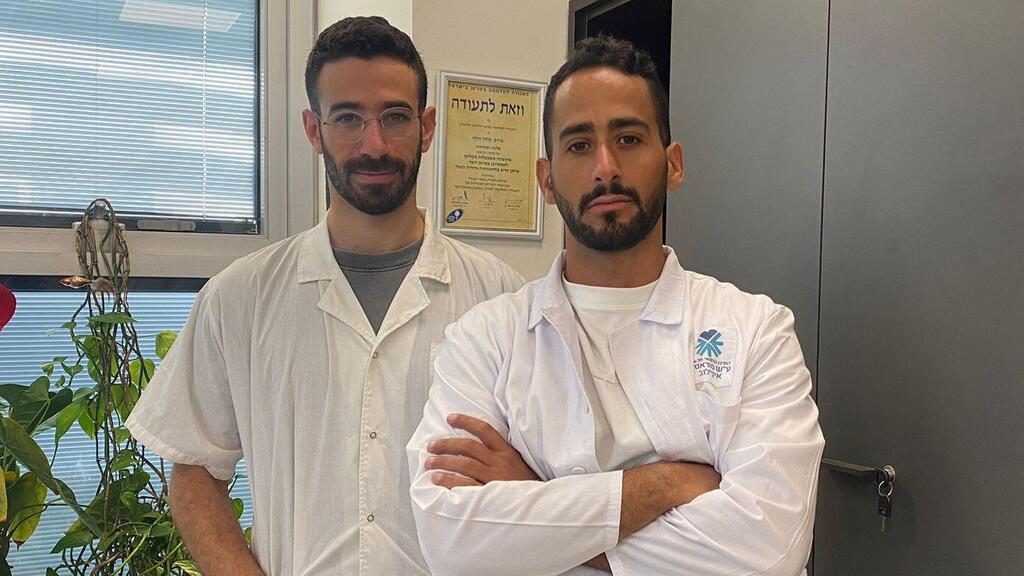

Die Studie wurde von Dr. Eran Cohen, einem Psychiatriespezialisten am Lev Hasharon Mental Health Center, zusammen mit Dr. Uriel Katz, einem Assistenzarzt am Wolfson Medical Center, in Zusammenarbeit mit Prof. Ido Wolf, dem Direktor der Onkologieabteilung des Ichilov Medical Center, durchgeführt , und die Israel Medical Association (IMA).

„Der Bereich der künstlichen Intelligenz hat uns schon immer fasziniert“, sagt Cohen. „Vor etwa einem Jahr wollten wir seine Fähigkeiten testen. Wir haben uns gefragt, wie wir seine Fähigkeiten in der Medizin testen können. Wir haben uns eine persönliche Initiative ausgedacht, um dies bei den Lizenzprüfungen für Assistenzärzte der Stufe A zu tun. Wir haben uns für die fünf entschieden.“ grundlegende medizinische Fachgebiete – Pädiatrie, Psychiatrie, allgemeine Chirurgie, Gynäkologie und Innere Medizin.“

Als die Ergebnisse eintrafen, waren die Ärzte überrascht, dass ChatGPT die Prüfungen erfolgreich bestanden hatte. „Wir erkannten, dass es die Prüfungen bestehen konnte, und nicht nur das, es bestand auch die Prüfungen. Es war erstaunlich für uns zu sehen“, sagte Cohen. „Uns wurde klar, dass wir etwas hatten, was die Welt wissen wollte, und wir wussten nicht wirklich, was wir damit anfangen sollten.“

Die beiden wandten sich dann an Wolf im Ichilov Medical Center. „Er ist bekannt für seinen Wunsch, neuen Bewohnern zu helfen und die wissenschaftliche Forschung voranzutreiben“, erklärte Cohen. „Er erklärte sich bereit, uns zu informieren und uns beim Aufbau des Themas zu helfen, bis wir eine veröffentlichte Arbeit hatten.“

Mit Wolfs Unterstützung wandten sich die beiden auch an die IMA, die Daten über israelische Einwohner bereitstellte, die im Jahr 2022 die Prüfungen zur medizinischen Zulassung ablegten. „Sie erklärten sich bereit, teilzunehmen und die Informationen mit uns zu teilen. Die meisten Länder der Welt tun dies nicht.“ Dr. Cohen fügte hinzu.

Im Rahmen der Studie verwendeten die Ärzte zwei verschiedene Versionen von ChatGPT – 3.5 und 4 – und stellten ihnen Lizenzprüfungsfragen zur Verfügung, die an Assistenzärzte in den von ihnen gewählten medizinischen Bereichen gestellt wurden. Jedes Modell absolvierte die Prüfung 120 Mal, um seine Fähigkeiten konsistent zu bewerten. Die erhaltenen Ergebnisse wurden dann mit den Ergebnissen von 849 Bewohnern verglichen, die dieselbe Prüfung abgelegt hatten.

„Jeder Datensatz war sehr interessant. Wir haben festgestellt, dass ChatGPT-4 die Prüfung nicht nur bestanden hat, sondern in einigen von ihnen sogar bessere Ergebnisse erzielt hat als die Bewohner“, so Cohen.

„Die Verbesserung zwischen den beiden Versionen zeigt den rasanten Sprung und das Tempo der KI-Entwicklung innerhalb eines Jahres. Das 3.5-Modell schnitt im Vergleich zum 4-Modell überhaupt nicht gut ab, es ist eine unglaubliche Leistungssteigerung“, fügte er hinzu.

Den Ergebnissen zufolge hat ChatGPT-4 die Prüfungen fast nie nicht bestanden, verglichen mit einer Durchfallquote von 25 % bei Assistenzärzten verschiedener Fachrichtungen. „Dies ist eine Prüfung, die den gesamten akademischen Stoff des Medizinstudiums abdeckt. Es ist eine Prüfung, die man lange und intensiv studiert. In einigen Gruppen gab es eine Durchfallquote von 30 %, was bedeutet, dass die Tatsache, dass ChatGPT nie durchgefallen ist, von Bedeutung ist.“

Im Gegensatz dazu waren die Durchschnittswerte zwischen ChatGPT und Bewohnern nahezu identisch, wobei das KI-Modell konsistent war und eine stabile Leistung zeigte, während die Werte der Bewohner zwischen 30 und 85 Punkten lagen. ChatGPT schnitt in den Bereichen Innere Medizin und Psychiatrie besser ab als die meisten Assistenzärzte.

Allerdings gelang es dem Modell nie, die Punktzahl des Bewohners mit der höchsten Punktzahl in der Prüfung zu übertreffen. „KI hat es noch nicht geschafft, mit denen mitzuhalten, die Profis auf ihrem Gebiet sind“, sagte Cohen.

Trotz der beeindruckenden Ergebnisse wird KI den Menschen in naher Zukunft wahrscheinlich nicht als Privatarzt ersetzen. „Wir sind wirklich gespannt, wie die Welt das sieht“, sagte Cohen und fügte hinzu: „Es sagt viel aus, aber es deutet nicht unbedingt auf etwas für die Zukunft hin. Unsere Studie soll eine Perspektive aufzeigen, wo das ist.“ Technologie steht.“

„Die Tatsache, dass KI Lizenzprüfungen erfolgreich bestehen kann, zeigt nur die Reife der Technologie und unterstreicht die Tatsache, dass wir lernen müssen, sie zu nutzen. Es ist uns besser gelungen, einen Einblick in unseren Stand zu geben“, fügte er hinzu und wies darauf hin, dass die einjährige Lücke zwischen den Modellen vielversprechend für die Zukunft der KI sei.

Doch welche Chancen könnten sich aus diesen Ergebnissen für die Zukunft ergeben? „Es könnte die Arbeit des Arztes bei der Suche und Verarbeitung von Informationen erheblich verkürzen. Es besteht die Notwendigkeit, die Synergie zwischen Ärzten und KI zu entwickeln, um medizinische Prozesse zu rationalisieren. Es gibt so viel Material und Bücher, aus denen man lernen kann. Das gesamte Feld wird immer größer. Wir.“ Wir müssen die Technologie irgendwie in die Ärzte integrieren, um in Zukunft eine bessere Gesundheitsversorgung zu ermöglichen.“

Angesichts der überraschenden Ergebnisse der Studie prüft die IMA unterdessen Möglichkeiten, die große Datenbank, über die sie verfügt, für zukünftige Studien zu nutzen. „Wir bereiten uns darauf vor, in naher Zukunft eine große und umfassende Studie zu diesem Thema durchzuführen“, sagte Professor Ron Eliashar, Vorsitzender des Prüfungsausschusses der IMA.

„Das Komitee verfügt über eine einzigartige Datenbank mit Prüfungen und Aufenthalten aus über 30 Jahren und es besteht ein enormes Potenzial, daraus relevante und nützliche Informationen zu extrahieren“, fügte er hinzu.