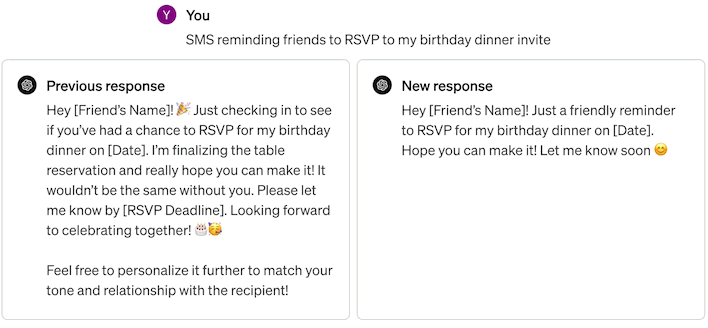

Im jüngsten Update, das keinen ausgefallenen Namen trägt, ist GPT4 Turbo laut OpenAI-Gründer Sam Altman nun „deutlich intelligenter und angenehmer zu bedienen“. Obwohl er nicht näher darauf eingegangen ist, scheint Altman in erster Linie über Änderungen am Modell zu sprechen, die dazu geführt haben, dass seine Reaktionen bei der Verwendung als Chatbot „direkter, weniger ausführlich und gesprächiger“ sind, wofür OpenAI das folgende Beispiel liefert nachweisen:

Bild: OpenAI

Das aktualisierte Modell schneidet auch bei den meisten gängigen KI-Benchmarks besser ab, einschließlich des google-Proof Q&A Benchmark für Hochschulabsolventen. Dieser herausfordernde Datensatz wurde entwickelt, um die Fähigkeiten von LLMs zu testen und umfasst einen Multiple-Choice-Test mit 448 Fragen, wobei die Fragen über alle wissenschaftlichen Bereiche verteilt sind. Die Fragen werden von Experten in den jeweiligen Fachgebieten entworfen, um nicht nur zu beurteilen, wie gut LLMs Fragen beantworten können, sondern auch, wie gut sie von Menschen überwacht werden können. Dieser Test ist der schwächste Benchmark von GPT-4 und die neue Version verbessert ihre Punktzahl in diesem Test von etwa 35 % auf knapp 50 %, was bei diesem schwierigen Benchmark ein hervorragendes Ergebnis darstellt.

Zu den anderen Benchmarks, bei denen Zuwächse zu verzeichnen sind, gehören der auf logisches Denken ausgerichtete MATH-Test, der Multilingual Grade School Math (MGSM)-Benchmark und der Discrete Reasoning Over Paragraphs (DROP)-Benchmark. Insbesondere DROP ist einer der anspruchsvollsten KI-Benchmarks, und GPT-4 Turbo war bereits eines der besten Modelle in diesem Test, aber die neue Version verbessert seine Punktzahl in diesem schwierigen Test auf etwas über 80 % und liegt damit im exklusive Kategorie von Modellen, um solche Höhen zu erreichen, die, äh, sich selbst einschließt. (Das nächstbeste Ergebnis stammt von Googles Gemini 1.5 Turbo mit 78,9 %.)

Neben dem neuen Modell, das den Wissensstand von GPT-4 auf April 2024 aktualisiert, stellt OpenAI auch fest, dass GPT-4 Turbo with Vision – das Modell, das Bildanalysefunktionen integriert – jetzt allgemein über seine API verfügbar ist. Vision-Anfragen können jetzt auch den JSON-Modus und Funktionsaufrufe verwenden, was sie wesentlich vielseitiger als zuvor macht. Im oben verlinkten Twitter-Thread haben Entwickler viele beeindruckende Beispiele für Apps gepostet, die mit dieser API erstellt wurden. Wenn Sie daran interessiert sind, anzufangen, gehen Sie zu Website von OpenAI und sehen Sie sich die Preise für API-Anfragen an den aktualisierten GPT-4 Turbo an.