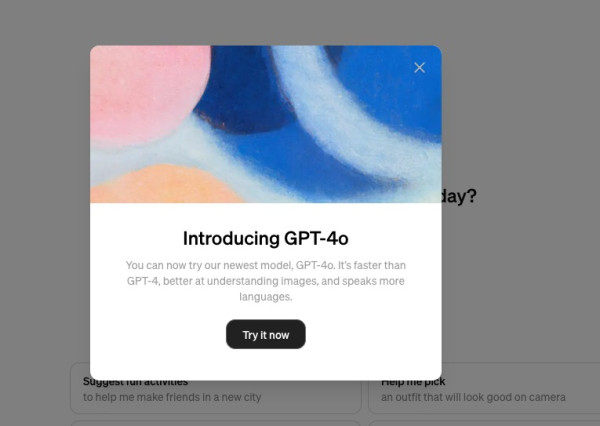

Wie verwende ich ChatGPT-4o? OpenAI veröffentlicht ChatGPT-4o! Das Gesamtgefühl ist, als würde man auf natürliche Weise mit einer echten Person kommunizieren und interagieren! Echtzeitübersetzung ohne Verzögerung, kann Antworten unterbrechen und sofortige Antworten erfordern, kann menschliche Emotionen und Feedbackvorschläge spüren, kann in Echtzeit mit 2 ChatGPT-4o kommunizieren, Bilder, einschließlich Text, Zahlen und Strichzeichnungen, vollständig verstehen, Menschen beibringen zählen…Stimme und menschliche Kommunikation umwandeln. Die Intelligenz und Emotionen der künstlichen Intelligenz werden weiter verbessert. Werfen Sie einen Blick auf die folgenden neuen Funktionen von ChatGPT-4o.

[Klicken Sie hier]um mit der App weitere Videos zur Produkt-Unboxing-Technologie anzusehen

Auf der OpenAI-Frühjahrskonferenz wurde ein neues Flaggschiff-KI-Modell – ChatGPT-4o – vorgestellt, wobei o für omnidirektionale Intelligenz steht. Diese neue Generation künstlicher Intelligenz demonstriert nicht nur beispiellosen technologischen Fortschritt, sondern zeichnet sich auch durch multimodale Interaktion und Sprachverständnis aus sind große Durchbrüche in der Ideenfindung, barrierefreien Kommunikation und individuellem Lernen. Das ChatGPT-4o-Modell von OpenAI hat gegenüber der bisherigen Basis erhebliche Verbesserungen und Innovationen vorgenommen und stellt nicht nur weitere technologische Durchbrüche dar, sondern ermöglicht auch den Komfort, die Genauigkeit, die Vielfalt und die Kreativität der künstlichen Intelligenz und der menschlichen Interaktion und personalisiertes Lernen.

Inhaltsverzeichnis

Welche Funktionen wurden in ChatGPT-4o verbessert?

Großer Fortschritt in der Sprachverarbeitung

GPT-4o verfügt über leistungsfähigere Fähigkeiten zum Sprachverständnis und zur Sprachgenerierung und kann komplexere Satzstrukturen und Semantiken verarbeiten. Dies führt zu einer besseren Leistung in Bereichen wie Schreibunterstützung, Inhaltsgenerierung und Sprachübersetzung sowie der Fähigkeit, Kontexte zu verstehen und relevante Antworten zu geben.

Schnelle Reaktionszeit

Im Vergleich zu GPT-4 wurde die Rechengeschwindigkeit von GPT-4o erheblich verbessert und beantwortete Fragen in nur 232 Millisekunden (0,232 Sekunden), mit einem Durchschnitt von 320 Millisekunden (0,32 Sekunden). Im Vergleich dazu betrugen die durchschnittlichen Reaktionszeiten im Sprachmodus für GPT-3.5 und GPT-4 2,8 Sekunden bzw. 5,4 Sekunden. Wenn Benutzer mit GPT-4o interagieren, können sie eine deutliche Geschwindigkeitssteigerung spüren, sodass es eher zu einem natürlichen Gespräch mit einer echten Person kommt.

Lebendige Spracherzeugung

Was die Sprache betrifft, hat GPT-4o erhebliche technologische Fortschritte gemacht und kann eine natürlichere und flüssigere Sprache erzeugen.

Ausgezeichnete visuelle Erkennungsfähigkeiten

GPT-4o legt den Schwerpunkt auf die Verbesserung der visuellen Erkennungsfähigkeiten und kann die umgebenden menschlichen Ausdrücke, Umgebungs- und Objektaktivitäten in Bildern oder dynamischen Bildern schnell und genau identifizieren.

Welche Funktionen hat GPT-4o?

Video-Chat

OpenAI-Tester fragten GPT-4o nach Vorschlägen für das Erscheinungsbild, bevor sie ein Interview simulierten. Obwohl das Haar des Probanden unordentlich war und er einen Fischerhut tragen wollte, um es zu verbergen, schlug GPT-4o vor, dass er sich die Haare kämmen sollte! Während des Gesprächs zeigten die Testpersonen Emotionen und interagierten mit GPT-4o, als würden sie mit einem echten Freund sprechen. Während des Gesprächs kann der Benutzer die Antwort von GPT-4o jederzeit unterbrechen und das Gespräch dann fortsetzen.

direkte Übersetzung

GPT-4o beherrscht 50 Sprachen und seine Sprachreaktionszeit wurde optimiert, sodass eine Echtzeitübersetzung ohne Verzögerung möglich ist. Der Übersetzungseffekt ist schnell und präzise und es können sprachliche und geografische Barrieren überwunden werden. Wenn OpenAI-Tester beispielsweise Englisch ins Italienische bzw. Italienisch ins Englische konvertieren müssen, führt GPT-4o eine sofortige Übersetzung schnell und nahezu ohne Zeitunterschied durch.

Bestimmen Sie menschliche Emotionen

Die Testperson bat GPT-4o vor einer angespannten Besprechung um Hilfe beim Ablesen seiner Atmung. Durch die Beobachtung des Atemrhythmus des Probanden kann GPT-4o Vorschläge machen, beispielsweise zur Anpassung des Atemrhythmus, um Verspannungen zu lösen. Laut OpenAI kann GPT-4o die Ausdrücke und Emotionen der Benutzer „lesen“ und mit einem lebendigeren und kontextbezogeneren Ton reagieren. GPT-4o kann eine Vielzahl von Stimmstilen und Intonationen imitieren und sogar natürlich wie eine echte Person lachen, nachdem sie einen Witz gehört hat, sodass es für Menschen schwierig ist, zu erkennen, dass es sich um einen KI-Roboter handelt!

Umgebungserkennung

GPT-4o legt den Schwerpunkt auf die Verbesserung der visuellen Erkennungsfähigkeiten. Diese Funktion hilft sehbehinderten Menschen, GPT-4o zu verwenden, um die visuelle Erkennung zu ersetzen und die Umgebungssituation beim Ausgehen mitzuteilen. Aus dem Demonstrationsvideo des Testers können wir ersehen, dass GPT-4o die Umgebung klar beschreibt, z. B. wo sich der Buckingham Palace befindet, wie man ein Taxi ruft, und Benutzer daran erinnert, die Hand zu heben, um ein Taxi zu rufen usw.

Interpretieren Sie Benutzeraktionen und -verhalten

Der Tester spielte das Stein-Schere-Papier-Spiel, und Chat GPT-4o sah die Aktionen des Benutzers deutlich und bestimmte das Ergebnis richtig. Sie können GPT-4o auch einladen, Ihnen fröhlich und natürlich „Happy Birthday“ zu singen, genau wie ein echter Freund.

Bild, Text, Text-to-Speech

GPT-4o versteht Bilder, einschließlich Text, Zahlen, Strichzeichnungen und Codes, und erklärt mithilfe der Stimme die Details und Inhalte in den Bildern. Es kann Menschen auch das Zählen beibringen! Tägliche Dokumentenverarbeitungsfunktionen wie Bilder, Text und Text-to-Speech liegen außerhalb der Reichweite von Chat GPT-4o.

Online-Meeting-Assistent

Da GPT-4o über die Fähigkeit verfügt, Bildschirme zu erkennen, können Sie bei Verwendung der Computerversion von ChatGPT Ihren Bildschirm damit teilen. GPT-4o kann den Inhalt des Bildschirms erkennen und ihn mit dem Benutzer besprechen. Benutzer können ChatGPT-4o auch zu einer Online-Videokonferenz hinzufügen und die KI als Gastgeber der Konferenz fungieren lassen, indem sie ihr jederzeit Fragen stellt oder sie auffordert, die Konferenz zusammenzufassen.

Online-Nachhilfe zur Hausaufgabenhilfe

Salman Khan, der Gründer der Khan Academy, veröffentlichte ein Video mit GPT-4o, um Schülern bei der Lösung von Problemen zu helfen. ChatGPT-4o ist wie ein Tutor, der die Schüler geduldig zum Denken und Antworten per Stimme anleitet. Eltern können die KI bitten, keine Antworten zu geben, sondern den Schülern die Möglichkeit zu geben, ihre eigenen Fragen durch eine Schritt-für-Schritt-Anleitung zu beantworten. Während des gesamten Prozesses zeigte die KI eine ermutigende Haltung gegenüber den Studierenden.

Klicken Sie auf das Bild, um mehr über die fünf wichtigsten Verkaufsargumente von ChatGPT-4o zu erfahren:

ChatGPT-4o 5 größte Verkaufsargumente

1. Schnelle Reaktionsfähigkeit

Ein bemerkenswertes Merkmal von ChatGPT-4o ist seine schnelle Reaktion auf Audioeingaben. Die durchschnittliche Reaktionszeit beträgt 320 Millisekunden, die schnellste kann 232 Millisekunden betragen, was nahe an der menschlichen Gesprächsgeschwindigkeit liegt. Diese Verbesserung macht ChatGPT-4o effizienter und kostengünstiger im Vergleich zu bestehenden Modellen. Insbesondere in Bezug auf englische Texte und Programmierung hat es das Niveau von GPT-4 Turbo erreicht und schneidet auch bei der Verarbeitung nicht-englischer Sprachen gut ab, und die Kosten sind 50 % niedriger als über die API.

2. Verbesserung der audiovisuellen Verarbeitungsmöglichkeiten

ChatGPT-4o macht erhebliche Fortschritte beim visuellen und auditiven Verständnis. Im Vergleich dazu erfordern frühere Modelle wie GPT-3.5 und GPT-4 bei Verwendung des Sprachmodus eine mehrstufige Verarbeitung der Audioeingabe, was zu einer erhöhten Latenz (2,8 Sekunden für GPT-3.5 und 5,4 Sekunden für GPT-4) und einer Menge führt Kontextinformationen gehen verloren. Diese Modelle müssen Audio in Text umwandeln, Text verarbeiten und wieder in Audio umwandeln, was ihre Fähigkeit zur Tonerkennung, zum Umgang mit mehreren Sprechern oder zur Analyse von Hintergrundgeräuschen einschränkt.

3. Sofortige Sprachgesprächsfunktion

ChatGPT-4o ist nicht nur hinsichtlich der Intelligenz mit GPT-4 gleichwertig, sondern auch hinsichtlich Geschwindigkeit und Funktionalität verbessert. Benutzer können beispielsweise Menüs in verschiedenen Sprachen fotografieren, direkt mit ChatGPT-4o sprechen, übersetzen und mehr über die Geschichte und Bedeutung von Lebensmitteln erfahren, während sie gleichzeitig Essensempfehlungen erhalten. OpenAI hofft, in Zukunft natürlichere Echtzeit-Sprachgesprächsfunktionen einzuführen und mit ChatGPT in Echtzeitvideos zu interagieren, beispielsweise durch die Erklärung der Regeln von Live-Sportveranstaltungen.

4. Unterstützt mehr als 50 Sprachen

ChatGPT-4o hat die Qualität und Geschwindigkeit der Sprachverarbeitung erheblich verbessert und unterstützt jetzt mehr als 50 Sprachen. OpenAI hat damit begonnen, ChatGPT-4o bei ChatGPT Plus- und Team-Benutzern zu bewerben, und Unternehmensbenutzer werden bald Zugriff auf den Dienst haben. Darüber hinaus können alle Benutzer ChatGPT-4o verwenden, für kostenlose Benutzer gelten jedoch Nutzungsbeschränkungen. Für Plus-Benutzer gilt das Fünffache des Nachrichtenlimits als für kostenlose Benutzer, und für Team- und Unternehmensbenutzer gelten höhere Einschränkungen.

5. Neue Funktionen für kostenlose Benutzer verfügbar

OpenAI ist bestrebt, mehr Menschen fortschrittliche KI-Tools zur Verfügung zu stellen. Derzeit nutzen jede Woche mehr als 100 Millionen Menschen ChatGPT. In den nächsten Wochen wird OpenAI den kostenlosen Benutzern schrittweise weitere intelligente Tools und Funktionen zur Verfügung stellen. Dazu gehören das Genießen intelligenter Erlebnisse auf GPT-4-Ebene, das Erhalten von Antworten von Modellen und Netzwerken, das Durchführen von Datenanalysen und das Erstellen von Diagrammen sowie das Besprechen von Fotoinhalten Dateien, um Hilfe beim Zusammenfassen, Schreiben oder Analysieren zu erhalten, GPTs und den GPT-Store zu erkunden und zu verwenden und die Speicherfunktion zu nutzen, um ein durchdachteres Erlebnis zu schaffen.

ChatGPT-4oWie viel kostet das?

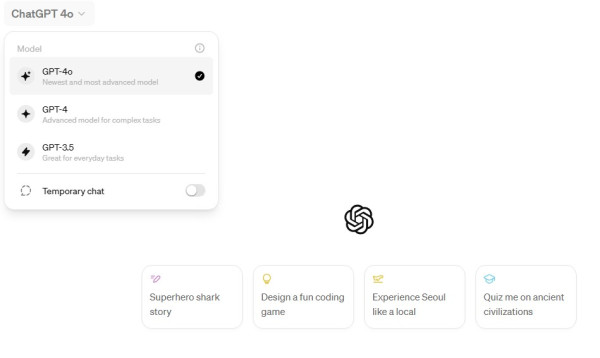

Bezahlversion

Benutzer von ChatGPT Plus können zur Nutzung frei auf GPT-4o umsteigen. Benutzer von kostenpflichtigen Abonnements haben weniger Nachrichteneinschränkungen als Benutzer der kostenlosen Version.

Benutzer von ChatGPT Plus können zur Nutzung frei auf GPT-4o umsteigen. Benutzer von kostenpflichtigen Abonnements haben weniger Nachrichteneinschränkungen als Benutzer der kostenlosen Version.

Benutzer von ChatGPT Plus können zur Nutzung frei auf GPT-4o umsteigen. Benutzer von kostenpflichtigen Abonnements haben weniger Nachrichteneinschränkungen als Benutzer der kostenlosen Version.

Freie Version

Benutzer der kostenlosen Version können nicht frei zu GPT-4o wechseln und müssen über ChatGPT Plus-Benutzer wechseln. Darüber hinaus verfügt die kostenlose Version von GPT-4o über ein begrenztes Kontingent. Sobald das Nutzungslimit überschritten ist, müssen Sie einen halben Tag warten, bevor Sie es wieder verwenden können.

GPT-4, das im März 2023 eingeführt wurde, wird für Benutzer verfügbar sein, die 20 US-Dollar pro Monat für ein Abonnement von ChatGPT Plus zahlen. Funktionen, die bisher nur zahlenden Benutzern zur Verfügung standen, wie Speicher und Webbrowsing, stehen Benutzern jetzt kostenlos zur Verfügung.

Wenn Sie GPT-4o haben, möchten Sie trotzdem ChatGPT Plus kaufen?

Wenn Sie ChatGPT häufig nutzen, ist es dennoch erforderlich, die kostenpflichtige Version von ChatGPT Plus zu abonnieren. Denn die kostenlose Version von GPT-4o verfügt über ein Nutzungskontingent. Nachdem ich 6-7 Fragen gestellt hatte, war das Tageslimit erreicht und ich wurde gebeten, etwa 9 Stunden zu warten, bevor ich es erneut verwenden konnte. Barret Zoph, Forschungsleiter bei OpenAI, sagte einmal: „Mit Plus können Benutzer es häufiger verwenden als Nicht-Abonnenten. Abonnenten von ChatGPT Plus können fünfmal mehr Befehle senden als GPT-4o.“

Wann wird die GPT-4o-App/Desktop verfügbar sein?

Schließlich wird erwartet, dass der von ChatGPT-4o bereitgestellte Sprachdienst nächsten Monat (Juni 2024) als Betaversion für Abonnentenbenutzer veröffentlicht wird.

OpenAI erwähnte jedoch, dass sie über den Missbrauch der Sprachfunktion besorgt seien, sodass die Sprachfunktion vorerst nicht für alle API-Benutzer zugänglich sein wird. Sie wird in den nächsten Wochen einigen vertrauenswürdigen Partnern zur Verfügung stehen, und wir werden dies tun müssen auf die Veröffentlichung nachfolgender Funktionen warten. Derzeit sehen Benutzer außerhalb der USA GPT-4o möglicherweise nicht auf iOS oder Android und die neue Mac-Desktop-App wurde noch nicht veröffentlicht. OpenAI plant, den Dienst in den kommenden Wochen breiter auf Mac-Desktops verfügbar zu machen, während eine Windows-Version voraussichtlich noch in diesem Jahr auf den Markt kommt.

【Verwandte Berichte】

Weiterführende Literatur:

Quelle:OpenAI 、OpenAI YouTube、pürierbar