Heute früh am Morgen wird eine 26-minütige Pressekonferenz die KI-Branche und unser zukünftiges Leben erneut stark verändern und auch unzählige KI-Startups in die Irre führen.

Das ist wirklich keine Schlagzeile, denn es handelt sich um eine OpenAI-Pressekonferenz.

Gerade hat OpenAI GPT-4o offiziell veröffentlicht, wobei das „o“ für „omni“ steht (was bedeutet, dass dieses Modell umfassend und allmächtig ist. Dies ist sogar das GPT-5 An). unvollendete Version.

Darüber hinaus steht dieses GPT-4-Level-Modell allen Benutzern kostenlos zur Verfügung und wird in den kommenden Wochen auf chatgpt Plus ausgeweitet.

Lassen Sie uns zunächst die Höhepunkte dieser Konferenz zusammenfassen. Bitte lesen Sie weiter unten für weitere Funktionsanalysen.

Kernpunkte der Pressekonferenz

- Neues GPT-4o-Modell: Ermöglicht die Eingabe beliebiger Texte, Audiodaten und Bilder und kann diese ohne Zwischenkonvertierung direkt generieren

- GPT-4o hat die Sprachlatenz deutlich reduziert und kann auf Audioeingaben in 232 Millisekunden reagieren, mit einem Durchschnitt von 320 Millisekunden, was den menschlichen Reaktionszeiten in Gesprächen ähnelt.

- GPT-4 ist kostenlos und steht allen Benutzern offen

- GPT-4o-API, 2-mal schneller als GPT4-Turbo und 50 % günstiger

- Atemberaubende Demonstration des Sprachassistenten in Echtzeit: Das Gespräch ähnelt eher einem Menschen, kann in Echtzeit übersetzen, Ausdrücke erkennen und den Bildschirm durch die Kamera erkennen, Code schreiben und Diagramme analysieren

- ChatGPT neue Benutzeroberfläche, prägnanter

- Eine neue ChatGPT-Desktop-App für macOS, die Windows-Version kommt später in diesem Jahr

Diese Merkmale wurden von Altman bereits in der Aufwärmphase als „gefühlt wie Magie“ beschrieben. Da KI-Modelle auf der ganzen Welt „GPT-4 einholen“, muss OpenAI einige echte Dinge aus seinem Arsenal herausholen.

Das kostenlose und verfügbare GPT-4o ist da, aber das ist nicht das größte Highlight

Tatsächlich stellten wir am Tag vor der Pressekonferenz fest, dass OpenAI die Beschreibung von GPT-4 stillschweigend von „das fortschrittlichste Modell“ in „fortschrittlich“ geändert hatte.

Damit soll die Ankunft von GPT-4o begrüßt werden. Die Stärke von GPT-4o besteht darin, dass es jede beliebige Kombination aus Text, Audio und Bildern als Eingabe akzeptieren und die oben genannte Medienausgabe direkt generieren kann.

Dies bedeutet, dass die Mensch-Computer-Interaktion der natürlichen Kommunikation zwischen Menschen näher kommen wird.

GPT-4o kann in 232 Millisekunden auf Audioeingaben reagieren, mit einem Durchschnitt von 320 Millisekunden, was nahe an der Reaktionszeit einer menschlichen Konversation liegt. Bei der vorherigen Verwendung des Sprachmodus zur Kommunikation mit ChatGPT betrug die durchschnittliche Latenz 2,8 Sekunden (GPT-3,5) bzw. 5,4 Sekunden (GPT-4).

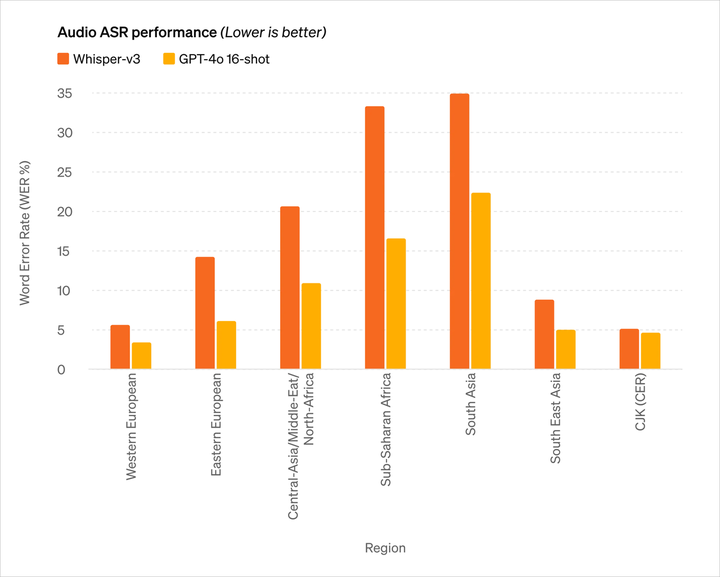

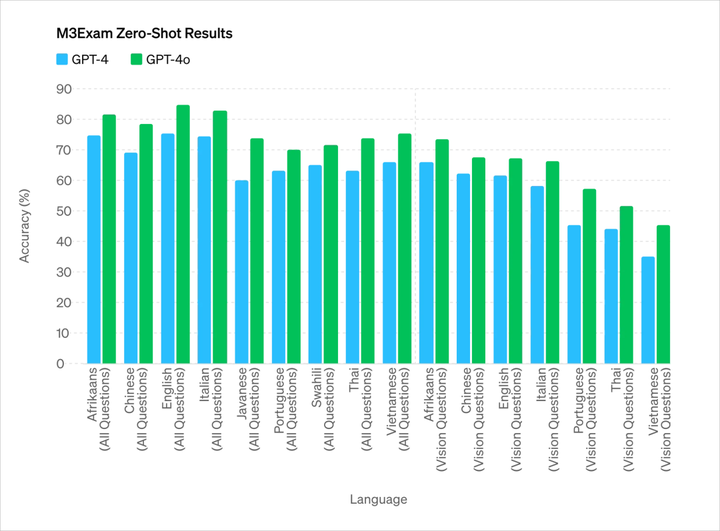

Es erreicht die Leistung von GPT-4 Turbo bei Englisch und Codetext, mit erheblichen Verbesserungen bei nicht englischsprachigem Text, während es bei der API schneller und 50 % günstiger ist.

Im Vergleich zu bestehenden Modellen schneidet GPT-4o besonders gut beim visuellen und akustischen Verständnis ab.

- Sie können ein Gespräch jederzeit unterbrechen

- Kann je nach Szene eine Vielzahl von Tönen mit menschenähnlichen Stimmungen und Emotionen erzeugen

- Führen Sie direkt einen Videoanruf mit der KI durch und lassen Sie sie online verschiedene Fragen beantworten

Den Testparametern nach zu urteilen, liegen die Hauptfähigkeiten von GPT-4o im Wesentlichen auf dem gleichen Niveau wie GPT-4 Turbo, das derzeit stärkste OpenAI.

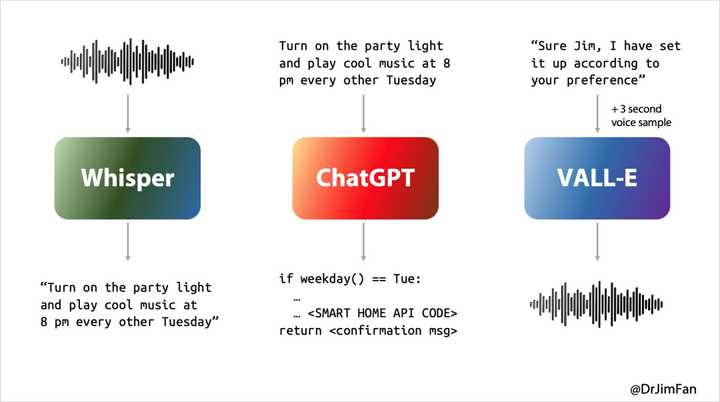

In der Vergangenheit waren unsere Erfahrungen mit Siri oder anderen Sprachassistenten nicht optimal. Im Wesentlichen durchlief das Gespräch mit dem Sprachassistenten drei Phasen:

- Spracherkennung oder „ASR“: Audio -> Text, ähnlich wie Whisper;

- LLM plant, was als nächstes gesagt werden soll: Text 1 -> Text 2;

- Synthese-zu-Sprache oder „TTS“: Text 2 -> Audio, denken Sie an ElevenLabs oder VALL-E.

Unsere täglichen natürlichen Gespräche laufen jedoch im Grunde so ab

- Überlegen Sie, was Sie als Nächstes sagen möchten, während Sie zuhören und sprechen.

- Fügen Sie an der richtigen Stelle „yeah, ähm, ähm“ ein;

- Erwarten Sie, wann die andere Partei mit dem Sprechen fertig ist, und übernehmen Sie sofort das Gespräch;

- Beschließen Sie, das Gespräch der anderen Person auf natürliche Weise und ohne Groll zu unterbrechen;

- Überlegen Sie, was Sie als Nächstes sagen möchten, während Sie zuhören und sprechen.

- Fügen Sie an der richtigen Stelle „yeah, ähm, ähm“ ein;

- Behandeln und unterbrechen Sie höflich.

Frühere KI-Sprachassistenten konnten diese Probleme nicht gut bewältigen, und in jeder der drei Phasen des Gesprächs kam es zu großen Verzögerungen, was zu einem schlechten Erlebnis führte. Gleichzeitig gehen dabei viele Informationen verloren, etwa die Unfähigkeit, die Intonation, mehrere Sprecher oder Hintergrundgeräusche direkt zu beobachten, und die Unfähigkeit, Lachen, Singen oder Emotionen auszudrücken.

Wenn Audio direkt Audio, Bilder, Text und Videos erzeugen kann, wird das gesamte Erlebnis sprunghaft sein.

GPT-4o ist ein brandneues Modell, das von OpenAI für diesen Zweck trainiert wurde. Die direkte Konvertierung von Text, Video und Audio erfordert, dass alle Ein- und Ausgaben von demselben neuronalen Netzwerk verarbeitet werden.

Noch überraschender ist, dass kostenlose Benutzer von ChatGPT mit GPT-4o die folgenden Funktionen nutzen können:

- Erleben Sie Intelligenz auf GPT-4-Niveau

- Erhalten Sie Antworten von Models und Netzwerken

- Analysieren Sie Daten und erstellen Sie Diagramme

- Lassen Sie uns über die Fotos sprechen, die Sie gemacht haben

- Laden Sie eine Datei hoch, um Hilfe bei der Zusammenfassung, beim Schreiben oder bei der Analyse zu erhalten

- Verwendung von GPTs und GPT Store

- Schaffen Sie hilfreichere Erfahrungen mit Memory

Und wenn Sie sich die folgenden Demonstrationen von GPT-4o ansehen, werden Ihre Gefühle möglicherweise komplizierter.

ChatGPT-Version „Jarvis“, jeder hat sie

ChatGPT kann nicht nur sprechen, zuhören, sondern auch zuschauen. Das ist nichts Neues, aber die „neue Version versenden“ von ChatGPT hat mich trotzdem überrascht.

Schlafpartner

Lassen Sie ChatGPT am Beispiel einer bestimmten Lebensszene eine Gute-Nacht-Geschichte über Roboter und Liebe erzählen. Es kann eine emotionale und dramatische Gute-Nacht-Geschichte erzählen, ohne viel nachzudenken.

Es kann sogar Geschichten in Form von Gesang erzählen, die den Nutzern als Schlafbegleiter dienen können.

Quizmaster

Oder lassen Sie sich auf der Pressekonferenz zeigen, wie Sie die lineare Gleichung 3X+1=4 lösen können. Es kann Sie Schritt für Schritt führen und die richtige Antwort geben.

Natürlich ist das oben Gesagte immer noch ein bisschen „Kinderspiel“, und die Codierungsschwierigkeiten vor Ort sind der eigentliche Test. Es lässt sich jedoch leicht mit drei Schlägen, fünf Schlägen und zwei Schlägen lösen.

Mit der „Vision“ von ChatGPT kann alles auf dem Computerbildschirm angezeigt werden, z. B. die Interaktion mit der Codebasis und die Anzeige der vom Code generierten Diagramme. Nicht wahr? Wird unsere Privatsphäre dann in Zukunft nicht deutlich sichtbar sein?

Echtzeitübersetzung

Das Publikum vor Ort stellte ChatGPT auch einige knifflige Fragen.

Unabhängig davon, wie oft Sie diesen KI-Sprachassistenten verwenden, können Sie problemlos vom Englischen ins Italienische und vom Italienischen ins Englische übersetzen. Es scheint, dass Sie nicht viel Geld ausgeben müssen, um einen Übersetzer zu kaufen In Zukunft ist ChatGPT möglicherweise besser als Ihr Echtzeit-Übersetzer. Der Übersetzer ist ziemlich zuverlässig.

Dieser Inhalt kann derzeit nicht außerhalb von Feishu-Dokumenten angezeigt werden.

▲ Echtzeitübersetzung (offizieller Website-Fall)

Das Wahrnehmen der Emotionen der Sprache ist nur der erste Schritt. ChatGPT kann auch menschliche Gesichtsemotionen interpretieren.

Bei der Pressekonferenz verwechselte ChatGPT direkt das von der Kamera aufgenommene Gesicht mit einem Tisch. Gerade als alle dachten, es würde umkippen, stellte sich heraus, dass die zuerst eingeschaltete Frontkamera auf den Tisch gerichtet war .

Am Ende wurden jedoch die Emotionen im Gesicht des Selfies genau beschrieben und das „strahlende“ Lächeln im Gesicht genau identifiziert.

Interessanterweise vergaß der Sprecher am Ende der Pressekonferenz nicht Cues „starke Unterstützung“ von Nvidia und seinem Gründer Lao Huang. Er hat wirklich Verständnis für die menschliche Natur.

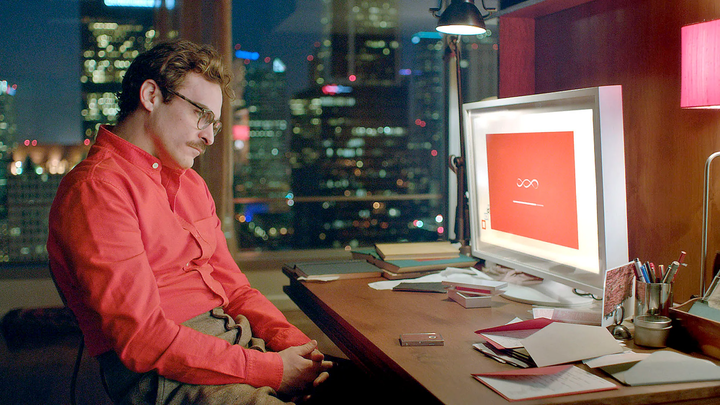

Die Idee einer Konversationssprachschnittstelle war unglaublich prophetisch.

Altman äußerte in früheren Interviews, dass er hofft, irgendwann einen KI-Assistenten ähnlich dem im KI-Film „Her“ zu entwickeln, und der heute von OpenAI veröffentlichte Sprachassistent wird tatsächlich Wirklichkeit.

Brad Lightcap, Chief Operating Officer von OpenAI, sagte vor nicht allzu langer Zeit voraus, dass wir in Zukunft mit KI-Chatbots auf die gleiche Weise sprechen werden wie mit Menschen und sie als Teil eines Teams behandeln werden.

Nun scheint es, dass dies nicht nur den Weg für die heutige Konferenz geebnet hat, sondern auch eine lebendige Fußnote zu unserem Leben in den nächsten zehn Jahren darstellt.

apple kämpft seit dreizehn Jahren mit KI-Sprachassistenten und ist nicht in der Lage, aus dem Labyrinth herauszukommen, aber OpenAI hat über Nacht den Ausweg gefunden. Es ist absehbar, dass Iron Mans „Jarvis“ in naher Zukunft keine Fantasie mehr sein wird.

„Sie kommt

Obwohl Sam Altman nicht auf der Konferenz erschien, veröffentlichte er nach der Konferenz einen Blog und postete ein Wort auf X:her.

Dies ist offensichtlich eine Anspielung auf den gleichnamigen Science-Fiction-Klassiker „Her“. Dies war das erste Bild, das mir in den Sinn kam, als ich die Präsentation dieser Konferenz sah.

Samantha im Film „Her“ ist nicht nur ein Produkt, sie versteht den Menschen sogar besser als der Mensch und ist den Menschen selbst ähnlicher. Wenn man mit ihr kommuniziert, kann man wirklich nach und nach vergessen, dass sie eine KI ist.

Das bedeutet, dass das Mensch-Computer-Interaktionsmodell nach der grafischen Benutzeroberfläche ein wirklich revolutionäres Update einleiten könnte, wie Sam Altman in seinem Blog sagte:

Die neuen Sprach- (und Video-)Modi sind die beste Computerschnittstelle, die ich je verwendet habe. Es fühlt sich an wie eine KI aus einem Film und ich bin immer noch ein wenig überrascht, dass es echt ist. Es stellt sich als große Veränderung heraus, Reaktionszeiten und Ausdruckskraft auf menschlicher Ebene zu erreichen.

Das vorherige ChatGPT ermöglichte es uns, den Beginn der natürlichen Benutzeroberfläche zu sehen: Einfachheit vor allem: Komplexität ist der Feind der natürlichen Benutzeroberfläche. Jede Interaktion sollte selbsterklärend sein und keine Bedienungsanleitung erfordern.

Aber das heute veröffentlichte GPT-4o ist völlig anders. Es hat fast keine Verzögerung in der Reaktion, ist intelligent, interessant und praktisch. Unsere Interaktion mit Computern hat noch nie eine so natürliche und reibungslose Interaktion erlebt.

Wenn noch mehr personalisierte Funktionen und die Zusammenarbeit mit verschiedenen Endgeräten unterstützt werden, bedeutet dies, dass wir mit Mobiltelefonen, Computern, Datenbrillen und anderen Computerterminals viele Dinge tun können, die zuvor nicht möglich waren.

Spannender ist jetzt, dass das iphone-Erlebnis möglicherweise stärker verbessert wird als bei jeder Konferenz der letzten Jahre, wenn Apple im nächsten Monat offiziell seine Zusammenarbeit mit OpenAI ankündigt.

Jim Fan, leitender Code-Wissenschaftler bei NVIDIA, glaubt, dass die Zusammenarbeit zwischen iOS 18, bekannt als das größte Update in der Geschichte, und OpenAI drei Ebenen haben könnte:

- OpenAI verzichtet auf Siri und hat ein kleines GPT-4o für iOS weiterentwickelt, das ausschließlich auf dem Gerät läuft und die Möglichkeit bietet, für ein Upgrade zur Nutzung von Cloud-Diensten kostenpflichtig zu sein.

- Native Funktionen speisen Kamera- oder Bildschirmstreams in das Modell ein. Unterstützung auf Chipebene für neuronale Audio- und Videocodecs.

- Integrieren Sie die iOS-Betriebs-API auf Systemebene und die Smart-Home-API. Niemand nutzt Siri Shortcuts, aber es ist Zeit für ein Revival. Dies könnte zu einem KI-Agentenprodukt mit einer Milliarde Nutzern werden. Dies ist wie ein Tesla-ähnliches Datenschwungrad in Originalgröße für Smartphones.

Apropos: Mir tut google leid, das morgen eine Pressekonferenz abhalten wird.

Autor: Li Chaofan und Mo Chongyu