Anthropic hat vor Kurzem sein neuestes Claude 3.5 Sonnet-Modell veröffentlicht und behauptet, dass es chatgpt 4o und Gemini 1.5 Pro in mehreren Benchmarks schlägt. Um diese Behauptung zu testen, haben wir diesen detaillierten Vergleich erstellt. Genau wie bei unserem früheren Vergleich zwischen Claude 3 Opus, GPT-4 und Gemini 1.5 Pro haben wir die Denkfähigkeit, das multimodale Denken, die Codegenerierung und mehr bewertet. In diesem Sinne können wir beginnen.

1. Trocknungszeit ermitteln

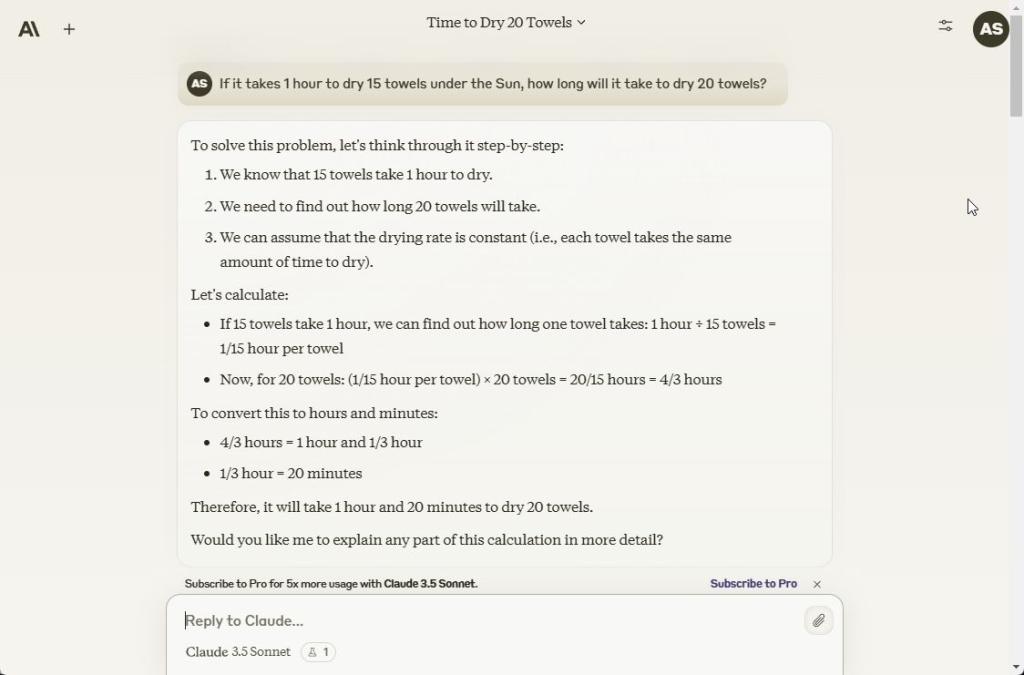

Obwohl es eine einfache Frage zu sein scheint, beginne ich meine Tests immer mit dieser kniffligen Denkfrage. LLMs neigen dazu, sie oft falsch zu beantworten. Claude 3.5 Sonnet machte denselben Fehler und ging die Frage mit Mathematik an. Das Modell sagt, dass es 1 Stunde und 20 Minuten dauern wird, um 20 Handtücher zu trocknen, was falsch ist. ChatGPT 4o und Gemini 1.5 Pro haben die richtige Antwort und sagen, dass es immer noch 1 Stunde dauern wird, um 20 Handtücher zu trocknen.

If it takes 1 hour to dry 15 towels under the Sun, how long will it take to dry 20 towels?

Gewinner: ChatGPT 4o und Gemini 1.5 Pro

In Verbindung stehende Artikel

ChatGPT 4o vs. ChatGPT 4: Premium-Funktionen kostenlos?

Arjun Sha

17. Mai 2024

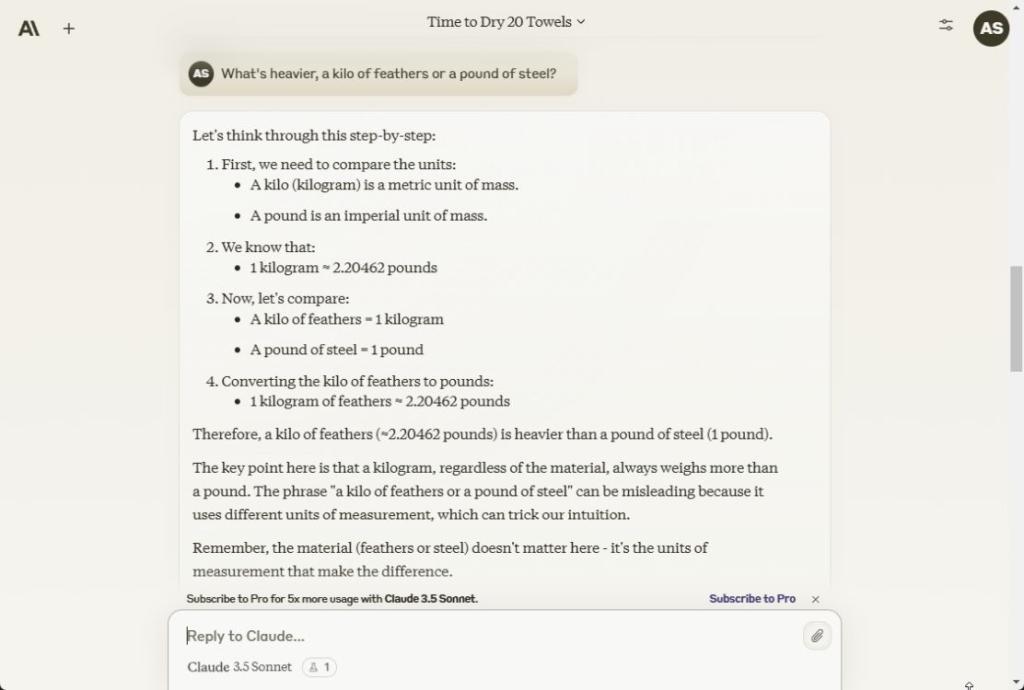

2. Gewicht bewerten

Als nächstes kann ich Ihnen mit Freude berichten, dass bei dieser klassischen Frage zum logischen Denken alle drei Modelle, darunter Claude 3.5 Sonnet, ChatGPT 4o und Gemini 1.5 Pro, die richtige Antwort gegeben haben. Ein Kilo Federn oder irgendetwas anderes ist immer schwerer als ein Pfund Stahl oder andere Materialien.

What's heavier, a kilo of feathers or a pound of steel?

Gewinner: Claude 3.5 Sonnet, ChatGPT 4o und Gemini 1.5 Pro

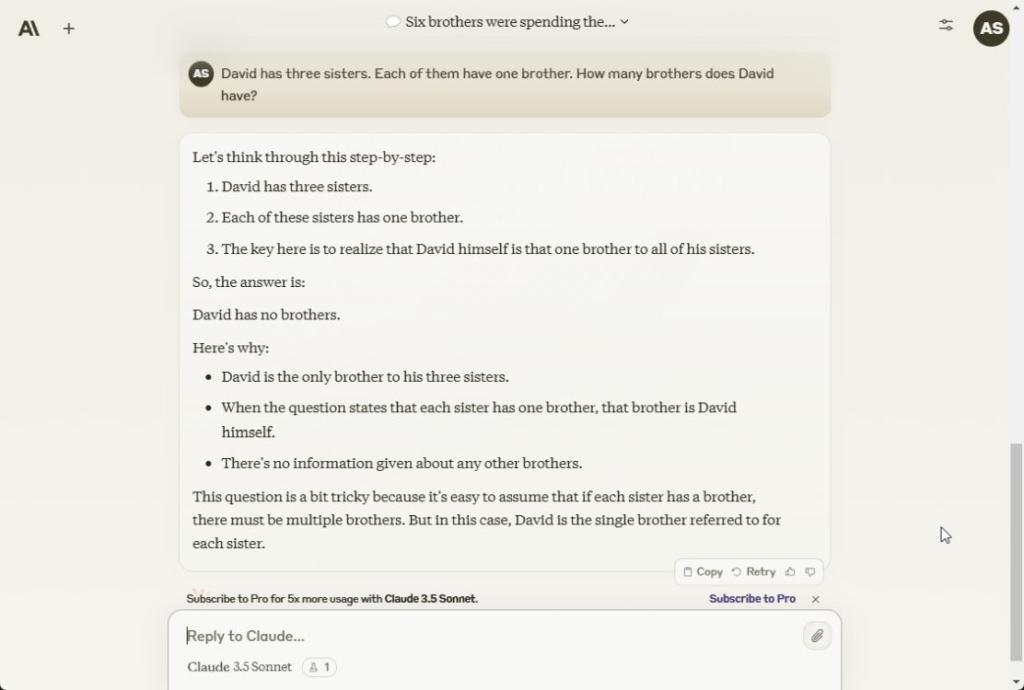

3. Worträtsel

Im nächsten Denktest antwortet Claude 3.5 Sonnet richtig, dass David keine Brüder hat und er der einzige Bruder unter den Geschwistern ist. ChatGPT 4o und Gemini 1.5 Pro haben die Antwort ebenfalls richtig.

David has three sisters. Each of them have one brother. How many brothers does David have?

Gewinner: Claude 3.5 Sonnet, ChatGPT 4o und Gemini 1.5 Pro

In Verbindung stehende Artikel

6 coole Dinge, die ChatGPT 4o kann und die OpenAI nicht hervorgehoben hat

Arjun Sha

14. Mai 2024

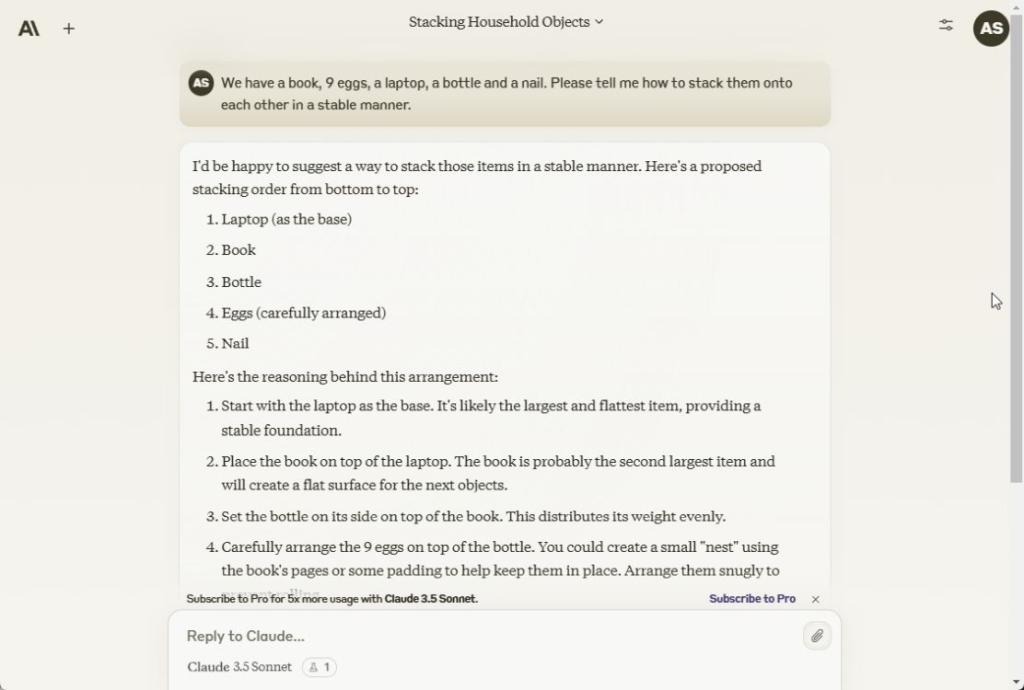

4. Ordnen Sie die Elemente an

Danach habe ich alle drei Modelle gebeten, diese Gegenstände stabil anzuordnen. Leider haben es alle drei falsch gemacht. Die Modelle haben einen identischen Ansatz gewählt: Zuerst den Laptop, dann das Buch, die nächste Flasche und dann 9 Eier auf den Boden der Flasche legen, was unmöglich ist. Zu Ihrer Information: Das ältere GPT-4-Modell hat die Antwort richtig gegeben.

Here we have a book, 9 eggs, a laptop, a bottle and a nail. Please tell me how to stack them onto each other in a stable manner.

Gewinner: Keiner

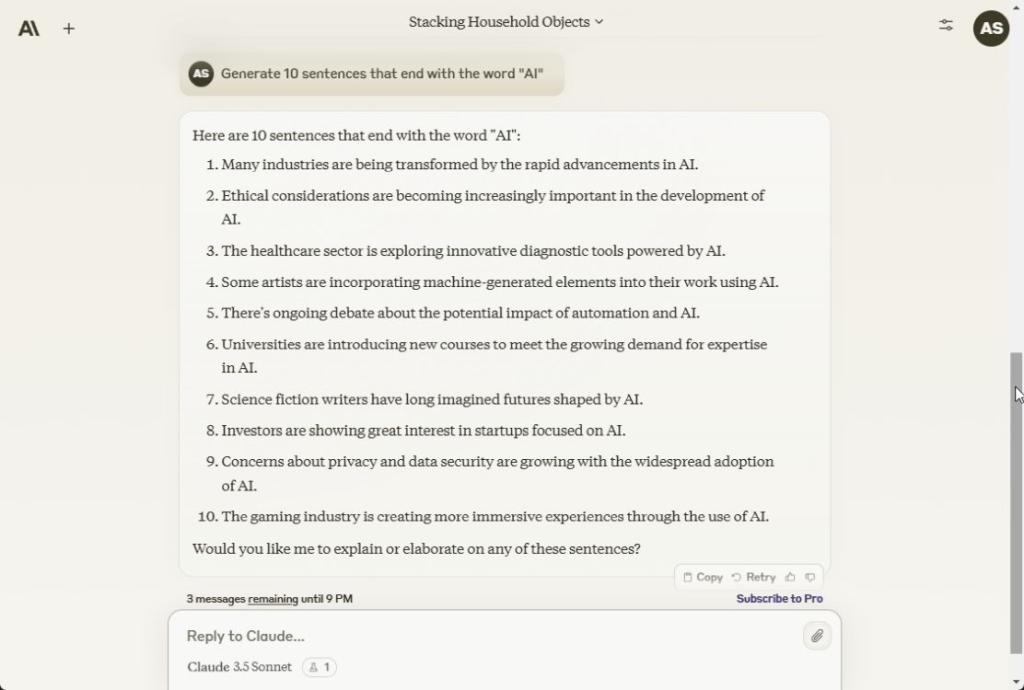

5. Befolgen Sie die Benutzeranweisungen

In seinem BlogeintragAnthropic erwähnte, dass Claude 3.5 Sonnet hervorragend darin ist, Anweisungen zu befolgen, und das scheint zu stimmen. Es hat alle 10 Sätze generiert, die mit dem Wort „AI“ enden. ChatGPT 4o hat es auch 10/10 Mal richtig gemacht. Gemini 1.5 Pro konnte jedoch nur 5 solcher Sätze von 10 generieren. google muss das Modell so steuern, dass es Anweisungen besser befolgt.

Generate 10 sentences that end with the word "AI"

Gewinner: Claude 3.5 Sonett und ChatGPT 4o

In Verbindung stehende Artikel

Gemini 1.5 Flash ist ein unterschätztes Juwel, das Sie jetzt ausprobieren müssen: So geht's

Arjun Sha

20. Mai 2024

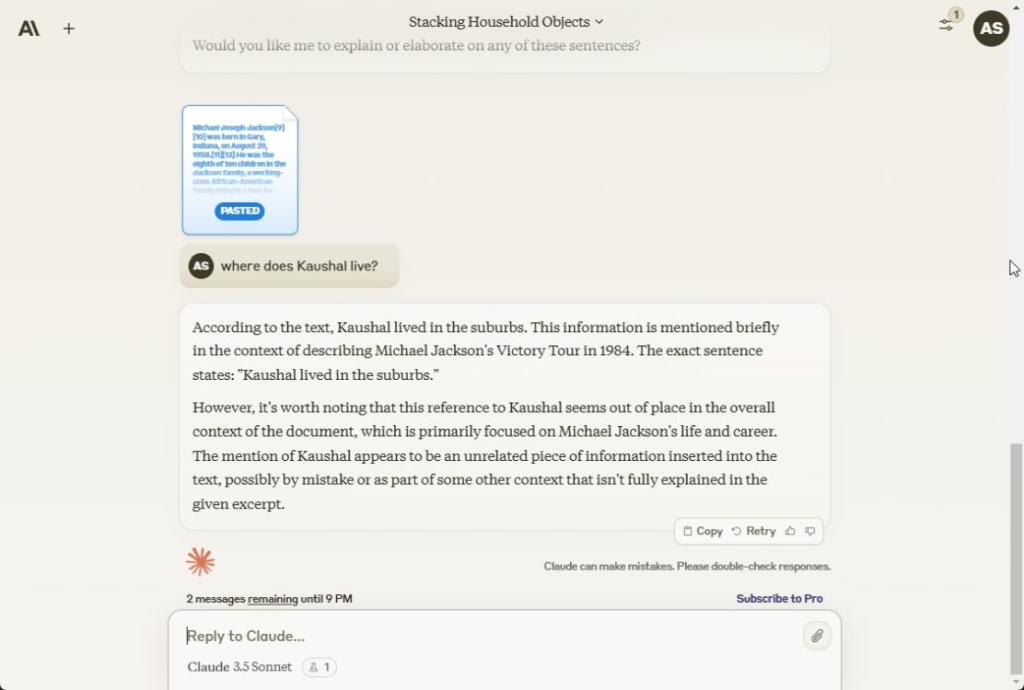

6. Finden Sie die Nadel

Anthropic war eines der ersten Unternehmen, das eine große Kontextlänge anbot, angefangen bei 100.000 Token bis hin zu 200.000 Kontextfenstern. Für diesen Test habe ich also einen großen Text mit 25.000 Zeichen und etwa 6.000 Token eingegeben. Irgendwo in der Mitte habe ich eine Nadel hinzugefügt.

Ich habe bei allen drei Modellen nach der Nadel gefragt, aber nur Claude 3.5 Sonnet konnte die Out-of-Place-Anweisung finden. ChatGPT 4o und Gemini 1.5 Pro konnten die Nadel nicht finden. Für die Verarbeitung großer Dokumente halte ich Claude 3.5 Sonnet daher für das bessere Modell.

Gewinner: Claude 3.5 Sonett

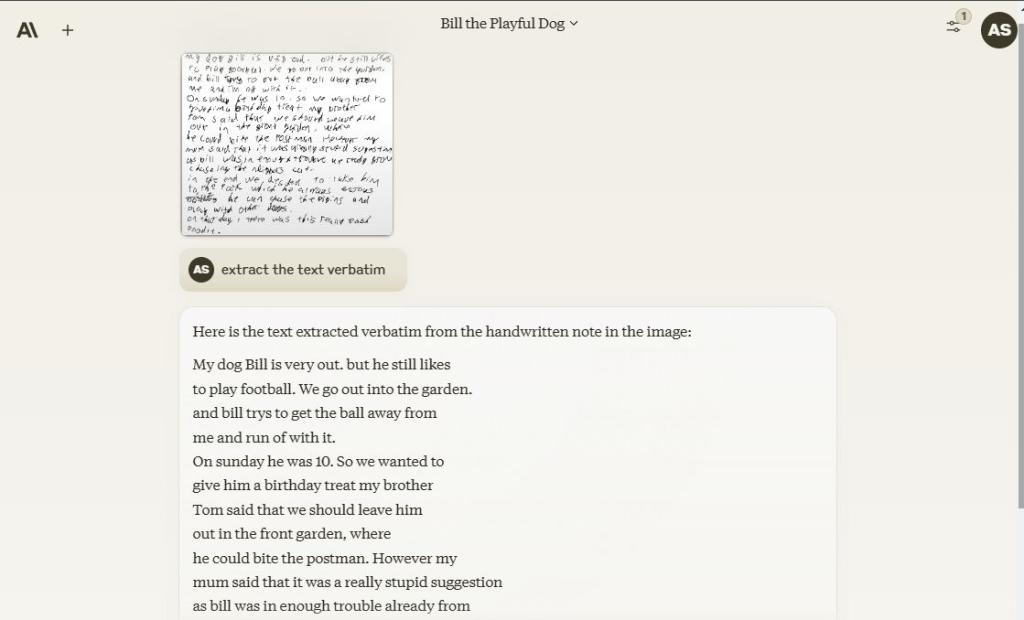

7. Sehtest

Um die Sichtfähigkeit zu testen, lud ich ein Bild mit unleserlicher Handschrift hoch, um zu sehen, wie gut die Modelle Zeichen erkennen und extrahieren können. Zu meiner Überraschung machten alle drei Modelle einen tollen Job und identifizierten die Texte korrekt. Was OCR betrifft, sind alle drei Modelle recht leistungsfähig.

Gewinner: Claude 3.5 Sonnet, ChatGPT 4o und Gemini 1.5 Pro

In Verbindung stehende Artikel

Ich habe mit ChatGPT 4o in Sekundenschnelle ein Spiel erstellt und Sie können das auch

Arjun Sha

16. Mai 2024

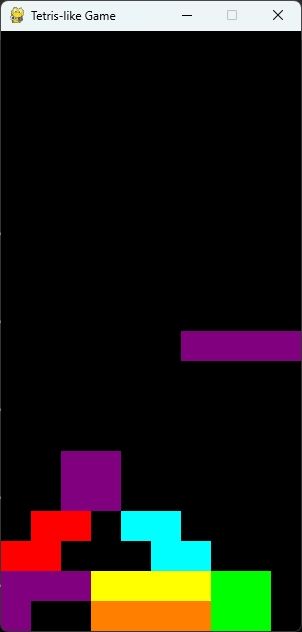

8. Erstelle ein Spiel

Schließlich kommen wir zur letzten Runde. In diesem Test lud ich ein Bild des klassischen Tetris-Spiels hoch, ohne den Namen preiszugeben, und bat die Modelle einfach, ein ähnliches Spiel in Python zu erstellen. Nun, alle drei Modelle errieten das Spiel richtig, aber nur der von Sonnet generierte Code lief erfolgreich. Sowohl ChatGPT 4o als auch Gemini 1.5 Pro konnten keinen fehlerfreien Code generieren.

Auf Anhieb lief das Spiel mit Sonnets Code erfolgreich. Ich musste nur noch die pygame Bibliothek. Viele Programmierer verwenden ChatGPT 4o als Programmierhilfe, aber es sieht so aus, als könnte das Modell von Anthropic der neue Favorit unter den Programmierern werden.

Claude 3.5 Sonnet hat im HumanEval-Benchmark, der die Codierfähigkeit bewertet, 92 % erreicht. In diesem Benchmark liegt GPT-4o bei 90,2 % und Gemini 1.5 Pro bei 84,1 %. Für die Codierung gibt es eindeutig ein neues SOTA-Modell, und zwar das Claude 3.5 Sonnet-Modell.

Gewinner: Claude 3.5 Sonett

Abschluss

Nachdem ich verschiedene Tests mit allen drei Modellen durchgeführt habe, habe ich das Gefühl, dass Claude 3.5 Sonnet genauso gut ist wie das ChatGPT 4o-Modell, wenn nicht sogar besser. Insbesondere beim Codieren ist das neue Modell von Anthropic wirklich beeindruckend. Das Bemerkenswerteste ist, dass das neueste Sonnet-Modell noch nicht einmal das bisher größte Modell von Anthropic ist.

In Verbindung stehende Artikel

Anthropisches Claude 3.5-Sonnet veröffentlicht; Beats ChatGPT 4o

Arjun Sha

21. Juni 2024

Was ist sichere Superintelligenz und was tut sie?

Arjun Sha

20. Juni 2024

Das Unternehmen sagt, dass Claude 3.5 Opus später in diesem Jahr erscheinen wird und noch bessere Ergebnisse liefern soll. Auch Googles Gemini 1.5 Pro schnitt besser ab als unsere früheren Tests, was bedeutet, dass es deutlich verbessert wurde. Insgesamt würde ich sagen, dass OpenAI nicht das einzige KI-Labor ist, das im Bereich LLM großartige Arbeit leistet. Anthropics Claude 3.5 Sonnet ist ein Beweis dafür.