Calvin Wankhede / Android Authority

Wenn Sie ChatGPT häufig verwenden, ist Ihnen vielleicht aufgefallen, dass der KI-Chatbot gelegentlich zu den ungünstigsten Zeiten ausfällt oder nicht mehr funktioniert. Diese Ausfälle dauern normalerweise nicht sehr lange, aber nachdem ich beim letzten Mal nicht weiterkam, sehnte ich mich nach einer zuverlässigeren Alternative. Glücklicherweise gibt es eine einfache Lösung in Form von lokalen Sprachmodellen wie LLaMA 3. Und das Beste daran? Sie können sogar auf relativ gewöhnlicher Hardware wie einem MacBook Air ausgeführt werden! Hier finden Sie alles, was ich bei der Verwendung von LLaMA 3 gelernt habe, und wie es im Vergleich zu ChatGPT abschneidet.

Warum Sie sich für lokale KI-Chatbots interessieren sollten

Die meisten von uns haben bisher nur ChatGPT und bekannte Alternativen wie Microsofts Copilot und Googles Gemini verwendet. All diese Chatbots laufen jedoch auf leistungsstarken Servern in weit entfernten Rechenzentren. Die Verwendung der Cloud bedeutet jedoch, dass man sich auf den Computer einer anderen Person verlässt, der ausfallen oder stundenlang nicht funktionieren kann.

Es ist auch unklar, wie Cloud-basierte KI-Chatbots Ihre Daten und Ihre Privatsphäre respektieren. Wir wissen, dass ChatGPT Gespräche speichert, um zukünftige Modelle zu trainieren, und dasselbe gilt wahrscheinlich auch für jedes andere Big-Tech-Unternehmen da draußen. Es ist keine Überraschung, dass Unternehmen weltweit, von Samsung bis Wells Fargo, ihren Mitarbeitern die interne Nutzung von ChatGPT untersagt haben.

Online-KI-Chatbots sind weder zuverlässig noch privat.

Hier kommen lokal ausgeführte KI-Chatbots ins Spiel. Nehmen wir zum Beispiel LLaMA 3, ein Open-Source-Sprachmodell, das von der KI-Abteilung von Meta entwickelt wurde (ja, dasselbe Unternehmen, dem auch Facebook und WhatsApp gehören). Der entscheidende Unterschied ist der Open-Source-Status von LLaMA – das heißt, jeder kann es herunterladen und selbst ausführen. Und da keine Daten jemals Ihren Computer verlassen, müssen Sie sich keine Sorgen machen, dass Geheimnisse preisgegeben werden.

Die einzige Voraussetzung zum Ausführen von LLaMA 3 ist ein relativ moderner Computer. Dies disqualifiziert leider Smartphones und Tablets. Ich habe jedoch festgestellt, dass Sie die kleinere Version von LLaMa 3 auf erschreckend minderwertiger Hardware ausführen können, darunter viele Laptops, die in den letzten Jahren auf den Markt gekommen sind.

LLaMA 3 vs. ChatGPT: Wie schlägt sich die Offline-KI?

Ich werde erklären, wie man LLaMA 3 installieren auf Ihrem Computer im nächsten Abschnitt, aber Sie möchten vielleicht zuerst wissen, wie es sich im Vergleich zu ChatGPT schlägt. Die Antwort ist nicht so einfach, da ChatGPT und LLaMA 3 in unterschiedlichen Varianten erhältlich sind.

Bis letzten Monat war die kostenlose Version von ChatGPT auf das ältere Modell GPT-3.5 beschränkt und man musste 20 $ pro Monat zahlen, um GPT-4 zu verwenden. Mit der Veröffentlichung von GPT-4o ermöglicht OpenAI nun kostenlosen Benutzern den Zugriff auf das neueste Modell mit einigen Einschränkungen hinsichtlich der Anzahl der Nachrichten, die pro Stunde gesendet werden können.

LLaMA 3 gibt es auch in zwei Modellgrößen: 8 Milliarden und 70 Milliarden Parameter. Die 8B-Version ist die einzige Wahl für diejenigen mit begrenzten Rechenressourcen, also im Wesentlichen alle außer den eingefleischtesten PC-Gamern. Das größere 70B-Modell benötigt nämlich mindestens 24 GB Videospeicher (VRAM), der derzeit nur auf exotischen 1.600-Dollar-GPUs wie der RTX 4090 von Nvidia verfügbar ist. Selbst dann müssen Sie sich mit einer komprimierten Version zufrieden geben, da das vollständige 70B-Modell 48 GB VRAM benötigt.

Angesichts all dessen ist LLaMA 3 8B natürlich unser Modell der Wahl. Die gute Nachricht ist, dass es sich sehr gut gegen GPT-3.5 oder das Basismodell von ChatGPT behaupten kann. Hier sind einige Vergleiche zwischen den beiden:

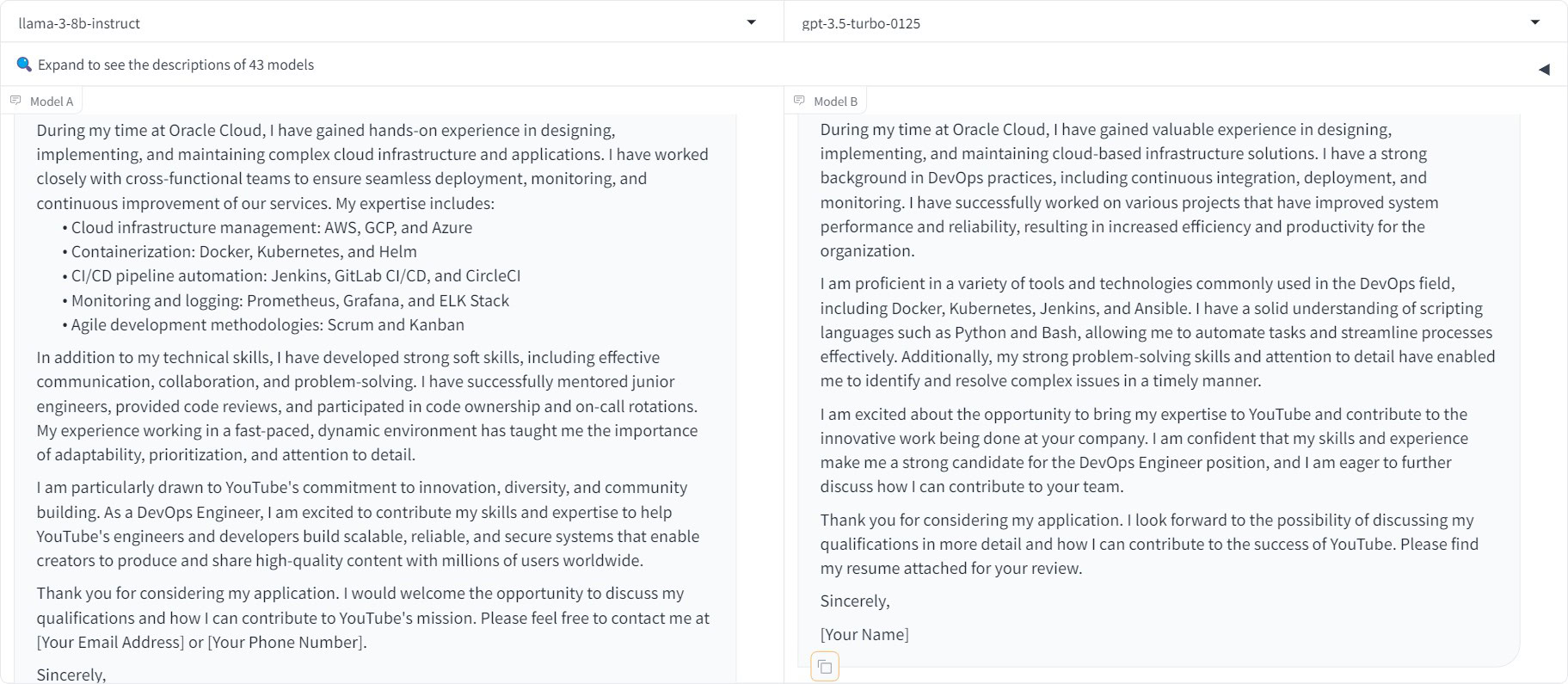

- Eingabeaufforderung 1: Schreiben Sie ein Anschreiben für die Stelle als DevOps Engineer bei YouTube. Ich arbeite seit meinem Abschluss als Softwareentwickler im Jahr 2019 bei Oracle Cloud.

Ergebnis: Praktisch unentschieden, auch wenn mir der Aufzählungspunktansatz von LLaMA etwas besser gefällt.

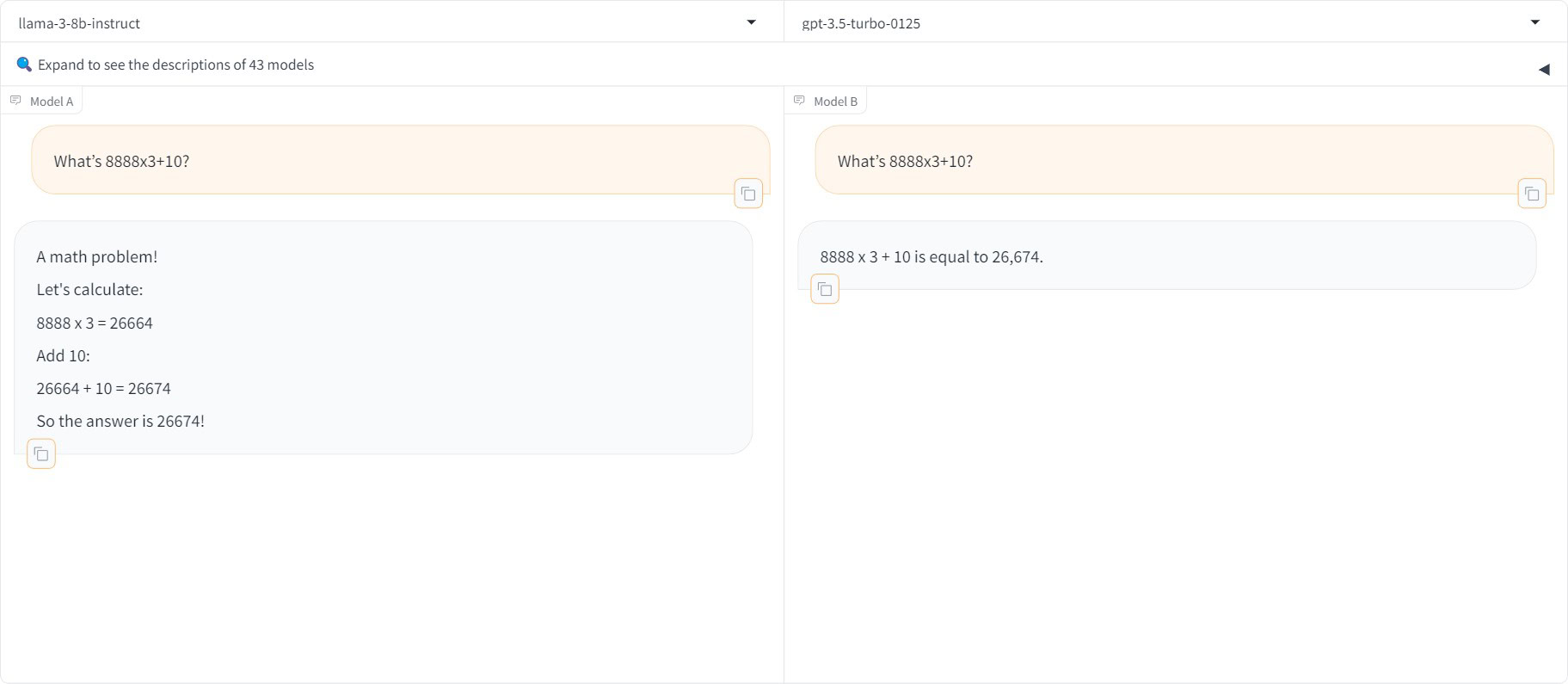

- Eingabeaufforderung 2: Was ist 8888×3+10?

Ergebnis: Beide Chatbots lieferten die richtige Antwort.

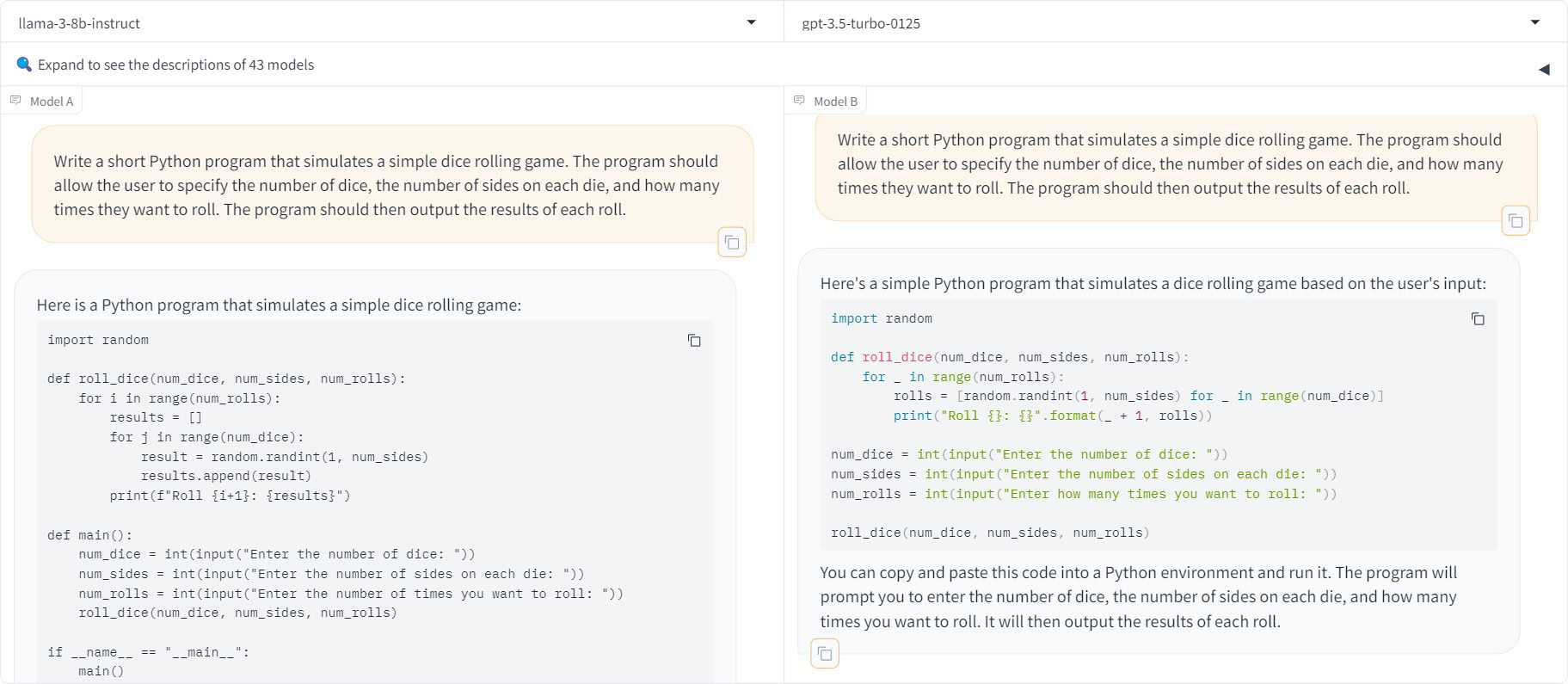

- Eingabeaufforderung 3: Schreiben Sie ein kurzes Python-Programm, das ein einfaches Würfelspiel simuliert. Das Programm sollte es dem Benutzer ermöglichen, die Anzahl der Würfel, die Anzahl der Seiten auf jedem Würfel und die Anzahl der Würfelwürfe anzugeben. Das Programm sollte dann die Ergebnisse jedes Wurfs ausgeben.

Ergebnis: Beide Chatbots haben funktionierenden Code produziert.

Ein erwähnenswerter Vorbehalt ist, dass weder GPT-3.5 noch LLaMA 3 auf das Internet zugreifen können, um aktuelle Informationen abzurufen. Die Frage nach dem SoC des Pixel 8 beispielsweise ergab bei beiden Modellen zwar selbstbewusst klingende, aber völlig ungenaue Antworten. Wenn Sie jemals sachliche Fragen stellen, würde ich die Antworten des lokalen Modells mit einer gehörigen Portion Skepsis betrachten. Aber für kreative und sogar Programmieraufgaben schneidet LLaMA 3 recht bewundernswert ab.

So laden Sie LLaMA 3 herunter und führen es lokal aus

Calvin Wankhede / Android Authority

Wie ich oben angedeutet habe, gibt es LLaMA 3 in zwei Größen. Das Modell LLaMA 3 8B erfordert nichts weiter als einen halbwegs aktuellen Computer. Tatsächlich lieferte die Ausführung auf meinem Desktop schnellere Antworten als ChatGPT oder jeder andere heute verfügbare Online-Chatbot. Obwohl mein Computer über eine Gaming-GPU der Mittelklasse verfügt, läuft LLaMA 3 auch problemlos auf einem Laptop mit bescheidener Hardware. Ein typisches Beispiel: Ich erhielt immer noch einigermaßen schnelle Antworten, als ich es auf einem M1 MacBook Air mit 16 GB RAM ausführte. Das ist vier Jahre alte Hardware, älter als ChatGPT selbst!

Nachdem wir das geklärt haben, benötigen Sie Software, um tatsächlich mit LLaMA 3 zu interagieren. Denn obwohl Sie das Modell kostenlos herunterladen können, bietet Meta es nicht als Programm oder App an, die Sie einfach per Doppelklick ausführen können. Dank der Open-Source-Community stehen uns heute jedoch mehrere verschiedene LLM-Frontends zur Verfügung.

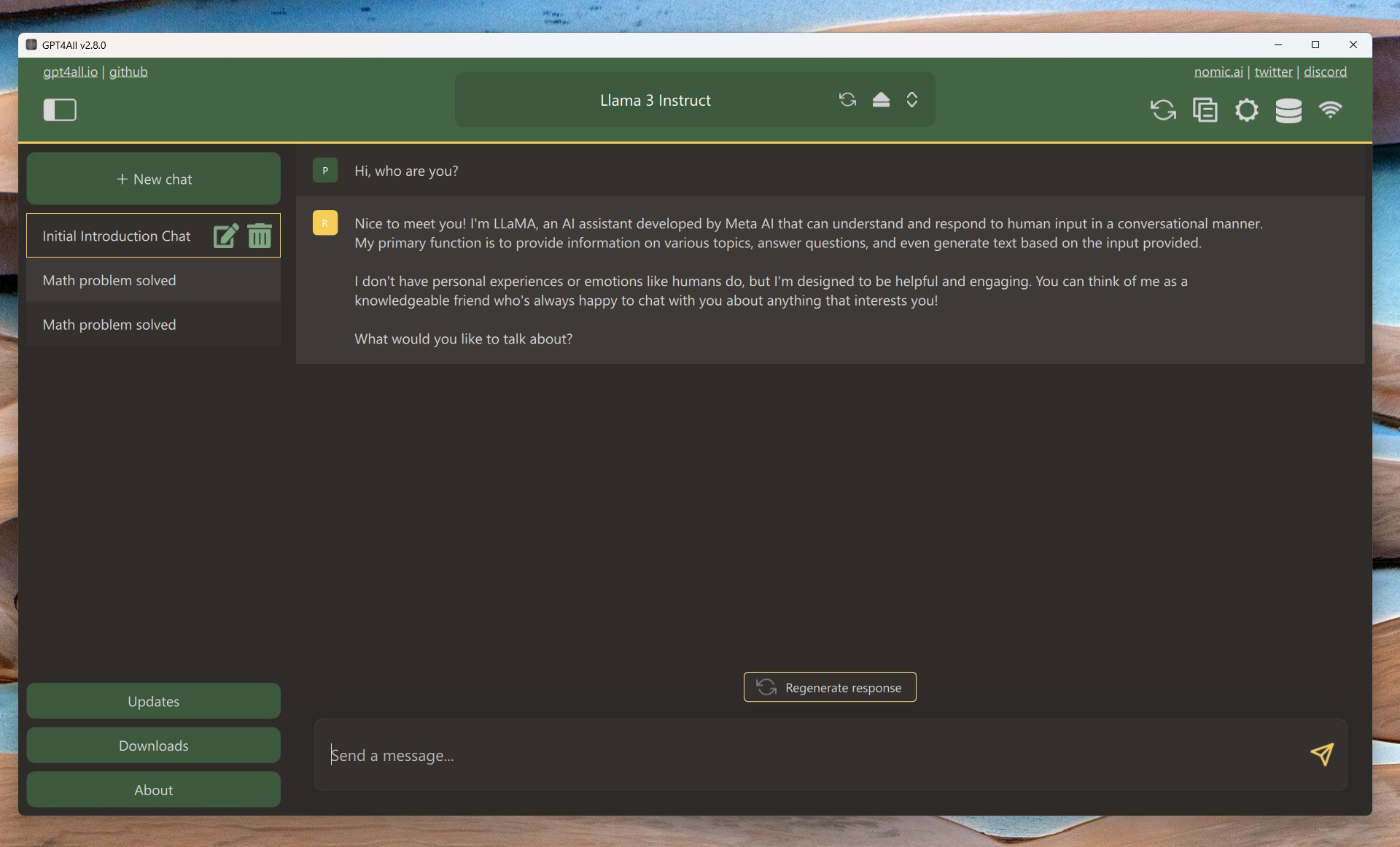

Nachdem ich einige davon ausprobiert habe, würde ich GPT4All empfehlen, da es den Download- und Ausführungsprozess von LLaMA 3 so einfach wie möglich macht. Hier ist eine Kurzanleitung:

- Herunterladen GPT4All für Ihren Windows- oder macOS-Computer und installieren Sie es.

- Öffnen Sie die GPT4All-App und klicken Sie auf Modelle herunterladen.

- Suchen Sie nach dem Modell „LLaMA 3 Instruct“ und klicken Sie auf Herunterladen. Dies ist das für Gespräche optimierte Modell 8B. Der Download kann je nach Internetverbindung einige Zeit dauern.

- Sobald der Download abgeschlossen ist, schließen Sie das Browser-Popup und wählen Sie LLaMA 3 Anleitung aus dem Dropdown-Menü „Modell“.

- Das war’s – Sie können mit dem Chatten beginnen. Sie sollten den oben abgebildeten Bildschirm sehen. Geben Sie einfach eine Eingabeaufforderung ein, drücken Sie die Eingabetaste und warten Sie, bis das Modell seine Antwort generiert.

Mein zugegebenermaßen leistungsstarker Desktop kann 50 Token pro Sekunde generieren, was die Reaktionsgeschwindigkeit von ChatGPT bei weitem übertrifft. Auf apple Silicon basierende Computer bieten dank ihres einheitlichen Speichers das beste Preis-Leistungs-Verhältnis und generieren Token schneller, als ein Mensch lesen kann.

Wenn Sie Windows ohne dedizierte GPU verwenden, ist die Textgenerierung von LLaMA 3 um einiges langsamer. Auf meiner Desktop-CPU lieferte es nur 5 Token pro Sekunde und erforderte mindestens 16 GB Systemspeicher. Auf der anderen Seite kommen Cloud-basierte Chatbots in Zeiten hoher Nachfrage jedoch auch nur langsam voran. Außerdem kann ich zumindest beruhigt sein, da ich weiß, dass meine Chats nie von jemand anderem gelesen werden.