Erinnern Sie sich, als Prisma die ultimative „KI“-Bildbearbeitungs-App auf dem Markt war? Ja, wir haben seitdem sicherlich einen langen Weg zurückgelegt. Mit dem Aufkommen von auf Eingabeaufforderungen basierenden KI-Bildgeneratoren wie DALL-E und Midjourney ist die Erstellung von Kunst und Deepfakes praktisch für jeden da draußen möglich.

Aber es gibt Einschränkungen, nicht wahr? Nach der anfänglichen Neuheit, Midjourney zu bitten, sich verschiedene Aufforderungen vorzustellen und zu sehen, was dabei herauskommt, wird alles ziemlich langweilig. Zumindest war es das bei mir.

Narzisstische Energie?

Schauen Sie, ich bin introvertiert, was bedeutet, dass ich nicht wirklich gerne ausgehe. Aber wissen Sie, was ich mag? Ich habe Bilder von mir an Orten, an die ich wahrscheinlich nie gehen würde; Verdammt, Orte, zu denen ich auch nicht gehen kann.

Natürlich wollte ich KI-Tools bitten, Bilder davon zu erstellen Mich in verschiedenen Situationen und an verschiedenen Orten. Allerdings wollte ich auch keine Bilder von mir auf zufälligen Websites hochladen, in der Hoffnung, dass die Ergebnisse gut sein würden; und da habe ich von Dreambooth gelesen.

Lasst die Spiele beginnen …

Es stellte sich heraus, dass wirklich kluge Leute Dinge wie Stable Diffusion der breiten Masse zugänglich gemacht haben. Darüber hinaus haben andere mit ihnen zusammengearbeitet und es buchstäblich jedem mit etwas Geduld ermöglicht, seine eigenen Stable Diffusion-Modelle zu erstellen und diese vollständig online auszuführen.

Obwohl ich also ein M1 MacBook Air habe, das keineswegs als Trainingsgerät für ein Deep-Learning-Bilderzeugungsmodell gedacht ist, kann ich ein Google Colab-Notebook betreiben und das alles auf den Servern von Google erledigen – kostenlos!

Alles, was ich wirklich brauchte, waren ein paar Bilder von mir, und das war’s.

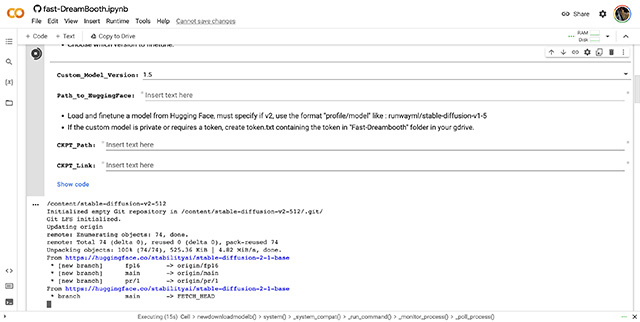

Trainiere meinen KI-Bildgenerator

Das Trainieren eines eigenen Bildgenerators ist überhaupt nicht schwierig. Wenn Sie Hilfe benötigen, stehen Ihnen online eine Reihe von Leitfäden zur Verfügung, die im Grunde genommen sehr einfach sind. Sie müssen lediglich das Colab-Notizbuch öffnen, Ihre Bilder hochladen und mit dem Training des Modells beginnen. Das alles geht ziemlich schnell.

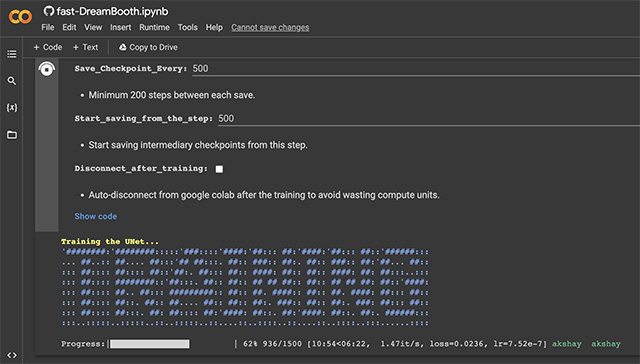

Okay, seien wir fair, das Text-Encoder-Training erfolgt recht schnell, innerhalb von 5 Minuten. Das Training des UNet mit den auf die Standardeinstellungen eingestellten Parametern dauert jedoch ziemlich lange – etwa 15 bis 20 Minuten. Wenn man jedoch bedenkt, dass wir tatsächlich ein KI-Modell trainieren, um mein Gesicht zu erkennen und zu zeichnen, klingen 20 Minuten nicht nach viel Zeit.

Während des Trainings gibt es eine Reihe von Möglichkeiten, wie Sie anpassen können, wie stark Sie Ihr Modell trainieren möchten, und was ich durch die Lektüre der Erfahrungen vieler Leute im Internet verstanden habe, ist, dass es keine wirklich „Einheitslösung“ gibt. Alle“-Strategie hier. Für grundlegende Anwendungsfälle schienen die Standardwerte jedoch für die meisten Leute gut zu funktionieren, und ich blieb auch dabei. Teilweise, weil ich nicht wirklich verstehen konnte, was die meisten Dinge bedeuteten, und teilweise, weil ich einfach keine Lust hatte, mehrere Modelle mit unterschiedlichen Trainingsparametern zu trainieren, um herauszufinden, was zu den besten Ergebnissen führte.

Schließlich war ich einfach auf der Suche nach einem lustigen KI-Bildgenerator, der ein paar halbwegs anständige Bilder von mir machen kann.

Übertrifft die Erwartungen

Ich bin keineswegs ein KI-Experte. Ich verstehe jedoch, dass das Training eines Stable-Diffusion-Modells auf einem Google Colab-Notebook mit 8 auf 512 x 512 Pixel zugeschnittenen JPEGs von mir nicht wirklich zu etwas Außergewöhnlichem führen wird.

Wie sehr ich mich geirrt habe.

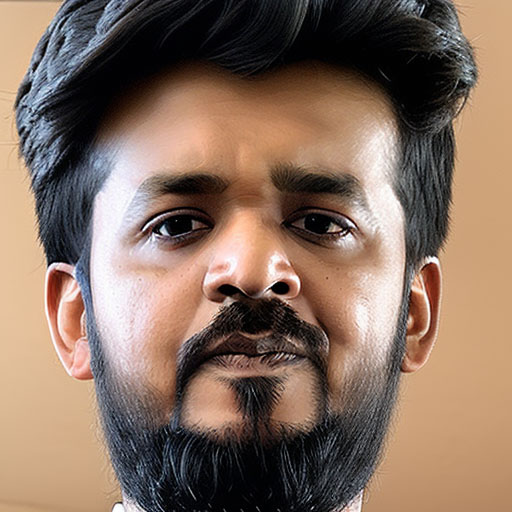

Bei meinem ersten Versuch, das von mir trainierte Modell zu verwenden, begann ich mit einer einfachen Eingabeaufforderung mit der Aufschrift „akshay“. Das Folgende ist das Bild, das generiert wurde.

Nicht großartig, oder? Aber so schlimm ist es doch auch nicht, oder?

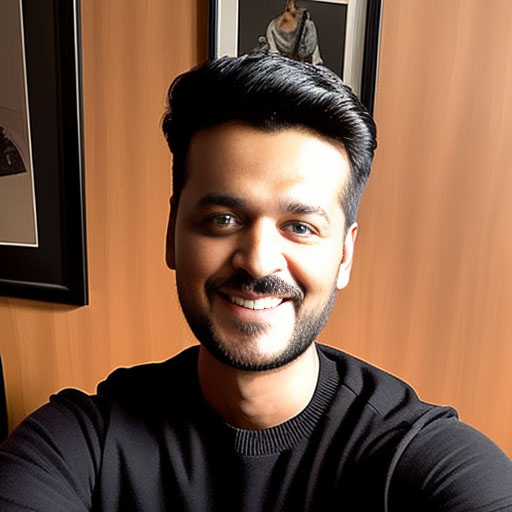

Aber dann begann ich, mit einigen der in der Benutzeroberfläche verfügbaren Parameter herumzuspielen. Es gibt mehrere Stichprobenmethoden, Stichprobenschritte, CFG-Skala, Skripte und vieles mehr. Zeit, etwas verrückt zu werden und mit verschiedenen Eingabeaufforderungen und Einstellungen für das Modell zu experimentieren.

Offensichtlich sind die Ergebnisse dieser Bilder nicht perfekt, und jeder, der mich gesehen hat, kann wahrscheinlich erkennen, dass es sich nicht um „meine“ Bilder handelt. Sie sind jedoch nah genug dran; und ich habe das Modell nicht einmal besonders sorgfältig trainiert.

Wenn ich den unzähligen Leitfäden auf Reddit und anderswo im Internet folgen würde, die darüber sprechen, wie man mit Dreambooth und Stable Diffusion das Training verbessern und bessere Ergebnisse erzielen kann, wären diese Bilder vielleicht noch realistischer (und wohl auch beängstigender) ausgefallen.

Dieser KI-Bildgenerator ist erschreckend gut

Sehen Sie, ich bin voll und ganz für Verbesserungen in der KI-Technologie. Als Technikjournalist habe ich in den letzten Jahren den sich ständig verändernden und sich verbessernden Bereich der verbraucherorientierten KI verfolgt und bin größtenteils zutiefst beeindruckt und optimistisch.

Wenn ich jedoch so etwas wie Dreambooth in Aktion sehe, wundere ich mich über die unethische Art und Weise, wie KI- und ML-basierte Tools praktisch jedem zugänglich sind, der Zugang zu einem Computer und dem Internet hat.

Es besteht kein Zweifel, dass es auf der Welt viele schlechte Schauspieler gibt. Zwar gibt es durchaus harmlose Anwendungsfälle für solch leicht zugängliche Technologie, aber wenn ich in den Jahren meiner Berichterstattung über Technologie eines gelernt habe, dann ist es, dass es zweifellos zu vielen unerwünschten Ergebnissen führen wird, wenn ein Produkt in die Hände von Millionen von Menschen gelangt . Bestenfalls etwas Unerwartetes und schlimmstenfalls etwas geradezu Ekelhaftes.

Die Möglichkeit zu haben, Deepfake-Bilder von so ziemlich allem zu erstellen irgendjemand Solange Sie 5 bis 10 Bilder ihres Gesichts zur Verfügung haben, ist es bei falscher Verwendung äußerst gefährlich. Denken Sie an Fehlinformationen, falsche Darstellungen und sogar Rachepornos – Deepfakes können auf all diese problematischen Arten eingesetzt werden.

Absicherungen? Welche Sicherheitsvorkehrungen?

Es ist auch nicht nur Dreambooth. An sich und bei guter Anwendung sind Dreambooth und Stable Diffusion unglaubliche Werkzeuge, mit denen wir erleben können, was KI leisten kann. Nach meinen bisherigen Erfahrungen gibt es jedoch keine wirklichen Schutzmaßnahmen für diese Technologie. Sicherlich können Sie damit keine völlige Nacktheit in Bildern erzeugen. zumindest standardmäßig. Es gibt jedoch zahlreiche Erweiterungen, mit denen Sie diesen Filter auch umgehen und so ziemlich alles erstellen können, was Sie sich vorstellen können, basierend auf der Identität einer beliebigen Person.

Selbst ohne solche Erweiterungen können Sie mit solchen Tools problemlos eine Vielzahl potenziell verstörender und anrüchiger Bilder von Menschen erstellen.

Darüber hinaus kann man mit einem einigermaßen leistungsstarken PC seine eigenen KI-Modelle ohne jegliche Sicherheitsvorkehrungen und auf der Grundlage der Trainingsdaten trainieren, die er verwenden möchte – was bedeutet, dass das trainierte Modell Bilder erzeugt, die unvorstellbar schädlich und schädlich sein können.

Deepfakes sind nichts Neues. Tatsächlich gibt es online eine riesige Fülle an Deepfake-Videos und -Medien. Allerdings war die Erstellung von Deepfakes bis in die jüngste Vergangenheit auf eine relativ kleine (wenn auch immer noch große) Anzahl von Personen beschränkt, die sich an der Schnittstelle zwischen „Personen mit leistungsfähiger Hardware“ und „technischem Know-how“ befanden.

Mit dem Zugang zu kostenlosen (begrenzt nutzbaren) GPU-Recheneinheiten bei Google Colab und der Verfügbarkeit von Tools wie Fast-Dreambooth, mit denen Sie KI-Modelle auf den Servern von Google trainieren und verwenden können, wird diese Zahl der Menschen exponentiell steigen. Das hat es wahrscheinlich schon – das macht mir Angst, und das sollte Ihnen auch Angst machen.

Was können wir tun?

Das ist die Frage, die wir uns an dieser Stelle stellen sollten. Tools wie DALL-E, Midjourney und ja, Dreambooth und Stable Diffusion sind sicherlich beeindruckend, wenn sie mit menschlichem Anstand verwendet werden. Die KI verbessert sich sprunghaft – das können Sie wahrscheinlich an der explosionsartigen Verbreitung von KI-bezogenen Nachrichten in den letzten Monaten erkennen.

Dies ist also ein entscheidender Punkt, an dem wir Wege finden müssen, um sicherzustellen, dass KI ethisch eingesetzt wird. Wie wir das bewerkstelligen können, ist eine Frage, auf die ich keine Antwort weiß, aber ich weiß, dass ich, nachdem ich den schnellen Dreamambooth-KI-Bildgenerator verwendet und seine Fähigkeiten gesehen habe, Angst davor habe, wie gut er ist , ohne sich zu sehr anzustrengen.