ChatGPT ist in letzter Zeit alles, worüber jeder reden kann. Basierend auf den Sprachmodellen GPT 3 und GPT 3.5 (für Plus-Abonnenten) ist der KI-Chatbot in seinen Möglichkeiten sprunghaft gewachsen. Viele Menschen haben jedoch mit angehaltenem Atem auf ein verbessertes Modell gewartet, das neue Maßstäbe setzt. Nun, OpenAI hat dies nun mit GPT-4 Wirklichkeit werden lassen, seinem neuesten multimodalen LLM, das randvoll mit Verbesserungen und beispielloser KI-Technologie ist. Schauen Sie sich alle Details unten an!

GPT-4 ist multimodal und übertrifft 3.5

Das neu angekündigte GPT-4-Modell von OpenAI ist eine große Sache in der künstlichen Intelligenz. Das Wichtigste, was zu erwähnen ist, ist, dass GPT-4 ein ist großes multimodales Modell. Das bedeutet, dass es dazu in der Lage sein wird Akzeptieren Sie Bild- und Texteingaben ihm ein tieferes Verständnis zu vermitteln. OpenAI erwähnt, dass das neue Modell zwar in vielen realen Szenarien weniger leistungsfähig als Menschen ist, auf verschiedenen Ebenen jedoch dennoch eine Leistung auf menschlicher Ebene aufweisen kann.

GPT-4 gilt außerdem als zuverlässigeres, kreativeres und effizienteres Modell als sein Vorgänger GPT-3.5. Zum Beispiel: Das neue Modell konnte eine simulierte Anwaltsprüfung mit einer Punktzahl von ungefähr den besten 10 % der Testteilnehmer bestehen (~90 Perzentil), während GPT 3,5 bei den unteren 10 % landete. GPT-4 ist auch in der Lage, differenziertere Anweisungen zu verarbeiten als das 3.5-Modell. OpenAI verglich beide Modelle in verschiedenen Benchmarks und Prüfungen und GPT-4 schnitt am besten ab. Schauen Sie sich hier all die coolen Dinge an, die ChatGPT tun kann.

GPT-4 und visuelle Eingaben

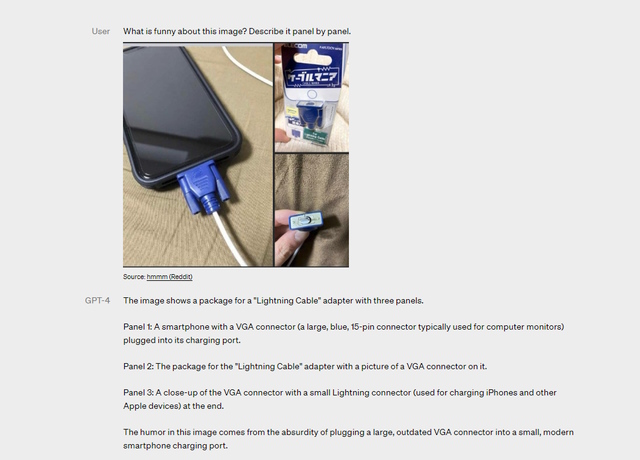

Wie oben erwähnt, kann das neue Modell Werbung sowohl für Text als auch für Bilder akzeptieren. Im Vergleich zu einer eingeschränkten Texteingabe GPT-4 wird beim Verstehen von Eingaben viel besser abschneiden die sowohl Text als auch Bilder enthalten. Die visuellen Eingaben bleiben in verschiedenen Dokumenten konsistent, einschließlich Texten und Fotos, Diagrammen und sogar Screenshots.

OpenAI demonstrierte dasselbe, indem es GPT-4 mit einem Bild und einer Textaufforderung fütterte, in der es aufgefordert wurde, zu beschreiben, was an dem Bild lustig ist. Wie oben zu sehen ist, konnte das Modell erfolgreich ein zufälliges Bild von Reddit lesen und auf die vom Benutzer gestellte Eingabeaufforderung antworten. Anschließend konnte das humorvolle Element identifiziert werden. Die Bildeingaben von GPT-4 sind jedoch immer noch nicht öffentlich verfügbar und stellen eine Forschungsvorschau dar.

Anfällig für Halluzinationen und begrenzte Daten

Obwohl GPT-4 im Vergleich zur vorherigen Version einen großen Fortschritt darstellt, bestehen immer noch einige Probleme. Zunächst erwähnt OpenAI, dass dies immer noch der Fall ist nicht völlig zuverlässig und neigt zu Halluzinationen. Dies bedeutet, dass die KI Denkfehler machen wird und ihre Ergebnisse mit großer Sorgfalt und unter menschlichem Eingreifen erfolgen sollten. Es könnte auch sein getrost falsch in seinen Vorhersagen, was zu Fehlern führen kann. Allerdings reduziert GPT-4 im Vergleich zu früheren Modellen die Halluzination. Um genau zu sein, die Das neue Modell erzielt eine um 40 % höhere Punktzahl als GPT-3.5 in die Unternehmensbewertungen ein.

Ein weiterer Nachteil, von dem viele hofften, dass er mit GPT-4 behoben werden würde, ist der begrenzte Datensatz. Leider GPT-4 Es fehlen noch Kenntnisse über Ereignisse, die nach September 2021 stattgefunden habenwas enttäuschend ist. Es lernt auch nicht aus seinen Erfahrungen, was zu den oben erwähnten Denkfehlern führt. Darüber hinaus kann GPT-4 an schwierigen Problemen scheitern, genau wie Menschen, einschließlich Sicherheitslücken. Aber es besteht kein Grund zur Sorge, da Microsoft Bing AI das GPT-4-Modell verwendet. Ja, Sie können das neue KI-Modell mit der Unterstützung von Echtzeit-Internetdaten auf Bing ausprobieren. In diesem Artikel erfahren Sie, wie Sie in jedem Browser auf den Bing AI-Chat zugreifen können – nicht nur auf Edge.

Greifen Sie mit ChatGPT Plus auf GPT-4 zu

GPT-4 ist verfügbar für ChatGPT Plus-Abonnenten mit Nutzungsbeschränkung. OpenAI erwähnt, dass es die genaue Nutzungsobergrenze je nach Bedarf und Systemleistung anpassen wird. Darüber hinaus könnte das Unternehmen sogar eine „neue Abonnementstufe“ für die GPT-4-Nutzung mit höherem Volumen einführen. Kostenlose Benutzer hingegen müssen warten, da das Unternehmen keine konkreten Pläne erwähnt hat und nur „Hoffnungen‚, dass es denjenigen ohne Abonnement eine gewisse Anzahl kostenloser GPT-4-Abfragen anbieten kann.

So wie es aussieht, wird sich GPT-4 zu einem entwickeln äußerst ansprechendes Sprachmodell sogar mit einigen Rissen in der Panzerung. Für diejenigen, die noch detailliertere Informationen suchen: Wir haben bereits etwas in Arbeit. Bleiben Sie also dran für mehr.

![[VÍDEO] Sie können jetzt per Sprache mit ChatGPT sprechen [VÍDEO] Sie können jetzt per Sprache mit ChatGPT sprechen](https://static.futuriq.de/uploads/2023/10/VIDEO-Sie-koennen-jetzt-per-Sprache-mit-ChatGPT-sprechen-180x135.png)