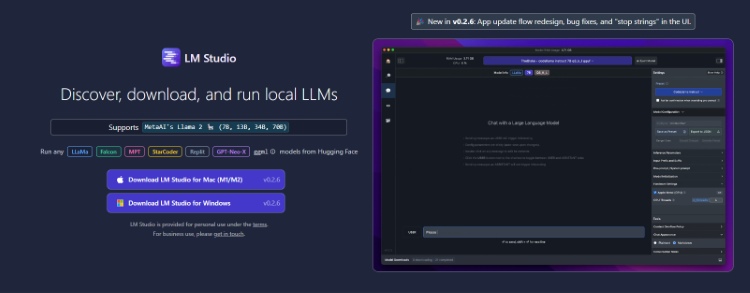

Derzeit gibt es mehrere KI-Player auf dem Markt, darunter ChatGPT, Google Bard, Bing AI Chat und viele mehr. Bei allen ist jedoch eine Internetverbindung erforderlich, um mit der KI interagieren zu können. Was wäre, wenn Sie ein ähnliches Large Language Model (LLM) auf Ihrem Computer installieren und lokal verwenden möchten? Ein KI-Chatbot, den Sie privat und ohne Internetverbindung nutzen können. Nun, mit neuen GUI-Desktop-Apps wie LM Studio und GPT4All können Sie ein ChatGPT-ähnliches LLM mühelos offline auf Ihrem Computer ausführen. In diesem Sinne lernen wir nun, wie man ein LLM lokal ohne Internetverbindung nutzt.

Führen Sie ein lokales LLM mit LM Studio auf PC und Mac aus

1. Machen Sie zunächst weiter und Laden Sie LM Studio herunter für Ihren PC oder Mac von Hier.

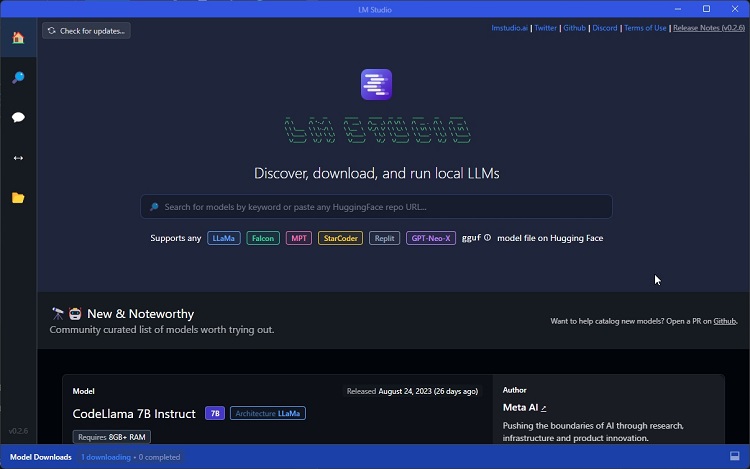

2. Führen Sie als Nächstes das aus Setup-Datei und LM Studio wird geöffnet.

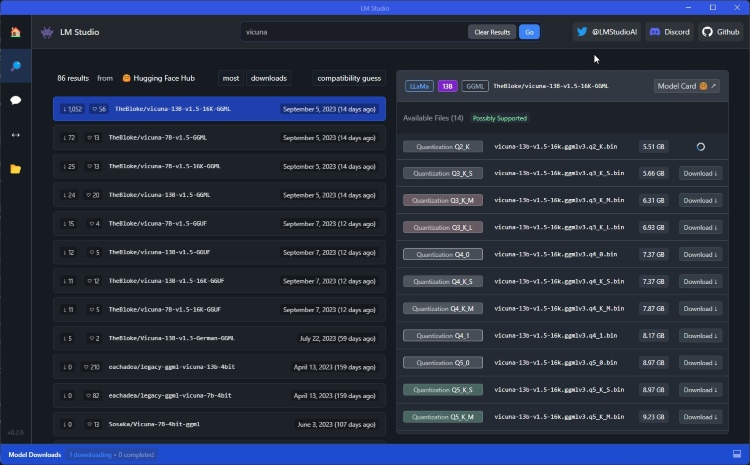

3. Gehen Sie als Nächstes zur Registerkarte „Suchen“ und Finden Sie das LLM Sie installieren möchten. Die besten Open-Source-KI-Modelle finden Sie in unserer Liste. Sie können auch weitere Modelle von erkunden Umarmendes Gesicht Und AlpakaEval Bestenliste.

4. Ich lade das herunter Vicuna-Modell mit 13B Parametern. Abhängig von den Ressourcen Ihres Computers können Sie noch leistungsfähigere Modelle herunterladen. Sie können auch codierungsspezifische Modelle wie StarCoder und WizardCoder herunterladen.

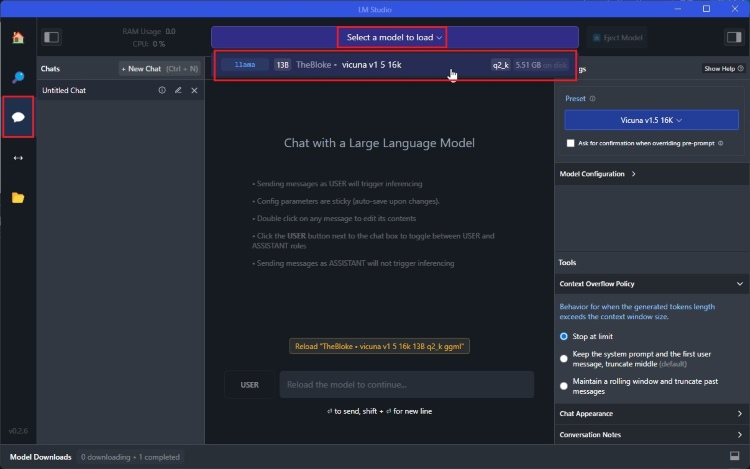

5. Sobald das LLM-Modell installiert ist, gehen Sie zu „Chatten”-Registerkarte im linken Menü.

6. Klicken Sie hier auf „Wählen Sie ein Modell zum Laden aus” und wählen Sie das heruntergeladene Modell aus.

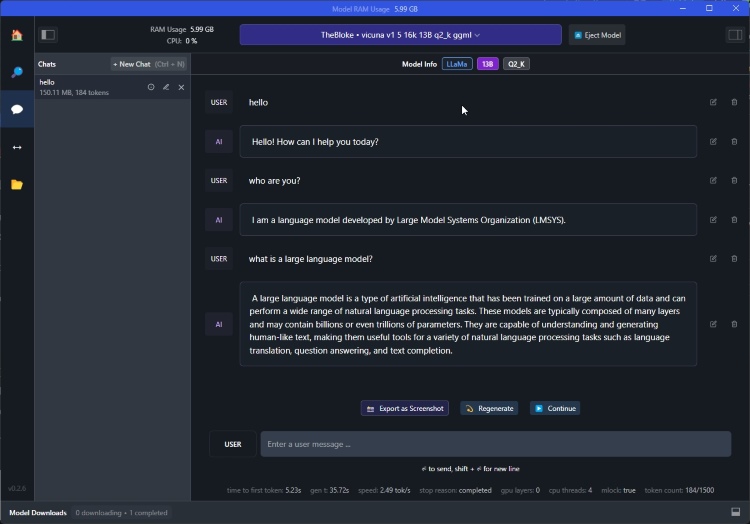

7. Jetzt können Sie Beginnen Sie mit dem KI-Modell zu chatten sofort lokal die Ressourcen Ihres Computers nutzen. Alle Ihre Chats sind privat und Sie können LM Studio auch im Offline-Modus verwenden.

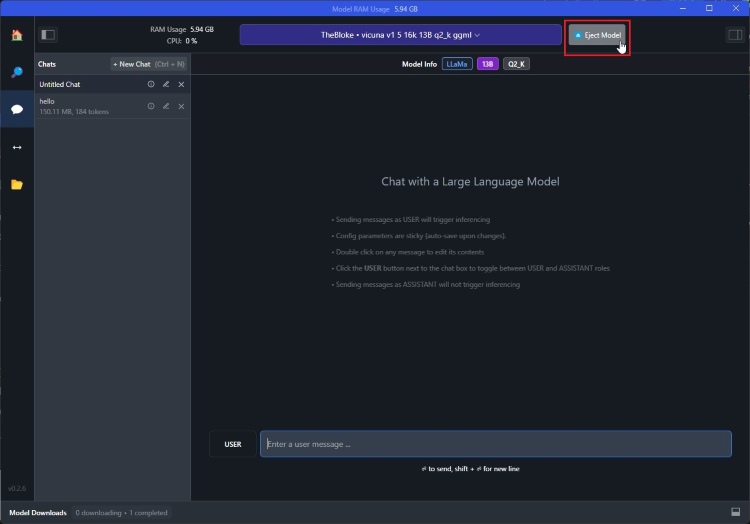

8. Sobald Sie fertig sind, können Sie auf „Modell auswerfen” wodurch das Modell aus dem RAM entlastet wird.

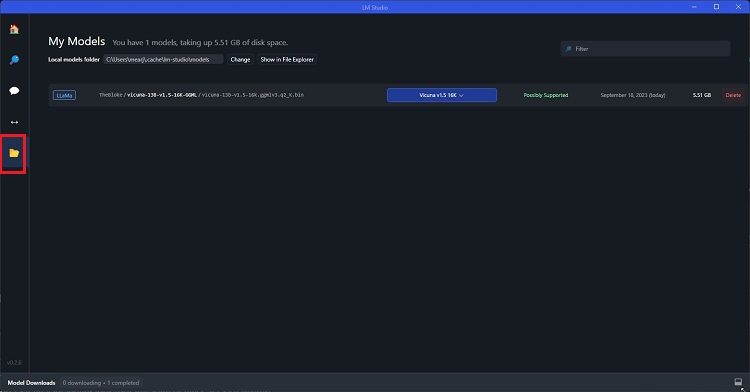

9. Sie können auch zur Registerkarte „Modelle“ wechseln und Verwalten Sie alle Ihre heruntergeladenen Modelle. So können Sie ein ChatGPT-ähnliches LLM lokal auf Ihrem Computer ausführen.

Führen Sie mit GPT4All ein lokales LLM auf PC, Mac und Linux aus

GPT4All ist eine weitere Desktop-GUI-App, mit der Sie ein ChatGPT-ähnliches LLM lokal und privat auf Ihrem Computer ausführen können. Das Beste an GPT4All ist, dass es nicht einmal eine dedizierte GPU erfordert und Sie Ihre Dokumente auch hochladen können, um das Modell lokal zu trainieren. Es ist keine API oder Codierung erforderlich. Das ist großartig, oder? Lassen Sie uns also weitermachen und herausfinden, wie Sie GPT4All lokal verwenden können.

1. Machen Sie weiter und Laden Sie GPT4All herunter aus Hier. Es unterstützt Windows-, macOS- und Ubuntu-Plattformen.

2. Als nächstes Führen Sie das Installationsprogramm aus Außerdem werden während der Installation einige zusätzliche Pakete heruntergeladen.

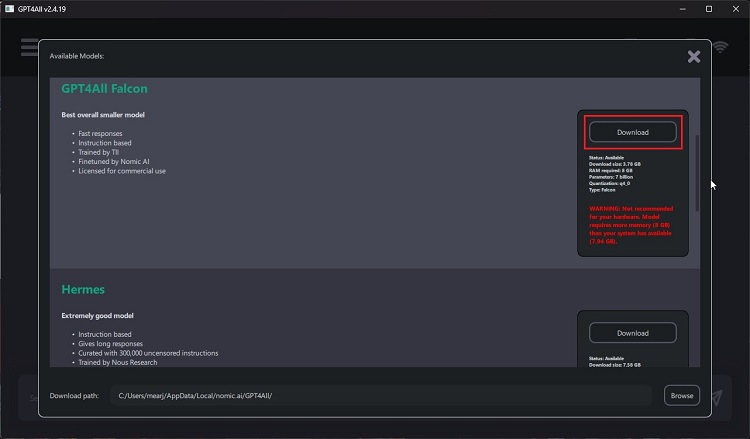

3. Laden Sie anschließend eines der Modelle herunter, basierend auf den Ressourcen Ihres Computers. Um eines der AI-Modelle verwenden zu können, müssen Sie über mindestens 8 GB RAM verfügen.

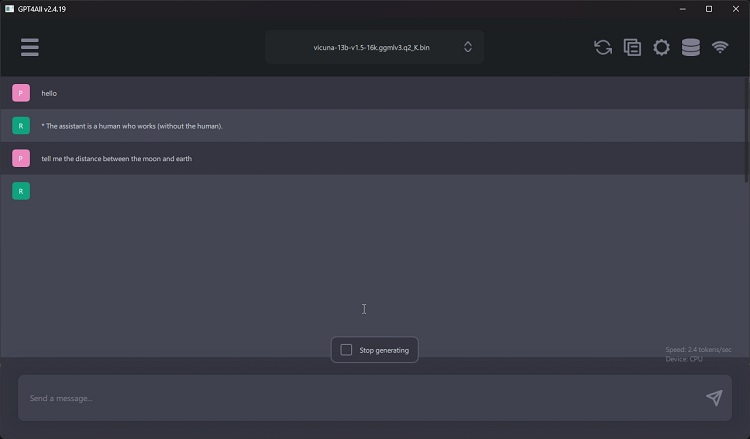

4. Jetzt können Sie einfach mit dem Chatten beginnen. Aufgrund des geringen Speichers bin ich auf einige gestoßen Leistungsprobleme und GPT4All funktionierte auf halbem Weg nicht mehr. Wenn Sie jedoch einen Computer mit leistungsstarken Spezifikationen haben, würde er viel besser funktionieren.

Anmerkung des Herausgebers: Zuvor enthielt dieser Leitfaden den Schritt-für-Schritt-Prozess zur Offline-Einrichtung von LLaMA und Alpaca auf PCs, wir haben jedoch einen ziemlich langwierigen Prozess aufgenommen. Dieser Prozess wurde durch die oben vorgeschlagenen Tools vereinfacht.