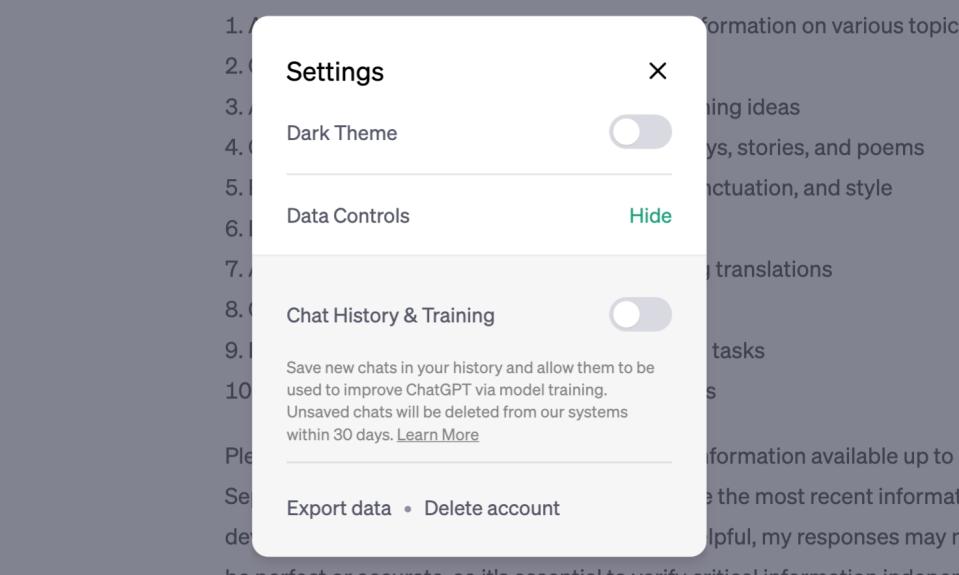

OpenAI beginnt endlich, eines der am meisten geschmähten Datensicherheitsprobleme aller Zeiten anzugehen. ChatGPT-Benutzer können jetzt den Chat-Verlauf schließen, um zu verhindern, dass die von ihnen eingegebenen Daten zum Trainieren des KI-Modells von ChatGPT verwendet werden. Entsprechende Einstellungen finden Sie unter „Datensteuerelemente“ in „Einstellungen“, einschließlich eines Schalters für „Chat-Verlauf und Training“ sowie Optionen zum Exportieren von Daten und zum Löschen von Konten.

Aber selbst wenn Verlauf und Training ausgeschaltet sind, speichert OpenAI Ihre Eingaben noch 30 Tage lang. Laut OpenAI soll dies Missbrauch vermeiden und diese Eingaben nur überprüfen, wenn eine regulatorische Notwendigkeit besteht. Nach 30 Tagen wird Ihre Eingabe dauerhaft entfernt. Was die Option zur Datenausgabe betrifft, ermöglicht sie es Ihnen nicht nur, Aufzeichnungen zu führen, sondern ermöglicht es den Benutzern auch, klarer zu verstehen, welche Daten ChatGPT gesammelt hat.

Zusätzlich zu dieser Kontrolle wird OpenAI dem bestehenden ChatGPT Plus auch eine „ChatGPT Business“-Abonnementebene hinzufügen. Diese Ebene richtet sich an „Fachleute, die eine genauere Datenkontrolle benötigen“ und „Unternehmen, die den Einsatz von Mitarbeitern besser verwalten möchten.“ Standardmäßig werden Daten nicht für Schulungen verwendet. Diese neue Abonnementstufe wird „in den kommenden Monaten“ live gehen.

Anfang dieses Monats machten drei Samsung-Mitarbeiter die Nachricht, dass sie vertrauliche Informationen an ChatGPT „durchsickern“ ließen, und hoben auch die Probleme der Datenkontrolle bei der Verwendung von Chatbots hervor, insbesondere Unternehmensgeheimnisse. Auch die Änderung von ChatGPT kann diesmal als Reaktion auf ähnliche Situationen gewertet werden.