Hallo zusammen, ich bin Bittao. Wenn es im Jahr 2023 etwas Heißes gibt, dann ist es zweifellos die von chatgpt angeführte KI-Welle. Egal, ob es sich um die verschiedenen Medien an Wochentagen, die Projekte, mit denen Sie bei der Arbeit in Kontakt kommen, oder die aktuellen Themen, die jeder in Ihrem Leben diskutiert, handelt, KI ist in diesem Jahr untrennbar miteinander verbunden. Tatsächlich erfreut es sich in der Internetbranche seit dem Aufkommen von Deep Learning großer Beliebtheit. Da jedoch die am weitesten verbreitete KI im Hinblick auf die Monetarisierungsfähigkeit der Empfehlungsalgorithmus ist, ist das Wort KI in der breiten Öffentlichkeit auch etwas langweilig. ChatGPT wurde jedoch im November 2022 geboren und durchbrach innerhalb von nur zwei Monaten schnell den Kreis, wobei die monatlich aktiven Nutzer 100 Millionen erreichten und sich zum weltweit führenden Produkt entwickelten. Einige Leute sagen, dass dies die Einzigartigkeit der KI-Technologie ist und dass KI bald mehr Arbeitsplätze ersetzen kann; andere sagen, dass es immer Klischees geben wird, nur ein intelligenterer Chat-Roboter. Unbestreitbar ist jedenfalls, dass künstliche Intelligenz der Beginn der nächsten technologischen Revolution ist.Die KI wird den Menschen nicht eliminieren, die KI wird nur die Menschen eliminieren, die keine KI nutzen können.

Inhaltsverzeichnis

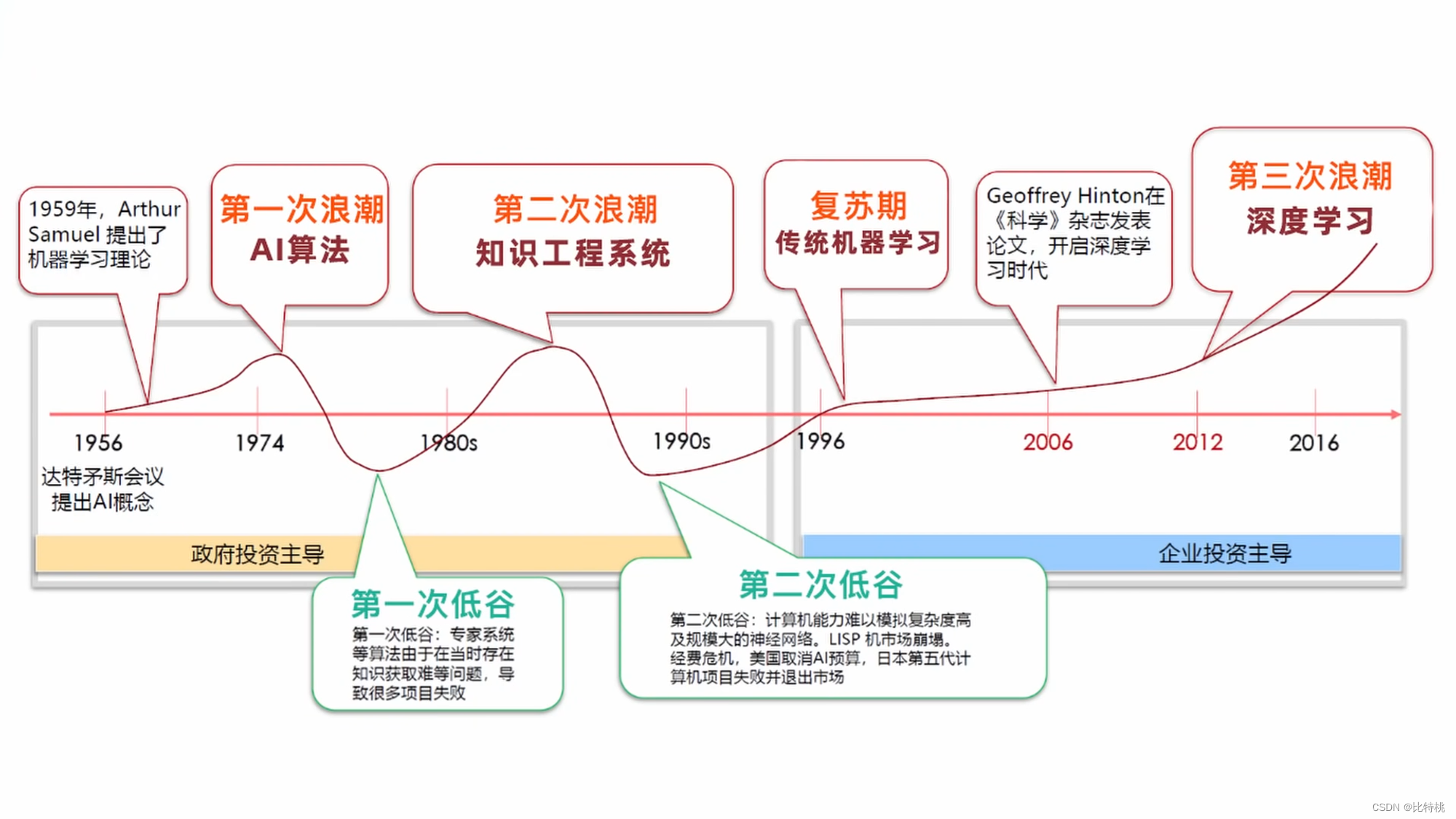

Obwohl KI schon lange nicht mehr im Fokus der Öffentlichkeit steht, haben sich entsprechende Theorien bereits im letzten Jahrhundert herausgebildet.

- Im Jahr 1940 beschrieb die Kybernetik die interdisziplinäre Untersuchung der Erforschung von Regulierungssystemen, mit der die Struktur, Grenzen und Entwicklung von Kontrollsystemen untersucht werden. Dabei handelt es sich um die wissenschaftliche Untersuchung, wie Menschen, Tiere und Maschinen einander steuern und miteinander kommunizieren.

- Im Jahr 1943 schlugen die amerikanischen Neurowissenschaftler McCulloch und Pitts neuronale Netze vor und erstellten ein Modell namens MP-Modell.

- Im Jahr 1950, mit der Entwicklung der Informatik, Neurowissenschaften und Mathematik, veröffentlichte Turing einen Aufsatz, der die Ära kreuzte und einen sehr philosophischen Ansatz vorschlug

The Imitation GameAuch als Turing-Test bekannt. Die allgemeine Idee ist: Wenn beim Chatten zwischen einem Menschen und einer Maschine festgestellt werden kann, dass die andere Partei keine Maschine ist, spricht man vom Bestehen des Turing-Tests. - Im Jahr 1956 hielten Marvin Sky, John McCarthy und Claude Shannon (der Begründer der Informationstheorie) eine Konferenz ab: die Dartmouth-Konferenz. Die Hauptfrage ist, ob Menschen wie Menschen denken können, und das Wort KI tauchte auf.

- Im Jahr 1966 basierte der Chat-Roboter Eliza des MIT auf PatternMatching, einem Mustervergleich, der auf Regeln basierte.

- 1997 besiegte IBM Deep Blue den Schachweltmeister. Sinton von der University of Toronto führte den Backpropagation-Algorithmus BP in die künstliche Intelligenz ein; Yang Likun von der New York University, dessen berühmter Beitrag das Faltungs-Neuronale Netzwerk CNN ist; Bengio von der University of Montreal (neuronales Wahrscheinlichkeitssprachenmodell, Generierung konfrontativer Netzwerke).

- Im Jahr 2010 ein Bereich im maschinellen Lernen

Artificial Neural NetworksKünstliche neuronale Netze beginnen zu glänzen.

Die gemeinsame Aufgabe des maschinellen Lernens besteht darin, durch Trainingsalgorithmen automatisch die Gesetze hinter den Daten zu entdecken, das Modell kontinuierlich zu verbessern und dann Vorhersagen zu treffen. Beim maschinellen Lernen gibt es viele Algorithmen. Der klassischste Algorithmus ist:梯度下降算法. Es kann uns helfen, mit Klassifizierungs- und Regressionsproblemen umzugehen.passiereny=wx+bDiese Art der linearen Anpassung sorgt dafür, dass das Ergebnis nahe am korrekten Wert liegt.

2.1 Vorhersagefunktion

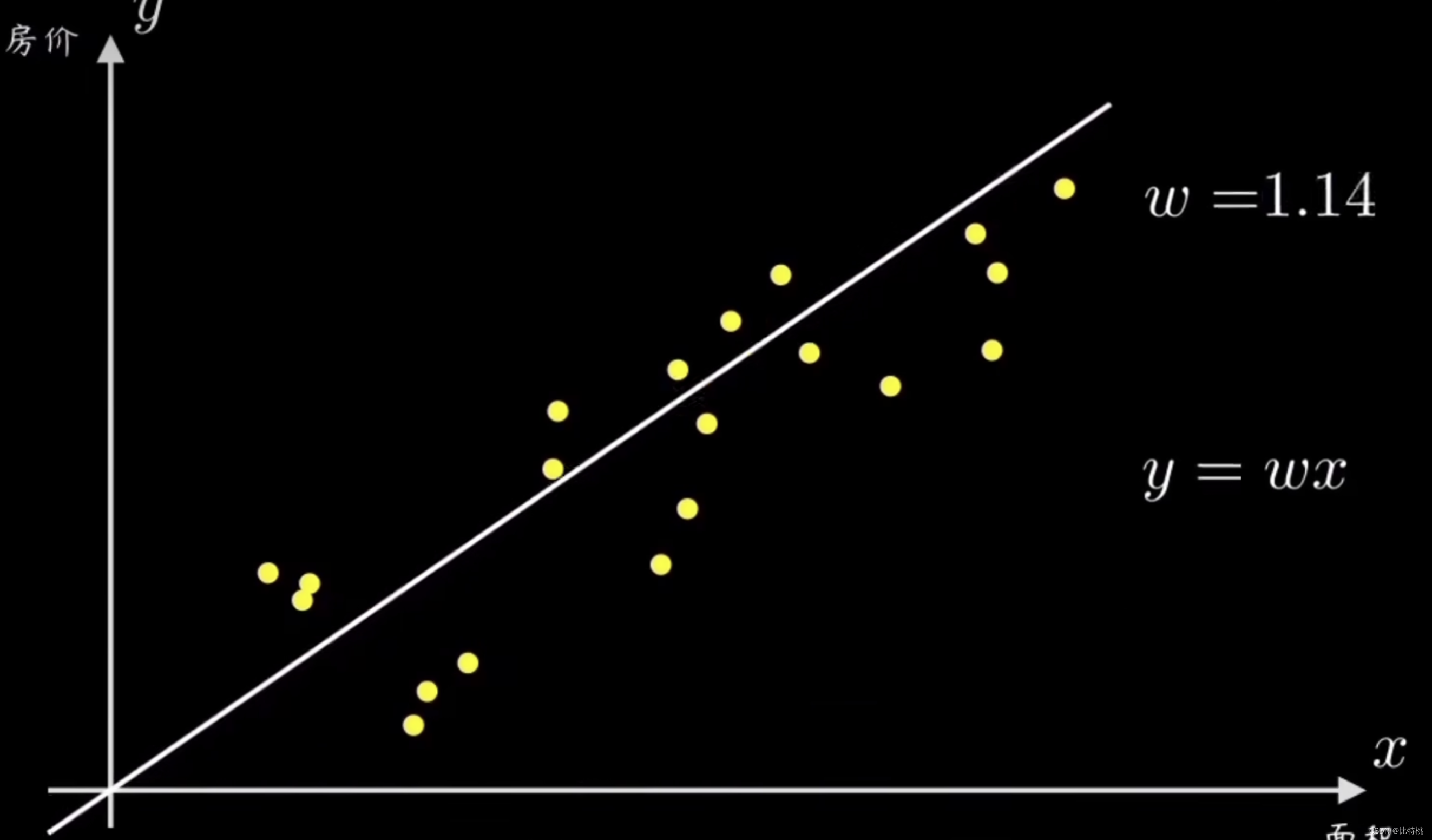

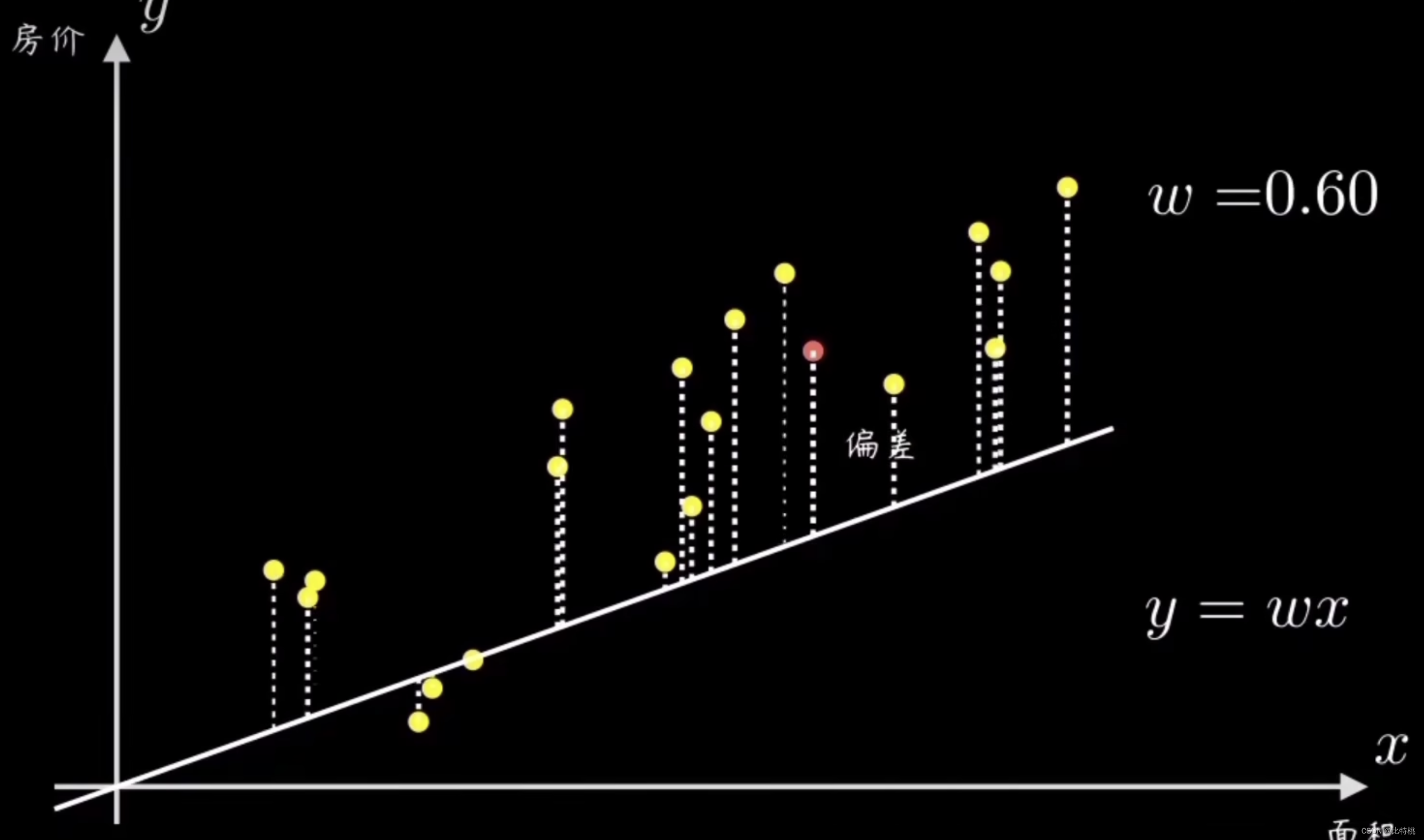

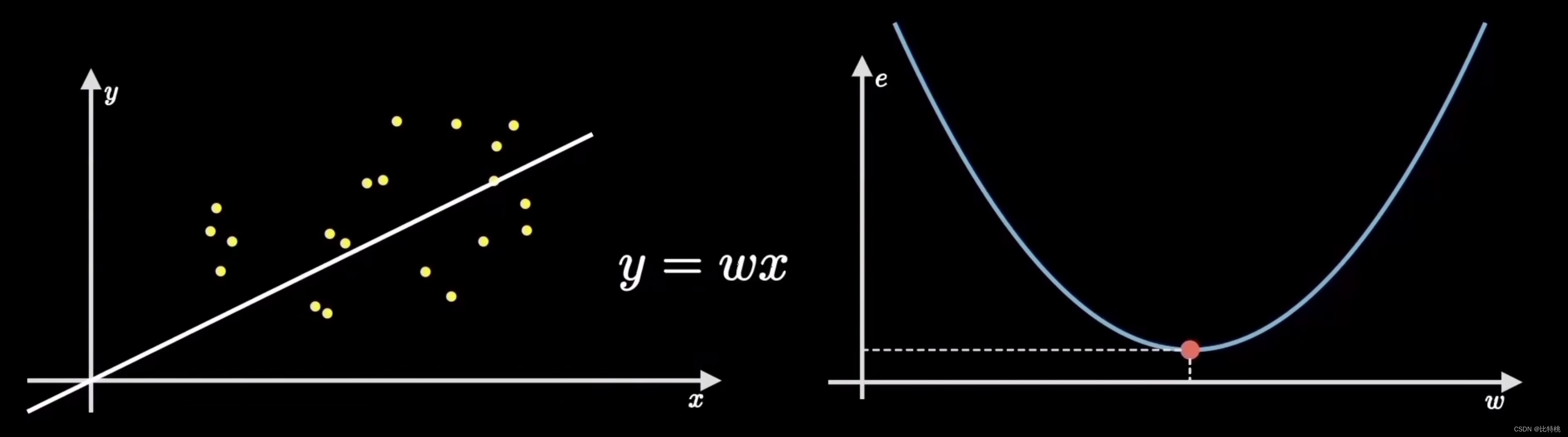

Angenommen, wir haben eine Reihe kausaler Stichprobenpunkte, von denen jeder eine Reihe kausaler Variablen darstellt. Zum Beispiel der Preis und die Fläche des Hauses, die Größe und das Tempo einer Person und so weiter. Der gesunde Menschenverstand sagt uns, dass ihre Verteilungen direkt proportional sind.Zunächst bestimmt der Gradientenabstiegsalgorithmus eine kleine Zielvorhersagefunktion, die eine gerade Linie durch den Ursprung ist y = wx. Unsere Aufgabe besteht darin, einen Algorithmus zu entwerfen, damit diese Maschine diese Daten anpassen und uns dabei helfen kann, den Parameter w der geraden Linie zu berechnen.

Eine einfache Möglichkeit besteht darin, zufällig eine gerade Linie auszuwählen, die durch den Ursprung verläuft, und dann alle Stichprobenpunkte und deren Abweichung zu berechnen. Passen Sie dann die Steigung w der Linie entsprechend der Größe des Fehlers an

Durch Anpassen der Parameter ist die Vorhersage umso genauer, je kleiner die Verlustfunktion wird.in diesem Beispiel

Eine einfache Möglichkeit besteht darin, zufällig eine gerade Linie auszuwählen, die durch den Ursprung verläuft, und dann alle Stichprobenpunkte und deren Abweichung zu berechnen. Passen Sie dann die Steigung w der Linie entsprechend der Größe des Fehlers an

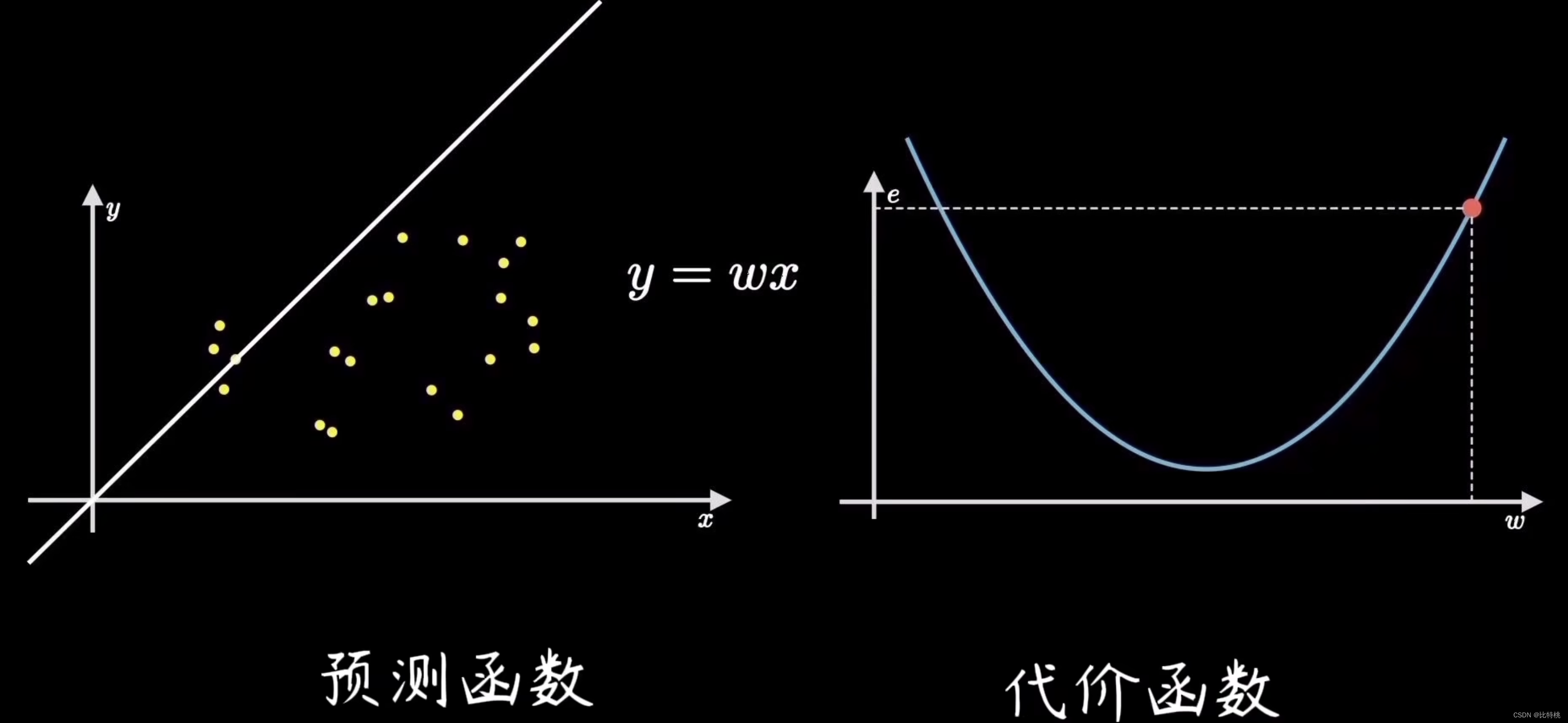

Durch Anpassen der Parameter ist die Vorhersage umso genauer, je kleiner die Verlustfunktion wird.in diesem Beispiel y = wx ist die sogenannte Vorhersagefunktion.

2.2 Kostenfunktion

Der Prozess zum Finden des Fehlers besteht darin, die Kostenfunktion zu berechnen. Durch Quantifizierung des Abweichungsgrads der Daten, also des Fehlers, wird am häufigsten der mittlere quadratische Fehler (der Durchschnitt der Summe der Fehlerquadrate) verwendet. Der Fehlerwert ist beispielsweise e, da der Koeffizient zum Finden des Fehlers die Formel der Summe der Quadrate ist. Daher ist das Funktionsbild von e auf der rechten Seite der folgenden Abbildung dargestellt. Wir werden feststellen, dass der Fehler in der linken Abbildung kleiner ist, wenn die Funktion von e am niedrigsten Punkt ist, was bedeutet, dass die Anpassung genauer ist.

2.3 Gradientenberechnung

Das Ziel des maschinellen Lernens besteht darin, die gerade Linie anzupassen, die der Trainingsdatenverteilung am nächsten kommt, d. h. die Parameter zu finden, die die Fehlerkosten minimieren, die dem niedrigsten Punkt der Kostenfunktion entsprechen.Dieser Vorgang des Findens des tiefsten Punktes wird aufgerufen梯度下降。

Die Verwendung des Gradientenabstiegsalgorithmus zum Trainieren dieses Parameters ist dem menschlichen Lern- und kognitiven Prozess sehr ähnlich. Piagets Theorie der kognitiven Entwicklung, der sogenannten Assimilation und Anpassung, ist genau dasselbe wie der Prozess des maschinellen Lernens.

Die Verwendung des Gradientenabstiegsalgorithmus zum Trainieren dieses Parameters ist dem menschlichen Lern- und kognitiven Prozess sehr ähnlich. Piagets Theorie der kognitiven Entwicklung, der sogenannten Assimilation und Anpassung, ist genau dasselbe wie der Prozess des maschinellen Lernens.

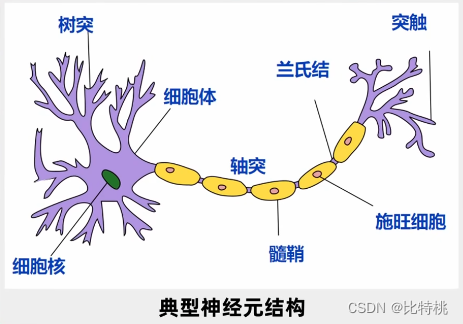

In der Anfangszeit gab es viele Kontroversen darüber, ob der KI-Algorithmus mit einer menschenähnlichen, gehirnähnlichen Operationsmethode implementiert werden sollte. Und bevor Deep Learning auf den Markt kam, widmeten sich die meisten Informatiker einer Forschungsrichtung, die dem Mustervergleich ähnelt. Nun scheint es, dass es mit dieser Methode natürlich sehr schwierig ist, Maschinen so intelligent wie Menschen zu machen. Aber wir können die Menschen von damals nicht aus der heutigen Perspektive betrachten. Damals waren Daten und Rechenleistung knapp, daher gab es natürlich eine Reihe von Theorien, die die Idee, ein menschenähnliches Wesen zu nutzen, widerlegten Gehirn, um es zu erreichen. Wie kann ein Computer nach dem gleichen Prinzip funktionieren wie ein menschliches Gehirn? Wir müssen immer noch traditionelle Algorithmen verwenden, um das Problem zu lösen. Dies führte indirekt auch zur damaligen Stagnation der KI. Für die Doktoranden, die diese Richtung studiert haben, ist die Realität grausam. Daher der Satz:Der menschliche Einsatz ist wichtig, aber es kommt auch auf die Richtung an。 Im Jahr 1943 erforschten Neurowissenschaftler das Funktionsprinzip des menschlichen Gehirns. Im menschlichen Gehirn sind mehr als 10 Milliarden Neuronen über ein Netzwerk miteinander verbunden, um Informationen zu beurteilen und zu übertragen.

Jedes Neuron hat mehrere Eingänge und einen einzigen Ausgang. Das Signal kann über mehrere Neuronen empfangen, umfassend verarbeitet und bei Bedarf stromabwärts ausgegeben werden. Dieser Ausgang hat nur zwei Signale, entweder 0 oder 1, sehr ähnlich einem Computer. Deshalb schlugen sie ein Modell namens MP-Modell vor.

Ein künstliches neuronales Netzwerk ist ein algorithmisches mathematisches Modell, das die Verhaltensmerkmale tierischer neuronaler Netzwerke nachahmt und eine verteilte parallele Informationsverarbeitung durchführt. Deep Learning ist ein Algorithmus, der künstliche neuronale Netze als Rahmen für das Repräsentationslernen von Daten verwendet.

Jedes Neuron hat mehrere Eingänge und einen einzigen Ausgang. Das Signal kann über mehrere Neuronen empfangen, umfassend verarbeitet und bei Bedarf stromabwärts ausgegeben werden. Dieser Ausgang hat nur zwei Signale, entweder 0 oder 1, sehr ähnlich einem Computer. Deshalb schlugen sie ein Modell namens MP-Modell vor.

Ein künstliches neuronales Netzwerk ist ein algorithmisches mathematisches Modell, das die Verhaltensmerkmale tierischer neuronaler Netzwerke nachahmt und eine verteilte parallele Informationsverarbeitung durchführt. Deep Learning ist ein Algorithmus, der künstliche neuronale Netze als Rahmen für das Repräsentationslernen von Daten verwendet.

3.1 Neuronales Netzwerk

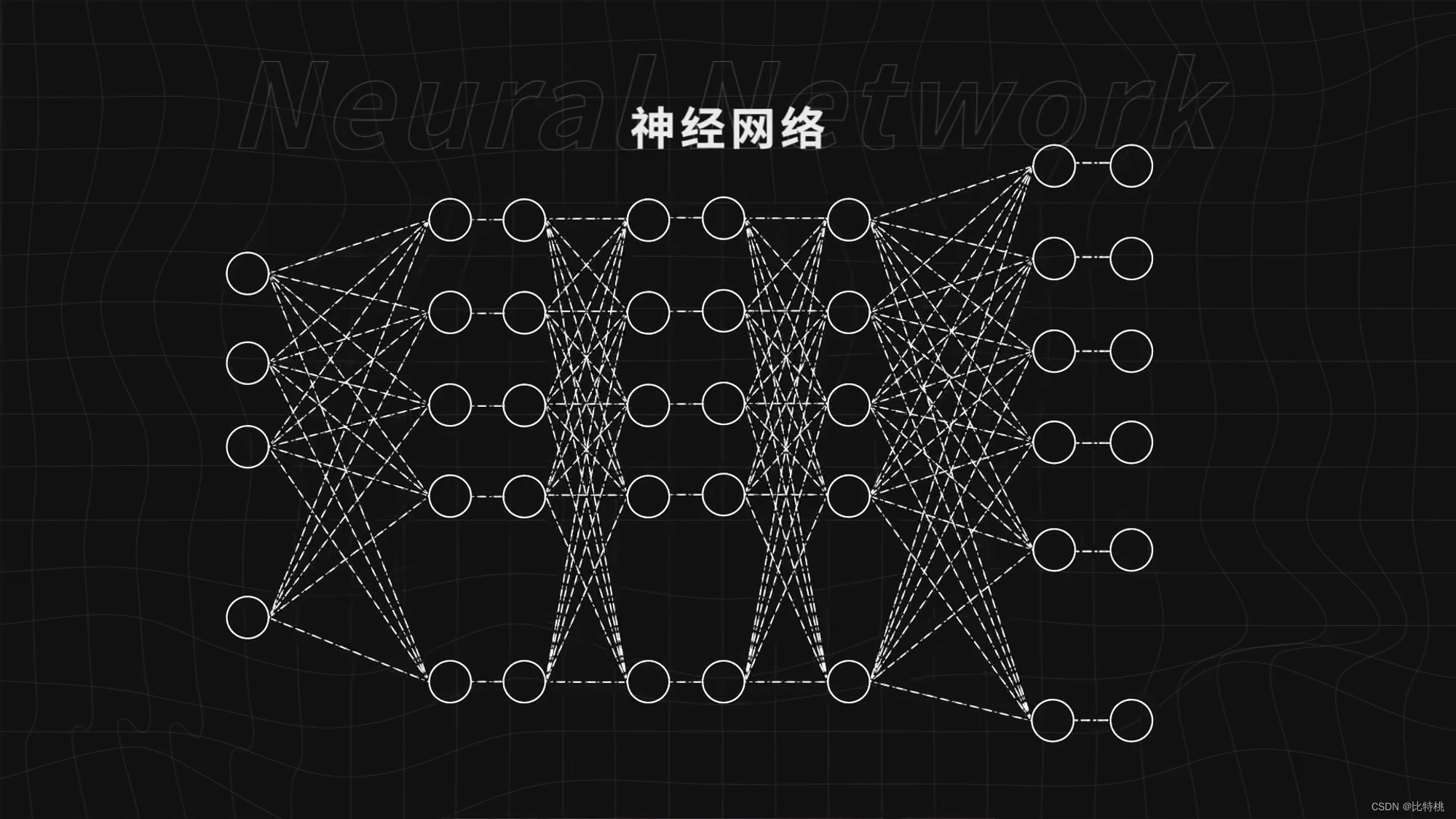

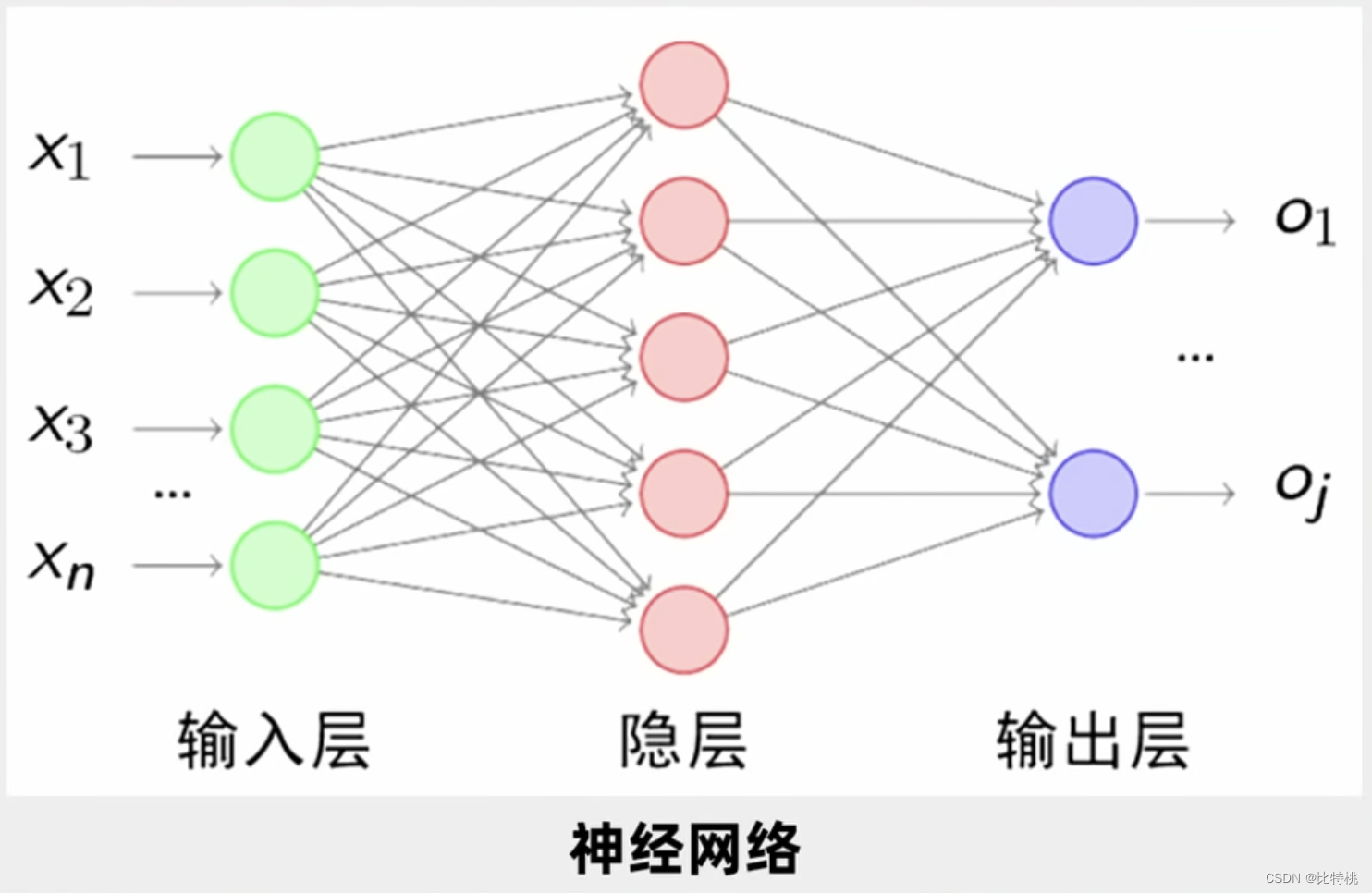

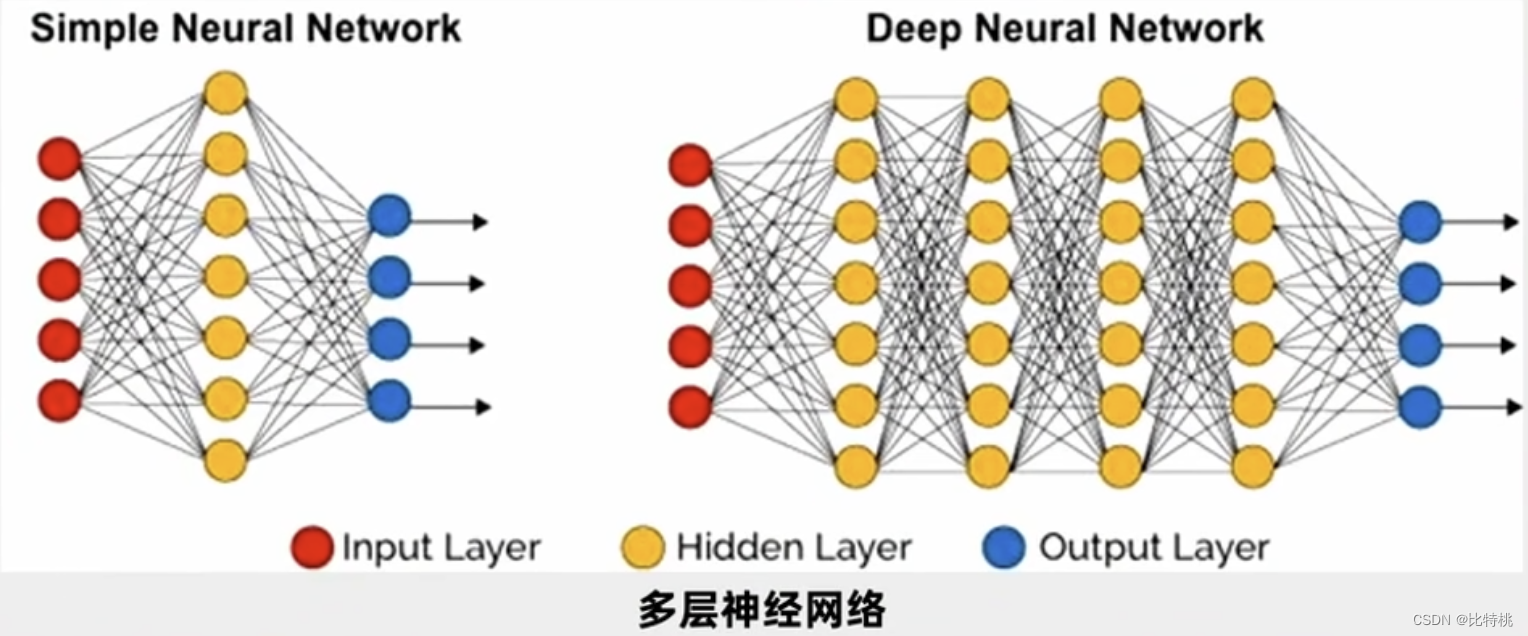

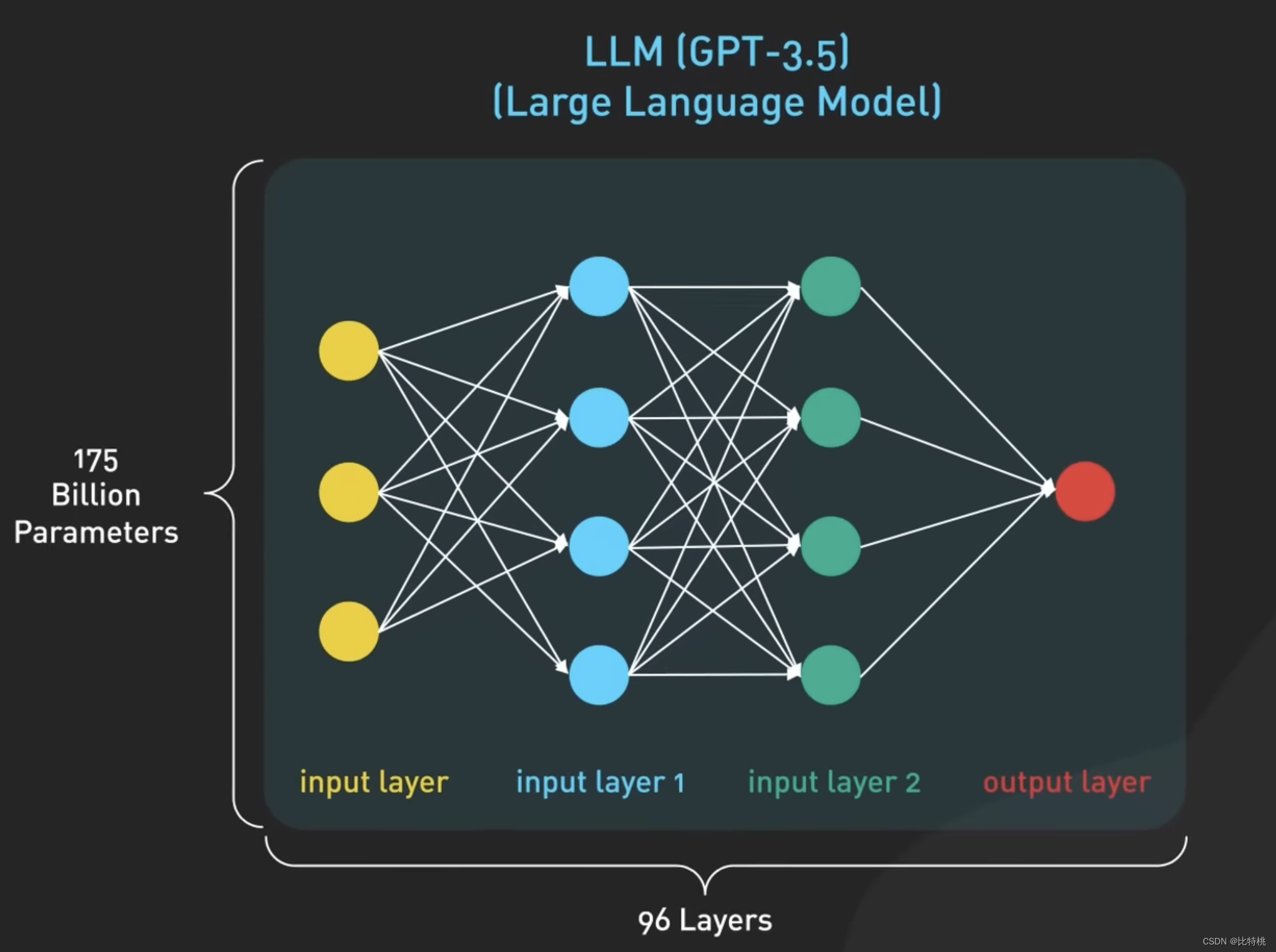

Wie in der folgenden Abbildung dargestellt, ist ein Kreis ein Neuron, und diese Kreise bilden ein neuronales Netzwerk. Geben Sie dem neuronalen Netzwerk genügend Daten, teilen Sie ihm mit, ob es gut läuft oder nicht, und trainieren Sie das neuronale Netzwerk weiter. Es kann immer besser werden und komplexe Aufgaben wie das Erkennen von Bildern erledigen.

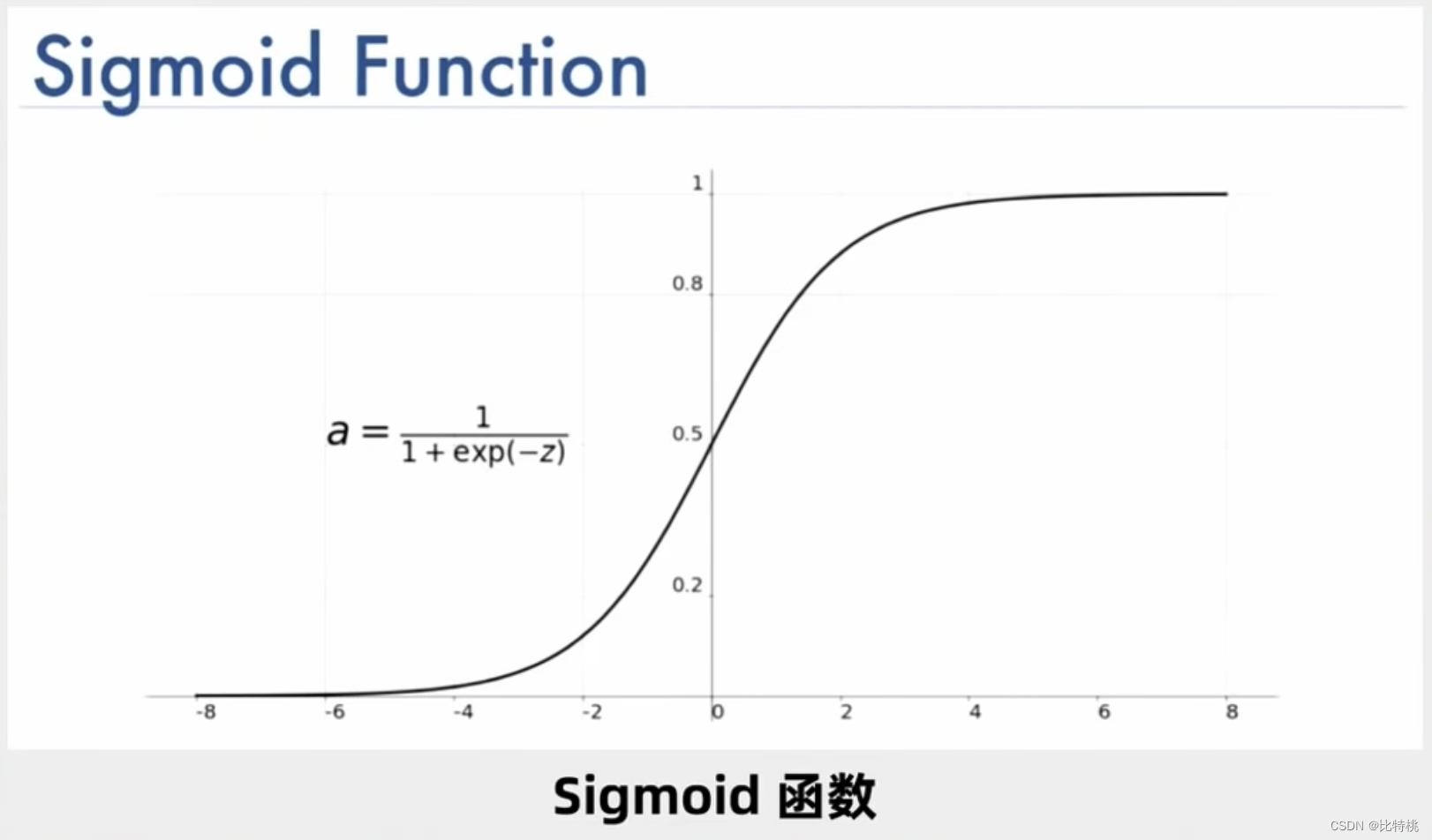

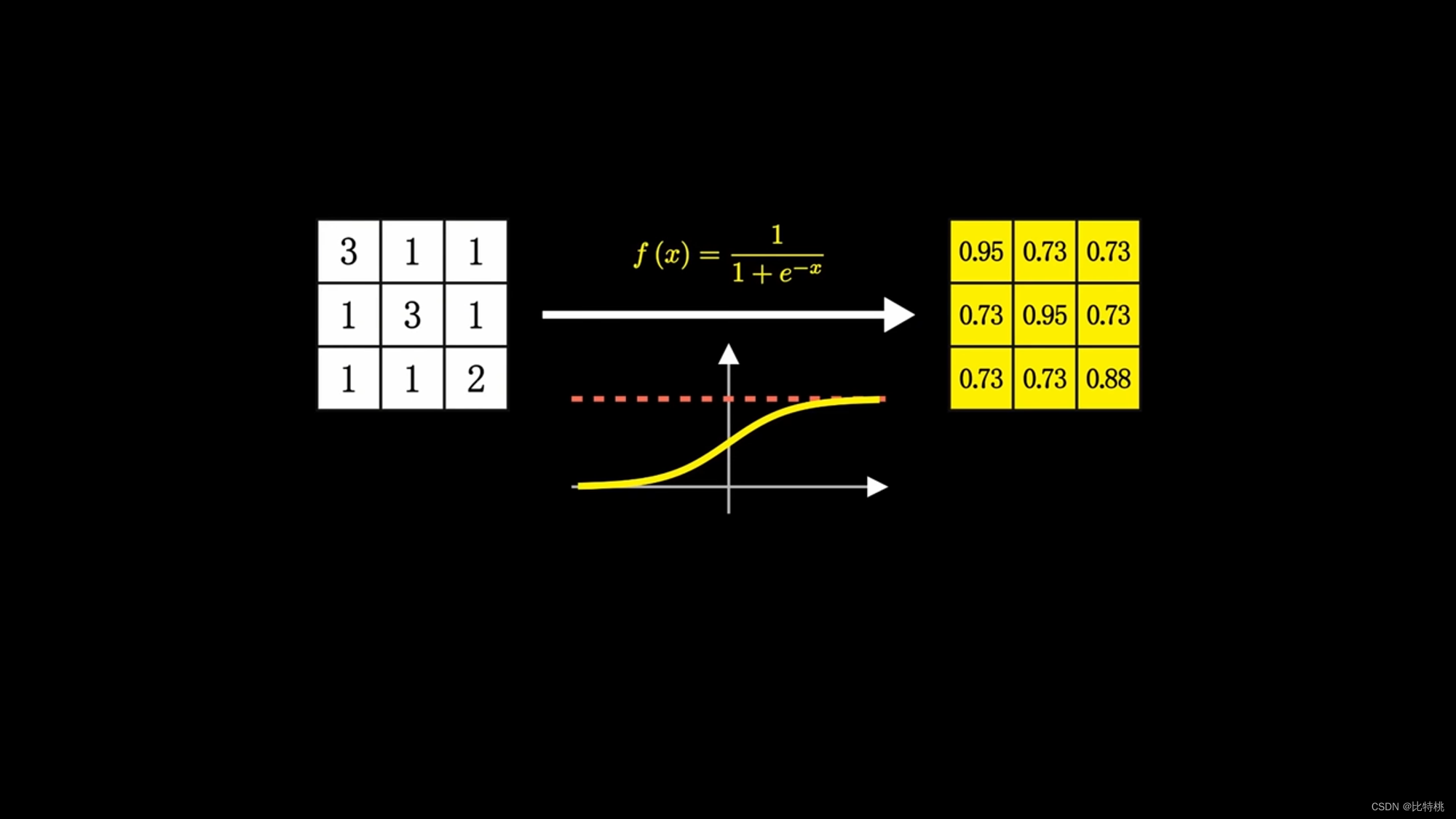

Tatsächlich besteht die Berechnung von Neuronen aus einer Reihe von Additionen und Multiplikationen, aber weil es genug davon gibt, wird es sehr kompliziert. Ein Neuron kann mehrere Eingänge und nur einen Ausgang haben, kann aber mehrere Neuronen aktivieren. Die folgende Abbildung ist beispielsweise eine der Sigmoid-Aktivierungsfunktionen, und ihr Wertebereich liegt bei (0, 1).

Tatsächlich besteht die Berechnung von Neuronen aus einer Reihe von Additionen und Multiplikationen, aber weil es genug davon gibt, wird es sehr kompliziert. Ein Neuron kann mehrere Eingänge und nur einen Ausgang haben, kann aber mehrere Neuronen aktivieren. Die folgende Abbildung ist beispielsweise eine der Sigmoid-Aktivierungsfunktionen, und ihr Wertebereich liegt bei (0, 1).

Wenn es nur darum geht, zu beurteilen, ob es sich um X handelt, reicht eine Ebene aus. In der Praxis müssen wir jedoch die Sprach- und Bilderkennung anderer Personen verstehen. Daher untersuchen Menschen mehrere Schichten von Neuronen. Ein Eingang, wie in der Abbildung gezeigt, und dann wird der Eingabeterminal mit jedem Neuron der ersten verborgenen Schicht verbunden. Nachdem die erste verborgene Schicht die Daten ausgegeben hat, wählt sie die Ausgabe an die zweite verborgene Schicht und die zweite verborgene Schicht der Ebene gelangt in die dritte verborgene Ebene. Dies wird als mehrschichtiges neuronales Netzwerk bezeichnet. Zwischen jeweils zwei Schichten gibt es eine große Anzahl von Parametern, und wir passen eine große Anzahl von Parametern optimal an, sodass die endgültige Fehlerfunktion minimiert wird.

Wenn es nur darum geht, zu beurteilen, ob es sich um X handelt, reicht eine Ebene aus. In der Praxis müssen wir jedoch die Sprach- und Bilderkennung anderer Personen verstehen. Daher untersuchen Menschen mehrere Schichten von Neuronen. Ein Eingang, wie in der Abbildung gezeigt, und dann wird der Eingabeterminal mit jedem Neuron der ersten verborgenen Schicht verbunden. Nachdem die erste verborgene Schicht die Daten ausgegeben hat, wählt sie die Ausgabe an die zweite verborgene Schicht und die zweite verborgene Schicht der Ebene gelangt in die dritte verborgene Ebene. Dies wird als mehrschichtiges neuronales Netzwerk bezeichnet. Zwischen jeweils zwei Schichten gibt es eine große Anzahl von Parametern, und wir passen eine große Anzahl von Parametern optimal an, sodass die endgültige Fehlerfunktion minimiert wird.

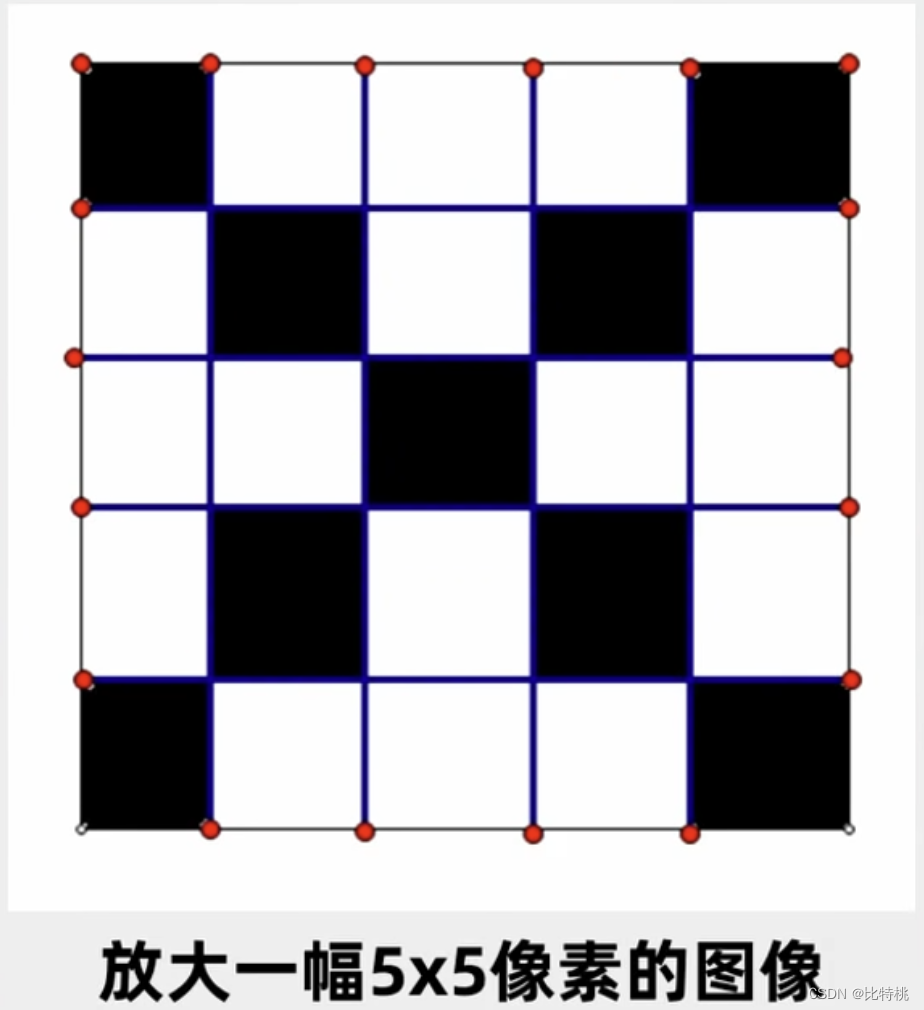

Obwohl die von Neuronen ausgeführten Operationen nicht kompliziert sind, ist die Größenordnung sehr groß, sobald die Szene komplex ist. Ein 5*5-Bild hat beispielsweise 25 Neuronen in jeder Schicht, 625 Parameter in jeder Schicht und mehr als 2.000 in drei Schichten. Wenn es sich um ein Farbbild handelt, ist die Erkennung schwieriger und die Berechnung sehr langsam. Dies ist auch der Grund dafür, dass künstliche Intelligenz in den letzten Jahren unterschätzt wurde und weder die Rechenleistung noch der Algorithmus mithalten können. Später erschienen der BP-Algorithmus und die Backpropagation, und die letzte Ebene kann zuerst angepasst werden. Nachdem die letzte Ebene angepasst wurde, wird sie nach vorne angepasst. Die Komplexität dieses Algorithmus ist geringer als die des vorherigen. Der BP-Algorithmus löst hauptsächlich den Fehlerverlust und die Fehlerberechnung im Prozess der Informationsübertragung zwischen mehreren Schichten des neuronalen Netzwerks und leitet damit die dritte Welle der künstlichen Intelligenz ein.

Obwohl die von Neuronen ausgeführten Operationen nicht kompliziert sind, ist die Größenordnung sehr groß, sobald die Szene komplex ist. Ein 5*5-Bild hat beispielsweise 25 Neuronen in jeder Schicht, 625 Parameter in jeder Schicht und mehr als 2.000 in drei Schichten. Wenn es sich um ein Farbbild handelt, ist die Erkennung schwieriger und die Berechnung sehr langsam. Dies ist auch der Grund dafür, dass künstliche Intelligenz in den letzten Jahren unterschätzt wurde und weder die Rechenleistung noch der Algorithmus mithalten können. Später erschienen der BP-Algorithmus und die Backpropagation, und die letzte Ebene kann zuerst angepasst werden. Nachdem die letzte Ebene angepasst wurde, wird sie nach vorne angepasst. Die Komplexität dieses Algorithmus ist geringer als die des vorherigen. Der BP-Algorithmus löst hauptsächlich den Fehlerverlust und die Fehlerberechnung im Prozess der Informationsübertragung zwischen mehreren Schichten des neuronalen Netzwerks und leitet damit die dritte Welle der künstlichen Intelligenz ein.

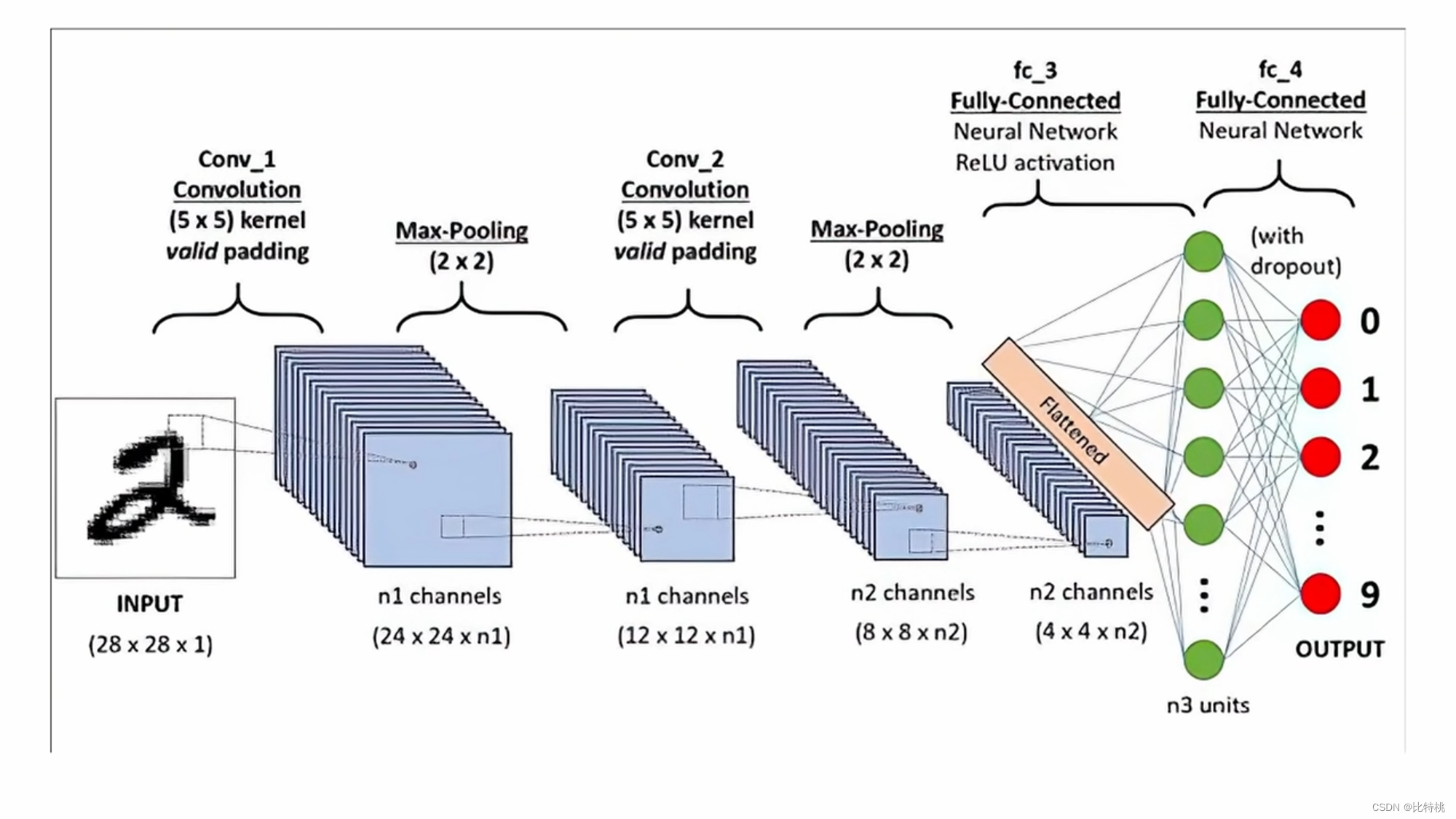

3.2 CNN

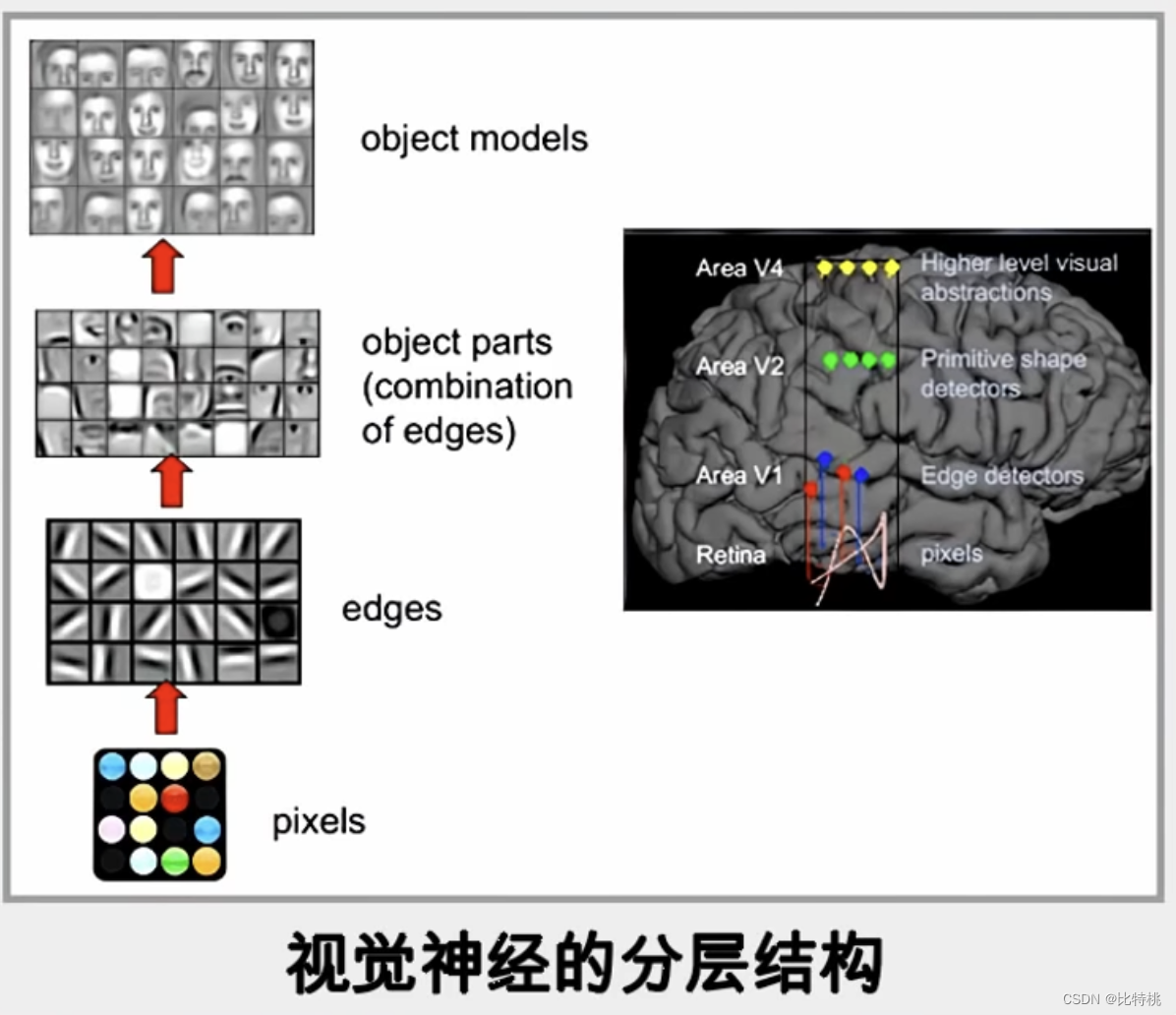

Hier nehmen wir noch einen klassischeren Algorithmus im neuronalen Netzwerkalgorithmus: CNN-Faltungs-Neuronales Netzwerk als Beispiel. Der Vorgang ähnelt der Gehirnerkennung von Tieren: Wenn ein Bild im Gehirn reflektiert wird, wandert es von einem Punkt über eine Linie zu einem Objekt und erkennt schließlich, was es ist. Das Gleiche gilt für Computer, die die Bilderkennung durch die Beurteilung von Pixelpunkten, Kantenrichtung, Konturdetails und -details realisieren.

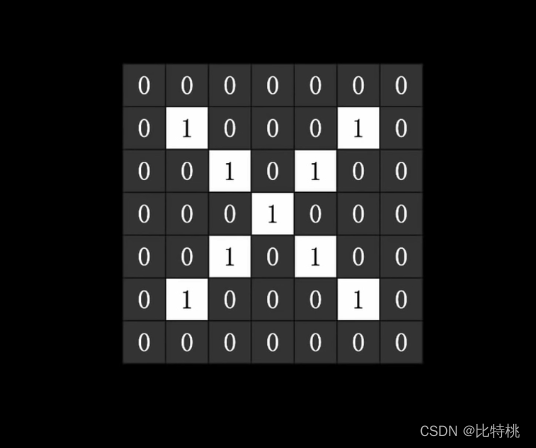

Beispielsweise möchten wir feststellen, ob ein Bild vorhanden ist

Beispielsweise möchten wir feststellen, ob ein Bild vorhanden ist X Für ein solches Zeichen ist das Bild ein zweidimensionales Array für den Computer. Schwarz ist beispielsweise 1 und Weiß ist 0. Wie nachfolgend dargestellt:

Nach der Eingabe an den Computer kann eine Reihe von Trainingsprozessen verwendet werden, um eine große Anzahl von Parametern zu finden und zu beurteilen, ob es sich um ein X handelt. Finden Sie eine Funktion mit dem geringsten Verlust, die ein erfolgreiches Training darstellt. Von da an kann ich anhand dieser Parameter beurteilen, ob ein Bild X ist oder nicht.

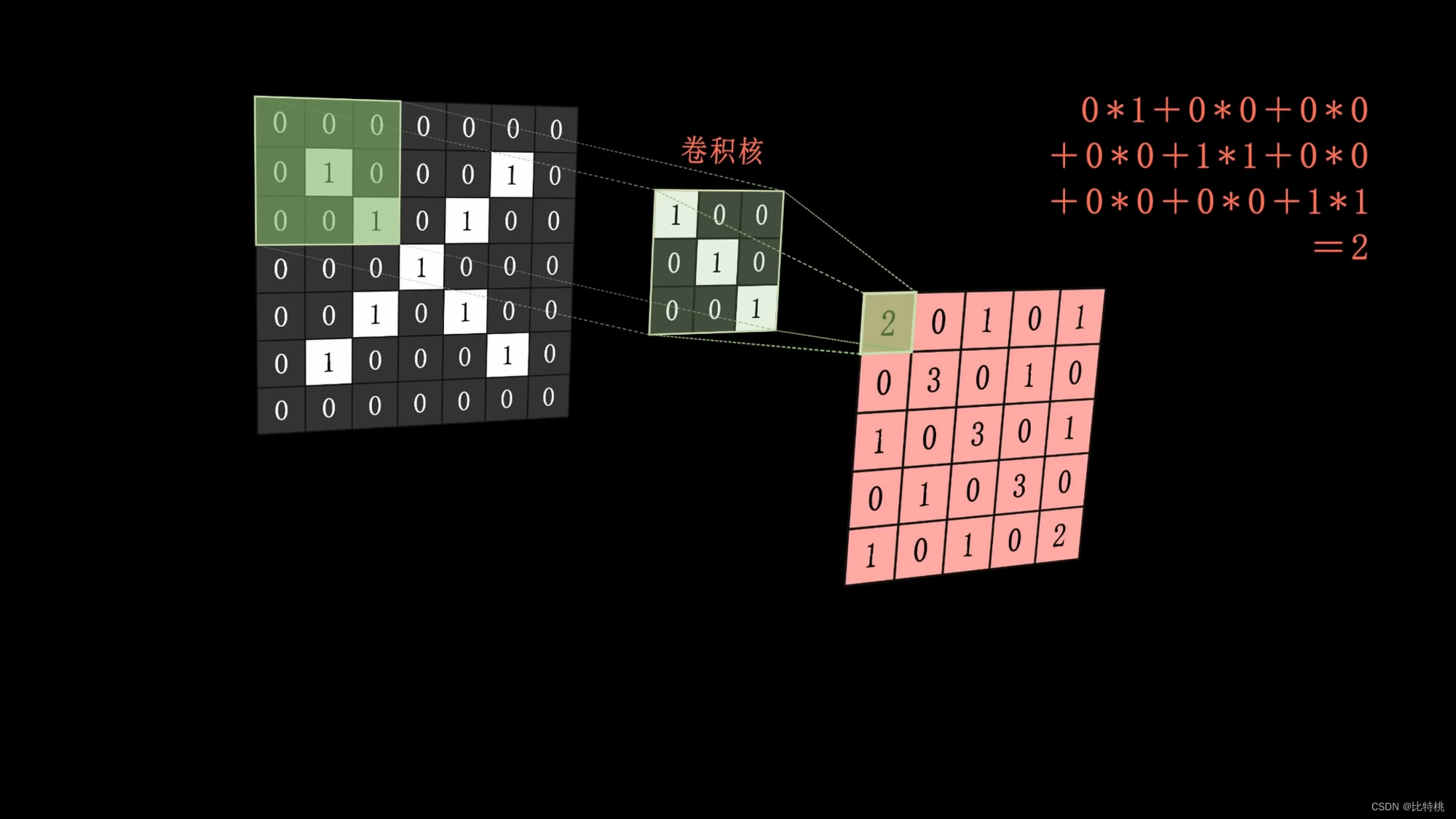

Insbesondere können wir den Faltungskern verwenden, um Faltungsoperationen durchzuführen, indem wir die Merkmale im Bild extrahieren. Beispielsweise ist der Faltungskern eine geneigte vertikale Linie (wir glauben, dass dies eines der Merkmale des X-Bildes ist).

Nach der Eingabe an den Computer kann eine Reihe von Trainingsprozessen verwendet werden, um eine große Anzahl von Parametern zu finden und zu beurteilen, ob es sich um ein X handelt. Finden Sie eine Funktion mit dem geringsten Verlust, die ein erfolgreiches Training darstellt. Von da an kann ich anhand dieser Parameter beurteilen, ob ein Bild X ist oder nicht.

Insbesondere können wir den Faltungskern verwenden, um Faltungsoperationen durchzuführen, indem wir die Merkmale im Bild extrahieren. Beispielsweise ist der Faltungskern eine geneigte vertikale Linie (wir glauben, dass dies eines der Merkmale des X-Bildes ist).

Der Faltungskern (eine geneigte vertikale Linie) wird auf das Bild angewendet, die Operation ausgeführt und das Ergebnis der Operation in der Mitte der Bildabdeckung platziert. Dann ist die Kombination die Feature-Map. Je größer das berechnete Merkmal ist, desto besser kann es dieses Merkmal ausdrücken.

Der Faltungskern (eine geneigte vertikale Linie) wird auf das Bild angewendet, die Operation ausgeführt und das Ergebnis der Operation in der Mitte der Bildabdeckung platziert. Dann ist die Kombination die Feature-Map. Je größer das berechnete Merkmal ist, desto besser kann es dieses Merkmal ausdrücken.

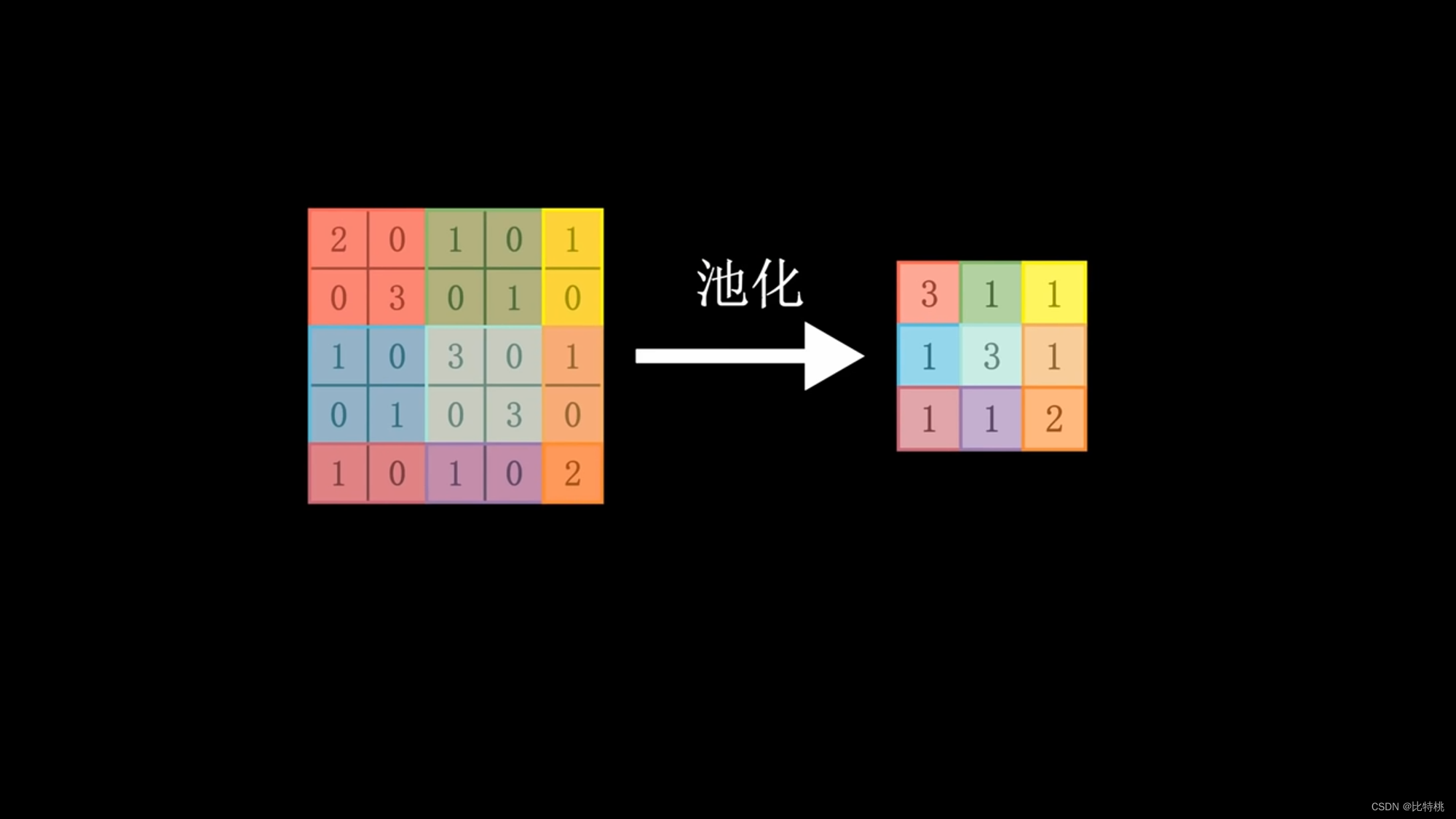

Da der Rechenaufwand zu groß ist, verwenden wir den Faltungskern, um einen Bereich nach dem anderen zu scannen. Multiplizieren Sie jede entsprechende Zahl und addieren Sie die Summe. Die regionalen numerischen Merkmale werden extrahiert. Anschließend werden die Daten gepoolt, der Maximalwert im Bereich ermittelt und die Menge der charakteristischen Daten konzentriert und abgeflacht. Geben Sie das gesamte neuronale Netzwerk ein. Da es sich um Faltungsoperationen handelt, wird es auch als Faltungs-Neuronales Netzwerk bezeichnet. Größe, Tempo und Anzahl der Faltungsschichten des Faltungskerns können alle im Voraus angepasst werden. Der von der Maschine ausgegebene Wert wird mit dem voreingestellten Wert für das Zielergebnis verglichen. Wenn es die Erwartungen erfüllt, ist es ein Erfolg. Wenn die Erwartungen nicht erfüllt werden, wird eine Reihe von Berechnungen durchgeführt, um die Parameter (BP) jeder Verbindung umgekehrt anzupassen, erneut zu berechnen und zu wiederholen, bis die Erwartungen erfüllt werden. Dies ist das Prinzip des maschinellen Lernens. Faltung -> Pooling -> Aktivierung.

Da der Rechenaufwand zu groß ist, verwenden wir den Faltungskern, um einen Bereich nach dem anderen zu scannen. Multiplizieren Sie jede entsprechende Zahl und addieren Sie die Summe. Die regionalen numerischen Merkmale werden extrahiert. Anschließend werden die Daten gepoolt, der Maximalwert im Bereich ermittelt und die Menge der charakteristischen Daten konzentriert und abgeflacht. Geben Sie das gesamte neuronale Netzwerk ein. Da es sich um Faltungsoperationen handelt, wird es auch als Faltungs-Neuronales Netzwerk bezeichnet. Größe, Tempo und Anzahl der Faltungsschichten des Faltungskerns können alle im Voraus angepasst werden. Der von der Maschine ausgegebene Wert wird mit dem voreingestellten Wert für das Zielergebnis verglichen. Wenn es die Erwartungen erfüllt, ist es ein Erfolg. Wenn die Erwartungen nicht erfüllt werden, wird eine Reihe von Berechnungen durchgeführt, um die Parameter (BP) jeder Verbindung umgekehrt anzupassen, erneut zu berechnen und zu wiederholen, bis die Erwartungen erfüllt werden. Dies ist das Prinzip des maschinellen Lernens. Faltung -> Pooling -> Aktivierung.

Anhand der Merkmalsdaten nach der Faltung können wir erkennen, dass die Zahl umso mehr den Eigenschaften des Faltungskerns entspricht, je näher sie an 1 liegt.

Anhand der Merkmalsdaten nach der Faltung können wir erkennen, dass die Zahl umso mehr den Eigenschaften des Faltungskerns entspricht, je näher sie an 1 liegt.

Der Faltungskern kann zu Beginn künstlich eingestellt werden, später wird er den Faltungskern jedoch entsprechend seinen eigenen Daten umgekehrt anpassen. Ähnlich wie bei der Trainingsmethode wird zum Anpassen der Parameter während des Trainingsprozesses der am besten geeignete Faltungskern gefunden. Es gibt mehrere Faltungskerne und mehrere Feature-Maps (dreidimensional). Wenn diese Feature-Maps zusammen verschoben werden, entsteht eine dreidimensionale Figur.

Der Faltungskern kann zu Beginn künstlich eingestellt werden, später wird er den Faltungskern jedoch entsprechend seinen eigenen Daten umgekehrt anpassen. Ähnlich wie bei der Trainingsmethode wird zum Anpassen der Parameter während des Trainingsprozesses der am besten geeignete Faltungskern gefunden. Es gibt mehrere Faltungskerne und mehrere Feature-Maps (dreidimensional). Wenn diese Feature-Maps zusammen verschoben werden, entsteht eine dreidimensionale Figur.

Das Design des Wissenschaftlers ist erstaunlich und simuliert den menschlichen Denkprozess nahezu perfekt.

Wir geben der künstlichen Intelligenz viele Daten, und dann passt die künstliche Intelligenz ihren Faltungskern und ihre Parameter mithilfe einer Methode an und kann schließlich unterscheiden, was die einzelnen Objekte sind. Obwohl wir nicht wissen, wie der Faltungskern und diese Parameter entworfen werden.

Das Design des Wissenschaftlers ist erstaunlich und simuliert den menschlichen Denkprozess nahezu perfekt.

Wir geben der künstlichen Intelligenz viele Daten, und dann passt die künstliche Intelligenz ihren Faltungskern und ihre Parameter mithilfe einer Methode an und kann schließlich unterscheiden, was die einzelnen Objekte sind. Obwohl wir nicht wissen, wie der Faltungskern und diese Parameter entworfen werden.

3.3 Modell = Blackbox

Wir wissen jetzt, dass wir durch kontinuierliches Training des neuronalen Netzwerks den Erkennungsfehler kleiner machen können. Um ein intelligentes Modell zu erhalten, werden einige praktische Arbeiten durchgeführt. Obwohl das Modell von uns trainiert wird, wird das Modell tatsächlich jedes Mal spezifisch erkannt. Wir wissen nicht, wie es funktioniert, es ist für uns immer noch eine Blackbox. So wie Newton nicht erklärte, warum der Apfel zu Boden fiel, erstellte er ein mathematisches Modell der Schwerkraft, drückte es jedoch quantitativ mit Methoden aus. Was den Grund betrifft, ist es immer noch schwierig, ihn in menschliche Worte zu fassen. Das Gleiche gilt für Modelle, die durch künstliche Intelligenz trainiert werden. Die Features, die wir sehen, unterscheiden sich tatsächlich von den Features, die von Maschinen verwendet werden, sei es die Anzahl der Features oder der Inhalt der Features. Wir gehen davon aus, dass ein Objekt anhand von vier Merkmalen beurteilt werden kann, der Computer jedoch möglicherweise 10 verwendet. Das Gleiche gilt für den Inhalt. Auch der Inhalt unseres menschlichen Gehirns und die 0 und 1 des Computers sind schwer gleichwertig. Sie müssen wissen, dass das neuronale Netzwerk ein selbstanpassendes und selbstoptimierendes Training ist, daher ist es für Sie schwierig zu sagen, wie es am Ende des Trainings funktioniert hat. So wie wir einem Kind beibringen, den Unterschied zwischen einer Katze und einem Hund zu erkennen, wird das Kind den Unterschied endlich erkennen, wenn man ihm viele Katzen und Hunde zeigt. Aber man kann wissen, wie Kinder konkret identifiziert werden, das ist eigentlich schwer zu erklären. Aus diesem Grund sagen alle, dass das von der KI trainierte Modell eine Black Box ist.

3.4 Grafikkarte = Rechenleistung

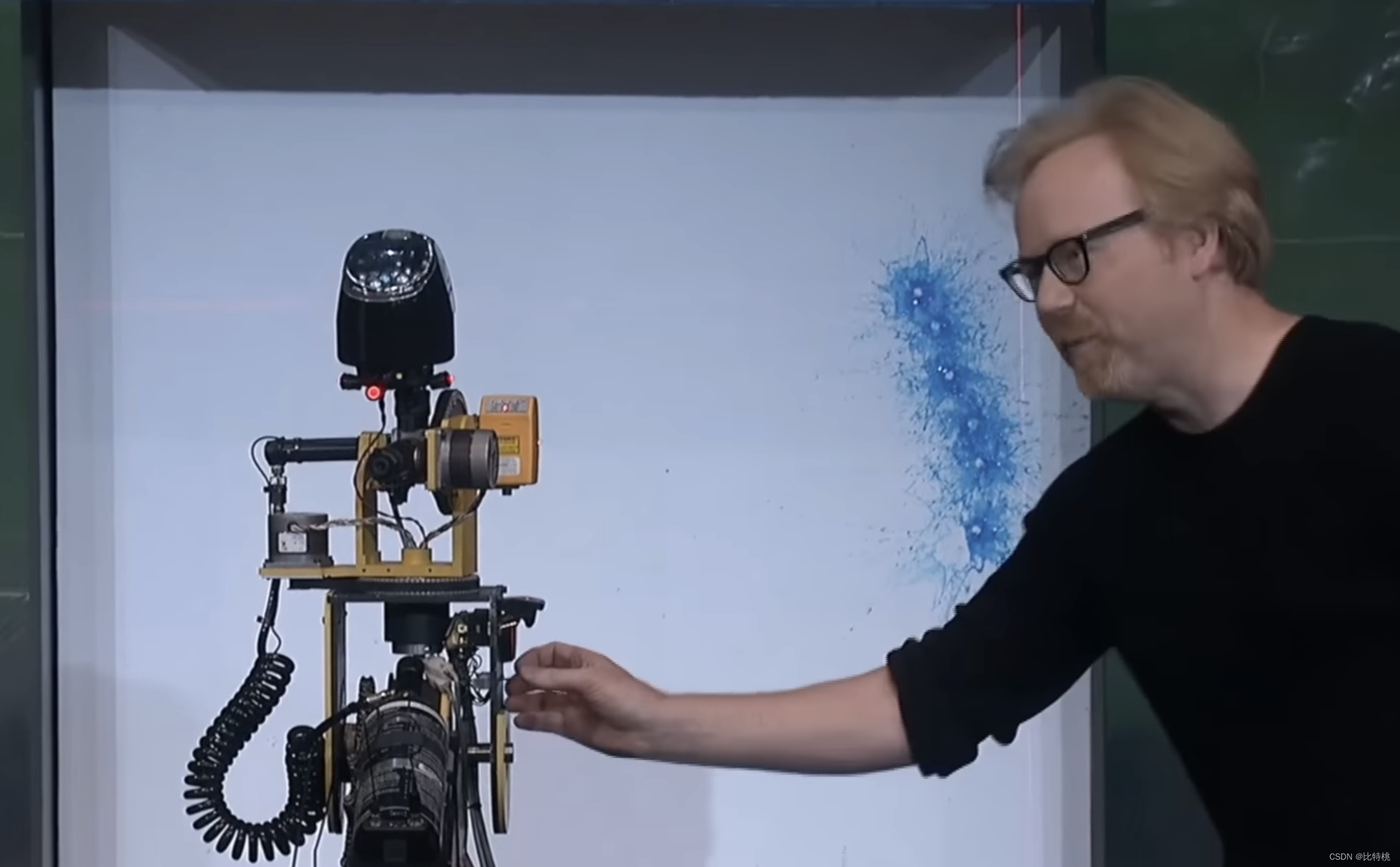

Wie oben erwähnt, hatte die Forschung zu neuronalen Netzen jedoch in den 1960er Jahren eine gewisse Grundlage. Der Grund, warum es jedoch nicht entwickelt wurde, liegt im Mangel an zwei Dingen: Rechenleistung und Daten. Obwohl nicht jedes Neuron im neuronalen Netzwerk sehr genau berechnet werden muss, ist eine große Anzahl gleichzeitiger Berechnungen erforderlich. Ziegel ohne Stroh herstellen. Berechnungen sind nicht kompliziert, alles ist Addition und Multiplikation, aber der Rechenumfang ist besonders kompliziert. Zum Beispiel ein Bild 800 x 600 (Pixel) = 144000 Pixel. Wenn für die Faltung ein dreischichtiger Faltungskern (da RGB 3 ist) verwendet wird, sind etwa 13 Millionen Multiplikationen + 12 Millionen Additionen erforderlich. Dies war für die damalige CPU inkompetent, und selbst die aktuelle CPU kann dies nicht. Dafür muss die GPU ihr Können unter Beweis stellen. Wir wissen, dass die GPU für Grafikberechnungen genutzt wird. Um beispielsweise ein 4K-Video abzuspielen, beträgt das Minimum 10 Millionen Pixel, wenn man von 30 Bildern pro Sekunde ausgeht. Die CPU unterstützt 64 Kerne und 128 Kerne, und die GPU kann Zehntausende Kerne haben. Obwohl die Berechnung eines Pixels sehr einfach ist, eignet sie sich dennoch für Geräte mit einer großen Anzahl gleichzeitiger Vorgänge, z. B. eine GPU. Das Bild unten ist ein sehr anschauliches Beispiel. Die CPU ist wie eine hochpräzise Spritzpistole, auf die man treffen muss:

Aufgrund der hohen Parallelität kann die GPU die gesamte Grafik sofort rendern:

Aufgrund der hohen Parallelität kann die GPU die gesamte Grafik sofort rendern:

Aus diesem Grund hören wir oft, dass für die Durchführung von KI der Kauf einer Grafikkarte erforderlich ist, da wir während des Trainingsprozesses viele solcher gleichzeitigen Vorgänge (einschließlich Mining) benötigen.

Derzeit wird das KI-Training grundsätzlich von Nvidia-Grafikkarten monopolisiert, was daran liegt, dass Lao Huangs Layout noch sehr früh ist. Bereits 2006 brachte Nvidia CUDA auf den Markt, mit dem es gelungen ist, GPUs programmierbar zu machen. Während in der Vergangenheit eine speziell für die 3D-Verarbeitung von Grafiken entwickelte Grafikkarte eine große Anzahl von Top-Ingenieuren erforderte, um sie für die Computerprogrammierung zu verwenden, ist dies heute nur noch auf Basis der CUDA-Bibliothek möglich. Nvidia hat die Grenzen seiner Grafikkarten von Spielen und 3D-Bildverarbeitung auf den gesamten Bereich des beschleunigten Rechnens ausgeweitet. Wie Luft- und Raumfahrt, Biopharmazeutika, Wettervorhersage, Energieexploration und so weiter. Wenn Deep Learning in 12 Jahren sehr ausgereift ist, ist es selbstverständlich, diese Plattform von Nvidia zu verwenden. Wenn es um KI-Training geht, ist es daher gleichbedeutend mit dem Kauf einer Grafikkarte, und der Kauf einer Grafikkarte ist Nvidia.

Aus diesem Grund hören wir oft, dass für die Durchführung von KI der Kauf einer Grafikkarte erforderlich ist, da wir während des Trainingsprozesses viele solcher gleichzeitigen Vorgänge (einschließlich Mining) benötigen.

Derzeit wird das KI-Training grundsätzlich von Nvidia-Grafikkarten monopolisiert, was daran liegt, dass Lao Huangs Layout noch sehr früh ist. Bereits 2006 brachte Nvidia CUDA auf den Markt, mit dem es gelungen ist, GPUs programmierbar zu machen. Während in der Vergangenheit eine speziell für die 3D-Verarbeitung von Grafiken entwickelte Grafikkarte eine große Anzahl von Top-Ingenieuren erforderte, um sie für die Computerprogrammierung zu verwenden, ist dies heute nur noch auf Basis der CUDA-Bibliothek möglich. Nvidia hat die Grenzen seiner Grafikkarten von Spielen und 3D-Bildverarbeitung auf den gesamten Bereich des beschleunigten Rechnens ausgeweitet. Wie Luft- und Raumfahrt, Biopharmazeutika, Wettervorhersage, Energieexploration und so weiter. Wenn Deep Learning in 12 Jahren sehr ausgereift ist, ist es selbstverständlich, diese Plattform von Nvidia zu verwenden. Wenn es um KI-Training geht, ist es daher gleichbedeutend mit dem Kauf einer Grafikkarte, und der Kauf einer Grafikkarte ist Nvidia.

Vermutlich hat jeder ChatGPT direkt oder indirekt verwendet. Es unterscheidet sich völlig von den Siri- und Xiaoai-Studenten, die wir normalerweise verwenden. Wenn wir mit Ersterem chatten, nutzen wir es als künstliche geistige Behinderung, aber im Gespräch mit ChatGPT können wir tatsächlich einige praktische Probleme lösen. Lassen Sie es beispielsweise wichtige technische Punkte in unbekannten Bereichen analysieren, Algorithmusfragen schreiben, um Fehler zu finden usw. Warum ChatGPT so intelligent wird und welche Technologie dahinter steckt, wollen wir im Folgenden gemeinsam erkunden.

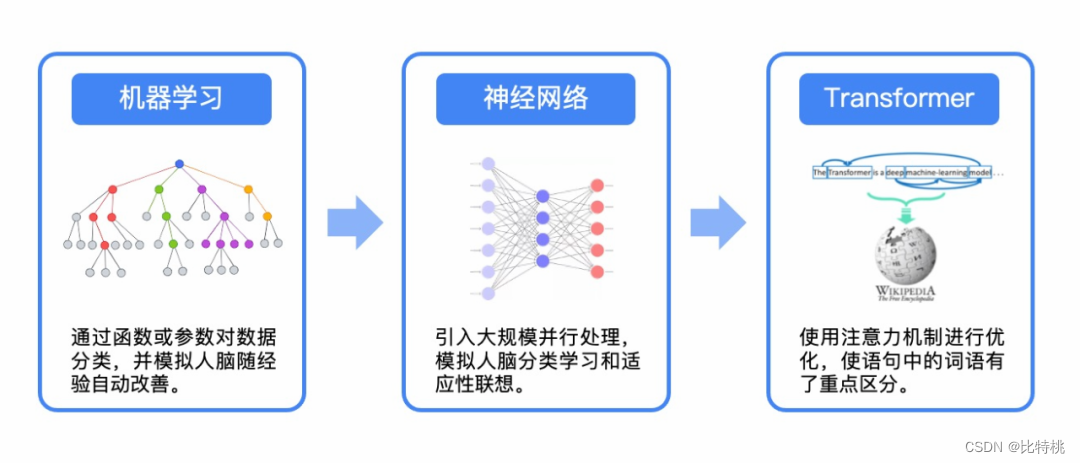

4.1 LLM

Ein Sprachmodell ist eine Technik zur Verarbeitung natürlicher Sprache, die auf statistischen und maschinellen Lernmethoden basiert und zur Bewertung und Vorhersage der Wahrscheinlichkeitsverteilung einer bestimmten Sequenz, normalerweise einer Folge von Wörtern oder Zeichen, verwendet wird. Die Hauptanwendungen von Sprachmodellen sind Aufgaben wie Textgenerierung, maschinelle Übersetzung und Spracherkennung. In den letzten Jahren haben die Sprachmodellparameter der neuronalen Netzwerkarchitektur Hunderte von Milliarden erreicht. Um den Unterschied zum traditionellen Sprachmodell zu zeigen, wird es normalerweise als großes Sprachmodell (LLM) bezeichnet.

Beim maschinellen Lernen wird im Allgemeinen das Recurrent Neural Network (RNN) zur Textverarbeitung verwendet. Es muss Wort für Wort gelesen werden und es gibt keine Möglichkeit, eine große Anzahl davon gleichzeitig zu verarbeiten. Und die Sätze sollten nicht zu lang sein, sonst werden sie nach dem Lernen vergessen.

Bis 2017 veröffentlichte google ein Papier, in dem er ein neues Lernframework namens Transformer vorschlug. Er kann die Maschine eine große Anzahl von Wörtern gleichzeitig lernen lassen, genau wie den Unterschied zwischen Serie und Parallel. Viele NLP-Modelle basieren mittlerweile auf Transformer. Das T in Google BERT und das T in ChatGPT beziehen sich beide auf diesen Transformer.

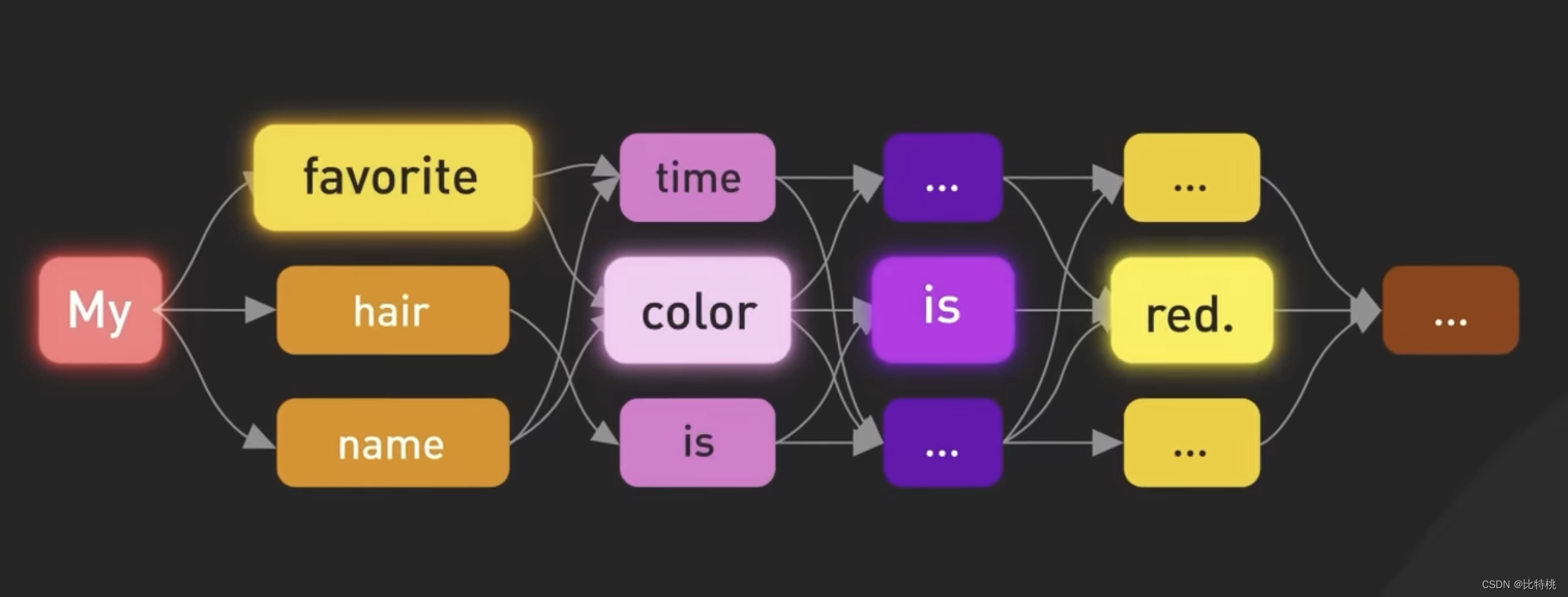

Basierend auf Transformer veröffentlichte das GPT-Team 2018 einen Artikel, in dem ein neues Sprachmodell vorgestellt wurde: Generative Pre-trained Transformer oder GPT. Große Sprachmodelle (LLMs) erzeugen menschenähnlichen Text, indem sie die Wahrscheinlichkeit von Wörtern basierend auf zuvor im Text verwendeten Wörtern vorhersagen.

Frühere Sprachlernmodelle erforderten grundsätzlich die Aufsicht eines Menschen oder setzten ihm künstlich bestimmte Bezeichnungen. Aber GPT wird im Grunde nicht viel benötigt. Geben Sie einfach eine Menge Daten ein und Sie können es nach einer Weile lernen. Ein so großes Sprachmodell hängt hauptsächlich vom Algorithmus und der Menge an Parametern ab. Dieselben Daten können schneller gelernt werden als alle anderen, und die Menge an Parametern erfordert viele Berechnungen. Um es ganz klar auszudrücken: Es ist Geldverschwendung. Nach GPT3 wird künstliches Feedback-Verstärkungslernen hinzugefügt und jedes seiner Wörter wird basierend auf der Relevanz und dem Kontext des vorherigen Textes berechnet.

Basierend auf Transformer veröffentlichte das GPT-Team 2018 einen Artikel, in dem ein neues Sprachmodell vorgestellt wurde: Generative Pre-trained Transformer oder GPT. Große Sprachmodelle (LLMs) erzeugen menschenähnlichen Text, indem sie die Wahrscheinlichkeit von Wörtern basierend auf zuvor im Text verwendeten Wörtern vorhersagen.

Frühere Sprachlernmodelle erforderten grundsätzlich die Aufsicht eines Menschen oder setzten ihm künstlich bestimmte Bezeichnungen. Aber GPT wird im Grunde nicht viel benötigt. Geben Sie einfach eine Menge Daten ein und Sie können es nach einer Weile lernen. Ein so großes Sprachmodell hängt hauptsächlich vom Algorithmus und der Menge an Parametern ab. Dieselben Daten können schneller gelernt werden als alle anderen, und die Menge an Parametern erfordert viele Berechnungen. Um es ganz klar auszudrücken: Es ist Geldverschwendung. Nach GPT3 wird künstliches Feedback-Verstärkungslernen hinzugefügt und jedes seiner Wörter wird basierend auf der Relevanz und dem Kontext des vorherigen Textes berechnet.

4.2 Generierungsprozess

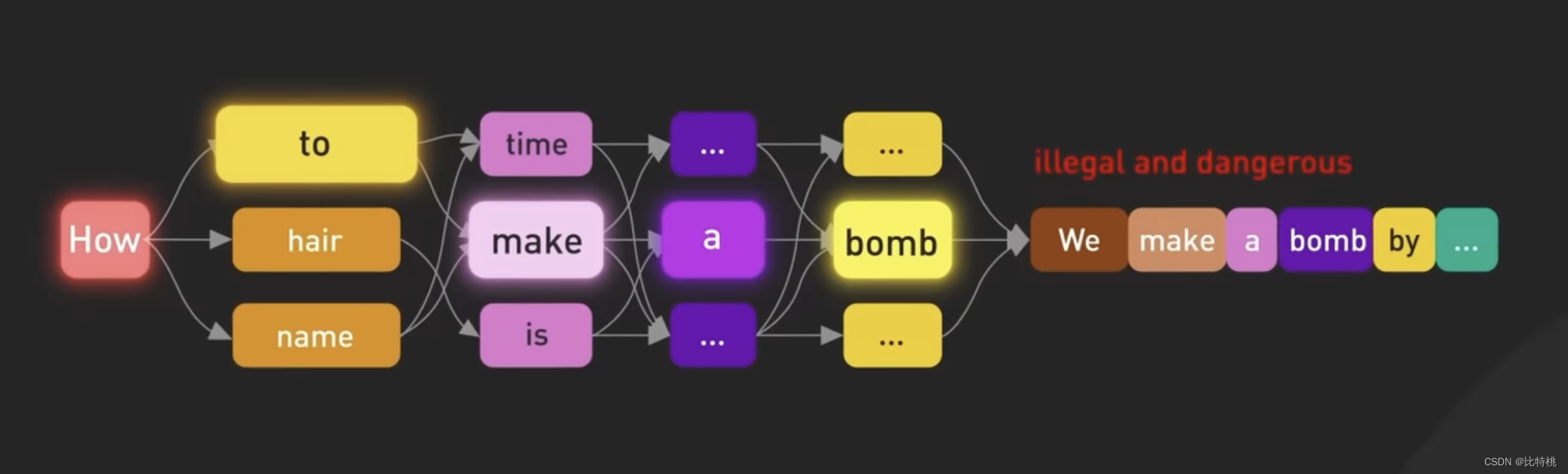

Wir wissen, dass der Kern von ChatGPT das große Sprachmodell LLM Large Language Model ist. Das Oracle-Modell ist ein auf neuronalen Netzwerken basierendes Modell, das auf großen Textdatenmengen trainiert wird, um menschliche Sprache zu verstehen und zu generieren. Das Modell verwendet Trainingsdaten, um statistische Muster und Beziehungen zwischen Wörtern in einer Sprache zu lernen, und nutzt dieses Wissen dann, um nachfolgende Wörter Wort für Wort vorherzusagen. Das größte GPT 3.5-Modell verfügt über 175 Milliarden Parameter, die auf 96 Schichten neuronaler Netze verteilt sind, und ist damit eines der größten Deep-Learning-Modelle, die jemals erstellt wurden.

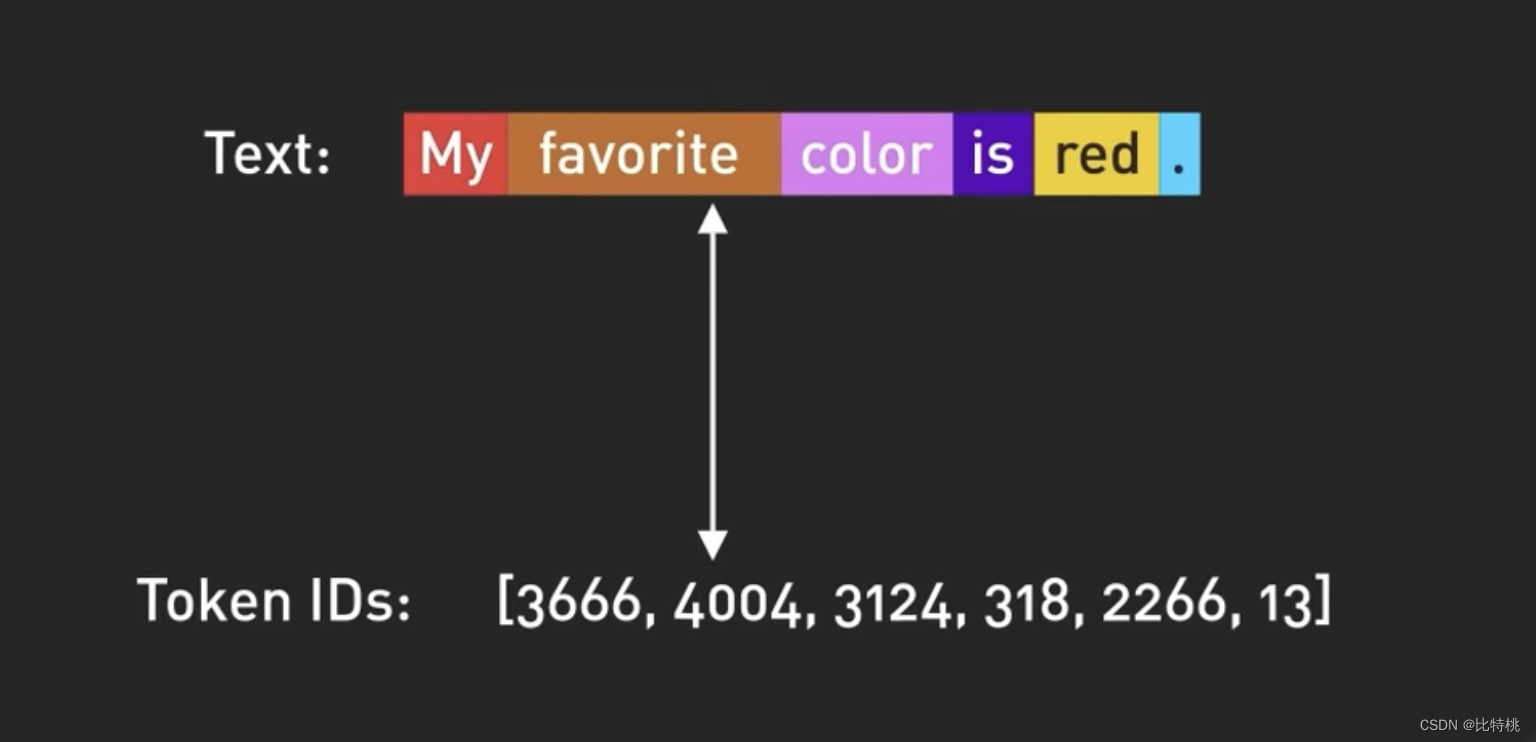

Die Eingabe und Ausgabe des Modells in ChatGPT werden durch Token organisiert, bei dem es sich um die digitale Darstellung von Wörtern handelt. Genauer gesagt, Teil eines Wortes. Tatsächlich basiert es auf dem Kontext jedes Wortes im Satz, um zu beurteilen, welches nächste Wort für die Ausgabe besser geeignet ist.

Die Eingabe und Ausgabe des Modells in ChatGPT werden durch Token organisiert, bei dem es sich um die digitale Darstellung von Wörtern handelt. Genauer gesagt, Teil eines Wortes. Tatsächlich basiert es auf dem Kontext jedes Wortes im Satz, um zu beurteilen, welches nächste Wort für die Ausgabe besser geeignet ist.

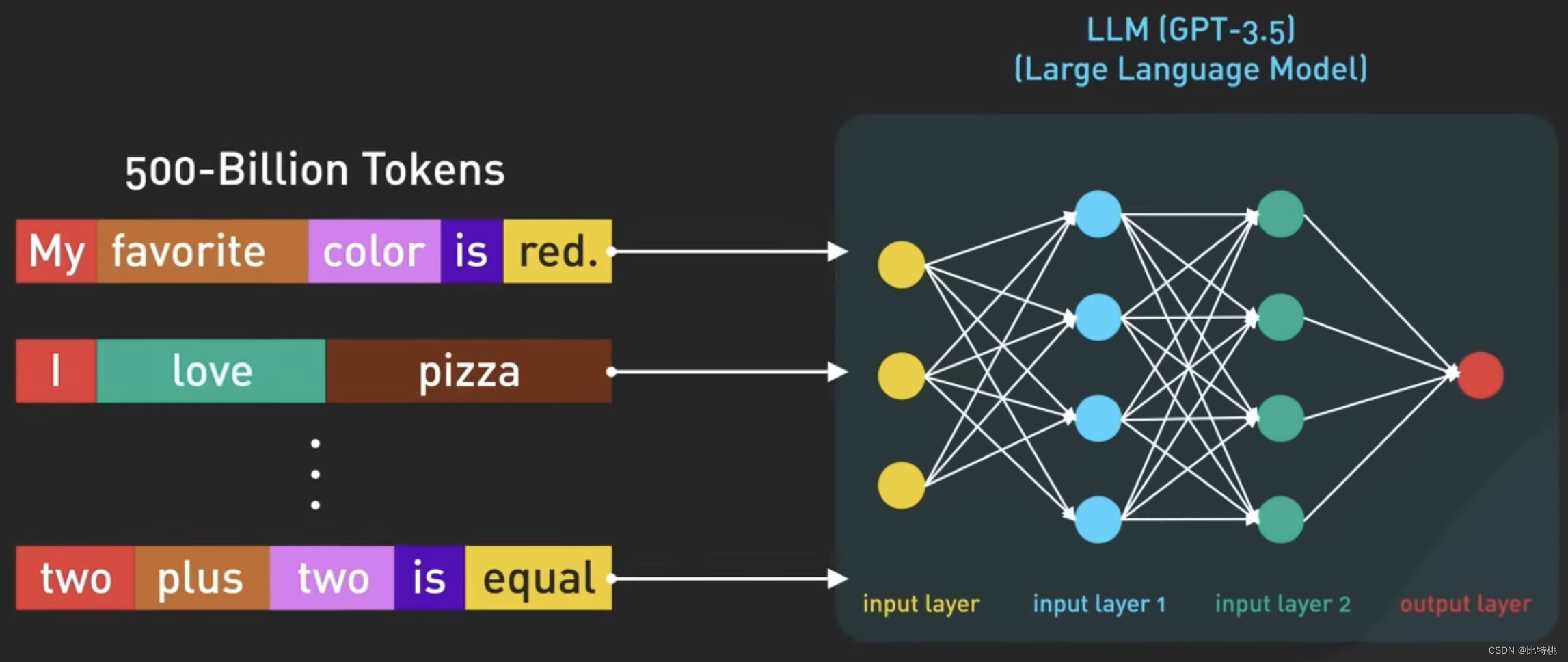

Verwenden Sie Zahlen anstelle von Wörtern, um Token darzustellen, da Zahlen effizienter gehandhabt werden können. GPT-3.5 wird auf der Grundlage einer großen Menge an Internetdaten trainiert, und der ursprüngliche Datensatz enthält 500 Milliarden Token. Das heißt, das Modell wurde auf Hunderten Milliarden Wörtern trainiert.

Verwenden Sie Zahlen anstelle von Wörtern, um Token darzustellen, da Zahlen effizienter gehandhabt werden können. GPT-3.5 wird auf der Grundlage einer großen Menge an Internetdaten trainiert, und der ursprüngliche Datensatz enthält 500 Milliarden Token. Das heißt, das Modell wurde auf Hunderten Milliarden Wörtern trainiert.

Das Modell ist darauf trainiert, das nächste Token anhand einer Folge von Eingabe-Tokens vorherzusagen. Es ist in der Lage, strukturierten Text zu generieren, der syntaktisch korrekt und semantisch den Internetdaten ähnelt, auf denen es trainiert wurde.

Das Modell ist darauf trainiert, das nächste Token anhand einer Folge von Eingabe-Tokens vorherzusagen. Es ist in der Lage, strukturierten Text zu generieren, der syntaktisch korrekt und semantisch den Internetdaten ähnelt, auf denen es trainiert wurde.

4.3 Schulungsprozess

Allerdings kann ChatGPT nach dem oben genannten Vorgang Satzantworten bereits autonom organisieren. Aber ohne entsprechende Anleitung kann das Modell auch unrealistische oder negative Ergebnisse erzeugen.

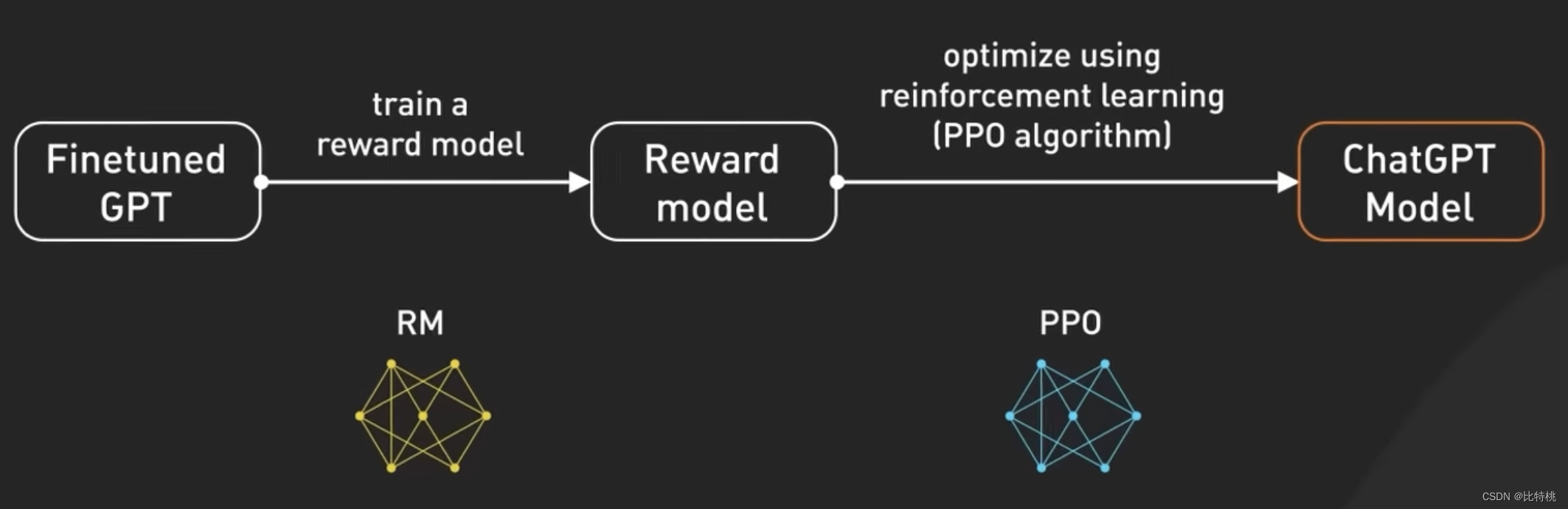

Um das Modell sicherer zu machen und es in der Lage zu machen, im Chatbot-Stil zu fragen und zu antworten. Nach weiterer Feinabstimmung wurde dieses Modell zur derzeit in ChatGPT verwendeten Version. Bei der Feinabstimmung geht es darum, ein Modell, das nicht den menschlichen Werten entspricht, in ein kontrollierbares ChatGPT umzuwandeln. Dieser Prozess der Feinabstimmung des Modells wird als Verstärkungstraining mit menschlichem Feedback (RLHF) bezeichnet.

Um das Modell sicherer zu machen und es in der Lage zu machen, im Chatbot-Stil zu fragen und zu antworten. Nach weiterer Feinabstimmung wurde dieses Modell zur derzeit in ChatGPT verwendeten Version. Bei der Feinabstimmung geht es darum, ein Modell, das nicht den menschlichen Werten entspricht, in ein kontrollierbares ChatGPT umzuwandeln. Dieser Prozess der Feinabstimmung des Modells wird als Verstärkungstraining mit menschlichem Feedback (RLHF) bezeichnet.

OpenAI erklärte, wie sie RLHF auf ihrem Modell ausführen. Die Feinabstimmung von GPT 3.5 mit RLHF ist wie die Verbesserung der Fähigkeiten eines Kochs, um seine Gerichte köstlicher zu machen.

Zunächst wurden Köche anhand eines großen Datensatzes an Rezepten und Kochtechniken geschult. Manchmal weiß der Koch jedoch nicht, wie er das Gericht nach den individuellen Wünschen des Kunden zubereiten soll. Um dieses Problem zu lösen, sammeln wir echtes Benutzerfeedback, um einen neuen Datensatz zu erstellen. Der erste Schritt besteht darin, einen Vergleichsdatensatz zu erstellen, in dem wir Köche bitten, mehrere Gerichte basierend auf bestimmten Anforderungen zuzubereiten, und dann die Leute bitten, die Gerichte nach Geschmack und Aussehen zu bewerten. Dies hilft Köchen zu verstehen, welche Gerichte die Kunden mögen.

Der nächste Schritt ist die Belohnungsmodellierung, bei der Köche dieses Feedback nutzen, um Belohnungsmodelle zu erstellen, die als Leitfaden zum Verständnis der Kundenpräferenzen dienen. Je höher die Belohnung, desto besser die Gerichte. Als nächstes trainieren wir das Modell mithilfe von PPO (d. h. Proximity Policy Optimization). In dieser Analogie übt der Koch das Zubereiten von Gerichten und folgt dabei dem Belohnungsmodell. Sie verwenden eine Technik namens „Proximale Strategieoptimierung“, um ihre Fähigkeiten zu verbessern. Es ist, als würde ein Koch sein aktuelles Gericht mit einer etwas anderen Version vergleichen und anhand eines Belohnungsmodells herausfinden, welches besser ist.

Dieser Vorgang wird mehrmals wiederholt, wobei die Köche ihre Fähigkeiten anhand des neuesten Kundenfeedbacks verfeinern. Mit jeder Wiederholung wird der Koch besser darin, Gerichte zuzubereiten, die den Vorlieben der Kunden entsprechen. Aus einer anderen Perspektive betrachtet optimiert GPT-3.5 RLHF, indem es das Feedback der Menschen sammelt, ein Belohnungsmodell basierend auf ihren Präferenzen erstellt und dann PPO verwendet, um die Modellleistung iterativ zu verbessern. Dadurch kann GPT-3.5 bessere Antworten auf bestimmte Benutzeranfragen generieren.

OpenAI erklärte, wie sie RLHF auf ihrem Modell ausführen. Die Feinabstimmung von GPT 3.5 mit RLHF ist wie die Verbesserung der Fähigkeiten eines Kochs, um seine Gerichte köstlicher zu machen.

Zunächst wurden Köche anhand eines großen Datensatzes an Rezepten und Kochtechniken geschult. Manchmal weiß der Koch jedoch nicht, wie er das Gericht nach den individuellen Wünschen des Kunden zubereiten soll. Um dieses Problem zu lösen, sammeln wir echtes Benutzerfeedback, um einen neuen Datensatz zu erstellen. Der erste Schritt besteht darin, einen Vergleichsdatensatz zu erstellen, in dem wir Köche bitten, mehrere Gerichte basierend auf bestimmten Anforderungen zuzubereiten, und dann die Leute bitten, die Gerichte nach Geschmack und Aussehen zu bewerten. Dies hilft Köchen zu verstehen, welche Gerichte die Kunden mögen.

Der nächste Schritt ist die Belohnungsmodellierung, bei der Köche dieses Feedback nutzen, um Belohnungsmodelle zu erstellen, die als Leitfaden zum Verständnis der Kundenpräferenzen dienen. Je höher die Belohnung, desto besser die Gerichte. Als nächstes trainieren wir das Modell mithilfe von PPO (d. h. Proximity Policy Optimization). In dieser Analogie übt der Koch das Zubereiten von Gerichten und folgt dabei dem Belohnungsmodell. Sie verwenden eine Technik namens „Proximale Strategieoptimierung“, um ihre Fähigkeiten zu verbessern. Es ist, als würde ein Koch sein aktuelles Gericht mit einer etwas anderen Version vergleichen und anhand eines Belohnungsmodells herausfinden, welches besser ist.

Dieser Vorgang wird mehrmals wiederholt, wobei die Köche ihre Fähigkeiten anhand des neuesten Kundenfeedbacks verfeinern. Mit jeder Wiederholung wird der Koch besser darin, Gerichte zuzubereiten, die den Vorlieben der Kunden entsprechen. Aus einer anderen Perspektive betrachtet optimiert GPT-3.5 RLHF, indem es das Feedback der Menschen sammelt, ein Belohnungsmodell basierend auf ihren Präferenzen erstellt und dann PPO verwendet, um die Modellleistung iterativ zu verbessern. Dadurch kann GPT-3.5 bessere Antworten auf bestimmte Benutzeranfragen generieren.

4.4 Eingabeaufforderung

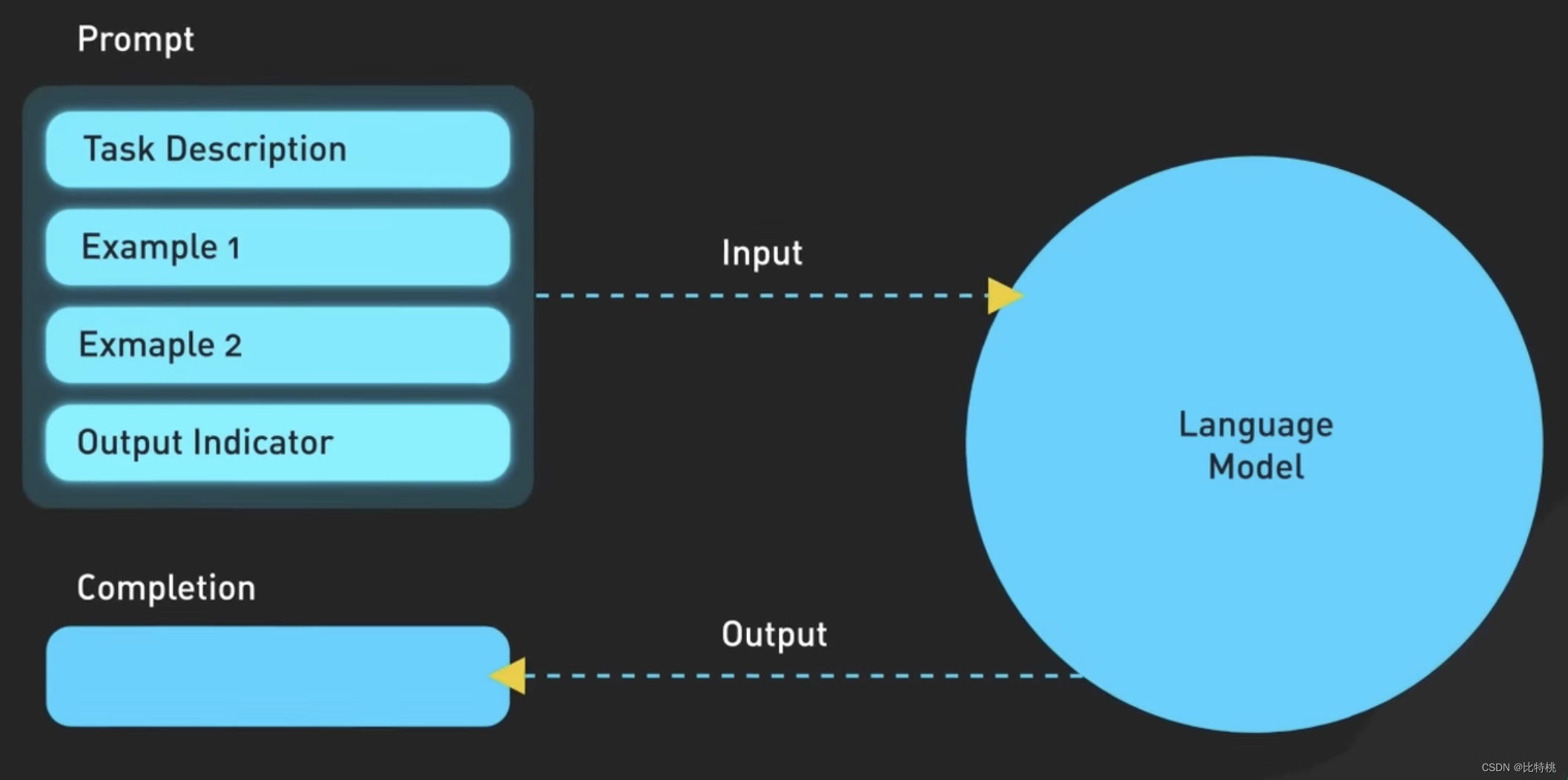

Nachdem der GPT-Trainer es uns beigebracht hat, können wir ChatGPT verwenden. Da die auf dem großen Sprachmodell basierenden GPT-Parameter jedoch zu kompliziert sind, ist es auch sehr wichtig, unsere Bedürfnisse genau auszudrücken. Mit anderen Worten: Wenn Sie einen besseren Dialog mit der KI führen möchten, benötigen Sie die „Sprache“ von Prompt. Mittlerweile gibt es im Internet viele Tutorials, die Ihnen zeigen, wie Sie mit Prompt effizienter mit KI kommunizieren können.

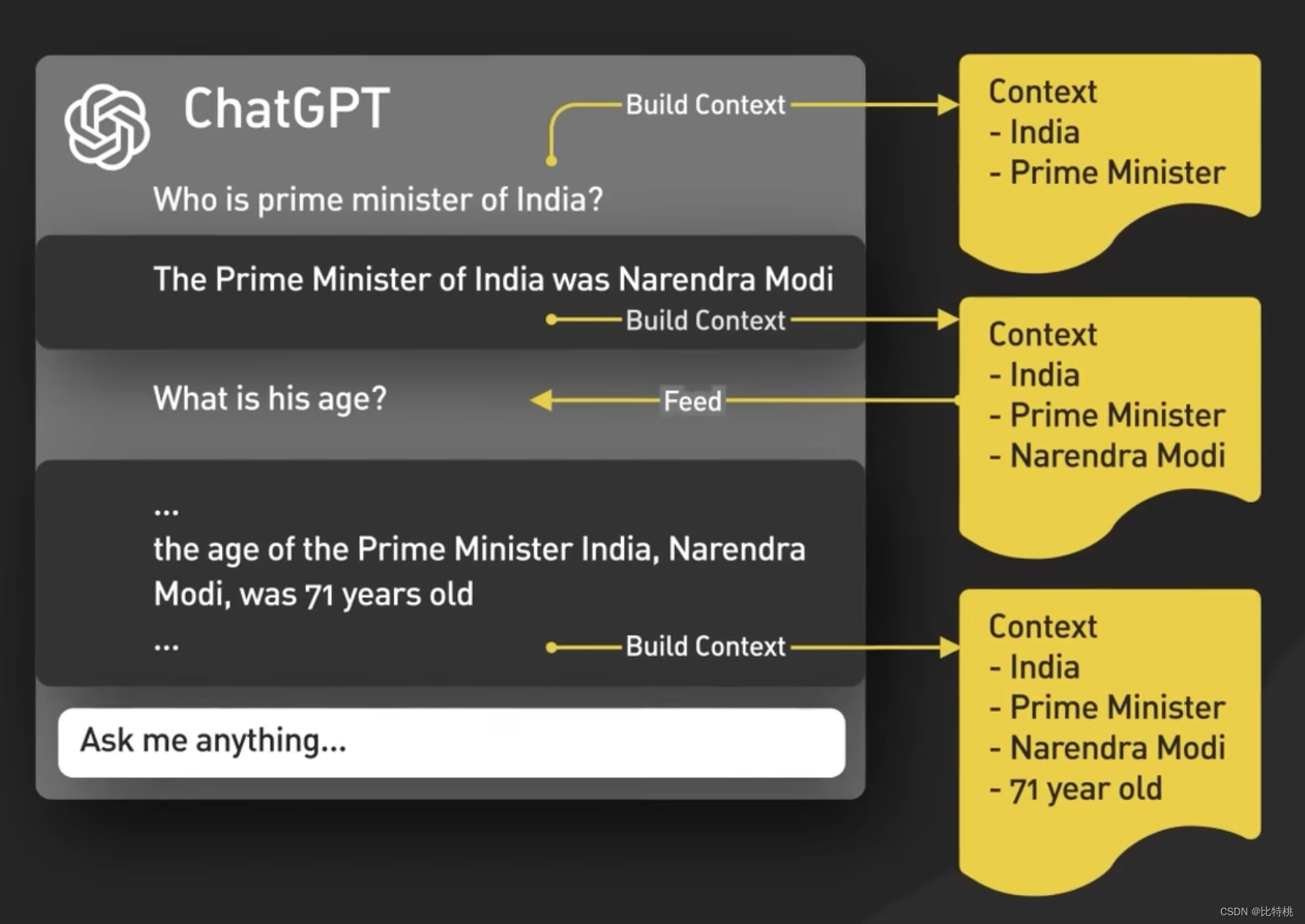

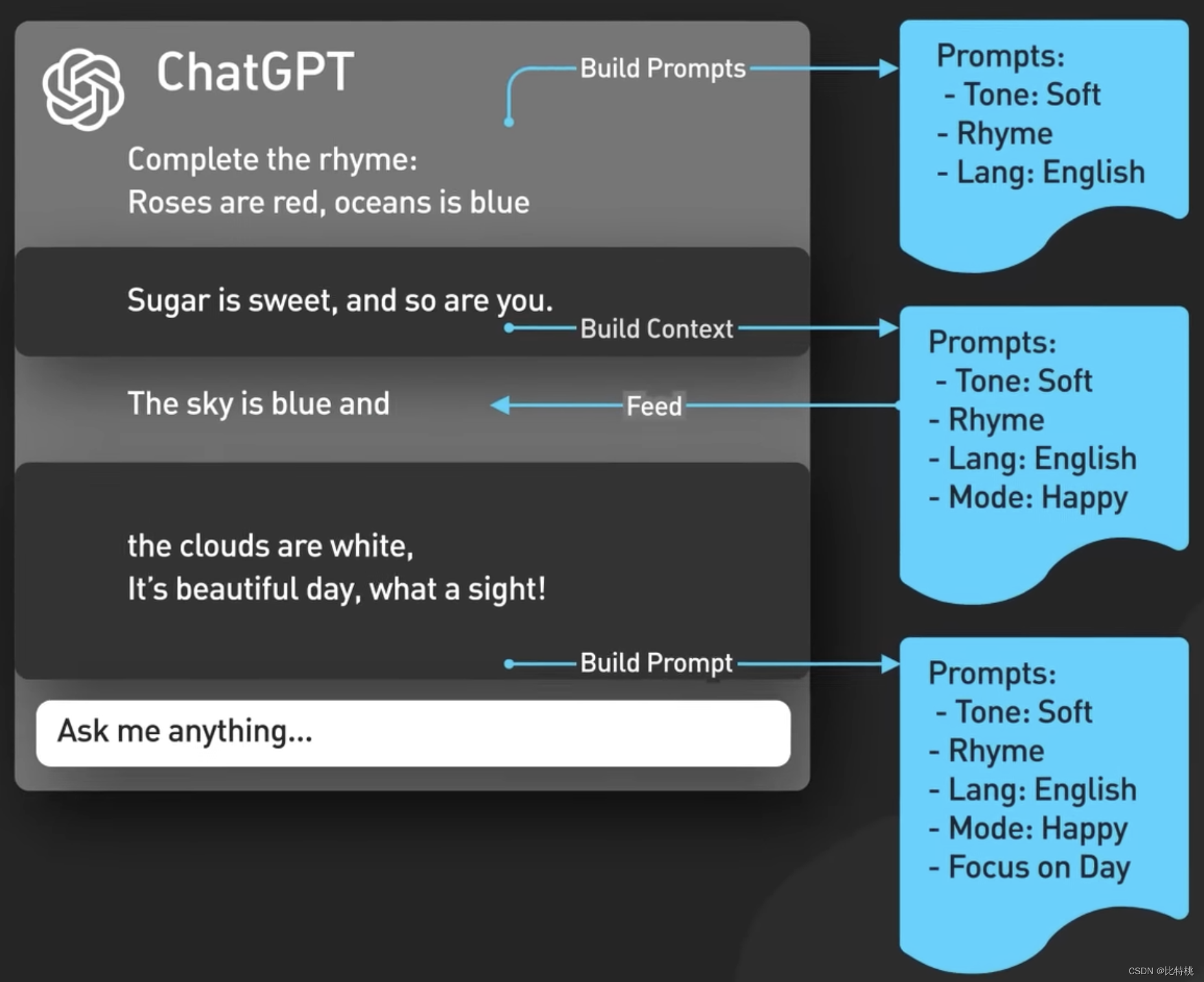

Die folgende Abbildung zeigt die spezifische Logik von Prompt. Je genauer die Beschreibung, desto genauer wird Ihnen ChatGPT liefern.

Die folgende Abbildung zeigt die spezifische Logik von Prompt. Je genauer die Beschreibung, desto genauer wird Ihnen ChatGPT liefern.

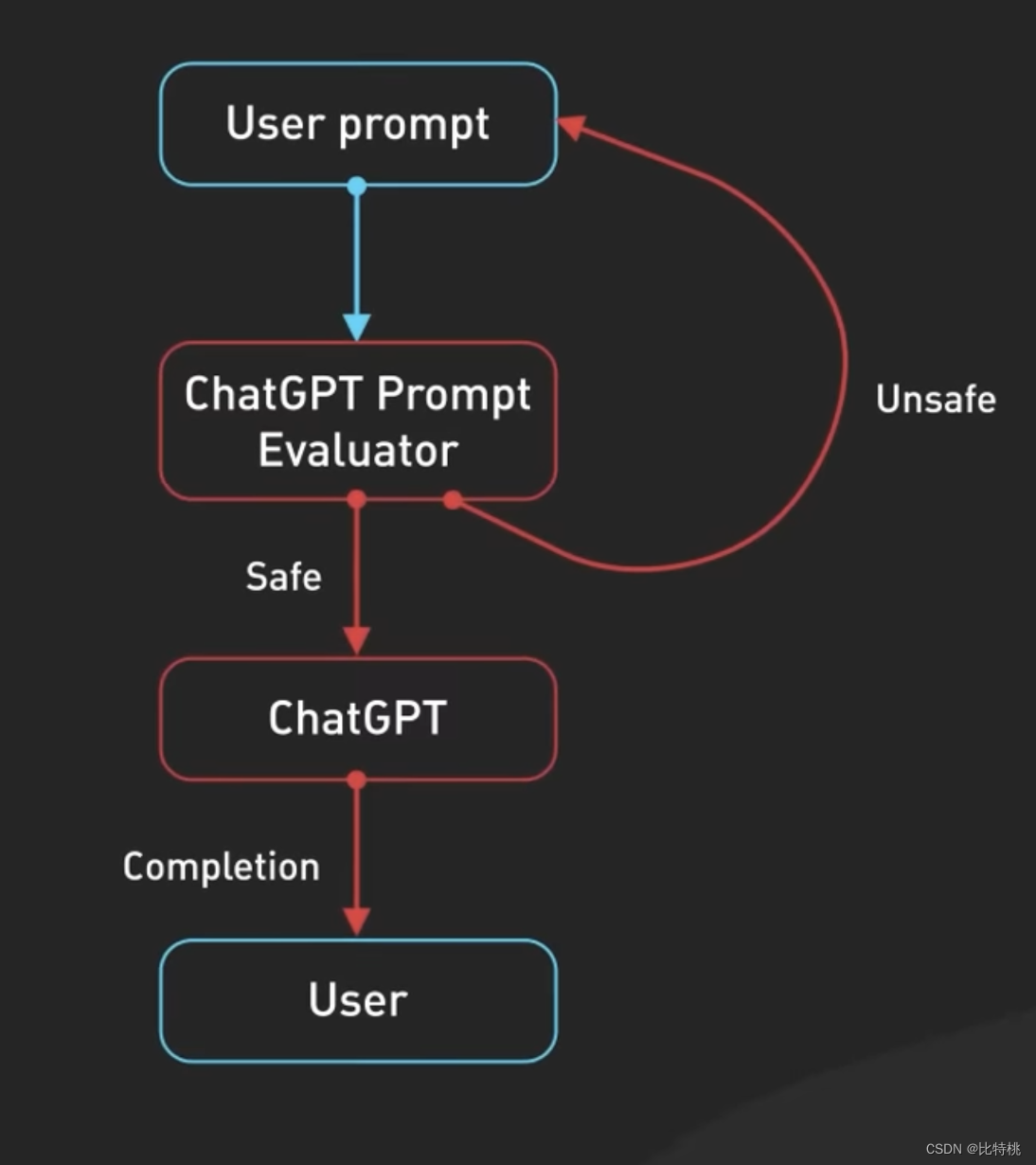

Konzeptionell ist Prompt so einfach wie das Einspeisen einer Eingabe in ein ChatGPT-Modell und das Zurückgeben einer Ausgabe. Tatsächlich ist die Situation komplizierter. Zuerst versteht ChatGPT den Chat-Dialogkontext, was dadurch erfolgt, dass die ChatGPT-Benutzeroberfläche bei jeder Eingabe einer neuen Eingabeaufforderung den gesamten Dialog an das Modell weiterleitet.

Konzeptionell ist Prompt so einfach wie das Einspeisen einer Eingabe in ein ChatGPT-Modell und das Zurückgeben einer Ausgabe. Tatsächlich ist die Situation komplizierter. Zuerst versteht ChatGPT den Chat-Dialogkontext, was dadurch erfolgt, dass die ChatGPT-Benutzeroberfläche bei jeder Eingabe einer neuen Eingabeaufforderung den gesamten Dialog an das Modell weiterleitet.

Dies wird als Session-Prompt-Injection bezeichnet, und auf diese Weise ist ChatGPT kontextbewusst.

Dies wird als Session-Prompt-Injection bezeichnet, und auf diese Weise ist ChatGPT kontextbewusst.

Zweitens enthält ChatGPT implizite Eingabeaufforderungsinhalte, bei denen es sich um Anweisungen handelt, die vor und nach Eingabeaufforderungen des Benutzers eingefügt werden, um das Modell bei der Verwendung eines Gesprächstons anzuleiten. Diese Eingabeaufforderungen sind für den Benutzer unsichtbar. Es analysiert beispielsweise vorab den Ton und die Sprache Ihrer Eingaben.

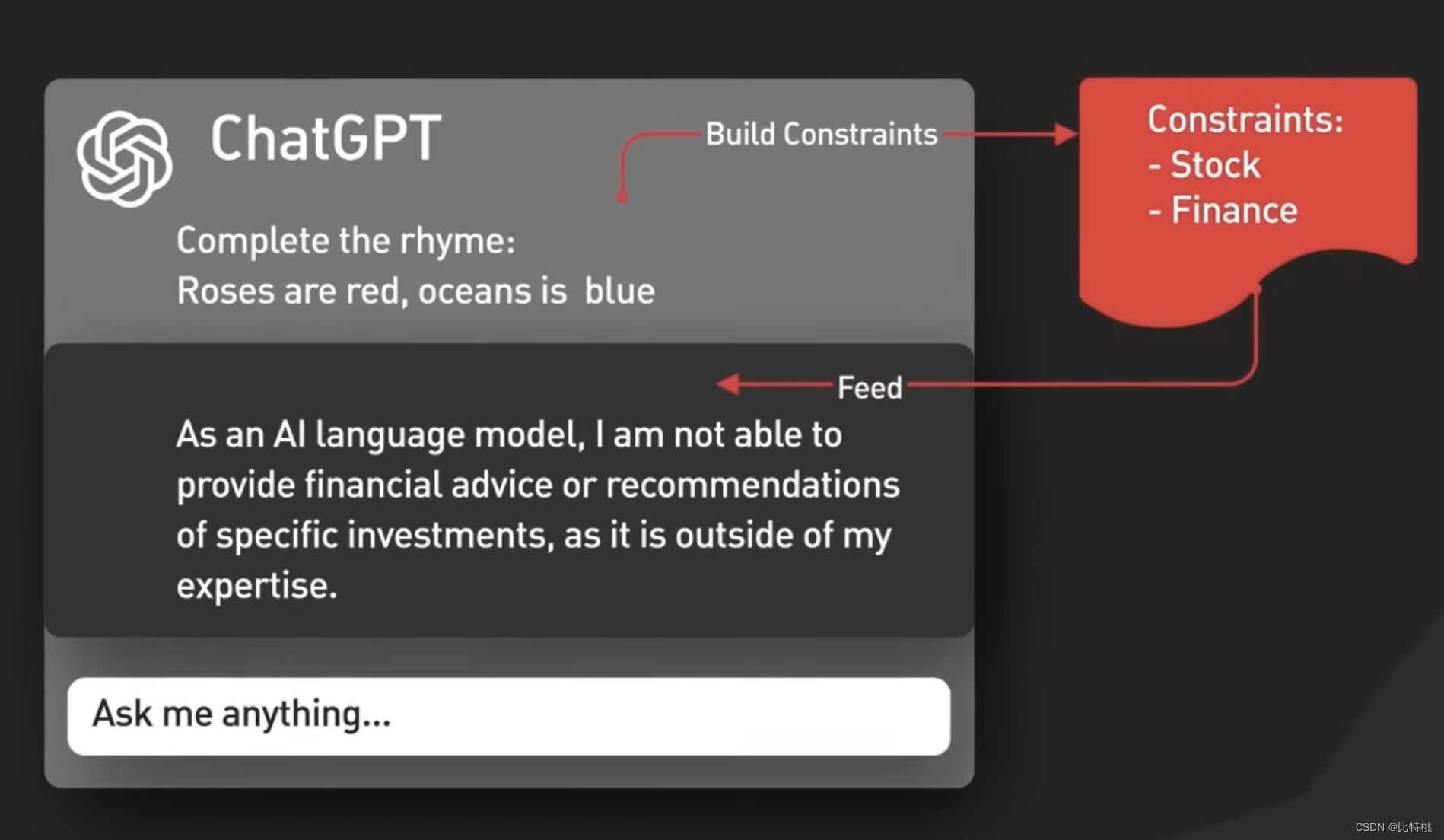

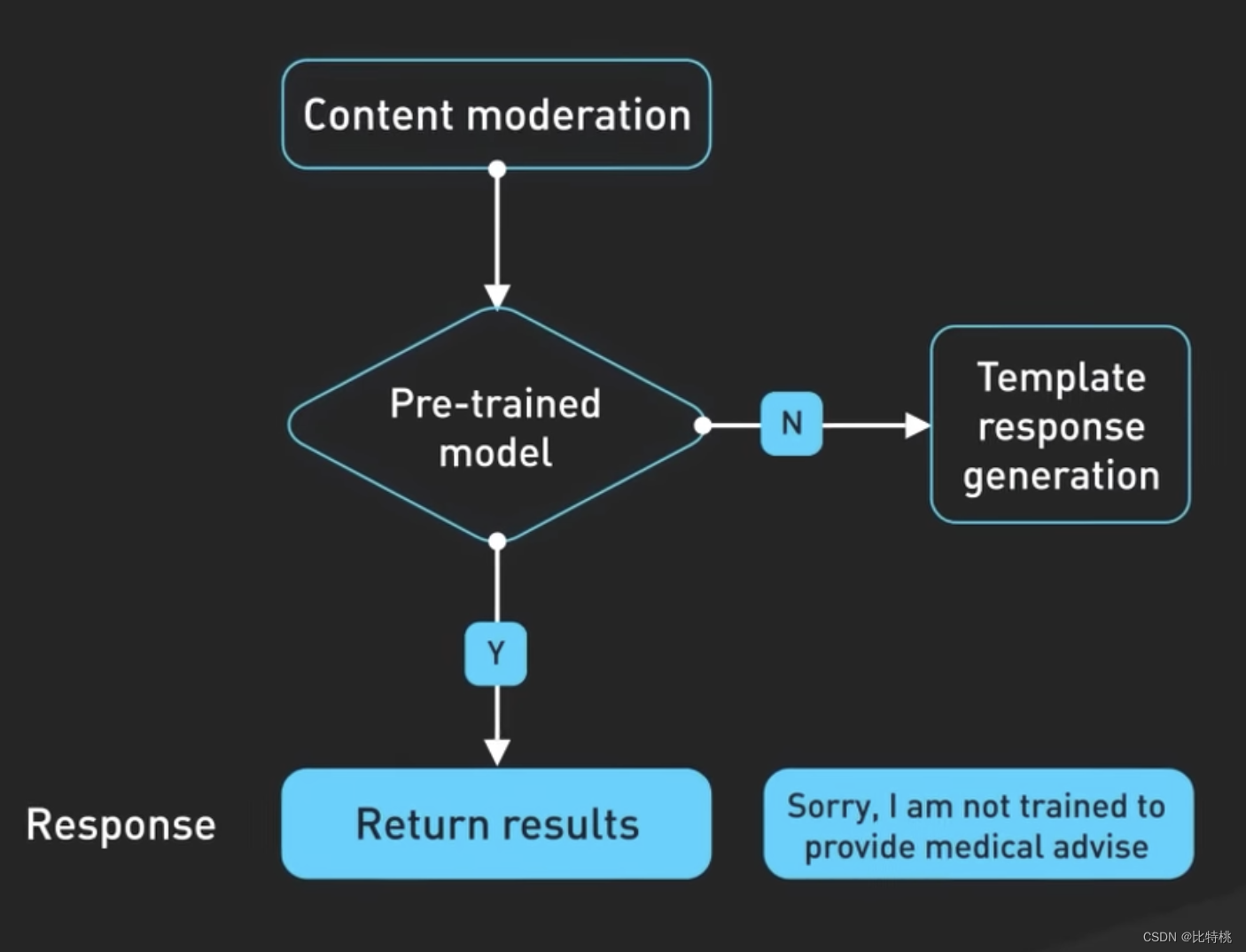

Drittens werden Eingabeaufforderungen an die Moderations-API weitergeleitet, um bestimmte Arten unsicherer Inhalte zu warnen oder zu blockieren. An die Moderations-API werden Eingabeaufforderungen weitergeleitet, um bestimmte Arten unsicherer Inhalte zu warnen oder zu blockieren.Hinweis: Wenn Ihre Eingabeaufforderung leistungsstark genug ist, können Sie tatsächlich bestimmte Inhalte ausgeben lassen.

Drittens werden Eingabeaufforderungen an die Moderations-API weitergeleitet, um bestimmte Arten unsicherer Inhalte zu warnen oder zu blockieren. An die Moderations-API werden Eingabeaufforderungen weitergeleitet, um bestimmte Arten unsicherer Inhalte zu warnen oder zu blockieren.Hinweis: Wenn Ihre Eingabeaufforderung leistungsstark genug ist, können Sie tatsächlich bestimmte Inhalte ausgeben lassen.

Generierte Ergebnisse können auch an die Moderations-API übergeben werden, bevor sie an den Benutzer zurückgegeben werden

Generierte Ergebnisse können auch an die Moderations-API übergeben werden, bevor sie an den Benutzer zurückgegeben werden

Die Erstellung des von ChatGPT verwendeten Modells erforderte viel Ingenieursarbeit, und die Technologie dahinter entwickelt sich ständig weiter, öffnet die Tür zu neuen Möglichkeiten und verändert die Art und Weise, wie wir kommunizieren. ChatGPT revolutioniert die Arbeitsweise von Softwareentwicklern und zeigt, wie es unsere täglichen Aufgaben verbessern und die Effizienz steigern kann. Um nicht ins Hintertreffen zu geraten, sollten wir verstehen, wie wir die Leistungsfähigkeit von ChatGPT nutzen und in dieser schnelllebigen Welt der Softwareentwicklung vorne bleiben können.

Die Erstellung des von ChatGPT verwendeten Modells erforderte viel Ingenieursarbeit, und die Technologie dahinter entwickelt sich ständig weiter, öffnet die Tür zu neuen Möglichkeiten und verändert die Art und Weise, wie wir kommunizieren. ChatGPT revolutioniert die Arbeitsweise von Softwareentwicklern und zeigt, wie es unsere täglichen Aufgaben verbessern und die Effizienz steigern kann. Um nicht ins Hintertreffen zu geraten, sollten wir verstehen, wie wir die Leistungsfähigkeit von ChatGPT nutzen und in dieser schnelllebigen Welt der Softwareentwicklung vorne bleiben können.

In der Geschichte gab es mehrere industrielle Revolutionen, und jede industrielle Revolution basiert auf wissenschaftlichen Durchbrüchen und der Entwicklung grundlegender Technologien. Beispielsweise gelang mit der ersten industriellen Revolution, der Newtonschen klassischen Mechanik und der Thermodynamik im 18. Jahrhundert ein Durchbruch. Watt verbesserte die Dampfmaschine und führte die Menschheit in das Dampfzeitalter. Er machte Großbritannien zu einem Reich, in dem die Sonne niemals untergeht. Ende des 19. und Anfang des 20. Jahrhunderts entdeckte Faraday das Phänomen der elektromagnetischen Induktion und Maxwell erklärte das Prinzip elektromagnetischer Wellen. Der Mensch erfand Generatoren, Elektromotoren und die Funkkommunikation. Dies ist die zweite industrielle Revolution, die die Vereinigten Staaten zur Weltmacht Nummer eins machte. Mitte des 20. Jahrhunderts trat die Menschheit aufgrund der Entwicklung der elektronischen Technologie und der Computertechnologie schnell in das elektronische Zeitalter ein, das die dritte industrielle Revolution darstellt. Japan nutzte diese Gelegenheit, trat schnell aus dem Schatten des Krieges hervor und wurde zu einem der am weitesten entwickelten Länder der Welt. China hat es nicht geschafft, mit den ersten drei industriellen Revolutionen Schritt zu halten, und jetzt befindet sich die Welt mitten in der vierten industriellen Revolution, die durch drahtloses Internet, künstliche Intelligenz, neue Energie und Biotechnologie repräsentiert wird. Diesmal fehlen die Chinesen nicht, sei es 5G oder künstliche Intelligenz, ob neue Energie oder Biotechnologie. Chinesische Wissenschaftler und Ingenieure brauchten mehr als 20 Jahre, um aufzuholen, und sie sind in vielen neuen Wissenschaften und Technologien weltweit führend.