(Milliarden-Fotos./Shutterstock)

Im letzten Jahr kam es zu einem explosionsartigen Anstieg der LLM-Aktivitäten, wobei allein chatgpt die Zahl übertraf 100 Millionen Nutzer. Und die Aufregung ist in den Vorstandsetagen aller Branchen angekommen, vom Gesundheitswesen über Finanzdienstleistungen bis hin zur Hightech-Branche. Der einfache Teil besteht darin, das Gespräch zu beginnen: Fast jede Organisation, mit der wir sprechen, teilt uns mit, dass sie ein ChatGPT für ihr Unternehmen möchte. Als nächstes kommt der schwierigere Teil: „Was soll dieser interne LLM also tun?“

Wie Vertriebsteams gerne sagen: „Was ist Ihr eigentlicher Anwendungsfall?“, aber hier kommt die Hälfte der Gespräche ins Stocken. Die meisten Organisationen kennen ihren Anwendungsfall einfach nicht.

Die einfache Chat-Schnittstelle von ChatGPT hat der ersten Welle von LLM-Anwendern ein einfaches Interaktionsmuster beigebracht: Sie stellen eine Frage und erhalten eine Antwort zurück. In gewisser Weise hat uns die Verbraucherversion gelehrt, dass LLMs im Wesentlichen ein prägnanteres google sind. Aber richtig eingesetzt ist die Technologie noch viel leistungsfähiger.

Der Zugriff auf ein internes KI-System, das Ihre Daten versteht, ist mehr als eine bessere interne Suche. Die richtige Denkweise ist nicht „ein etwas besseres Google (oder Gott bewahre, Clippy) in Bezug auf interne Daten“. Die richtige Art, über sie nachzudenken, ist als Belegschaftsmultiplikator. Machen Sie mehr, indem Sie mehr automatisieren, insbesondere wenn Sie mit Ihren unstrukturierten Daten arbeiten.

In diesem Artikel werden wir einige der wichtigsten Anwendungen von LLMs behandeln, die wir in Unternehmen sehen und die tatsächlich den Geschäftswert steigern. Wir fangen einfach an, mit denen, die uns bekannt vorkommen, und arbeiten uns bis zum neuesten Stand vor.

Top-LLM-Anwendungsfälle im Unternehmen

Wir werden fünf Kategorien von Anwendungsfällen beschreiben; Für jeden erläutern wir, was wir unter dem Anwendungsfall verstehen, warum LLMs gut passen und ein konkretes Beispiel für eine Anwendung in der Kategorie.

Die Kategorien sind:

- Fragen und Antworten und Suche (z. B. Chatbots)

- Informationsextraktion (Erstellung strukturierter Tabellen aus Dokumenten)

- Textklassifizierung

- Generative KI

- Ein Beispiel hierfür sind die Kombination von traditionellem ML und LLMs – Personalisierungssysteme.

Für jeden Fall kann es auch hilfreich sein zu verstehen, ob die Lösung des Anwendungsfalls eine Änderung des LLM erfordert Wissen – die Reihe von Fakten oder Inhalten, denen es ausgesetzt war, oder Begründung – wie es auf der Grundlage dieser Fakten Antworten generiert. Standardmäßig werden die am weitesten verbreiteten LLMs auf englischsprachigen Daten aus dem Internet als Wissensbasis trainiert und „beigebracht“, eine ähnliche Sprache zu generieren.

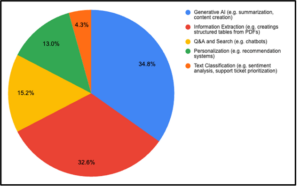

In den letzten drei Monaten haben wir 150 Führungskräfte, Datenwissenschaftler, Ingenieure für maschinelles Lernen, Entwickler und Produktmanager in großen und kleinen Unternehmen zu ihrer internen Nutzung von LLMs befragt. Dies wird zusammen mit den Kunden, mit denen wir täglich zusammenarbeiten, unsere Erkenntnisse hier vorantreiben.

Selbstberichteter Anwendungsfall aus einer Umfrage unter 150 Datenexperten

Anwendungsfall Nr. 1: Fragen und Antworten und Suche

Ehrlich gesagt denken die meisten Kunden zuerst daran, wenn sie ChatGPT intern übersetzen: Sie möchten Fragen zu ihren Dokumenten stellen.

Im Allgemeinen eignen sich LLMs gut für diese Aufgabe, da Sie Ihre interne Dokumentation im Wesentlichen „indizieren“ und einen Prozess namens „Indizieren“ verwenden können Augmented Generation abrufen (RAG), um neues, unternehmensspezifisches Wissen an die gleiche LLM Reasoning Pipeline weiterzugeben.

Beim Aufbau eines Frage-und-Antwort-Systems mit LLMs sollten Unternehmen zwei wesentliche Vorbehalte beachten:

- LLMs sind nicht deterministisch – sie können halluzinieren, und Sie benötigen Leitplanken entweder an den Ausgängen oder wie das LLM in Ihrem Unternehmen eingesetzt wird sich davor zu schützen.

- LLMs sind nicht gut für analytische Berechnungen oder „aggregierte“ Abfragen – wenn Sie einem LLM 100 Finanzunterlagen geben und fragen, „Welches Unternehmen hat das meiste Geld verdient“, müssen Sie das Wissen über viele Unternehmen zusammenfassen und vergleichen, um eine einzige Antwort zu erhalten. Im Auslieferungszustand wird es scheitern, aber wir werden in Anwendungsfall Nr. 2 Strategien zur Bewältigung dieses Problems behandeln.

Beispiel: Wissenschaftlern dabei helfen, Erkenntnisse aus verstreuten Berichten zu gewinnen

Eine gemeinnützige Organisation, mit der wir zusammenarbeiten, ist international führend im Umweltschutz. Sie erstellen detaillierte PDF-Berichte für die Hunderte von Projekten, die sie jährlich sponsern. Da das Budget begrenzt ist, muss die Organisation Programmgelder sorgfältig den Projekten zuweisen, die die besten Ergebnisse liefern. In der Vergangenheit war hierfür ein kleines Team erforderlich, das Tausende von Seiten mit Berichten überprüfte. Der Tag hat nicht genügend Stunden, um dies effektiv zu tun. Durch die Erstellung einer LLM-Frage-und-Antwort-Anwendung auf der Grundlage ihres großen Dokumentenbestands kann die Organisation nun schnell Fragen stellen wie: „Welche sind die fünf Regionen, in denen wir mit der Wiederaufforstung den größten Erfolg hatten?“ Diese neuen Funktionen haben es der Organisation ermöglicht, in Echtzeit intelligentere Entscheidungen über ihre Projekte zu treffen.

Anwendungsfall Nr. 2: Informationsextraktion

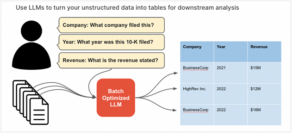

Es wird geschätzt, dass rund 80 % aller Daten unstrukturiert sind und ein Großteil dieser Daten in Dokumenten enthaltene Texte sind. Der ältere Verwandte der Frage-Antwort-Methode, die Informationsextraktion, soll die analytischen und aggregierten Aufgaben lösen, die Unternehmen über diese Dokumente beantworten müssen.

Der Prozess zum Aufbau einer effektiven Informationsextraktion umfasst die Ausführung eines LLM über jedes Dokument, um relevante Informationen zu „extrahieren“ und eine Tabelle zu erstellen, die Sie abfragen können.

Beispiel: Strukturierte Erkenntnisse für das Gesundheitswesen und das Bankwesen erstellen

Die Informationsextraktion ist in einer Reihe von Branchen nützlich, beispielsweise im Gesundheitswesen, wo Sie strukturierte Patientenakten möglicherweise mit Daten aus PDF-Laborberichten oder Arztbriefen anreichern möchten. Ein weiteres Beispiel ist das Investmentbanking. Ein Fondsmanager kann aus einem großen Korpus unstrukturierter Finanzberichte, etwa 10.000, strukturierte Tabellen mit Feldern wie Umsatz pro Jahr, Anzahl der Kunden, neue Produkte, neue Märkte usw. erstellen. Diese Daten können dann analysiert werden, um die beste Investition zu ermitteln Optionen. Schau dir das an kostenloses Beispiel Notizbuch darüber, wie Sie Informationen extrahieren können.

Anwendungsfall Nr. 3: Textklassifizierung

Normalerweise handelt es sich bei der Textklassifizierung um die Domäne traditioneller Modelle für überwachtes maschinelles Lernen. Sie ist eine klassische Methode, mit der High-Tech-Unternehmen große Sprachmodelle verwenden, um Aufgaben wie die Triage von Support-Tickets, die Moderation von Inhalten, die Stimmungsanalyse und mehr zu automatisieren. Der Hauptvorteil, den LLMs gegenüber überwachtem ML haben, ist die Tatsache, dass sie operieren können Nullschussalso ohne Trainingsdaten oder die Notwendigkeit, das zugrunde liegende Basismodell anzupassen.

(Ascannio/Shutterstock)

Wenn Sie Trainingsdaten als Beispiele haben, anhand derer Sie Ihr Modell verfeinern möchten, um eine bessere Leistung zu erzielen, unterstützen LLMs diese Funktion auch sofort. Die Feinabstimmung trägt in erster Linie dazu bei, die Argumentation des LLM zu ändern, indem man ihn beispielsweise dazu auffordert, einigen Teilen einer Eingabe mehr Aufmerksamkeit zu schenken als anderen. Es kann auch hilfreich sein, Ihnen beim Training zu helfen kleiner Modell (da es nicht erforderlich ist, französische Gedichte zu rezitieren, reicht es aus, Support-Tickets zu klassifizieren), dessen Bereitstellung kostengünstiger sein kann.

Beispiel: Automatisierung des Kundensupports

Forethought, ein führender Anbieter von Kundensupport-Automatisierung, nutzt LLMs für eine breite Palette von Lösungen wie intelligente Chatbots und die Klassifizierung von Support-Tickets, um Kundendienstmitarbeitern dabei zu helfen, Probleme schneller zu priorisieren und zu selektieren. Ihre Arbeit mit LLMs ist hier dokumentiert realer Anwendungsfall mit Upwork.

Anwendungsfall Nr. 4: Generative Aufgaben

Der Einstieg in die innovativeren Anwendungsfälle ist die Klasse von Anwendungsfällen, bei denen ein Unternehmen ein LLM verwenden möchte, um Inhalte zu generieren, häufig für eine Endbenutzeranwendung.

Sie haben selbst bei ChatGPT bereits Beispiele dafür gesehen, wie den Klassiker „Schreiben Sie mir einen Blog-Beitrag über LLM-Anwendungsfälle“. Aber unseren Beobachtungen zufolge sind generative Aufgaben im Unternehmen in der Regel einzigartig, da sie in der Regel darauf abzielen, welche zu generieren strukturierte Ausgabe. Diese strukturierte Ausgabe kann Code sein, der an einen Compiler gesendet wird, JSON, das an eine Datenbank gesendet wird, oder eine Konfiguration, die dabei hilft, bestimmte Aufgaben intern zu automatisieren.

Eine strukturierte Generierung kann schwierig sein. Die Ausgabe muss nicht nur korrekt sein, sondern auch korrekt formatiert sein. Aber wenn sie erfolgreich sind, ist dies eine der effektivsten Möglichkeiten, wie LLMs dabei helfen können, natürliche Sprache in eine für Maschinen lesbare Form zu übersetzen und so die interne Automatisierung zu beschleunigen.

Beispiel: Code generieren

In diesem kurzes Tutorial-Videozeigen wir, wie mit einem LLM JSON generiert werden kann, das dann zur Automatisierung nachgelagerter Anwendungen verwendet werden kann, die über API funktionieren.

(FrimuFilms/Shutterstock)

Anwendungsfall Nr. 5: Kombination von ML und LLMs

Autoren sollten keine Favoriten haben, aber mein Lieblingsanwendungsfall ist der, den wir zuletzt von Unternehmen sehen, die auf dem neuesten Stand der Produktion von ML-Anwendungen sind: die Kombination von traditionellem maschinellem Lernen mit LLMs. Die Kernidee besteht darin, den Kontext und die Wissensbasis eines LLM mit Vorhersagen zu erweitern, die aus einem überwachten ML-Modell stammen und dem LLM zusätzliche Möglichkeiten bieten Argumentation darüber hinaus. Anstatt eine Standarddatenbank als Wissensbasis für ein LLM zu verwenden, verwenden Sie im Wesentlichen ein separates Modell für maschinelles Lernen.

Ein gutes Beispiel hierfür ist die Verwendung von Einbettungen und einem Empfehlungssystemmodell zur Personalisierung.

Beispiel: Konversationsempfehlung für E-Commerce

Ein E-Commerce-Anbieter, mit dem wir zusammenarbeiten, war daran interessiert, ein personalisierteres Einkaufserlebnis zu schaffen, das natürlichsprachliche Abfragen wie „Welche Herrenschuhe aus Leder würden Sie für eine Hochzeit empfehlen?“ nutzt. Sie bauten ein Empfehlungssystem mit überwachtem ML auf, um personalisierte Empfehlungen basierend auf dem Profil eines Kunden zu generieren. Die Werte werden dann einem LLM zugeführt, sodass der Kunde über eine chatähnliche Oberfläche Fragen stellen kann. Ein Beispiel für diesen Anwendungsfall können Sie hier sehen kostenloses Notizbuch.

Die Bandbreite hochwertiger Anwendungsfälle für LLMs geht weit über Chatbots im ChatGPT-Stil hinaus. Teams, die mit LLMs beginnen möchten, können kommerzielle LLM-Angebote nutzen oder Open-Source-LLMs wie Llama-2 oder Vicuna auf ihren eigenen Daten in ihrer Cloud-Umgebung mit gehosteten Plattformen wie anpassen Prädibase.

Über den Autor: Devvret Rishi ist Mitbegründer und Chief Product Officer von Prädibase, ein Anbieter von Tools für die Entwicklung von KI- und maschinellen Lernanwendungen. Vor Predibase war Devvret Produktmanager bei Google und Lehrbeauftragter für den Kurs „Einführung in künstliche Intelligenz“ der Harvard University.

Ähnliche Artikel:

OpenAI führt ChatGPT Enterprise ein

GenAI debütiert an der Spitze des Hype-Zyklus 2023 von Gartner

Die grenzenlosen Geschäftsmöglichkeiten der generativen KI