|

Hören Sie sich diesen Artikel an |

Boston Dynamics hat seinen Spot-Vierbeiner, der normalerweise für Inspektionen verwendet wird, in einen Roboter-Reiseführer verwandelt. Das Unternehmen integrierte den Roboter in chatgpt und andere KI-Modelle als Machbarkeitsnachweis für die potenziellen Robotikanwendungen grundlegender Modelle.

Im letzten Jahr haben wir enorme Fortschritte bei den Fähigkeiten der generativen KI erlebt, und viele dieser Fortschritte wurden durch den Aufstieg großer Foundation Models (FMs) vorangetrieben. FMs sind große KI-Systeme, die auf einem riesigen Datensatz trainiert werden.

Diese FMs verfügen typischerweise über Millionen von Milliarden Parametern und wurden durch das Sammeln von Rohdaten der interessierten Öffentlichkeit trainiert. All diese Daten geben ihnen die Möglichkeit, neue Verhaltensweisen zu entwickeln oder Aufgaben auszuführen, die über das hinausgehen, wofür sie direkt trainiert wurden. Dadurch können sie für eine Vielzahl von Anwendungen angepasst werden und als Grundlage für andere Algorithmen dienen.

Das Team von Boston Dynamics verbrachte den Sommer damit, einige Proof-of-Concept-Demos mit FMs für Roboteranwendungen zusammenzustellen. Diese Demos erweiterte das Team dann im Rahmen eines internen Hackathons. Das Unternehmen war besonders an einer Demo interessiert, in der Spot Entscheidungen in Echtzeit auf der Grundlage der FM-Ausgabe trifft.

Große Sprachmodelle (LLMs) wie ChatGPT sind im Grunde sehr leistungsfähige Autovervollständigungsalgorithmen mit der Fähigkeit, einen Textstrom aufzunehmen und das nächste Textbit vorherzusagen. Das Team von Boston Dynamics interessierte sich für die Fähigkeit von LLMs, Rollenspiele zu spielen, Kultur und Nuancen zu reproduzieren, Pläne zu formulieren und über einen längeren Zeitraum Kohärenz aufrechtzuerhalten. Das Team ließ sich auch von kürzlich veröffentlichten VQA-Modellen (Visual Question Answering) inspirieren, mit denen Bilder beschriftet und einfache Fragen dazu beantwortet werden können.

Ein robotergestützter Reiseführer schien die perfekte Demo zu sein, um diese Konzepte zu testen. Der Roboter würde herumlaufen, Objekte in der Umgebung betrachten und sie dann mithilfe eines VQA- oder Beschriftungsmodells beschreiben. Der Roboter würde auch ein LLM verwenden, um diese Beschreibungen auszuarbeiten, Fragen des Tourpublikums zu beantworten und zu planen, welche Maßnahmen als nächstes zu ergreifen sind.

Laut dem Boston Dynamics-Team fungiert der LLM in diesem Szenario als Improvisationsschauspieler. Der Ingenieur stellt ihm einen breiten Strichplan zur Verfügung und der LLM füllt die Lücken im Handumdrehen aus. Das Team wollte die Stärken des LLM ausspielen und suchte daher nicht nach einer vollkommen sachlichen Tour. Stattdessen suchten sie nach Unterhaltung, Interaktivität und Nuancen.

Spot in einen Reiseführer verwandeln

Das Hardware-Setup für den Spot-Tourguide. 1. Spot EAP 2; 2. Reseaker V2; 3. Bluetooth-Lautsprecher; 4. Spotarm und Greiferkamera. | Quelle: Boston Dynamics

Für die vom Team geplante Demo musste Spot in der Lage sein, mit einer Gruppe zu sprechen und Fragen und Anregungen von ihnen zu hören. Boston Dynamics hat eine vibrationsfeste Halterung für einen Respeaker V2-Lautsprecher in 3D gedruckt. Sie befestigten dies über einen USB-Anschluss an der EAP-2-Nutzlast von Spot.

Spot wird über einen Offboard-Computer gesteuert, entweder einen Desktop-PC oder einen Laptop, der für die Kommunikation das SDK von Spot nutzt. Das Team fügte einen einfachen Spot SDK-Dienst hinzu, um Audio mit der EAP 2-Nutzlast zu kommunizieren.

Da Spot nun in der Lage war, mit Audio umzugehen, musste das Team ihm Konversationsfähigkeiten verleihen. Sie begannen mit der ChaptGPT-API von OpenAI auf gpt-3.5 und führten dann ein Upgrade auf gpt-4 durch, als es verfügbar wurde. Darüber hinaus führte das Team Tests an kleineren Open-Source-LLMs durch.

Das Team ließ sich von Forschungen bei Microsoft inspirieren und veranlasste GPT, indem es den Eindruck erweckte, als würde es die nächste Zeile in einem Python-Skript schreiben. Anschließend stellten sie dem LLM eine englische Dokumentation in Form von Kommentaren zur Verfügung und bewerteten die Ausgabe des LLM, als wäre es Python-Code.

Das Boston Dynamics-Team gewährte dem LLM außerdem Zugriff auf sein SDK, eine Karte des Tourgeländes mit einzeiligen Beschreibungen der einzelnen Standorte und die Möglichkeit, Sätze zu sagen oder Fragen zu stellen. Dies erreichten sie durch die Integration einer VQA- und Speech-to-Text-Software.

Sie speisten die Greifkamera und die Vorderkörperkamera des Roboters in BLIP-2 ein und ließen es entweder im visuellen Frage-Antwort-Modus oder im Bildunterschriftsmodus laufen. Dies wird etwa einmal pro Sekunde ausgeführt und die Ergebnisse werden direkt in die Eingabeaufforderung eingespeist.

Um Spot die Möglichkeit zu geben, zu hören, speiste das Team Mikrofondaten in Blöcken in den Flüsterton von OpenAI ein, um sie in englischen Text umzuwandeln. Spot wartet auf ein Weckwort wie „Hey, Spot“, bevor es diesen Text in die Eingabeaufforderung einfügt, und unterdrückt den Ton, wenn er selbst spricht.

Da ChatGPT textbasierte Antworten generiert, musste das Team diese über ein Text-to-Speech-Tool laufen lassen, damit der Roboter auf die Zielgruppe reagieren konnte. Das Team probierte eine Reihe handelsüblicher Text-to-Speech-Methoden aus, entschied sich jedoch für den Cloud-Dienst ElevenLabs. Um die Latenz zu reduzieren, streamten sie den Text auch parallel als „Phrasen“ auf die Plattform und spielten dann den generierten Ton ab.

Das Team wollte außerdem, dass Spot eine natürlichere Körpersprache hat. Deshalb verwendeten sie im Spot 3.3-Update eine Funktion, die es dem Roboter ermöglicht, sich bewegende Objekte zu erkennen und zu verfolgen, um zu erraten, wo sich die nächste Person befand, und ließen den Roboter dann seinen Arm in Richtung dieser Person drehen.

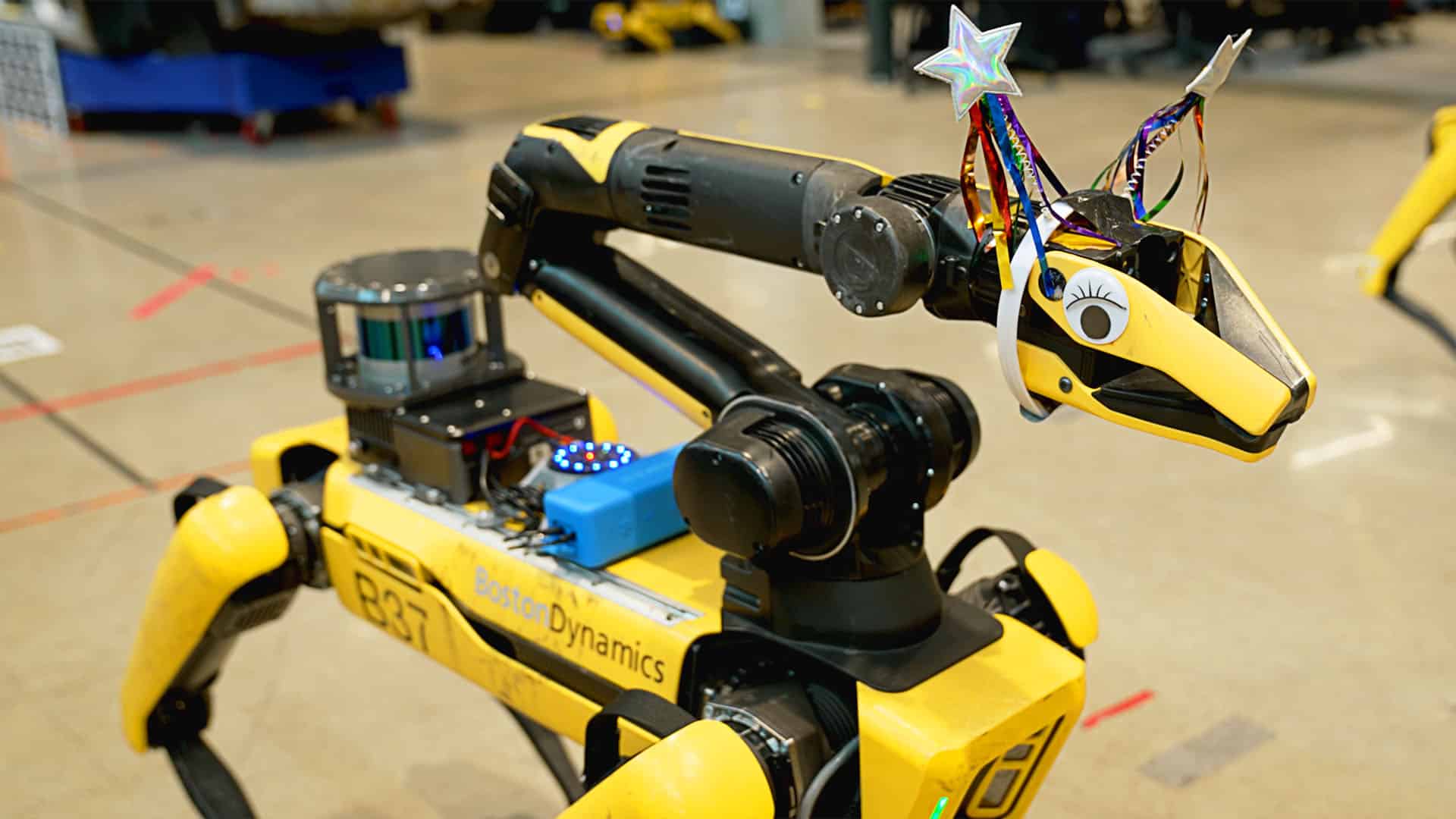

Mithilfe eines Tiefpassfilters für die erzeugte Sprache konnte das Team erreichen, dass der Greifer die Sprache nachahmt, sozusagen den Mund einer Marionette. Diese Illusion wurde verstärkt, als das Team dem Greifer Kostüme oder Kulleraugen hinzufügte.

Wie hat sich Spot entwickelt?

Das Team verpasste Spots Arm einen Hut und Kulleraugen, um ihn ansprechender zu machen. | Quelle: Boston Dynamics

Das Team bemerkte, dass aus dem sehr einfachen Aktionsraum des Roboters schnell neues Verhalten hervorging. Sie fragten den Roboter: „Wer ist Marc Raibert?“ Der Roboter kannte die Antwort nicht und teilte dem Team mit, dass er zum IT-Helpdesk gehen und nachfragen würde, wofür er jedoch nicht programmiert war. Das Team fragte Spot auch, wer seine Eltern seien, und ging dorthin, wo im Büro die älteren Versionen von Spot, Spot V1 und Big Dog, ausgestellt waren.

Diese Verhaltensweisen zeigen die Macht der statistischen Assoziation zwischen den Konzepten „Helpdesk“ und „eine Frage stellen“ sowie „Eltern“ und „alt“. Sie deuten nicht darauf hin, dass der LLM im menschlichen Sinne bewusst oder intelligent sei, so das Team.

Der LLM erwies sich auch als gut darin, den Charakter beizubehalten, auch wenn das Team ihm absurdere Persönlichkeiten zum Ausprobieren gab.

Obwohl das LLM eine gute Leistung erbrachte, konnte es während der Tour häufig wieder gutmachen. Beispielsweise wurde dem Team immer wieder mitgeteilt, dass Stretch, der Logistikroboter von Boston Dynamics, für Yoga gedacht sei.

Für die Zukunft plant das Team, die Schnittstelle zwischen künstlicher Intelligenz und Robotik weiter zu erforschen. Für sie bietet die Robotik eine gute Möglichkeit, große Fundamentmodelle in der realen Welt zu „erden“. Mittlerweile tragen diese Modelle auch dazu bei, kulturellen Kontext, allgemeines Wissen über den gesunden Menschenverstand und Flexibilität bereitzustellen, die für viele Roboteraufgaben nützlich sein könnten.