Das kommende Zeitalter leistungsstarker KI-Chatbots kann sehr wohl die Welt auf radikale und unvorhergesehene Weise umgestalten, aber es könnte dies zu immensen Kosten für die Umwelt tun. Ein neuer Bericht heute veröffentlicht vom Stanford Institute for Human-Centered Artificial Intelligence schätzt, wie viel Energie benötigt wird, um KI-Modelle zu trainieren OpenAIs GPT-3die den weltberühmten antreibt ChatGPT, könnte das Haus eines durchschnittlichen Amerikaners Hunderte von Jahren mit Strom versorgen. Von den drei in der Studie untersuchten KI-Modellen war das System von OpenAI bei weitem das energieintensivste-hungrig.

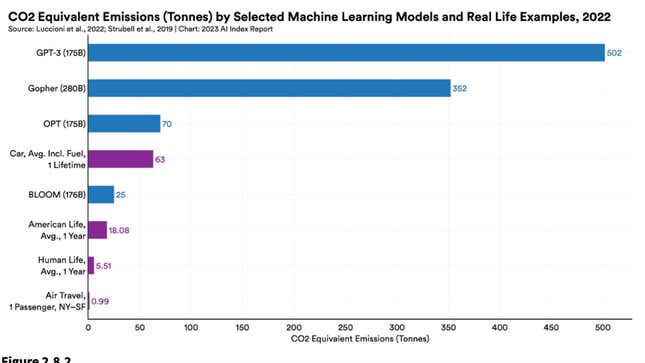

Die Forschung, die im kürzlich von Stanford veröffentlichten Artificial Intelligence Index hervorgehoben wird, stützt sich auf aktuelle Forschungsergebnisse zur Messung der Kohlenstoffkosten verbunden mit dem Training von vier Modellen: DeepMinds GopherBigScience-Initiativen‘ BLÜHEN, Metas OPTUnd OpenAIs GPT-3. Das Modell von OpenAI hat Berichten zufolge 502 Tonnen freigesetzt von Kohlenstoff während seiner Ausbildung. Um das ins rechte Licht zu rücken, das ist 1,4-mal mehr Kohlenstoff als Gopher und satte 20,1-mal mehr als BLOOM. GPT-3 benötigte mit 1.287 MWh auch den höchsten Stromverbrauch des Loses.

Zahlreiche Faktoren flossen in die Bestimmung des Energieverbrauchs jedes Modells ein, darunter die Menge der Datenpunkte oder Parameter, auf die sie trainiert wurden, und die Energieeffizienz der Rechenzentren, in denen sie untergebracht sind. Trotz der deutlichen Unterschiede im Energieverbrauch wurden drei der vier Modelle (mit Ausnahme von DeepMinds Gopher) mit etwa 175 Milliarden Parametern trainiert. OpenAI wird nicht sagen, wie viele Parameter es neu veröffentlicht hat GTP-4 trainiert wird, aber angesichts der enormen Datensprünge, die zwischen früheren Versionen erforderlich waren des Modells kann man davon ausgehen, dass GTP-4 benötigt noch mehr Daten als seine Vorgänger. Ein KI-Enthusiast schätzt GPT-4 könnte mit 100 Billionen Parametern trainiert werden, obwohl OpenAI-CEO Sam Altman dies getan hat seitdem diese Figur genannt„völliger Bullshit“.

„Wenn wir nur ohne Rücksicht auf die Umweltauswirkungen skalieren, können wir uns in eine Situation bringen, in der wir mit maschinellen Lernmodellen mehr schaden als nützen“, sagt Stanford-Forscher Peter Henderson sagte letztes Jahr. „Wir wollen das wirklich so weit wie möglich mildern und netto soziales Gutes bringen.“

KI-Modelle sind zweifellos datenhungrig, aber der Stanford-Bericht stellt fest, dass es möglicherweise noch zu früh ist, um zu sagen, ob dies unbedingt bedeutet, dass sie auf eine Umweltkatastrophe hindeuten oder nicht. Leistungsstarke KI-Modelle könnten in Zukunft zur Optimierung des Energieverbrauchs in Rechenzentren und anderen Umgebungen eingesetzt werden. In einem dreimonatigen Experiment konnte beispielsweise der BCOOLER-Agent von DeepMind etwa 12,7 % Energieeinsparung in einem Google-Rechenzentrum erzielen und gleichzeitig das Gebäude so kühl halten, dass die Menschen bequem arbeiten können.

Die Umweltkosten von KI spiegeln das Krypto-Klima-Dilemma wider

Wenn Ihnen das alles bekannt vorkommt, liegt das daran, dass wir im Grunde gesehen haben, wie sich diese Umweltdynamik vor einigen Jahren mit der letzten großen Besessenheit der Technologie abspielte: Krypto und Web3. In diesem Fall tauchte Bitcoin als der der Branche auf offensichtlicher umweltbedingter wunder Punkt zu den enormen Energiemengen, die zum Schürfen von Münzen in seinem Proof-of-Work-Modell benötigt werden. Einige Schätzungen empfehlen Allein Bitocin benötigt jedes Jahr mehr Energie als der jährliche Stromverbrauch Norwegens.

Jahrelange Kritik von Umweltaktivisten veranlasste die Kryptoindustrie jedoch, einige Änderungen vorzunehmen. Ethereum, die zweitgrößte Währung auf der Blockchain, offiziell geschaltet letztes Jahr zu einem Proof-of-Stake-Modell, von dem Befürworter behaupten, dass es seinen Stromverbrauch reduzieren könnte um über 99 %. Andere kleinere Münzen waren ähnlich auf Energieeffizienz ausgelegt. Im Großen und Ganzen stecken große Sprachmodelle noch in den Kinderschuhen, und es ist alles andere als sicher, wie sich ihr Umweltbericht entwickeln wird.

Große Sprachmodelle werden absurd teuer

Der Energiebedarf ist nicht die einzige Zahl, die bei neuen LLMs in die Höhe schießt. So sind ihre Preisschilder. Als OpenAI GPT 2 im Jahr 2019 veröffentlichte, stellte der Stanford-Bericht fest, dass es das Unternehmen nur 50.000 US-Dollar kostete, um sein Modell zu trainieren, das auf 1,5 Milliarden Parametern basiert. Nur drei Jahre später stellte Google sein eigenes leistungsstarkes PaLM-Modell vor, das mit 540 Milliarden Parametern trainiert wurde. Das Training dieses Modells kostet 8 Millionen Dollar. PaLM war dem Bericht zufolge etwa 360-mal größer als GPT-2 und kostete aber 160-mal mehr. Auch diese Modelle, die entweder von OpenAI oder Google veröffentlicht wurden, werden immer größer.

„Allgemein werden große Sprach- und multimodale Modelle immer größer und teurer“, stellt der Bericht fest.

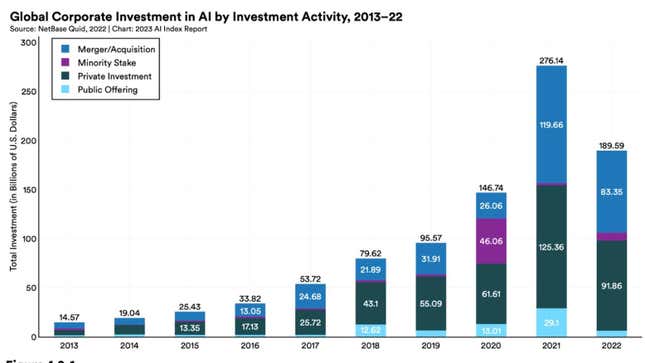

All dieses Geld könnte Übertragungseffekte in der Gesamtwirtschaft haben. Stanford schätzt, dass die Summe der privaten Investitionen in KI im Jahr 2022 weltweit 18-mal höher war als im Jahr 2013. Auch die KI-bezogenen Stellenausschreibungen in allen Sektoren, zuletzt in den USA, nehmen zu und stiegen von 1,7 % auf 1,9 % 2022. Auf globaler Ebene bleiben die USA in Bezug auf die Gesamtinvestitionen in KI unübertroffen und investierten Berichten zufolge im Jahr 2022 47,4 Milliarden US-Dollar in KI-Technologie. Das ist 3,5-mal mehr als China, das zweitgrößte Geldgeber. Wenn es darum geht, Geld zu verbrennen, ist Amerika unerreicht.

Der Gesetzgeber versucht, aufzuholen

Die jüngste Welle leistungsstarker Chatbots und ethischer und rechtlicher Fragen, die sie umgeben, hat sich an fast jeden außerhalb der KI-Ingenieure, einschließlich des Gesetzgebers, herangeschlichen. Langsam aber sicher versucht der Gesetzgeber, gesetzgeberisch aufzuholen. Im Jahr 2021 wurden laut Stanford-Bericht nur 2 % aller Bundesgesetze mit KI tatsächlich in Kraft gesetzt. Diese Zahl stieg letztes Jahr auf 10 %. Viele dieser Rechnungen wurden in ähnlicher Weise vor der aktuellen Hysterie um GPT4 und den vorschnellen Beschreibungen einiger Forscher geschrieben als „Künstliche allgemeine Intelligenz.“

Gesetzgeber interessieren sich auch mehr denn je für KI. Im Jahr 2022 identifizierte Stanford 110 KI-bezogene Rechtsfälle, die vor US-Bundes- und Landesgerichten verhandelt wurden. Das klingt vielleicht nicht nach viel, aber es sind immer noch 6,5-mal mehr Fälle als 2016 entdeckt wurden. Die Mehrheit dieser Fälle ereignete sich in Kalifornien, Illinois und New York. Rund 29 % dieser KI-Fälle betrafen das Zivilrecht, während 19 % Rechte des geistigen Eigentums betrafen. Wenn neu Beschwerden die von Schriftstellern und Künstlern über die Verwendung ihres Stils durch KI-Generatoren eingereicht werden, ist es möglich, dass der Anteil der Eigentumsrechtsfälle zunehmen könnte.

Möchten Sie mehr über KI, Chatbots und die Zukunft des maschinellen Lernens erfahren? Schauen Sie sich unsere vollständige Berichterstattung über an künstliche Intelligenzoder stöbern Sie in unseren Leitfäden zu Die besten kostenlosen KI-Kunstgeneratoren Und Alles, was wir über ChatGPT von OpenAI wissen.