Bildnachweis: PhonlamaiFoto / Getty Images

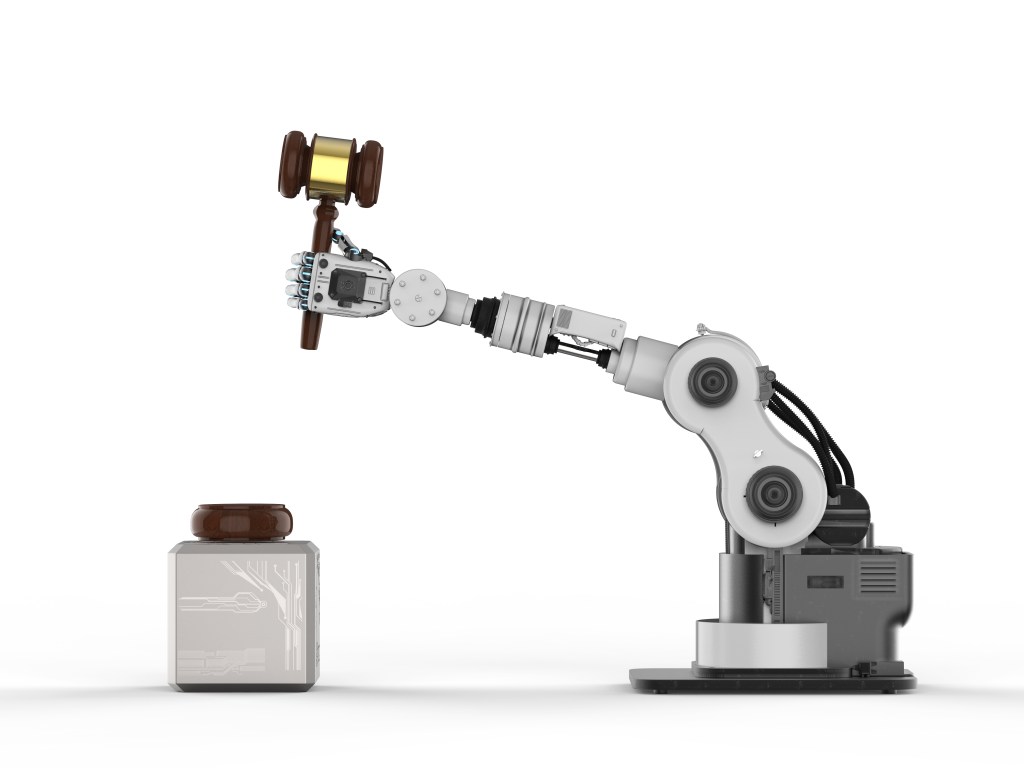

Nur wenige Anwälte wären dumm genug, eine KI ihre Argumente vortragen zu lassen, aber einer hat es bereits getan, und Richter Brantley Starr unternimmt Schritte, um sicherzustellen, dass sich das Debakel nicht wiederholt sein Gerichtssaal.

Der texanische Bundesrichter hat eine Anforderung hinzugefügt, dass jeder Anwalt, der vor seinem Gericht erscheint, bezeugen muss, dass „kein Teil der Akte durch generative künstliche Intelligenz verfasst wurde“ oder, wenn dies der Fall ist, dass sie „von einem Menschen“ überprüft wurde.

Letzte Woche erlaubte Anwalt Steven Schwartz chatgpt, seine juristischen Recherchen in einer aktuellen Bundesakte zu „ergänzen“, indem er ihm sechs Fälle und relevante Präzedenzfälle lieferte – die alle völlig vom Sprachmodell halluziniert waren. Er jetzt „bedauert sehr“, dies getan zu habenund während die landesweite Berichterstattung über diesen Fauxpas wahrscheinlich andere Anwälte dazu veranlasst hat, es noch einmal zu versuchen, geht Richter Starr kein Risiko ein.

Am Bundesstandort für den Nordbezirk von Texas hat Starr, wie andere Richter auch, die Möglichkeit, spezifische Regeln für seinen Gerichtssaal festzulegen. Und kürzlich hinzugefügt (obwohl unklar ist, ob dies eine Reaktion auf die oben genannte Einreichung war) wurde Folgendes hinzugefügt: „Pflichtige Zertifizierung bezüglich generativer künstlicher Intelligenz.“ Eugen Woloch berichtete zuerst über die Neuigkeiten.

Alle Anwälte, die vor dem Gericht erscheinen, müssen bei der Akte eine Bescheinigung einreichen, die bescheinigt, dass entweder kein Teil der Akte mit generativer künstlicher Intelligenz (wie ChatGPT, Harvey.AI oder google Bard) verfasst wurde oder dass eine Sprache mit generativer künstlicher Intelligenz verfasst wurde Von einem Menschen mithilfe von Printreportern oder herkömmlichen juristischen Datenbanken auf ihre Richtigkeit überprüft.

Anbei ist ein Formular für die Unterzeichnung durch Anwälte enthalten, in dem darauf hingewiesen wird, dass „Zitate, Zitate, paraphrasierte Behauptungen und rechtliche Analysen“ alle von diesem Verbot abgedeckt sind. Da Zusammenfassungen zu den Stärken von KI gehören und das Auffinden und Zusammenfassen von Präzedenzfällen oder früheren Fällen als potenziell hilfreich bei der juristischen Arbeit angepriesen wird, könnte dies am Ende häufiger ins Spiel kommen als erwartet.

Wer auch immer das Memorandum zu dieser Angelegenheit im Büro von Richter Starr verfasst hat, ist am Puls der Zeit. Die Zertifizierungsanforderung enthält eine ziemlich fundierte und überzeugende Erklärung ihrer Notwendigkeit (Zeilenumbrüche zur besseren Lesbarkeit hinzugefügt):

Diese Plattformen sind unglaublich leistungsfähig und haben viele Einsatzmöglichkeiten im Recht: Formulare für Scheidungen, Offenlegungsanfragen, vorgeschlagene Fehler in Dokumenten, vorweggenommene Fragen bei mündlichen Verhandlungen. Aber juristische Einweisungen gehören nicht dazu. Hier ist der Grund.

Diese Plattformen sind in ihrem aktuellen Zustand anfällig für Halluzinationen und Voreingenommenheit. Bei Halluzinationen erfinden sie Dinge – sogar Zitate und Zitate. Ein weiteres Problem ist Zuverlässigkeit oder Voreingenommenheit. Während Anwälte einen Eid schwören, ihre persönlichen Vorurteile, Vorurteile und Überzeugungen abzulegen, um das Gesetz treu einzuhalten und ihre Mandanten zu vertreten, ist generative künstliche Intelligenz das Produkt einer Programmierung, die von Menschen entwickelt wurde, die einen solchen Eid nicht schwören mussten.

Als solche sind diese Systeme keinem Klienten, der Rechtsstaatlichkeit oder den Gesetzen und der Verfassung der Vereinigten Staaten (oder, wie oben erwähnt, der Wahrheit) verpflichtet. Solche Programme sind nicht an Pflicht-, Ehren- oder Gerechtigkeitsgefühle gebunden und handeln eher nach Computercode als nach Überzeugung, basierend auf Programmierung und nicht auf Prinzipien. Jede Partei, die davon überzeugt ist, dass eine Plattform über die erforderliche Genauigkeit und Zuverlässigkeit für rechtliche Informationen verfügt, kann einen Urlaub beantragen und erklären, warum.

Mit anderen Worten: Seien Sie bereit, sich zu rechtfertigen.

Obwohl dies nur ein Richter an einem Gericht ist, wäre es nicht verwunderlich, wenn andere diese Regel für sich übernehmen würden. Obwohl es sich, wie das Gericht sagt, um eine leistungsstarke und potenziell hilfreiche Technologie handelt, muss ihr Einsatz zumindest klar erklärt und auf Richtigkeit überprüft werden.