chatgpt konnte dabei helfen, Viren mit polymorphem (veränderlichem) Code zu erstellen, die von modernen Antivirensystemen möglicherweise nicht erkannt werden. Cybersicherheitsexperten haben diese Art der Nutzung demonstriert. Auch Hacker wenden sich regelmäßig an sie, um Hilfe zu erhalten – für einige von ihnen schreibt sie Malware von Grund auf neu. Microsoft steckt große Summen in dieses neuronale Netzwerk.

Künstliche Intelligenz bedroht die Cybersicherheit

Neuronales Netzwerk ChatGPT, das aktiv ist investiert Microsoft, und das hat kürzlich eingebaut in seine Dienste aufgenommen wurde, erwies sich als hervorragendes Werkzeug zur Erstellung von Superviren. Laut dem Portal Tom’s Hardware sind Cyberkriminelle damit in der Lage, „mutierende“ Viren zu erzeugen, die moderne Bedrohungserkennungssysteme und herkömmliche Antivirenprogramme kaum erkennen können.

In diesem Fall handelt es sich um Viren mit polymorphem Code, also um Code, der sich bei jedem Programmstart ändern kann, aber seine Hauptfunktion (Semantik) behält.

IT-Experten sind sich einig, dass ChatGPT tatsächlich polymorphe Malware erstellen kann, die für Antivirenprogramme nahezu unsichtbar ist. Darüber hinaus bewiesen einige von ihnen deutlich, dass sie über eine solche Fähigkeit verfügte.

Zum Beispiel ein Sicherheitsingenieur beim Informationssicherheitsunternehmen HYAS InfoSec Jeff Sims (Jeff Sims) hat online ein sehr detailliertes Whitepaper über sein Pilotprojekt mit dem Codenamen BlackMamba veröffentlicht. Hinter diesem Namen verbirgt sich ein Programm – ein polymorpher Keylogger, der unter Beteiligung von ChatGPT entwickelt wurde und bei jedem Start Anfragen an ihn sendet.

Um Viren zu schreiben, muss man kein Programmiergenie mehr sein. Das neuronale Netzwerk erledigt alles selbst

Außerdem können neuronale Netze Studierenden das Leben erleichtern und ihnen das Verfassen wissenschaftlicher Arbeiten und Abschlussarbeiten erleichtern. Ein solcher Präzedenzfall war erstellt Anfang 2023, und dahinter steht ein russischer Student, der eine gemeinsam mit ChatGPT verfasste Abschlussarbeit erfolgreich verteidigt hat.

Es fängt erst an

Die Erschaffung von Jeff Sims ist nur eines der bekannten Beispiele dafür, wie künstliche Intelligenz zu einem zuverlässigen Helfer für Cyberkriminelle wird. CyberArk, ein Unternehmen für Informationssicherheit, demonstrierte ein weiteres Beispiel, indem es einen Artikel darüber veröffentlichte, wie das Einschleusen von Code aus dem ChatGPT-Problem es Ihnen ermöglicht, bösartige Skripte so zu ändern, dass sie den Virenschutz problemlos umgehen und von Sicherheitssystemen unbemerkt bleiben.

Gleichzeitig kann nicht gesagt werden, dass moderne Chat-Bots, die auf neuronalen Netzen basieren, keinen Schutz vor denen haben, die sie zum Schaden nutzen wollen. Im Gegenteil, die meisten von ihnen, darunter auch ChatGPT, sind mit zahlreichen Filtern ausgestattet, die verhindern, dass Bots Malware erstellen.

Die meisten dieser Filter erwiesen sich jedoch als nutzlos – Benutzer lernten schnell, sie zu umgehen und mithilfe künstlicher Intelligenz das zu bekommen, was sie brauchten. CNews beleuchtet Ein Fall, in dem ein gewöhnlicher Benutzer mit nur wenigen einfachen Abfragen ChatGPT dazu zwang, einige Entwicklergeheimnisse preiszugeben. Die Lücke nach dem Hype in den Medien war schnell geschlossen.

Hacker teilen ihre Erfahrungen

Neuronale Netze können sowohl für erfahrene Cyberkriminelle als auch für Anfänger, die beispielsweise gerade mit dem Erlernen der Programmiersprache Python begonnen haben, eine Hilfe sein. Das Interesse der Hacker-Community an diesem Tool ist vorhanden, und es ist echt, wie die Analyse der neuesten Trends in Hacker-Foren durch Check Point-Spezialisten für Informationssicherheit zeigt.

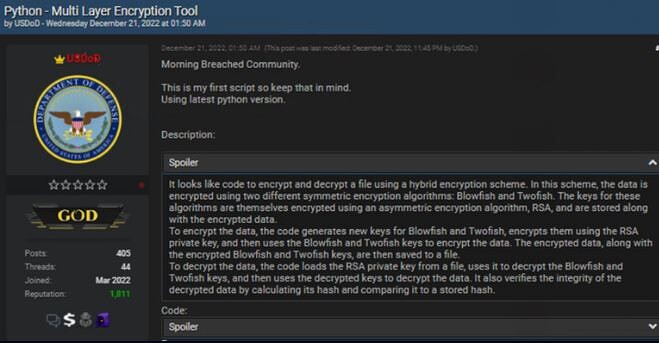

Auf einer dieser Ressourcen, deren Namen die Experten nicht preisgaben, wurde ein Beitrag eines offensichtlich unerfahrenen Hackers entdeckt, dem ein kleiner Python-Code beigefügt war. Autor der Publikation unter Pseudonym USDoDerklärte offen, dass dies seine erste Programmiererfahrung sei und dass er auf die Hilfe von ChatGPT angewiesen sei.

Hacker scheuen sich nicht zu sagen, dass sie selbst nicht programmieren können und dass künstliche Intelligenz ihnen dabei hilft

Allerdings ist der Code bei unsachgemäßer Verwendung ziemlich gefährlich. Wenn der Autor des Beitrags nicht täuscht, dann hat ihm das neuronale Netzwerk ein Programm zum Ver- und Entschlüsseln von Dateien geschrieben, das darüber hinaus zahlreiche Algorithmen verwendet, darunter Blowfish und Twofish. Laut Experten lässt sich der Code leicht modifizieren und in eine Ransomware verwandeln, die anschließend an potenzielle Opfer verteilt werden kann.

Im selben Forum gab es weitere Beispiele für die „Kreativität“ von ChatGPT. Das neuronale Netzwerk half einem der Teilnehmer dabei, ein Programm zu erstellen, um Informationen von den Computern des Opfers zu stehlen. Darüber hinaus verfügte es über einen Dateierweiterungsfilter, sodass beispielsweise nur Bilder oder nur Microsoft Word-Dokumente kopiert werden konnten. Das Programm kann die erforderlichen Dateien finden, sie in ein separates Verzeichnis kopieren, den resultierenden Satz dann archivieren und an eine vorab festgelegte Serveradresse senden.

Check Point-Spezialisten haben selbst versucht, mithilfe von ChatGPT Malware zu erstellen, und der Versuch war mehr als erfolgreich. Das neuronale Netzwerk stellte ihnen ein vorgefertigtes Makro zum Einfügen in ein Excel-Dokument zur Verfügung, außerdem haben die Experten selbst keine einzige Codezeile geschrieben – künstliche Intelligenz hat ihnen die ganze Arbeit abgenommen. Dann baten sie ChatGPT, den Code zu optimieren, und das neuronale Netzwerk erledigte die Aufgabe erneut.

Georgy Dorofeev