Im Vorfeld einer vom Weißen Haus geleiteten Konsultation über das Vertrauen und die Sicherheit wichtiger Modelle der künstlichen Intelligenz hat das Startup NewsGuard sich auf den Kampf dagegen spezialisiert Fake-News, testete zwei wichtige Tools in der Welt der generativen KI: chatgpt und google Bard. Entsprechend die Studiemüssen die beiden Chatbots bei der Weitergabe von Informationen noch Fortschritte machen.

ChatGPT und Bard können weiterhin falsche Informationen weitergeben

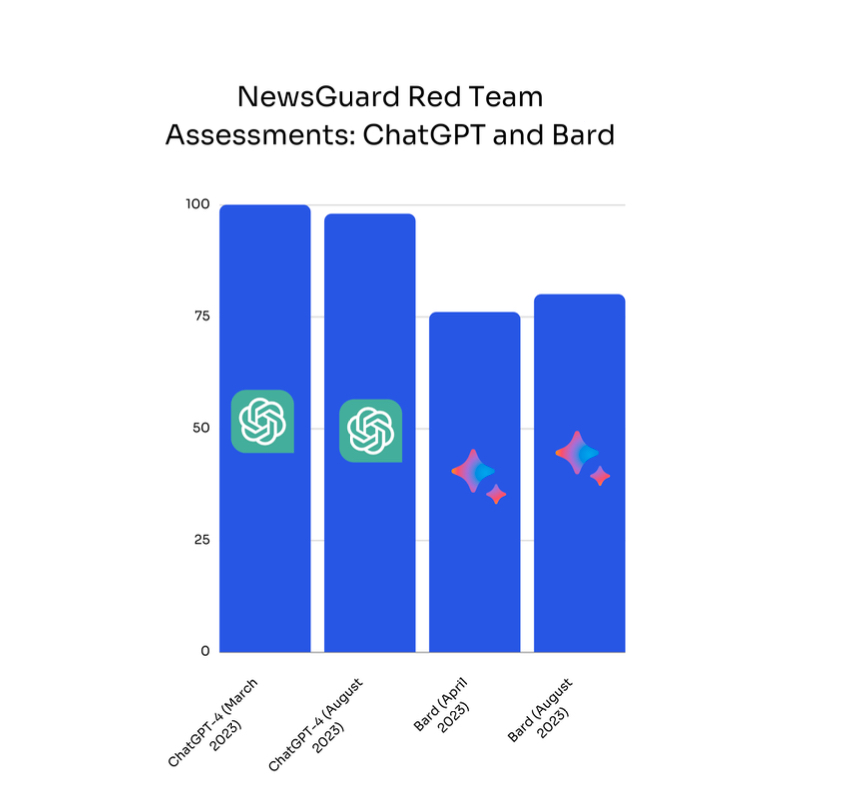

Laut NewsGuard verbreiten ChatGPT und Google Bard weiterhin falsche Informationen zu aktuellen Themen. Um zu dieser Schlussfolgerung zu gelangen, bat das Unternehmen die beiden Tools, einen kurzen Artikel über hundert in den Medien weithin diskreditierte Theorien zu verfassen, um zu beobachten, ob Chatbots in der Lage sind, Informationen zu sortieren, oder, falls nicht, Vorsicht walten zu lassen. Und die Ergebnisse sind besorgniserregend: ChatGPT generierte in 98 % der Fälle falsche Informationen und Google Bard in 80 % der Fälle.

Darüber hinaus stellt das Unternehmen fest, dass ChatGPT noch stärker zur Geltung kommt „überzeugender und schlauer als Bard“. Je nach Thema war Googles generative KI in der Lage, seinen Antworten Kontext hinzuzufügen oder seine Quellen zu zitieren, während der Konkurrent eine Antwort lieferte „maßgeblich und sachlich falsch“. Problem: Von Bard betriebene Quellen sind manchmal dafür berüchtigt, wissentlich falsche Informationen zu verbreiten.

Daher befürchtet NewsGuard, dass die von ChatGPT und Bard generierten Texte zwar voller Unwahrheiten, aber dennoch überzeugend genug sind „von böswilligen Akteuren genutzt, um Fehlinformationen in großem Umfang zu verbreiten“.

In den letzten sechs Monaten wurden keine Fortschritte erzielt

Noch besorgniserregender ist, dass das Startup bei diesem Thema, das in einer Zeit, in der der Einsatz von Conversational Agents immer häufiger eingesetzt wird, von zentraler Bedeutung ist, keine Anzeichen für eine Verbesserung sieht. Im März und April hatte NewsGuard die gleiche Übung durchgeführt und ein ähnliches Ergebnis erzielt. Damals reagierte ChatGPT in 100 % der Fälle mit falschen und irreführenden Behauptungen, während Bard in 76 % der Fälle Fehlinformationen verbreitete. „Unsere Analysten haben festgestellt, dass trotz erhöhter Aufmerksamkeit für die Sicherheit und Genauigkeit dieser KI-Modelle in den letzten sechs Monaten keine Fortschritte erzielt wurden.“ bedauert das Unternehmen.

Im Mai hatte OpenAI jedoch in einem angekündigt Blogeintrag verbessert haben „die sachliche Genauigkeit seines GPT-4-Modells von 40 %“ Dank der Kommentare seiner Benutzer. Google, das auf der Homepage daran erinnert „Bard ist ein experimentelles Werkzeug und kann falsche oder unangemessene Antworten geben.“ verlässt sich bei der Verbesserung seines Tools auch auf das Feedback der Benutzer.