Fast zwei Dutzend Forscher der Tsinghua University, der Ohio State University und der University of California in Berkeley arbeiteten zusammen, um eine Methode zur Messung der Fähigkeiten großer Sprachmodelle (LLMs) als reale Agenten zu entwickeln.

LLMs wie chatgpt von OpenAI und Claude von Anthropic haben im vergangenen Jahr die Technologiewelt im Sturm erobert, da sich hochmoderne „Chatbots“ bei einer Vielzahl von Aufgaben als nützlich erwiesen haben, darunter Codierung, Kryptowährungshandel und Textgenerierung.

Verwandt: OpenAI startet den Webcrawler „GPTBot“ im Rahmen der Pläne für das nächste Modell: GPT-5

In der Regel werden diese Modelle anhand ihrer Fähigkeit zur Ausgabe von Texten, die als menschenähnlich wahrgenommen werden, oder anhand ihrer Ergebnisse bei für Menschen konzipierten Klartexttests bewertet. Im Vergleich dazu wurden weit weniger Artikel zum Thema LLM-Modelle als Agenten veröffentlicht.

Agenten der künstlichen Intelligenz (KI) führen bestimmte Aufgaben aus, beispielsweise das Befolgen einer Reihe von Anweisungen in einer bestimmten Umgebung. Beispielsweise schulen Forscher häufig einen KI-Agenten darin, sich in einer komplexen digitalen Umgebung zurechtzufinden, um den Einsatz von maschinellem Lernen zur sicheren Entwicklung autonomer Roboter zu untersuchen.

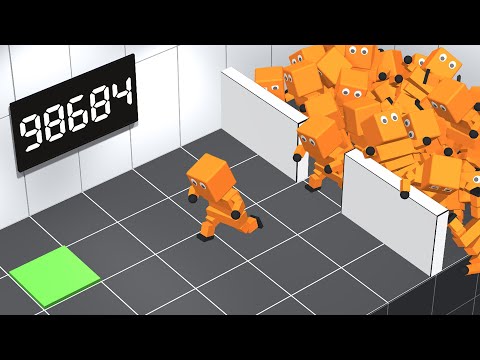

Herkömmliche Agenten für maschinelles Lernen wie der im Video oben werden aufgrund der unerschwinglichen Kosten, die mit Trainingsmodellen wie ChatGPT und Claude verbunden sind, normalerweise nicht als LLMs erstellt. Allerdings haben sich die größten LLMs als Vermittler als vielversprechend erwiesen.

Das Team aus Tsinghua, Ohio State und UC Berkeley hat ein Tool namens AgentBench entwickelt, um die Fähigkeiten von LLM-Modellen als Agenten in der realen Welt zu bewerten und zu messen, was nach Angaben des Teams das erste seiner Art ist.

Laut dem Vorabdruckpapier der Forscher ist das wichtigste Herausforderung Bei der Entwicklung von AgentBench ging es darum, über herkömmliche KI-Lernumgebungen – Videospiele und Physiksimulatoren – hinauszugehen und Wege zu finden, LLM-Fähigkeiten auf reale Probleme anzuwenden, damit sie effektiv gemessen werden können.

Sie entwickelten eine mehrdimensionale Reihe von Tests, die die Fähigkeit eines Modells messen, anspruchsvolle Aufgaben in verschiedenen Umgebungen auszuführen.

Dazu gehört, dass Modelle Funktionen in einer SQL-Datenbank ausführen, innerhalb eines Betriebssystems arbeiten, Haushaltsreinigungsfunktionen planen und durchführen, online einkaufen und mehrere andere übergeordnete Aufgaben, die eine schrittweise Problemlösung erfordern.

Dem Papier zufolge übertrafen die größten und teuersten Modelle die Open-Source-Modelle deutlich:

„[W]Wir haben mit AgentBench eine umfassende Evaluierung von 25 verschiedenen LLMs durchgeführt, darunter sowohl API-basierte als auch Open-Source-Modelle. Unsere Ergebnisse zeigen, dass erstklassige Modelle wie GPT-4 in der Lage sind, ein breites Spektrum realer Aufgaben zu bewältigen, was auf das Potenzial für die Entwicklung eines leistungsstarken, kontinuierlich lernenden Agenten hinweist.“

Die Forscher gingen sogar so weit zu behaupten, dass „Top-LLMs in der Lage werden, komplexe Missionen in der realen Welt zu bewältigen“, fügten jedoch hinzu, dass Open-Source-Konkurrenten noch einen „langen Weg vor sich“ hätten.