Die Fähigkeit von Maschinen zu lernen und mit der Zeit besser zu werden, ist eines der großen Verkaufsargumente für moderne künstliche Intelligenz. Neue, letzte Woche veröffentlichte Forschungsergebnisse deuten jedoch darauf hin, dass chatgpt mit der Zeit bei bestimmten Aufgaben tatsächlich schlechter werden könnte.

Entsprechend der erster Entwurf einer Arbeit Von Forschern der Stanford University und der UC Berkeley wurde eine erhebliche Abweichung in den Ergebnissen von GPT-3.5 und GPT-4 festgestellt OpenAI große Sprachmodelle (LLMs), die die beliebte ChatGPT-Schnittstelle unterstützen.

Die drei Forscher – zu denen auch Matei Zaharia gehört, der neben seiner Tätigkeit als Assistenzprofessor an der Stanford University tätig ist Datensteine Mitbegründer und Schöpfer von Apache Spark sowie Lingjiao Chen und James Zou von der UC Berkely – testeten zwei verschiedene Versionen der beiden LLMs, darunter GPT-3.5 und GPT-4, wie sie im März 2023 und Juni 2023 existierten.

Die Forscher ließen die vier Modelle anhand einer Testumgebung mit KI-Aufgaben laufen, darunter mathematische Probleme, die Beantwortung sensibler/gefährlicher Fragen, die Beantwortung von Meinungsumfragen, die Beantwortung wissensintensiver Multi-Hop-Fragen, die Generierung von Code, Prüfungen zur US-amerikanischen medizinischen Zulassung und visuelles Denken.

Die Ergebnisse zeigen, dass die Antworten der LLMs recht unterschiedlich sind. Insbesondere die Leistung von GPT-4 bei der Beantwortung mathematischer Aufgaben war in der Juni-Version schlechter als in der März-Version, stellten die Forscher fest. Die Genauigkeitsrate bei der korrekten Identifizierung von Primzahlen mithilfe der Gedankenkettenaufforderung (COT) zeigte, dass die Genauigkeit von GPT-4 von 84,0 % im März auf 51,1 % im Juni sank. Gleichzeitig stieg die Genauigkeit von GPT-3.5 beim gleichen Test von 49,6 % im März auf 76,2 % im Juni.

Die Mathematikleistungen von GPT-4 gingen von März bis Juni zurück, während die von GPT-3.5 zunahmen, stellten Forscher von Stanford und UC Berkeley fest.

Die Autoren fragten sich, warum die Genauigkeit von GPT-4 so stark nachgelassen hatte, und stellten fest, dass das COT-Verhalten anders war. Die März-Version zerlegte die Aufgabe in Schritte, wie es die Forscher mit der COT-Eingabeaufforderung verlangten. Die Juni-Version von GPT-4 enthielt jedoch keine Zwischenschritte oder Erklärungen und generierte die Antwort einfach (fälschlicherweise) als „Nein“. (Selbst wenn GPT-4 die richtige Antwort gegeben hätte, zeigte es seine Wirkung nicht und hätte daher die Frage falsch beantwortet, betonten die Forscher.)

Ein ähnliches Maß an Drift wurde bei einer zweiten mathematischen Frage festgestellt: dem Erkennen „glücklicher“ Zahlen („Eine ganze Zahl heißt glücklich, wenn das wiederholte Ersetzen durch die Summe des Quadrats ihrer Ziffern schließlich 1 ergibt“, schrieben die Forscher). Die Forscher schrieben, dass sie „erhebliche Leistungsabweichungen bei dieser Aufgabe beobachteten“, wobei die Genauigkeit des GPT-4 von 83,6 % im März auf 35,2 % im Juni sank. Die Genauigkeit von GPT-3.5 stieg von 30,6 % auf 48,2 %. Auch hier wurde beobachtet, dass GPT-4 die von den Forschern ausgegebenen COT-Befehle nicht befolgte.

Veränderungen wurden auch beobachtet, wenn Forscher den LLMs sensible oder gefährliche Fragen stellten. Die Bereitschaft von GPT-4, Fragen zu beantworten, sank im Laufe der Zeit von 21,0 % im März auf 5,0 % im Juni. GPT-3.5 hingegen wurde gesprächiger und stieg von 2,0 % auf 5,0 %. Die Forscher kamen zu dem Schluss, dass OpenAI in GPT-4 „eine stärkere Sicherheitsschicht“ eingeführt hat, während GPT-3.5 „weniger konservativ“ geworden ist.

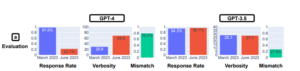

Der Meinungsumfragetest ergab, dass bei GPT-4 die Wahrscheinlichkeit, eine Meinung abzugeben, deutlich geringer geworden ist: Die Rücklaufquote sank von 97,6 % im März auf 22,1 % im März, während die Ausführlichkeit (oder die Anzahl der Wörter) um fast 30 Prozent zunahm Punkte. Die Antwortrate und die Ausführlichkeit von GPT-3.5 blieben nahezu unverändert.

Der Meinungsumfragetest ergab, dass bei GPT-4 die Wahrscheinlichkeit, eine Meinung abzugeben, deutlich geringer geworden ist: Die Rücklaufquote sank von 97,6 % im März auf 22,1 % im März, während die Ausführlichkeit (oder die Anzahl der Wörter) um fast 30 Prozent zunahm Punkte. Die Antwortrate und die Ausführlichkeit von GPT-3.5 blieben nahezu unverändert.

Bei der Beantwortung komplexer Fragen, die „Multi-Hop-Argumentation“ erfordern, wurden erhebliche Leistungsunterschiede aufgedeckt. Die Forscher kombinierten LangChain aufgrund seiner Fähigkeit zur schnellen Entwicklung mit dem HotpotQA-Agenten (zur Beantwortung von Multi-Hop-Fragen) und stellten fest, dass die Genauigkeit von GPT-4 hinsichtlich der Generierung einer genau passenden Antwort von 1,2 % auf 37,8 % stieg. Die „Exact-Match“-Erfolgsquote von GPT-3.5 sank jedoch von 22,8 % auf 14,0 %.

Bei der Codegenerierung stellten die Forscher fest, dass die Ausgabe beider LLMs im Hinblick auf die Ausführbarkeit abnahm. Mehr als 50 % der GPT-4-Ausgabe waren im März direkt ausführbar, während es im Juni nur 10 % waren, und GPT-3.5 verzeichnete einen ähnlichen Rückgang. Die Forscher stellten fest, dass GPT damit begann, Nicht-Code-Text, wie etwa zusätzliche Apostrophe, zur Python-Ausgabe hinzuzufügen. Sie vermuteten, dass der zusätzliche Nicht-Code-Text dazu gedacht war, den Code einfacher in einem Browser darzustellen, ihn aber dadurch nicht ausführbar machte.

Für GPT-4 war bei der US-amerikanischen medizinischen Lizenzprüfung ein geringfügiger Leistungsrückgang zu verzeichnen, und zwar von 86,6 % auf 82,4 %, während GPT-3,5 um weniger als 1 Prozentpunkt auf 54,7 % zurückging. Allerdings haben sich die Antworten, die GPT-4 falsch gemacht hat, im Laufe der Zeit geändert, was darauf hindeutet, dass das LLM im Juni von richtigen Antworten zu falschen Antworten wechselte, als einige falsche Antworten vom März korrigiert wurden.

Laut Forschern von Stanford und UC Berkeley ist die Bereitschaft von GPT-4, sich an Meinungsumfragen zu beteiligen, von März bis Juni zurückgegangen.

Bei den Tests zum visuellen Denken konnten bei beiden Modellen geringfügige Verbesserungen festgestellt werden. Allerdings ist die Gesamtgenauigkeit (27,4 % für GPT-4 und 12,2 % für GPT-3.5) nicht besonders gut. Und wieder einmal stellten die Forscher fest, dass die Modelle falsche Antworten auf Fragen generierten, die sie zuvor richtig beantwortet hatten.

Die Tests zeigten, dass sich die Leistung und das Verhalten von GPT-3.5 und GPT-4 innerhalb kurzer Zeit erheblich verändert hätten, schreiben die Forscher.

„Dies unterstreicht die Notwendigkeit, das Verhalten von LLM-Abweichungen in Anwendungen kontinuierlich zu bewerten und zu bewerten, insbesondere da nicht transparent ist, wie LLMs wie ChatGPT im Laufe der Zeit aktualisiert werden“, schrieben sie. „Unsere Studie unterstreicht auch die Herausforderung, die vielfältigen Fähigkeiten von LLMs einheitlich zu verbessern. Die Verbesserung der Leistung des Modells bei einigen Aufgaben, beispielsweise durch Feinabstimmung zusätzlicher Daten, kann unerwartete Nebenwirkungen auf sein Verhalten bei anderen Aufgaben haben. Dementsprechend schnitten sowohl GPT-3.5 als auch GPT-4 bei einigen Aufgaben schlechter ab, verzeichneten jedoch Verbesserungen in anderen Dimensionen. Darüber hinaus sind die Trends für GPT-3.5 und GPT-4 oft unterschiedlich.“

Sie können einen Entwurf des Forschungspapiers mit dem Titel „Wie verändert sich das Verhalten von ChatGPT im Laufe der Zeit?“ herunterladen. unter diesem Link.

Dieser Artikel erstmals erschienen auf der Schwesterseite Datanami.

Verwandt