LLMs sind Deep-Learning-KI-Algorithmen, die anhand sehr großer Datensätze Inhalte erkennen, zusammenfassen, übersetzen, vorhersagen und generieren können.

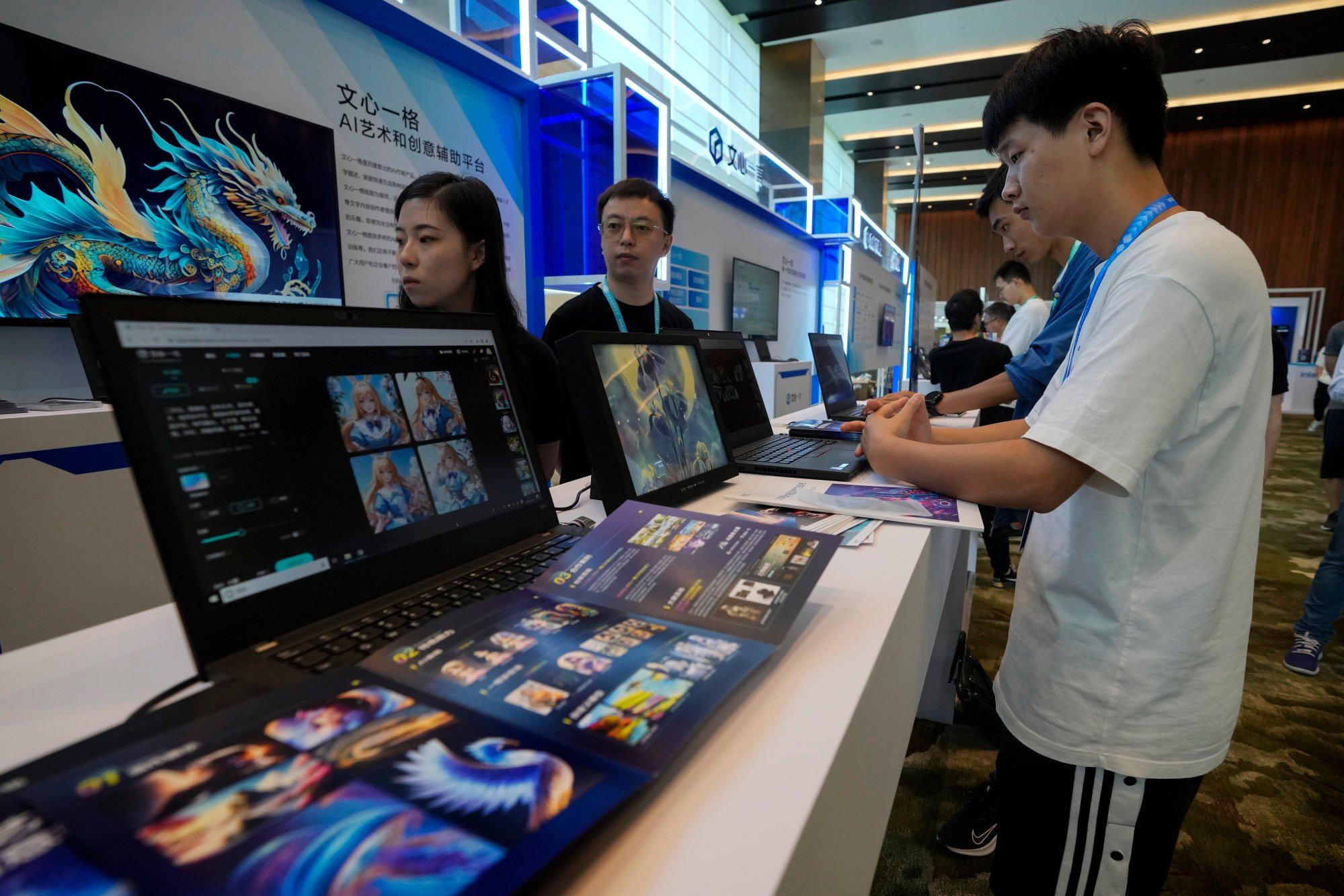

Während die Einführung von chatgpt bei chinesischen Technologieunternehmen einen Aufruhr ausgelöst hat, inländische Konkurrenten zu entwickeln, von Ernie Bot von Baidu bis hin zu LLM Tongyi Qianwen von Alibaba Group Holding, wird das Feld immer noch von US-Unternehmen angeführt, wobei OpenAI daraufhin GPT-4 Turbo und einen US-Riesen herausbrachte google hinterlässt mit Bard einen bleibenden Eindruck. Alibaba besitzt die South China Morning Post.

„Wie Wasser und Strom“: China fordert ein „einheitliches“ Computernetzwerk

„Wie Wasser und Strom“: China fordert ein „einheitliches“ Computernetzwerk

Der überfüllte Markt des Landes mit mehr als 100 LLMs wird durch mangelnden Zugang zu fortschrittlichen Chips, strenge Regulierung, Zensur sensibler Themen, hohe Entwicklungskosten und fragmentierte Märkte für die Technologie eingeschränkt.

„China steht bei der Entwicklung von LLMs vor zahlreichen Herausforderungen, da die Technologielücke zum Westen aufgrund der Einführung von GPT und Googles Gemini größer wird“, sagte Su Lian Jye, Chefanalystin beim Forschungsunternehmen Omdia. „Einschränkungen der Rechenleistung aufgrund von Chip-Verboten und die begrenzte Qualität der Daten aus dem auf Mandarin basierenden Internet im Vergleich zum englischsprachigen Raum können ebenfalls Rückschläge sein.“

Einige sagen, dass Chinas beschleunigte KI-Bemühungen im Jahr 2017 vorangetrieben wurden, als AlphaGo, ein Computerprogramm von Alphabets DeepMind Technologies, Ke Jie besiegte, den damals weltbesten Go-Spieler – auch bekannt als Weiqi – 3:0. Go wird in China seit der alten Zhou-Dynastie gespielt. Jetzt steht das Land erneut unter Druck.

Die größte Herausforderung besteht darin, dass das Land aufgrund der US-Handelssanktionen keinen Zugang zu hochmodernen Grafikprozessoren (GPUs) von Herstellern wie Nvidia hat.

Diese GPUs, darunter Nvidias H100 mit einem Preis von etwa 30.000 US-Dollar pro Einheit, gelten als das schlagende Herz der neuesten LLMs und bestimmen in hohem Maße, wie leistungsfähig das Modell sein kann und über welche Microsoft, Meta Platforms, Google, Amazon und Oracle alle verfügen investiert in.

Das Gericht in Peking entscheidet, dass KI-generierte Inhalte dem Urheberrecht unterliegen, lehnt jedoch den Standpunkt der USA ab

Das Gericht in Peking entscheidet, dass KI-generierte Inhalte dem Urheberrecht unterliegen, lehnt jedoch den Standpunkt der USA ab

Allerdings sind finanzstarke chinesische Technologiefirmen mit Kaufbeschränkungen konfrontiert. Einen Monat vor der Einführung von GPT durch OpenAI aktualisierte die US-Regierung ihre Exportkontrollregeln, um China aus Gründen der nationalen Sicherheit den Zugang zu fortschrittlichen Chips wie Nvidias H100 und A100 zu blockieren.

China steht bei der Entwicklung von LLMs vor zahlreichen Herausforderungen, da die Technologielücke zum Westen aufgrund der Einführung von GPT und Googles Gemini größer wird

Das in Kalifornien ansässige Unternehmen Nvidia hat sich alle Mühe gegeben, die Situation zu entschärfen, indem es langsamere Varianten dieser Chips – den A800 und den H800 – für chinesische Kunden entwickelt hat, was Unternehmen wie Tencent Holdings und ByteDance die Möglichkeit bietet, ihre Vorräte aufzustocken. Festlandchina und Hongkong sind für etwas mehr als 22 Prozent des Nvidia-Umsatzes verantwortlich, wobei nur Taiwan und die USA mehr erwirtschaften.

Allerdings hat die US-Regierung im Oktober die Kontrollen erneut verschärft, wodurch Nvidia den Verkauf des A800 und H800 an China illegal gemacht hat und damit gedroht hat, künftige Workarounds zu verbieten.

In einer Rede auf dem Reagan National Defense Forum in Kalifornien Anfang des Monats sagte US-Handelsministerin Gina Raimondo: „Wenn man einen Chip um eine bestimmte Schnittlinie herum neu gestaltet, ermöglicht das das.“ [China] Um KI zu machen, werde ich es gleich am nächsten Tag kontrollieren.“

Wang Shuyi, ein Professor mit Schwerpunkt auf KI und maschinellem Lernen an der Tianjin Normal University, sagte, unzureichende Rechenleistung sei eines der Haupthindernisse für die Entwicklung von KI-Modellen in China.

„Es wird für China immer schwieriger, Zugang zu fortschrittlichen Chips zu erhalten“, sagte Wang. „Selbst chinesische Unternehmen mit Geld werden ohne Rechenleistung nicht in der Lage sein, hochwertige Datenquellen vollständig zu nutzen.“

Und da inländische Unternehmen bei der Chipproduktion immer noch weit hinter der Spitze zurückbleiben, wird es China in absehbarer Zeit schwer fallen, diese Beschränkungen zu überwinden.

Der Videospiel- und Social-Media-Riese Tencent warnte letzten Monat außerdem davor, dass US-Beschränkungen für den Verkauf von High-End-Chips nach China letztendlich Auswirkungen auf seine Cloud-Dienste haben würden, obwohl das Unternehmen über einen großen Vorrat an Nvidia-KI-Chips verfügt.

„Am stärksten betroffen sind große Technologieunternehmen, die Aufträge erteilt haben [for chips] „Da es sich um Milliarden von Dollar handelt, die nicht geliefert werden können, wird sich dies auf ihre Fähigkeit auswirken, in Zukunft Dienste über ihre Clouds bereitzustellen“, sagte Chen Yu, Partner bei der Risikokapitalgesellschaft Yunqi Partners, die das KI-Start-up MiniMax unterstützt hat.

Nach Angaben von Omdia sollten Baidu, Alibaba, Tencent und ByteDance 125.000 Einheiten Nvidia H100-GPUs kaufen – 20 Prozent aller H100-Lieferungen im Jahr 2023.

Chen wies jedoch darauf hin, dass chinesische Start-ups einen gewissen Schutz genießen, da sie auf die Rechenkapazitäten globaler öffentlicher Cloud-Dienste zugreifen können, die nicht eingeschränkt sind.

Huawei bietet Chinas größtem Kupferrohrexporteur Cloud- und KI-Technologie an

Huawei bietet Chinas größtem Kupferrohrexporteur Cloud- und KI-Technologie an

Allerdings haben die Sanktionen hart getroffen. Während US-Unternehmen von OpenAI bis Nvidia wegen ihrer Rolle bei der Einführung generativer KI in die Welt Schlagzeilen machten, hatten einige der größten KI-Stars Chinas von vor ein paar Jahren, wie beispielsweise das in Hongkong notierte Unternehmen SenseTime, unter den US-Beschränkungen Schwierigkeiten, Gewinne zu erzielen .

„Einige Unternehmen, darunter iFlyTek, arbeiten mit Huawei Technologies an Workarounds, um Chip-Grenzwerte zu durchbrechen, aber ihre Bemühungen werden immer noch durch das Fehlen eines ausgereiften KI-Trainings-Ökosystems wie Nvidias CUDA behindert“, sagte ein in Hangzhou ansässiger KI-Unternehmer Aufgrund der Sensibilität der Angelegenheit lehnte es jedoch ab, namentlich genannt zu werden.

Unterdessen sind ausländische LLMs wie die GPT-Reihe von OpenAI, das neu veröffentlichte Gemini von Google sowie der KI-Chatbot Bard aufgrund strenger regulatorischer Anforderungen immer noch nicht direkt in China verfügbar.

Die Cyberspace Administration of China, die Behörde, die Chinas Internet überwacht, hat mit Wirkung zum 15. August strenge KI-Vorschriften eingeführt, die eine Überprüfung von LLMs und eine Überwachung ihrer Entwicklung, einschließlich Dateneingaben und -ausgaben, vorschreiben. Baidu beispielsweise musste Ernie Bot monatelang im „Testmodus“ laufen lassen, bevor es für die öffentliche Nutzung freigegeben wurde.

Die strukturellen Sprachunterschiede zwischen Englisch und Mandarin und die Sensibilität in Bezug auf politische Themen – inländische KI-Chatbots weichen bei der Beantwortung heikler Fragen in Benutzertests aus – bedeuten auch, dass es eine strikte Trennung zwischen dem inländischen und dem globalen Markt gibt.

Laut Unternehmensangaben ist Googles Bard beispielsweise in „230 Ländern und Territorien“ verfügbar und fehlt nur an wenigen Orten wie Festlandchina, Hongkong, Iran und Nordkorea.

Auch China riskiert Doppelarbeit. Bis Juli dieses Jahres waren 130 LLMs von chinesischen Unternehmen und Forschungsinstituten auf den Markt gebracht worden, was zu einem sogenannten „Gerangel von hundert großen Modellen“ führte.

Robin Li Yanhong, Mitbegründer und Geschäftsführer des Suchmaschinengiganten Baidu, sagte letzten Monat, dass die Einführung mehrerer konkurrierender LLMs in China „eine enorme Ressourcenverschwendung“ sei und dass Unternehmen sich stärker auf Anwendungen konzentrieren sollten.

„Im Hinblick auf Technologie oder Marktgröße hat sich derzeit keine Plattform als vorherrschend herausgestellt“, sagte Luo Yuchen, CEO von Shenzhen Yantu Intelligence and Innovation. Allerdings fügte Luo hinzu, dass die Modellentwicklung fortgesetzt werden sollte, da selbst GPT-4 wahrscheinlich nicht gut genug sei, um Unternehmen bei der Lösung alltäglicher Aufgaben zu helfen, die von Menschen erledigt werden.

Baidu sieht begrenzte kurzfristige Auswirkungen der US-amerikanischen KI-Chip-Einschränkungen

Baidu sieht begrenzte kurzfristige Auswirkungen der US-amerikanischen KI-Chip-Einschränkungen

Wang Xiaochuan, CEO des KI-Start-ups Baichuan, sagte letzte Woche auf einem Tencent-Technologieforum in Peking, dass viele Firmen davon absehen sollten, ihre eigenen Modelle zu trainieren und „ihre Bemühungen stattdessen darauf konzentrieren sollten, Kommerzialität und skalierbare KI-Produkte zu finden, indem sie bestehende Modelle über die Cloud nutzen.“ Dienstleistungen“.

In der Zwischenzeit scheinen Baidu und Alibaba unterschiedliche Wege zum KI-Wachstum aufgezeigt zu haben.

Alibaba Cloud hat sein Qwen-72B-KI-Modell für Forschungs- und kommerzielle Zwecke auf der Plattform für maschinelles Lernen Hugging Face und seiner eigenen Open-Source-Community ModelScope als Open-Source-Lösung bereitgestellt. Dies folgt einem Schritt von Meta, sein Llama2-Modell im Juli als Open-Source-Lösung bereitzustellen.

Alibaba Cloud sagte, eine Open-Source-Community sei für die Entwicklung von Modellen und KI-basierten Anwendungen von entscheidender Bedeutung. Seit August stellt das Unternehmen vier Varianten seines proprietären LLM Tongyi Qianwen Open-Source-Communities zur Verfügung.

Im Gegensatz dazu hat Baidu erklärt, dass sein Ernie LLM proprietär bleiben wird. Shen Dou, der die AI Cloud Group von Baidu leitet, hat darauf hingewiesen, dass die Open-Source-Lösung grundlegender LLMs aufgrund „fehlender effektiver Feedbackschleifen“ und hoher Upgrade-Kosten schwierig sein kann.

KI ist sicherlich ein teures Geschäft. Für den Aufbau und die Schulung von LLMs sind Tausende fortschrittlicher Chips erforderlich, um riesige Datenmengen zu verarbeiten, die Löhne hochqualifizierter Ingenieure nicht eingerechnet.

Laut einem CNBC-Bericht vom März nutzte Metas Llama-Modell beispielsweise 2.048 Nvidia A100-GPUs für das Training mit 1,4 Billionen Token, einer numerischen Darstellung von Wörtern, und dauerte etwa 21 Tage.

Zwar ist klar, dass China bei der Beschaffung fortschrittlicher Rechenleistung und -ausrüstung einen harten Kampf vor sich hat, aber es hat Zugriff auf riesige Datenschätze und ein riesiges Spektrum an Marktanwendungen – die beiden Vorteile werden hervorgehoben von Präsident Xi vor fünf Jahren. Es gibt auch eine Vielzahl findiger Unternehmer.

Beispielsweise hat Lee Kai-fu, ein bekannter Risikokapitalgeber und ehemaliger Präsident von Google China, sein KI-Start-up 01.AI innerhalb von nur acht Monaten in ein 1-Milliarden-US-Dollar-Unternehmen umgewandelt, obwohl es einige Kontroversen über die Verwendung der Struktur von Meta gab Lama LLM.

Und Chinas Big-Tech-Firmen streben danach, die Technologie in der einen oder anderen Form zu monetarisieren.

„Offen oder geschlossen, KI ist in den Augen von Cloud-Service-Providern im Wesentlichen ein Booster für ein Cloud-Geschäft“, sagte Su von Omdia. „Diese Anbieter, ob Tencent oder Huawei, wollen letztendlich Geld verdienen, indem sie Rechen- und Speicherkapazitäten auf ihren Plattformen an KI-Entwickler vermieten.“

Zusätzliche Berichterstattung von Ben Jiang