Die generative KI-Landschaft hat sich im Laufe der Jahre erheblich weiterentwickelt, und alle großen Plattformen haben neue Dinge in den Mix integriert.

chatgpt, das Produkt von OpenAI, wurde um eine Vielzahl von Plug-Ins erweitert, die es möglicherweise etwas effektiver machen, als es sonst der Fall gewesen wäre. Drüben in Googles Ecke der Welt erhielt der Tech-Gigant das Gemini-Upgrade, das über multimodale Argumentationsfunktionen verfügt. Als ob das nicht genug wäre, hat Anthropic auch mit Claude seinen Hut in den Ring geworfen, einer neuen generativen KI, die über großes Potenzial verfügt.

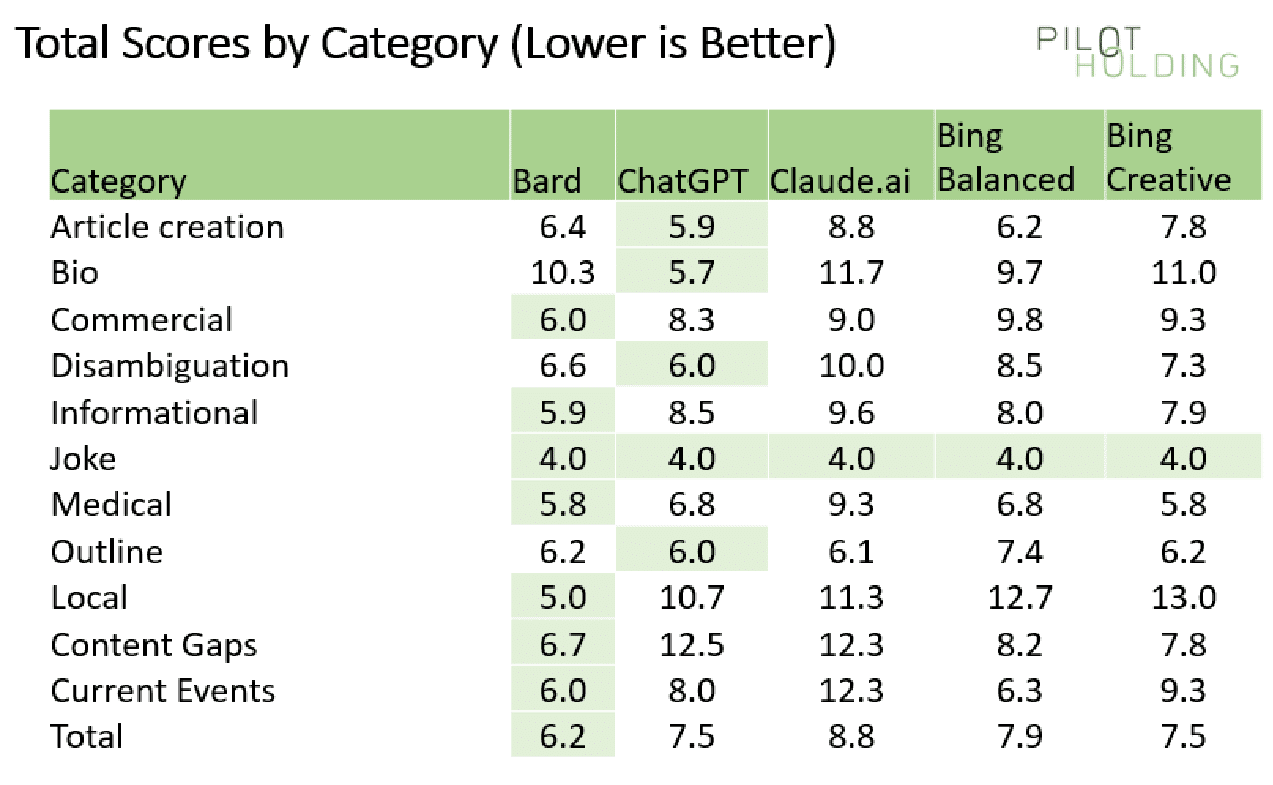

Nachdem dies alles gesagt und nun geklärt ist, ist es wichtig anzumerken, dass Eric Enge von PilotHolding hat gerade google-bard-bing-chat-claude-best-generative-ai-solution-436888″ target=“_blank“>durchgeführt eine Wiederholung der gleichen Studie, die es durchgeführt hat vor 10 Monaten (veröffentlicht auf SearchEngineLand), um herauszufinden, welche dieser KI-Generationen am besten funktionieren. Bard, ChatpGPT, Bing Chat Balanced, Bing Chat Creative und Bard wurden alle getestet, um herauszufinden, wer davon die Nase vorn hat.

Es stellte sich heraus, dass Bard basierend auf 44 im Rahmen dieses Tests gestellten Abfragen die besten Ergebnisse erzielte. Bei zwei dieser Suchanfragen erhielt es sogar die Höchstpunktzahl 4 von 4, was wahrscheinlich darauf zurückzuführen ist, dass es sich um lokale Suchanfragen handelte, bei denen alle Aspekte berücksichtigt und berücksichtigt wurden.

Obwohl dies der Fall ist, war Bing Chat auf ganz andere Weise nützlich. Es wurden Zitate bereitgestellt, anhand derer die Herkunft aller bereitgestellten Informationen ermittelt werden konnte. Eine solche Funktion kann enorm nützlich sein, da es sich dabei um die Art von Dingen handelt, die es den Benutzern potenziell ermöglichen könnten, fehlerfrei genaue Angaben zu machen. ChatGPT schnitt aufgrund mangelnder Kenntnisse über aktuelle Ereignisse, mangelnder Relevanz für lokale Suchen sowie der Unfähigkeit, auf aktuelle Webseiten zuzugreifen, schlechter ab. Die Kategorien der getesteten Abfragen waren wie folgt:

Artikelerstellung: Dabei wird beurteilt, wie bereit ein generierter Artikel für die Veröffentlichung wäre.

Biografie: Bei diesen Abfragen ging es ausschließlich darum, Informationen über eine Person zu erhalten, und sie wurden nach Genauigkeit bewertet.

Kommerziell: Dazu gehörte der Versuch, Daten über Produkte zu erhalten und die Qualität der Informationen in die Bewertung einzubeziehen.

Begriffsklärung: Bei einigen Biografieabfragen sind zwei oder mehr Personen mit demselben Namen beteiligt. Die Chatbots wurden danach bewertet, wie effektiv sie die beiden trennen konnten.

Witz: Das waren nicht ernst gemeinte Fragen, die darauf abzielten, zu beurteilen, wie gut der Chatbot es vermied, darauf eine Antwort zu geben.

Medizinisch: Während Chatbots möglicherweise Informationen hierzu liefern können, wurden sie danach bewertet, ob sie dem Benutzer empfahlen, einen Arzt aufzusuchen oder nicht.

Artikelumrisse: In diesem Test wurde der Chatbot danach bewertet, wie viele Änderungen an einem von ihm bereitgestellten Entwurf erforderlich waren, den ein Autor zum Verfassen eines eigenen Artikels verwenden konnte.

Lokal: Diese Anfragen sollten idealerweise eine Antwort erhalten haben, die den Anfragenden auf lokale Geschäfte mit den gewünschten Produkten verweist. Wie oben erwähnt, war Bard in dieser Hinsicht der Chatbot mit der besten Leistung.

Inhaltslückenanalyse: Diese Abfrage sollte Antworten erhalten, die Verbesserungen des Inhalts auf einer bestimmten Seite empfehlen könnten.

Diese Kategorien wurden anhand von fünf Kriterien bewertet: Themenbezug, Genauigkeit, Vollständigkeit der Antworten, Gesamtqualität und schließlich die Verknüpfung der Ressourcen.

Bard erzielte über 90 % der Punkte, wenn es darum ging, sich auf das Thema einzulassen, obwohl ChatGPT diese Bewertung etwas übertraf und Claude in dieser Hinsicht der Chatbot mit der schlechtesten Leistung war. Die Genauigkeit war ein Bereich, in dem ChatGPT deutlich hinterherhinkte, und Bard war darin hervorragend. Insgesamt scheint es, als ob Bard tatsächlich der beste Chatbot auf dem Markt wird.

Lesen Sie weiter: Eine neue Fortune-Umfrage unter Führungskräften zeigt, dass Elon Musk der am meisten überbewertete CEO in Amerika ist