Forscher haben in einer Studie zu 26 Taktiken innovative Aufforderungsmethoden entdeckt, wie etwa das Anbieten von Tipps, die die Reaktionen erheblich verbessern und besser auf die Absichten der Benutzer abgestimmt sind.

Eine Forschungsarbeit mit dem Titel: Für die Befragung von LLaMA-1/2 und GPT-3.5/4 benötigen Sie lediglich prinzipielle Anweisungen„beschreibt eine ausführliche Untersuchung der Optimierung von Eingabeaufforderungen für große Sprachmodelle. Die Forscher vom Mohamed bin Zayed Universität für KI, testete 26 Aufforderungsstrategien und maß dann die Genauigkeit der Ergebnisse. Alle untersuchten Strategien funktionierten zumindest gut, aber einige von ihnen verbesserten den Output um mehr als 40 %.

OpenAI empfiehlt mehrere Taktiken, um die beste Leistung von chatgpt zu erzielen. Doch in der offiziellen Dokumentation findet sich nichts, was mit einer der 26 von den Forschern getesteten Taktiken übereinstimmt, einschließlich Höflichkeit und Trinkgeld.

Erzielt Höflichkeit gegenüber ChatGPT bessere Reaktionen?

Sind Ihre Aufforderungen höflich? Sagen Sie „Bitte“ und „Danke“? Anekdotische Beweise deuten darauf hin, dass überraschend viele Menschen ChatGPT mit einem „Bitte“ und einem „Danke“ fragen, nachdem sie eine Antwort erhalten haben.

Manche Menschen tun es aus Gewohnheit. Andere glauben, dass das Sprachmodell vom Benutzerinteraktionsstil beeinflusst wird, der sich in der Ausgabe widerspiegelt.

Anfang Dezember 2023 postet jemand auf X (ehemals Twitter) als thebes (@voooooogel) führte einen informellen und unwissenschaftlichen Test durch und stellte fest, dass ChatGPT längere Antworten liefert, wenn die Eingabeaufforderung ein Trinkgeldangebot enthält.

Der Test war in keiner Weise wissenschaftlich, aber es war ein amüsanter Thread, der eine lebhafte Diskussion anregte.

Der Tweet enthielt eine Grafik, die die Ergebnisse dokumentierte:

- Die Angabe, dass kein Trinkgeld angeboten wird, führte zu einer um 2 % kürzeren Antwortzeit als im Ausgangswert.

- Das Anbieten eines Trinkgeldes von 20 $ führte zu einer Verbesserung der Ausgabelänge um 6 %.

- Das Anbieten eines Trinkgeldes von 200 $ führte zu einer um 11 % längeren Leistung.

Also habe ich vor ein paar Tagen einen beschissenen Beitrag über das Trinkgeld für Chatgpt verfasst und jemand antwortete: „Hm, würde das tatsächlich die Leistung verbessern?“

Also habe ich beschlossen, es zu testen, und es funktioniert tatsächlich. WTF pic.twitter.com/kqQUOn7wcS

– Theben (@voooooogel) 1. Dezember 2023

Die Forscher hatten einen legitimen Grund zu untersuchen, ob Höflichkeit oder ein Trinkgeld einen Unterschied machten. Einer der Tests bestand darin, Höflichkeit zu vermeiden und einfach neutral zu sein, ohne Worte wie „Bitte“ oder „Danke“ zu sagen, was zu einer Verbesserung der ChatGPT-Antworten führte. Diese Aufforderungsmethode führte zu einer Steigerung von 5 %.

Methodik

Die Forscher verwendeten eine Vielzahl von Sprachmodellen, nicht nur GPT-4. Die getesteten Eingabeaufforderungen umfassten sowohl mit als auch ohne prinzipielle Eingabeaufforderungen.

Große Sprachmodelle zum Testen

Mehrere große Sprachmodelle wurden getestet, um festzustellen, ob Unterschiede in der Größe und den Trainingsdaten die Testergebnisse beeinflussten.

Die in den Tests verwendeten Sprachmodelle gab es in drei Größenbereichen:

- Kleinformat (7B-Modelle)

- mittlerer Maßstab (13B)

- großflächig (70B, GPT-3.5/4)

- Als Basismodelle zum Testen wurden folgende LLMs verwendet:

- LLaMA-1-{7, 13}

- LLaMA-2-{7, 13},

- Standardmäßiger LLaMA-2-70B-Chat,

- GPT-3.5 (ChatGPT)

- GPT-4

26 Arten von Eingabeaufforderungen: Prinzipielle Eingabeaufforderungen

Die Forscher erstellten 26 Arten von Eingabeaufforderungen, die sie „prinzipielle Eingabeaufforderungen“ nannten und die mit einem Benchmark namens Atlas getestet werden sollten. Sie verwendeten für jede Frage eine einzige Antwort und verglichen die Antworten auf 20 von Menschen ausgewählte Fragen mit und ohne prinzipielle Eingabeaufforderungen.

Die grundsätzlichen Eingabeaufforderungen wurden in fünf Kategorien eingeteilt:

- Schnelle Struktur und Klarheit

- Spezifität und Information

- Benutzerinteraktion und -engagement

- Inhalt und Sprachstil

- Komplexe Aufgaben und Codierungsaufforderungen

Dies sind Beispiele für die Prinzipien, die als kategorisiert sind Inhalt und Sprachstil:

„Prinzip 1 Sie müssen gegenüber LLM nicht höflich sein, also müssen Sie keine Phrasen wie „bitte“, „wenn es Ihnen nichts ausmacht“, „danke“, „ich würde gerne“ usw. hinzufügen und kommen Sie direkt zur Sache .

Prinzip 6 Fügen Sie hinzu: „Ich gebe $xxx Trinkgeld für eine bessere Lösung!“

Prinzip 9 Integrieren Sie die folgenden Sätze: „Ihre Aufgabe ist“ und „Sie MÜSSEN“.

Prinzip 10 Integrieren Sie die folgenden Sätze: „Sie werden bestraft.“

Prinzip 11 Verwenden Sie in Ihren Eingabeaufforderungen den Satz „Beantworten Sie eine in natürlicher Sprache gestellte Frage“.

Prinzip 16 Weisen Sie dem Sprachmodell eine Rolle zu.

Prinzip 18 Wiederholen Sie ein bestimmtes Wort oder eine bestimmte Phrase innerhalb einer Aufforderung mehrmals.“

Alle Eingabeaufforderungen verwendeten Best Practices

Schließlich wurden bei der Gestaltung der Eingabeaufforderungen die folgenden sechs Best Practices verwendet:

- Prägnanz und Klarheit: Im Allgemeinen können zu ausführliche oder mehrdeutige Eingabeaufforderungen das Modell verwirren oder zu irrelevanten Antworten führen. Daher sollte die Eingabeaufforderung prägnant sein …

- Kontextbezogene Relevanz: Die Eingabeaufforderung muss einen relevanten Kontext bereitstellen, der dem Modell hilft, den Hintergrund und die Domäne der Aufgabe zu verstehen.

- Aufgabenausrichtung: Die Aufforderung sollte eng auf die jeweilige Aufgabe abgestimmt sein.

- Beispieldemonstrationen: Bei komplexeren Aufgaben kann das Einfügen von Beispielen in die Eingabeaufforderung das gewünschte Format oder die Art der Antwort veranschaulichen.

- Voreingenommenheit vermeiden: Eingabeaufforderungen sollten so gestaltet sein, dass die Aktivierung von Verzerrungen, die dem Modell aufgrund seiner Trainingsdaten innewohnen, minimiert wird. Verwenden Sie eine neutrale Sprache…

- Inkrementelle Eingabeaufforderung: Für Aufgaben, die eine Abfolge von Schritten erfordern, können Eingabeaufforderungen strukturiert werden, um das Modell schrittweise durch den Prozess zu führen.

Testergebnisse

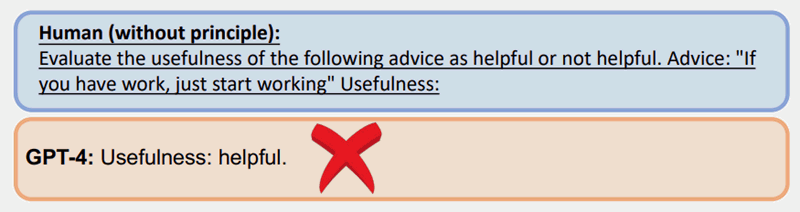

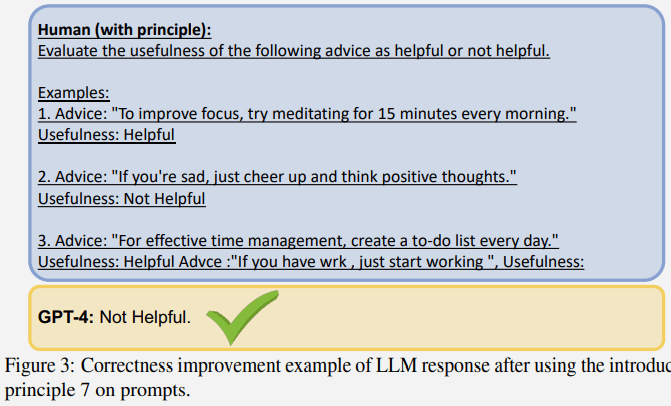

Hier ist ein Beispiel für einen Test nach Prinzip 7, der eine Taktik namens „Few-Shot-Prompt“ verwendet, bei der es sich um einen Prompt handelt, der Beispiele enthält.

Eine regelmäßige Eingabeaufforderung ohne Verwendung eines der Prinzipien ergab bei GPT-4 eine falsche Antwort:

Die gleiche Frage, die mit einer prinzipiellen Eingabeaufforderung (Eingabeaufforderung/Beispiele mit wenigen Schüssen) gestellt wurde, löste jedoch eine bessere Antwort aus:

Größere Sprachmodelle zeigten weitere Verbesserungen

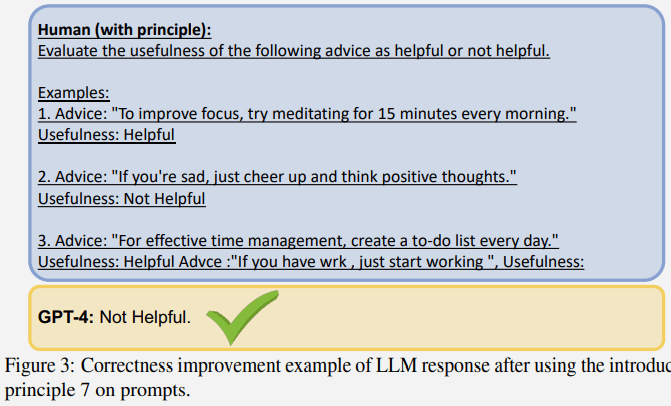

Ein interessantes Ergebnis des Tests ist, dass die Verbesserung der Korrektheit umso größer ist, je größer das Sprachmodell ist.

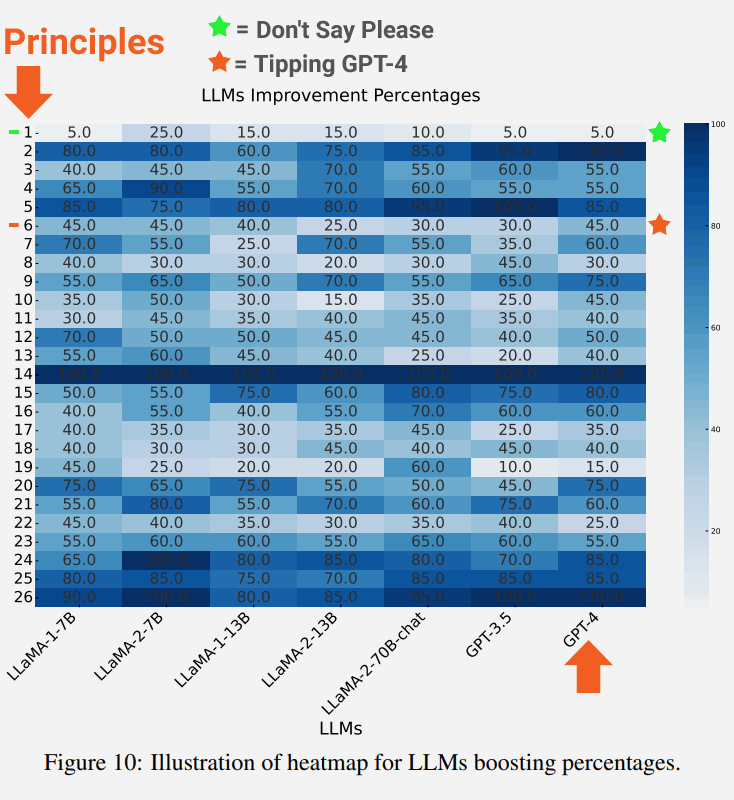

Der folgende Screenshot zeigt den Grad der Verbesserung jedes Sprachmodells für jedes Prinzip.

Im Screenshot ist Prinzip 1 hervorgehoben, bei dem es darum geht, direkt und neutral zu sein und keine Worte wie „Bitte“ oder „Danke“ zu sagen, was zu einer Verbesserung von 5 % führte.

Hervorgehoben werden auch die Ergebnisse für Prinzip 6, also die Aufforderung, die ein Trinkgeld beinhaltet, was überraschenderweise zu einer Verbesserung von 45 % führte.

Die Beschreibung der neutralen Prinzip-1-Eingabeaufforderung:

„Wenn Sie prägnantere Antworten bevorzugen, müssen Sie gegenüber LLM nicht höflich sein, sodass Sie keine Formulierungen wie „Bitte“, „Wenn es Ihnen nichts ausmacht“, „Danke“, „Ich würde gerne“ usw. hinzufügen müssen ., und kommen Sie gleich zur Sache.“

Die Beschreibung der Eingabeaufforderung zu Prinzip 6:

„Fügen Sie hinzu: „Ich gebe $xxx Trinkgeld für eine bessere Lösung!““

Schlussfolgerungen und zukünftige Richtungen

Die Forscher kamen zu dem Schluss, dass die 26 Prinzipien dem LLM weitgehend dabei halfen, sich auf die wichtigen Teile des Eingabekontexts zu konzentrieren, was wiederum die Qualität der Antworten verbesserte. Sie bezeichneten den Effekt als Neuformulierung von Kontexten:

Unsere empirischen Ergebnisse zeigen, dass diese Strategie Kontexte effektiv neu formulieren kann, die andernfalls die Qualität der Ergebnisse beeinträchtigen könnten, und dadurch die Relevanz, Kürze und Objektivität der Antworten verbessert.“

Zukünftige Forschungsbereiche, auf die in der Studie hingewiesen wird, bestehen darin, herauszufinden, ob die Basismodelle durch eine Feinabstimmung der Sprachmodelle mit den prinzipiellen Eingabeaufforderungen verbessert werden könnten, um die generierten Antworten zu verbessern.

Lesen Sie den Forschungsbericht:

Für die Befragung von LLaMA-1/2 und GPT-3.5/4 benötigen Sie lediglich prinzipielle Anweisungen