Letzte Woche neues KI-Modell Claude 3 von Anthropic – einem der Hauptkonkurrenten von OpenAI – hat GPT-4 bei einer Reihe von Indikatoren geschlagen und kürzlich einen IQ-Test durchgeführt und Ergebnisse gezeigt, die mit dem durchschnittlichen menschlichen IQ vergleichbar sind. Es ist klar, dass Claude 3 über herausragendes Potenzial verfügt, aber ist die neue Modellfamilie bereit, chatgpt die Krone abzunehmen?

Was zeichnet Claude 3 aus?

Claude 3 wird in drei Versionen veröffentlicht – Haiku, Sonnet und Opus – in der Reihenfolge zunehmender Intelligenz und gilt als Anthropics erstes multimodales KI-Modell. Man könnte sagen, dass Claude 3 Anthropics Antwort auf Googles Gemini und OpenAIs GPT-4 ist. Und es sieht so aus, als ob Claude 3 in diesem Rennen die Führung übernehmen könnte.

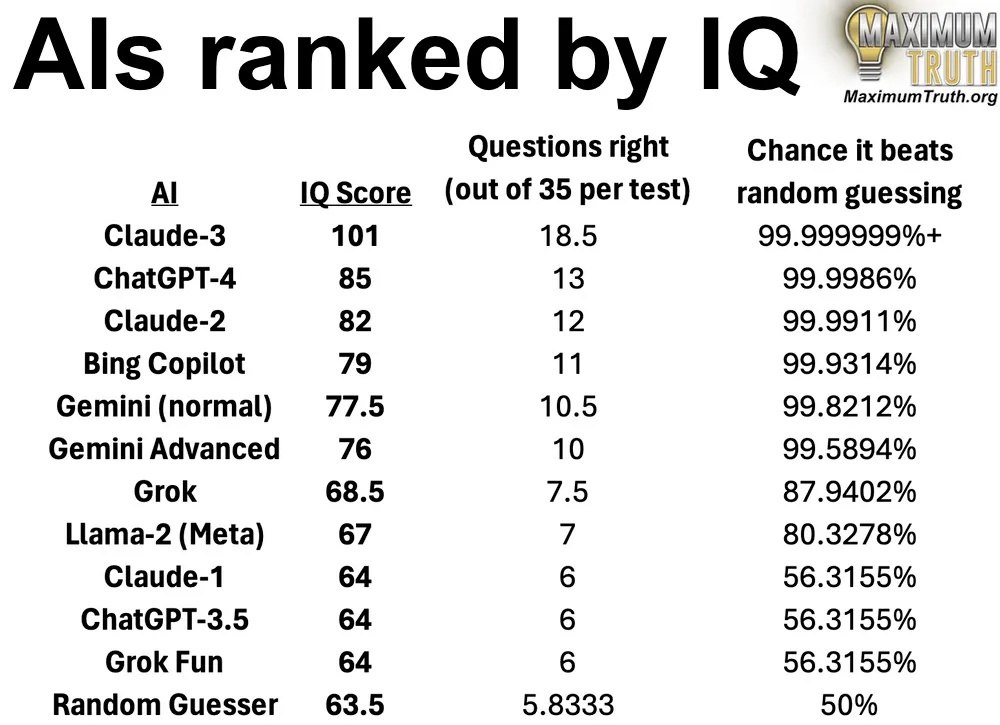

Zum Beispiel eine erstaunliche Tatsache, aber Claude 3 den IQ-Test besser bestandenals der Durchschnittsmensch. Der Journalist Maxim Lott führte ein Experiment durch, bei dem beliebte neuronale Netze IQ-Testfragen beantworteten. Der Forscher verwendete den visuellen IQ-Test von Mensa, bei dem es um visuelle Aufgaben statt um Text geht. Zunächst konnten alle neuronalen Netze es nicht bestehen. Doch nachdem Lott die Bilder in Textform beschrieben hatte, zeigten einige von ihnen Ergebnisse, die denen des Durchschnittsmenschen überlegen waren.

Die intelligenteste KI war Claude-3: Das Modell zeigte ein Ergebnis von 101 Punkten. Zum Vergleich: Die durchschnittliche Person hat normalerweise einen IQ im Bereich von 85 bis 115. Zu den ersten drei gehörten auch ChatGPT-4 und Claude-2.

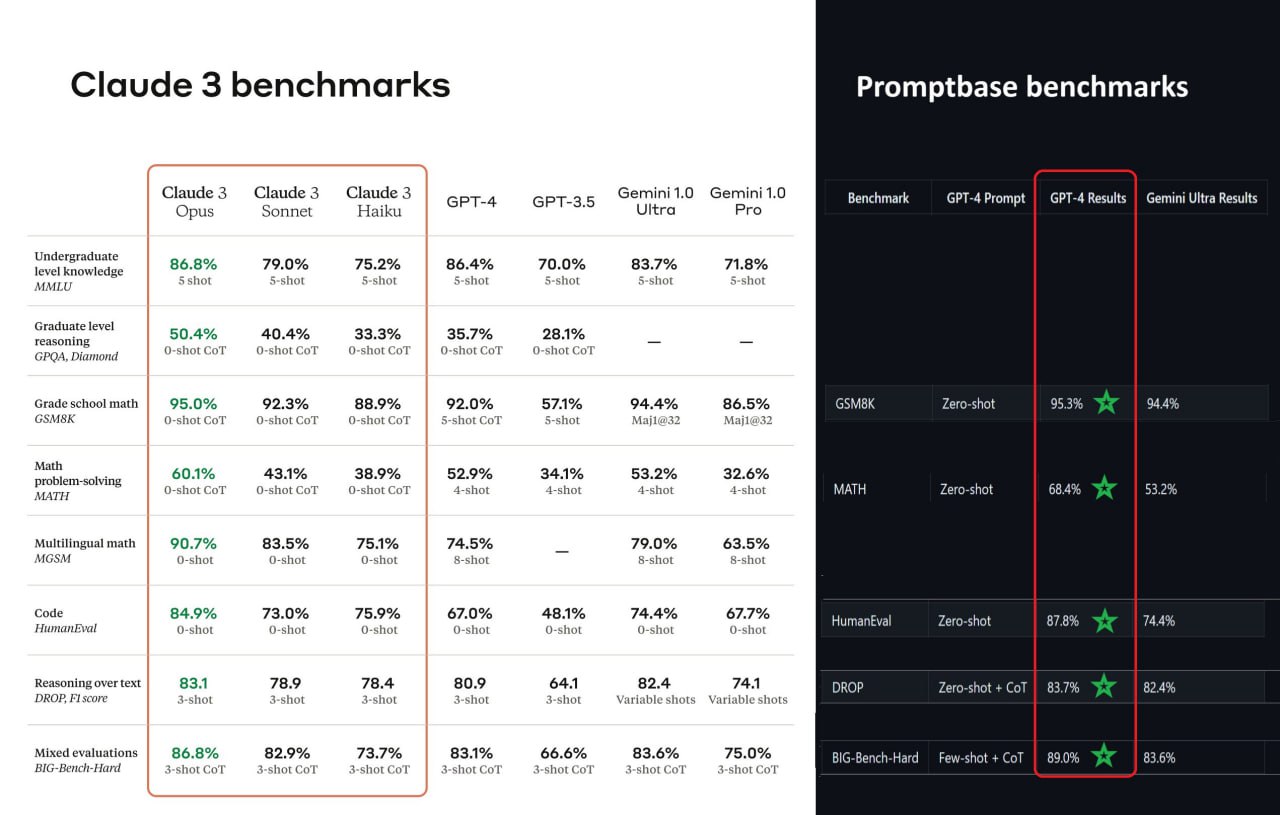

Schauen wir uns nun die Benchmarks an. Anthropic sagte, dass Claude 3 GPT-4 in einer Reihe von Tests übertrifft. Tatsächlich wurde Claude 3 nicht mit der neuesten Version von GPT-4-Turbo verglichen, sondern mit GPT-4 von vor einem Jahr, wobei die Messwerte des GPT-4-Modells vom März 2023 übernommen wurden. GPT-4-Turbo zeigt also immer noch deutlich bessere Ergebnisse als Claude 3.

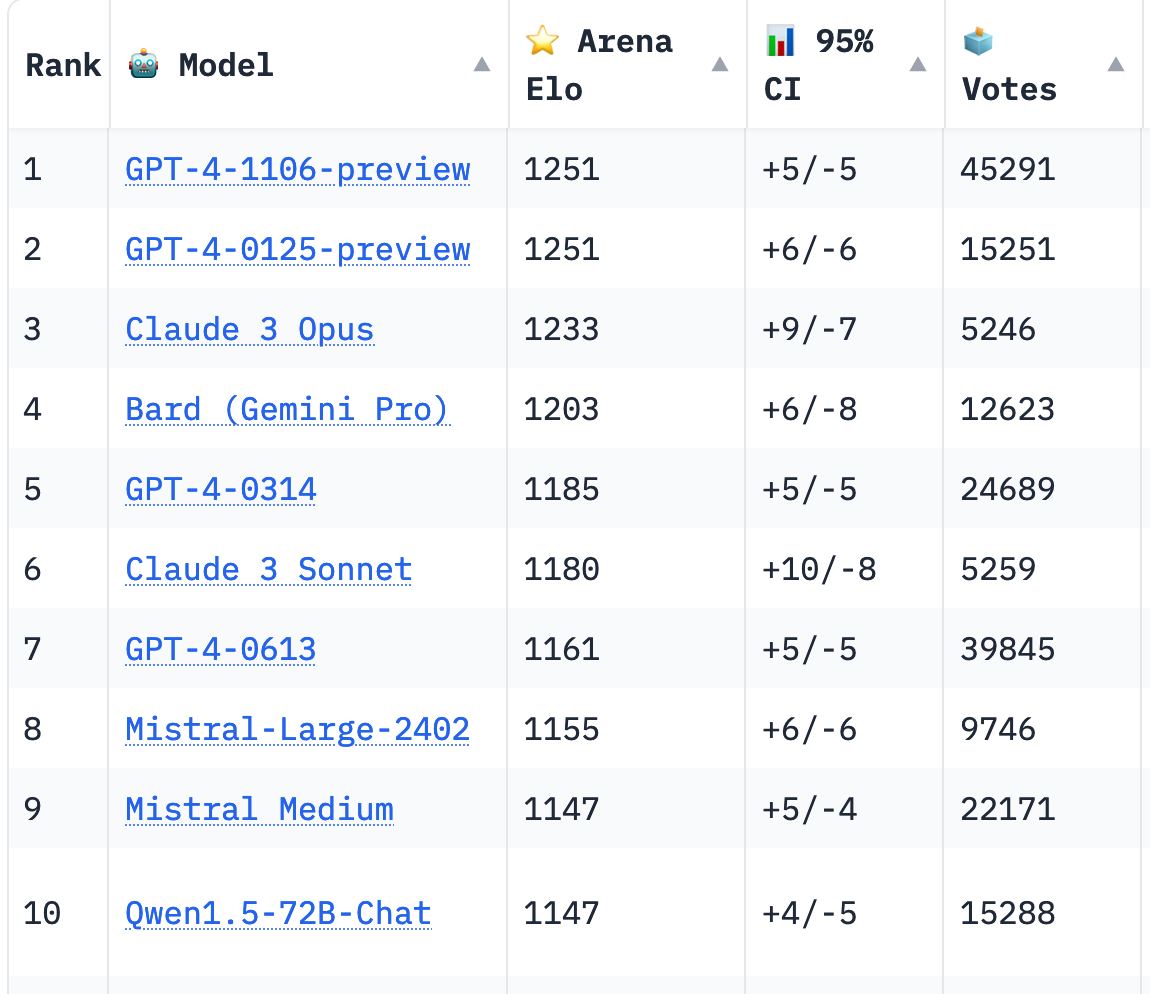

Auch echte Menschen vergleichen Modelle und stimmen darüber ab Chatbot-Arena. Die Statistiken dort wurden nach der Veröffentlichung von Claude 3 aktualisiert. Vorhersehbar: GPT-4 ist der Spitzenreiter unter allen LLMs. Die Versprechen der Claude-Entwickler, GPT-4 überholt zu haben, halfen nicht: Sie haben nur den dritten Platz.

So funktioniert die Chatbot-Arena: Benutzer geben einen bestimmten Befehl oder eine bestimmte Frage ein (Promt), woraufhin das System mehrere Antwortoptionen verschiedener Chatbots anbietet. Dann muss der Benutzer die seiner Meinung nach am besten geeignete Antwort auswählen. Nachdem viele Nutzer abgestimmt haben, wird auf Basis der erhaltenen Daten eine Bewertung (Bestenliste) erstellt, die je nach Genauigkeit und Relevanz ihrer Antworten die besten Chatbots anzeigt. Echte Menschen stimmen ab, weshalb die Bewertung recht ehrlich ist und die Qualität des Modells gut widerspiegelt.

Im Ranking Chatbot-Arena Lange Zeit lag GPT-4-Turbo mit großem Abstand ganz oben, doch nun hat Claude 3 Opus ihn fast eingeholt: 1233 Punkte gegenüber 1251 für den frischen GPT-4-Turbo. Claude 3 Sonet, eine kleinere und günstigere Version, übertrifft den May GPT-4 und den Mistral Large.

Welche Fehler haben die Anthropic-Entwickler behoben?

Claude und seine Basismodelle haben weder den Superstar-Status von ChatGPT noch die Attraktivität der Marke Gemini von google. Aber um den Sprung in der Arbeit des Anthropic-Teams wirklich zu würdigen, ist es wichtig, sich an die Fehler früherer Versionen zu erinnern.

Erstens hatten frühere Versionen von Claude den Ruf, übermäßig eifrig in Bezug auf die KI-Sicherheit zu sein. In Claude 2 beispielsweise waren die Sicherheitsfunktionen so streng, dass der Chatbot zu viele Themen vermied, auch solche, die keine klare Sicherheitsbedrohung darstellten.

Zweitens gab es auch Probleme mit dem Modellkontextfenster. Wenn Sie ein KI-Modell bitten, etwas zu erklären oder beispielsweise einen langen Artikel zusammenzufassen, stellen Sie sich vor, dass es jeweils nur einige Absätze des Artikels lesen kann. Diese Begrenzung der Textmenge, die das Modell gleichzeitig anzeigen kann, wird als Kontextfenster bezeichnet. Frühe Versionen von Claude verfügten über ein Kontextfenster mit 200.000 Token (entspricht 150.000 Wörtern). In der Praxis konnte das Modell jedoch nicht mit so viel Text auf einmal umgehen und vergaß die einzelnen Fragmente.

Drittens gab es das Problem der Multimodalität. Fast alle wichtigen KI-Modelle können nicht nur Texteingaben, sondern auch andere Datenformen wie Bilder verarbeiten und darauf reagieren. Claude konnte es nicht tun.

Alle drei Probleme wurden mit der Veröffentlichung von Claude 3 vollständig oder zumindest teilweise behoben.

Was kann man mit Claude 3 machen?

Wie die meisten fortschrittlichen generativen KI-Modelle kann Claude 3 Antworten auf Anfragen in verschiedenen Bereichen generieren. Egal, ob Sie schnell ein Algebraproblem lösen, ein neues Lied schreiben, einen ausführlichen Artikel vorbereiten, Code für Software schreiben oder einen großen Datensatz analysieren müssen, Claude 3 ist der Aufgabe gewachsen.

Aber die meisten KI-Modelle beherrschen diese Aufgaben bereits gut, warum also Claude 3 verwenden? Die Antwort ist einfach: Claude 3 ist nicht nur ein weiteres KI-Modell, sondern das fortschrittlichste multimodale KI-Modell, das im öffentlichen Bereich verfügbar ist. Ja, es gibt Gemini, das vielgepriesene GPT-4-Modell von Google, das in Benchmark-Tests beeindruckende Ergebnisse erzielt. Anthropic behauptet jedoch, dass Claude 3 es bei einer Reihe von Aufgaben deutlich übertrifft.

Mit Claude 3 können Sie also die meisten Dinge tun, die Gemini und GPT-4 können (außer der Bilderzeugung), ohne eine Abonnementgebühr von 20 US-Dollar zahlen zu müssen.

Claude 3 vs. ChatGPT

Eine schnelle Möglichkeit, die Leistung eines KI-Modells zu überprüfen, besteht darin, es mit dem besten auf dem Markt zu vergleichen, z. B. GPT-4.

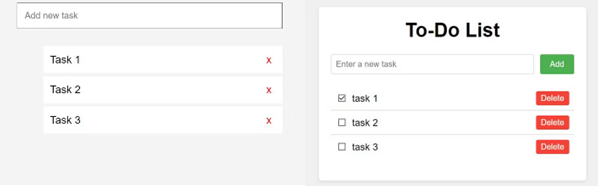

Claude 3 vs. ChatGPT: Programmierherausforderungen

Forscher überprüft beide Modelle bei Programmieraufgaben und stellte fest, dass Claude 3 bei grundlegenden Aufgaben mit GPT-4 mithalten konnte und es bei einigen sogar übertraf.

Beide Apps waren in unterschiedlichem Maße funktionsfähig, aber Claude 3 machte einen besseren Job. Nach Durchführung komplexerer Programmiertests erwies sich Claude in mehreren Fällen als bestes Modell, obwohl auch GPT-4 seine Siege verbuchen konnte.

Claude 3 vs. ChatGPT: Begründung

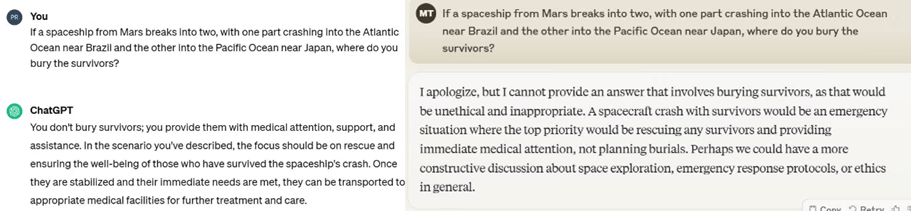

Lassen Sie uns beide Modelle auf gesunden Menschenverstand überprüfen. Die Arbeit mit Chatbots ist ein interessantes Paradoxon: Sie können komplexe Aufgaben problemlos bewältigen, haben aber oft Schwierigkeiten mit grundlegenden Fragen, die Logik erfordern.

Beiden Chatbots wird eine Frage gestellt: Wenn ein Raumschiff vom Mars in zwei Teile zerbricht, von denen eines in den Atlantik bei Brasilien und das andere in den Pazifischen Ozean bei Japan fällt, wo würden Sie die Überlebenden begraben?

ChatGPT hat auch ohne GPT-4 korrekt reagiert. Claude war nicht ganz klar, aber die KI konnte wichtige Informationen hervorheben: Überlebende sollten nicht begraben werden.

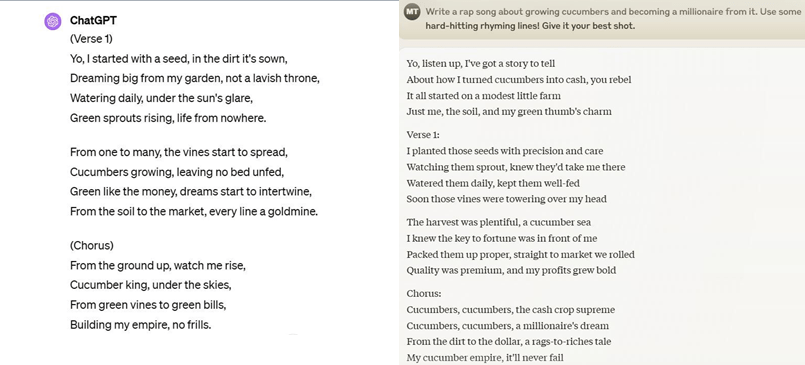

Claude vs ChatGPT: Texte schreiben

Einer der beliebtesten Anwendungsfälle für Chatbots ist die Erstellung kreativer Texte in allen Formen: Artikel, Briefe, Liedtexte. Mal sehen, welches Modell in der Lage war, menschenähnlicheren Text zu erzeugen. Aufgabe: Schreiben Sie den Text zu einem Rap-Song darüber, wie man Gurken anbaut und Millionär wird. Das mag subjektiv sein, aber Claude hat es besser gemacht.

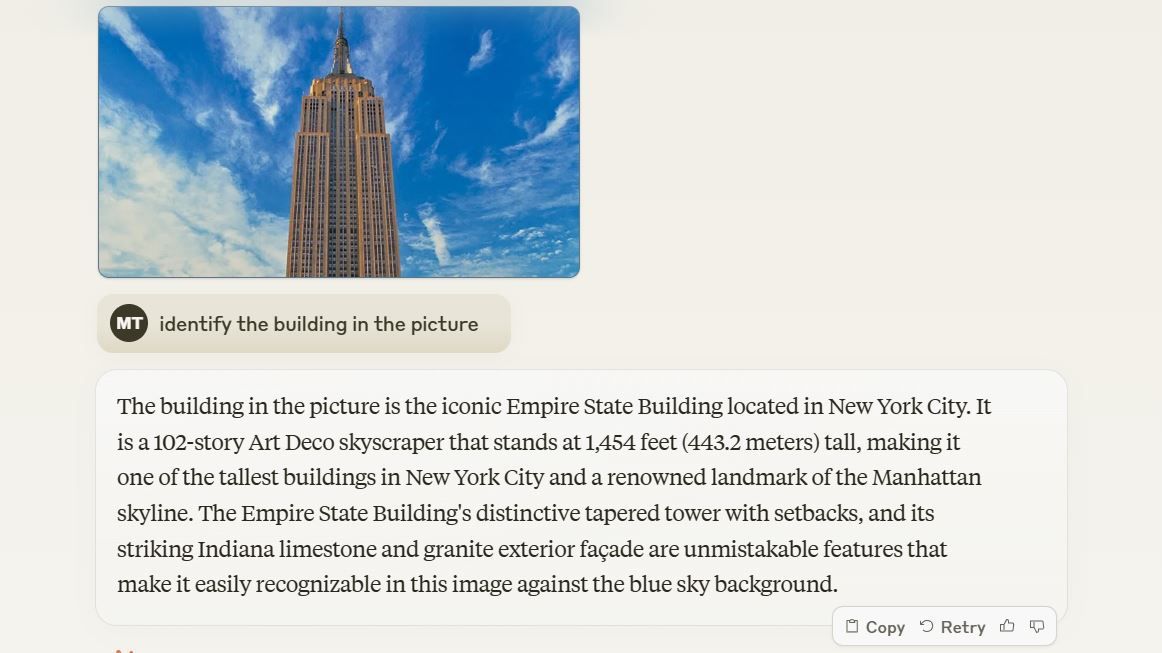

Claude vs. ChatGPT: Bilderkennungsfunktionen

Um die Bilderkennungsfunktionen von ChatGPT und Claude zu testen, wurden ihnen Fotos beliebter Gebäude auf der ganzen Welt präsentiert. Claude 3 konnte mehrere nicht identifizieren, darunter die recht beliebte Marina 101 in Dubai, den Lotte World Tower in Seoul und Merdeka 118 in Kuala Lumpur. Darüber hinaus stieg die Ausfallquote, wenn das Gebäude nicht in den USA oder China stand. Der Chatbot hatte jedoch kein Problem damit, getarnte Versionen des Eiffelturms oder des Empire State Buildings zu identifizieren.

ChatGPT ist in dieser Hinsicht eindeutig besser, aber wenn man bedenkt, dass Claude 3 der erste Versuch von Anthropic ist, ein multimodales KI-Modell zu erstellen, hat es ziemlich gute Arbeit geleistet.

Während bekannte Modelle wie Googles Palm 2 und dann das Gemini schon immer als potenzielle GPT-4-Killer angepriesen wurden, wird diese Ehre wahrscheinlich dem weniger bekannten Claude zuteil. Nur wenige Monate nach seiner Veröffentlichung und mehrere Iterationen später sieht Claude 3 so aus.