Während Meta das Meta AI-Update auf alle Plattformen brachte, veröffentlichte Meta auch den Llama 3-Benchmark für Technologie-Enthusiasten.

Der Benchmark bietet unabhängigen Forschern und Entwicklern eine standardisierte Testsuite, um die Leistung von Llama 3 bei verschiedenen Aufgaben zu bewerten.

Diese Transparenz ermöglicht es Benutzern, die Stärken und Schwächen von Llama 3 mit denen anderer LLMs zu vergleichen, die denselben Benchmark verwenden, und so ein objektiveres Verständnis seiner Fähigkeiten zu fördern.

Was zeigt der Llama 3 Benchmark?

Meta AI hat den Llama 3-Benchmark erstellt, eine umfassende Reihe von Bewertungen zur Bewertung der LLM-Leistung bei verschiedenen Aufgaben. Zu diesen Aufgaben gehören das Beantworten von Fragen, das Zusammenfassen, das Befolgen von Anweisungen und das Lernen mit wenigen Schüssen. Der Benchmark dient als entscheidendes Instrument zur Messung der Stärken und Schwächen von Llama 3 im Vergleich zu anderen LLMs.

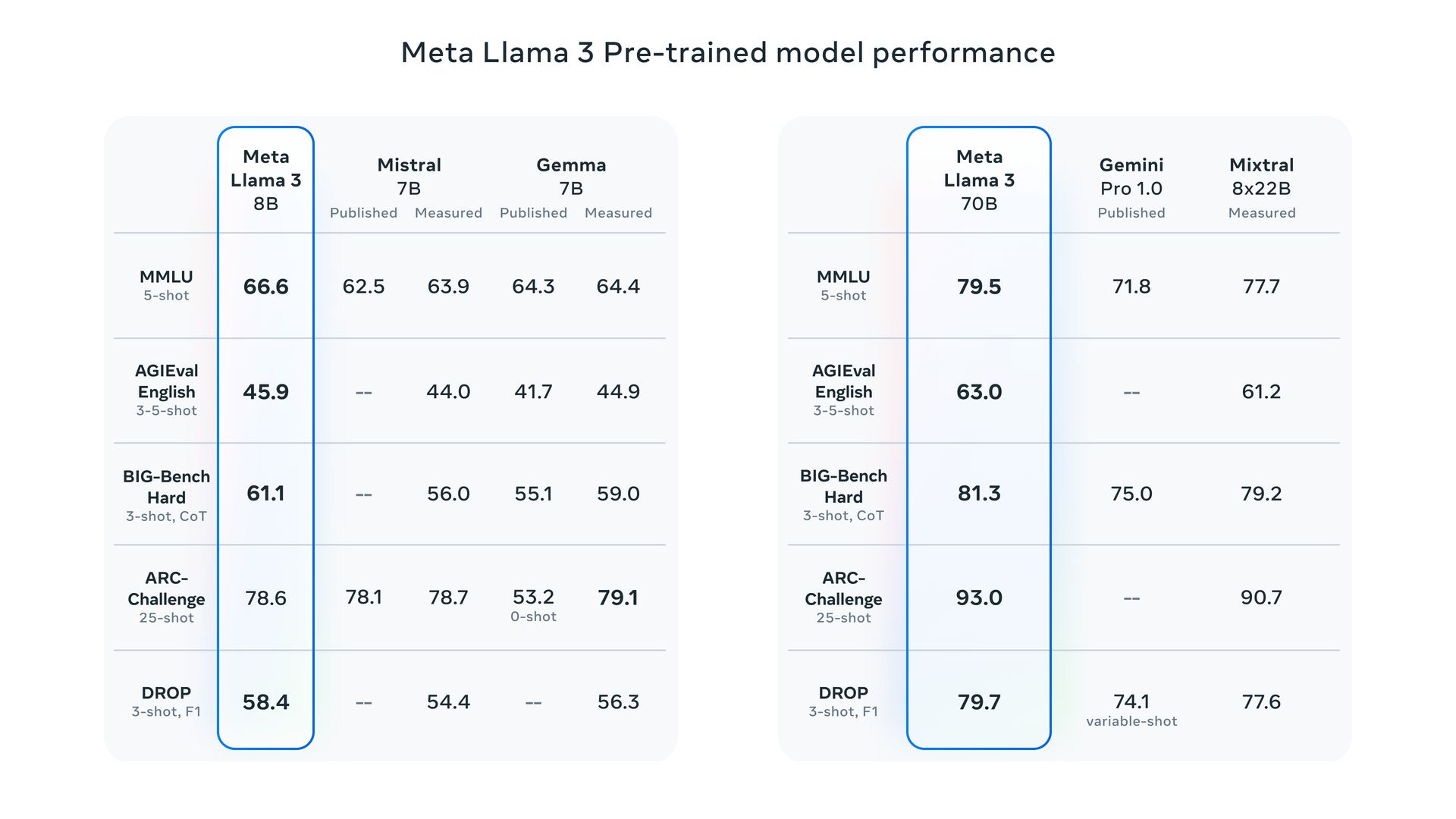

Während ein direkter Vergleich zwischen dem Llama 3-Benchmark und denen der Wettbewerber aufgrund unterschiedlicher Bewertungsmethoden schwierig ist, behauptet Meta, dass die auf ihrem Datensatz trainierten Llama 3-Modelle bei allen bewerteten Aufgaben eine außergewöhnliche Leistung erzielten. Dies zeigt, dass Meta AI mit den Besten im LLM-Bereich mithalten kann.

Hier ist ein genauerer Blick darauf, wie die Benchmarks von Llama 3 abschneiden:

- Parameterskala: Meta rühmt sich, dass ihre Llama-3-Modelle mit den Parametern 8B und 70B Llama 2 übertreffen und einen neuen Stand der Technik für LLMs ähnlicher Größe darstellen.

- Menschliche Bewertung: Meta führte menschliche Bewertungen anhand eines umfassenden Datensatzes durch, der 12 wichtige Anwendungsfälle umfasste. Diese Bewertung positioniert das 70B-Anweisungsfolgemodell Llama 3 im Vergleich zu Konkurrenten vergleichbarer Größe in realen Szenarien positiv.

Hierbei handelt es sich um eigene Bewertungen von Meta. Für einen aussagekräftigeren Vergleich könnten unabhängige Benchmarks erforderlich sein.

Open-Weights vs. Open-Source

Es ist wichtig, zwischen „Open-Weights“ und „Open-Source“ zu unterscheiden. Während Llama 3 kostenlos herunterladbare Modelle und Gewichte bietet, fällt es aufgrund von Einschränkungen beim Zugriff und bei den Trainingsdaten nicht unter die strenge Definition von Open Source (im Gegensatz zu echter Open-Source-Software).

Lama 3 gibt es in zwei Größen: 8 Milliarden (8B) Und 70 Milliarden (70 Milliarden) Parameter. Beide sind steht zum kostenlosen Download auf der Website von Meta zur Verfügung nach einem einfachen Anmeldevorgang.

Ein technischer tiefer Einblick in Meta AI

Llama 3 bietet zwei Versionen:

- Vorab trainiert: Dies ist das Rohmodell, das sich auf die Vorhersage des nächsten Tokens konzentriert.

- Anleitung abgestimmt: Diese Version ist genau darauf abgestimmt, spezifische Benutzeranweisungen zu befolgen.

Beide Versionen haben ein Kontextlimit von 8.192 Token.

Trainingsdetails

- Trainingshardware: Meta nutzte für das Training von Llama 3 zwei speziell angefertigte Cluster mit jeweils sagenhaften 24.000 GPUs.

- Trainingsdaten: Mark Zuckerberg, CEO von Meta, enthüllte in einem Podcast-Interview, dass das 70B-Modell auf einem riesigen Datensatz von rund 15 Billionen Token trainiert wurde. Interessanterweise erreichte das Modell während des Trainings nie einen Sättigungspunkt (Höchstleistung), was darauf hindeutet, dass es bei noch größeren Datensätzen möglicherweise Raum für weitere Verbesserungen gibt.

- Zukunftspläne: Meta trainiert derzeit eine kolossale 400B-Parameterversion von Llama 3, was es bei Benchmarks wie MMLU, GPQA, HumanEval und MATH möglicherweise in die gleiche Leistungsliga wie Konkurrenten wie GPT-4 Turbo und Gemini Ultra bringt.

Die Herausforderungen im Llama 3 Benchmark

Wir müssen die Einschränkungen der aktuellen LLM-Benchmarks anerkennen, die auf Faktoren wie die Kontamination von Trainingsdaten und die Auswahl der Ergebnisse durch die Anbieter zurückzuführen sind.

Trotz dieser Einschränkungen stellte Meta einige Benchmarks zur Verfügung, die die Leistung von Llama 3 bei Aufgaben wie MMLU (Allgemeinwissen), GSM-8K (Mathematik), HumanEval (Codierung), GPQA (Fortgeschrittene Fragen) und MATH (Textaufgaben) demonstrieren.

Diese Benchmarks positionieren das 8B-Modell im Vergleich zu Konkurrenten mit offenen Gewichten wie dem Gemma 7B und dem Mistral 7B Instruct von google. Auch gegen etablierte Namen wie Gemini Pro 1.5 und Claude 3 Sonnet kann sich das 70B-Modell behaupten.

Zugänglichkeit von Lama 3

Meta plant, Llama 3-Modelle auf großen Cloud-Plattformen wie AWS, Databricks, Google Cloud und anderen verfügbar zu machen und so eine breite Zugänglichkeit für Entwickler zu gewährleisten.

Llama 3 bildet die Grundlage des virtuellen Assistenten von Meta, der in Suchfunktionen auf Facebook, Instagram, WhatsApp, Messenger usw. prominent vertreten sein wird eigene Website ähnelt der ChatGPT-Schnittstelle (einschließlich Bildgenerierung).

Zusätzlich, Meta ist eine Partnerschaft mit Google eingegangen Echtzeit-Suchergebnisse in den Assistenten zu integrieren und darauf aufzubauen bestehende Partnerschaft mit Microsofts Bing.

Hervorgehobener Bildnachweis: Meta