Am Donnerstag stellte Meta frühe Versionen davon vor Lama 3 Offenes KI-Modell, das zur Texterstellung, Codegenerierung oder für Chatbots verwendet werden kann. Es gab auch bekannt, dass es Meta-KI-Assistent ist jetzt auf einer Website verfügbar und soll in seine wichtigsten Social-Media-Apps integriert werden, was die Bemühungen des Unternehmens verstärkt, seine Produkte im Vergleich zu anderen KI-Assistenten wie chatgpt von OpenAI, Copilot von Microsoft und Gemini von google zu positionieren.

Wie sein Vorgänger Llama 2 zeichnet sich Llama 3 dadurch aus, dass es ein frei verfügbares, offenes Large Language Model (LLM) ist, das von einem großen KI-Unternehmen bereitgestellt wird. Technisch gesehen gilt Llama 3 nicht als „Open Source“, da dieser Begriff eine hat spezifische Bedeutung in Software (wie wir in anderen Berichten erwähnt haben), und die Branche hat sich noch nicht auf die Terminologie für KI-Modellversionen geeinigt, die entweder Code oder Gewichte mit Einschränkungen liefern (Sie können die Lizenz von Llama 3 lesen). Hier) oder dieses Schiff ohne Bereitstellung von Trainingsdaten. Normalerweise bezeichnen wir diese Veröffentlichungen stattdessen als „offene Gewichte“.

Derzeit ist Llama 3 in zwei Parametergrößen verfügbar: 8 Milliarden (8B) und 70 Milliarden (70B), die beide als kostenlose Downloads auf der Website von Meta mit a verfügbar sind Melden Sie sich an. Llama 3 gibt es in zwei Versionen: vorab trainiert (im Grunde das rohe Modell zur Vorhersage des nächsten Tokens) und anweisungsoptimiert (feinabgestimmt, um Benutzeranweisungen zu befolgen).

Benj Edwards

Meta trainierte beide Modelle auf zwei Maßgeschneiderte Cluster mit 24.000 GPUs. In einem Podcast-Interview mit Dwarkesh PatelMark Zuckerberg, CEO von Meta, sagte, dass das Unternehmen das 70B-Modell mit rund 15 Billionen Datentokens trainiert habe. Während des gesamten Prozesses erreichte das Modell nie die „Sättigung“ (das heißt, es stieß nie an Grenzen hinsichtlich der Leistungssteigerung). Schließlich zog Meta den Stecker und begann, andere Modelle zu trainieren.

„Ich schätze, unsere Vorhersage war, dass es mehr asymptotieren würde, aber selbst am Ende war es immer noch geneigt. Wir hätten ihm wahrscheinlich mehr Token geben können, und es wäre etwas besser geworden“, sagte Zuckerberg im Podcast.

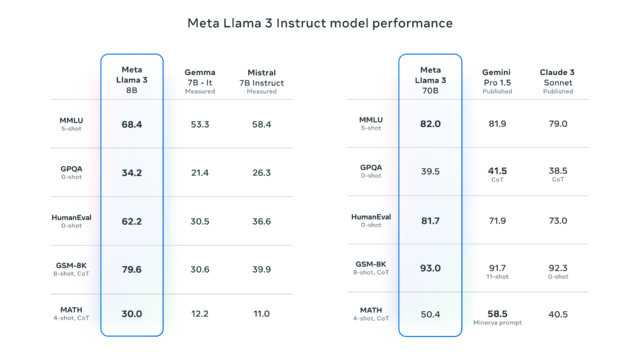

Meta gab außerdem bekannt, dass es derzeit eine 400B-Parameterversion von Llama 3 trainiert, was einige Experten wie Jim Fan von Nvidia für möglich halten in der gleichen Liga spielen wie GPT-4 Turbo, Claude 3 Opus und Gemini Ultra auf Benchmarks wie MMLU, GPQA, HumanEvalUnd MATHEMATIK.

Apropos Benchmarks: Wir haben in der Vergangenheit viele Worte darauf verwendet, zu erklären, wie frustrierend ungenau Benchmarks sein können, wenn sie auf große Sprachmodelle angewendet werden, was auf Probleme wie Trainingskontamination (d. h. Einbeziehung von Benchmark-Testfragen in den Trainingsdatensatz) und Rosinenpickerei zurückzuführen ist Seitens der Anbieter und die Unfähigkeit, den allgemeinen Nutzen von KI in einer interaktiven Sitzung mit per Chat abgestimmten Modellen zu erfassen.

Aber wie erwartet hat Meta einige Benchmarks für Llama 3 bereitgestellt, in denen die Ergebnisse aufgeführt sind MMLU (Grundkenntnisse auf Bachelor-Niveau), GSM-8K (Grundschulmathematik), HumanEval (Kodierung), GPQA (Fragen für Hochschulabsolventen) und MATHEMATIK (Mathe-Textaufgaben). Diese zeigen, dass das 8B-Modell im Vergleich zu Modellen mit offenem Gewicht wie Googles Gemma 7B und anderen gut abschneidet Mistral 7B Instruct, und das 70B-Modell konnte sich auch gegen Gemini Pro 1.5 und Claude 3 Sonnet behaupten.

Meta sagt, dass das Llama-3-Modell um Funktionen zum Verständnis von Codierung erweitert wurde (wie Llama 2) und zum ersten Mal sowohl mit Bildern als auch mit Text trainiert wurde – obwohl es derzeit nur Text ausgibt. Entsprechend ReutersChris Cox, Chief Product Officer von Meta, bemerkte in einem Interview, dass in zukünftigen Updates von Llama 3 komplexere Verarbeitungsfähigkeiten (wie die Ausführung mehrstufiger Pläne) erwartet werden, die auch multimodale Ausgaben unterstützen werden – also sowohl Text als auch Bilder.

Meta plant, die Llama 3-Modelle auf einer Reihe von Cloud-Plattformen zu hosten und sie über AWS, Databricks, Google Cloud und andere große Anbieter zugänglich zu machen.

Ebenfalls am Donnerstag gab Meta bekannt, dass Llama 3 die neue Basis des virtuellen Assistenten Meta AI werden wird, den das Unternehmen erstmals im September angekündigt hatte. Der Assistent wird prominent in den Suchfunktionen für Facebook, Instagram, WhatsApp, Messenger und die oben genannten erscheinen eigene Website Es verfügt über ein ähnliches Design wie ChatGPT und bietet die Möglichkeit, Bilder in derselben Benutzeroberfläche zu generieren. Das Unternehmen kündigte außerdem eine Partnerschaft mit Google an, um Echtzeit-Suchergebnisse in den Meta-KI-Assistenten zu integrieren, und ergänzt damit eine bestehende Partnerschaft mit Microsofts Bing.