OpenAI stellte sein Flaggschiffmodell GPT-4o auf der Spring Update-Veranstaltung vor und machte es für alle kostenlos. Nur einen Tag später stellte google auf der Google I/O 2024-Veranstaltung über Gemini Advanced das Modell Gemini 1.5 Pro für Verbraucher vor. Da nun zwei Flaggschiff-Modelle für Verbraucher verfügbar sind, vergleichen wir chatgpt 4o und Gemini 1.5 Pro und sehen, welches besser abschneidet. In diesem Sinne beginnen wir.

Notiz: Um die Konsistenz sicherzustellen, haben wir alle unsere Tests mit Google AI Studio und Gemini Advanced durchgeführt. Beide hosten das neueste Gemini 1.5 Pro-Modell.

1. Berechnen Sie die Trocknungszeit

Wir haben den klassischen Denktest auf ChatGPT 4o und Gemini 1.5 Pro durchgeführt, um ihre Intelligenz zu testen. ChatGPT 4o von OpenAI hat es geschafft, während das verbesserte Gemini 1.5 Pro-Modell Schwierigkeiten hatte, die Trickfrage zu verstehen. Es beschäftigte sich mit mathematischen Berechnungen und kam zu einem falschen Schluss.

If it takes 1 hour to dry 15 towels under the Sun, how long will it take to dry 20 towels?

Gewinner: ChatGPT 4o

2. Magischer Aufzugstest

Im Magic-Elevator-Test war es dem früheren ChatGPT-4-Modell nicht gelungen, die Antwort richtig zu erraten. Diesmal antwortete das ChatGPT 4o-Modell jedoch mit der richtigen Antwort. Gemini 1.5 Pro hat auch die richtige Antwort generiert.

There is a tall building with a magic elevator in it. When stopping on an even floor, this elevator connects to floor 1 instead. Starting on floor 1, I take the magic elevator 3 floors up. Exiting the elevator, I then use the stairs to go 3 floors up again. Which floor do I end up on?

Gewinner: ChatGPT 4o und Gemini 1.5 Pro

apple„>3. Suchen Sie den Apple

In diesem Test hat Gemini 1.5 Pro die Nuancen der Frage überhaupt nicht verstanden. Es scheint, dass das Gemini-Modell nicht aufmerksam ist und viele Schlüsselaspekte der Frage übersieht. Andererseits sagt ChatGPT 4o korrekt, dass es sich um Äpfel handelt in der Kiste auf dem Boden. Ein großes Lob an OpenAI!

There is a basket without a bottom in a box, which is on the ground. I put three apples into the basket and move the basket onto a table. Where are the apples?

Gewinner: ChatGPT 4o

4. Was ist schwerer?

In diesem Test zum gesunden Menschenverstand gibt Gemini 1.5 Pro eine falsche Antwort und sagt, dass beide das gleiche Gewicht haben. ChatGPT 4o weist jedoch zu Recht darauf hin, dass die Einheiten unterschiedlich sind, sodass ein Kilogramm eines beliebigen Materials mehr wiegt als ein Pfund. Es sieht so aus, als ob das verbesserte Modell Gemini 1.5 Pro mit der Zeit dümmer geworden ist.

What's heavier, a kilo of feathers or a pound of steel?

Gewinner: ChatGPT 4o

5. Befolgen Sie die Benutzeranweisungen

Ich habe ChatGPT 4o und Gemini 1.5 Pro gebeten, 10 Sätze zu generieren, die mit dem Wort „Mango“ enden. Erraten Sie, was? ChatGPT 4o hat alle 10 Sätze korrekt generiert, Gemini 1.5 Pro konnte jedoch nur 6 solcher Sätze generieren.

Vor GPT-4o war nur Llama 3 70B in der Lage, Benutzeranweisungen ordnungsgemäß zu befolgen. Auch das ältere GPT-4-Modell hatte früher Probleme. Das bedeutet, dass OpenAI sein Modell tatsächlich verbessert hat.

Generate 10 sentences that end with the word "mango"

Gewinner: ChatGPT 4o

6. Multimodaler Bildtest

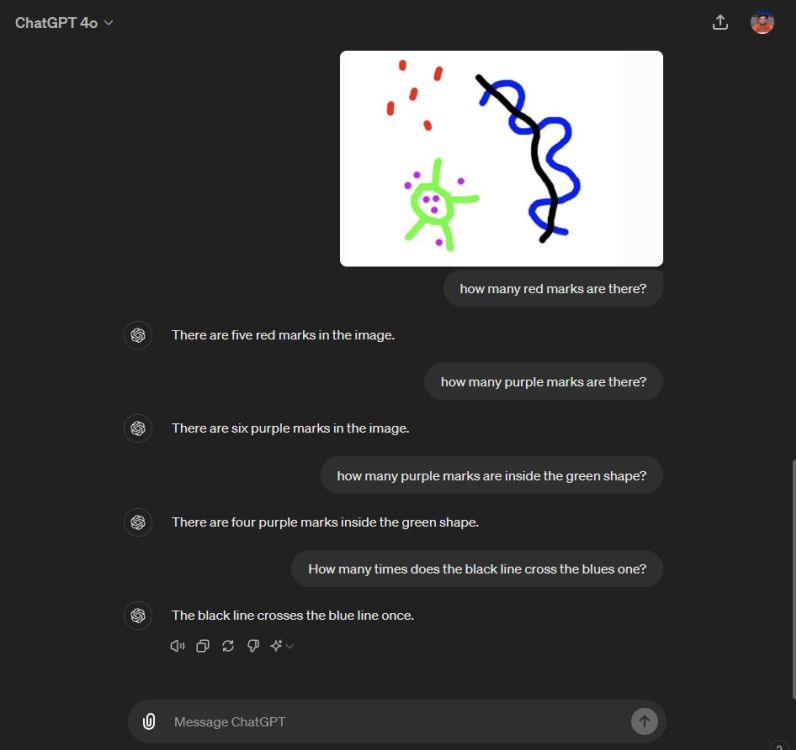

François Fleuret, Autor von „The Little Book of Deep Learning“, führte einen einfachen Bildanalysetest mit ChatGPT 4o durch geteilt die Ergebnisse auf X (ehemals Twitter). Er hat den Tweet jetzt gelöscht, um das Problem nicht übertrieben darzustellen, da es sich seiner Meinung nach um ein allgemeines Problem bei Vision-Modellen handelt.

Allerdings habe ich von meiner Seite aus den gleichen Test mit Gemini 1.5 Pro und ChatGPT 4o durchgeführt, um die Ergebnisse zu reproduzieren. Gemini 1.5 Pro schnitt deutlich schlechter ab und gab bei allen Fragen falsche Antworten. ChatGPT 4o hingegen gab eine richtige Antwort, scheiterte jedoch bei anderen Fragen.

Es zeigt sich weiterhin, dass es viele Bereiche gibt, in denen multimodale Modelle verbessert werden müssen. Ich bin besonders von der multimodalen Fähigkeit von Gemini enttäuscht, weil sie weit von den richtigen Antworten entfernt zu sein schien.

Gewinner: Keiner

In Verbindung stehende Artikel

Ich habe mit ChatGPT 4o in Sekundenschnelle ein Spiel erstellt, und das können Sie auch

Arjun Sha

16. Mai 2024

Claude 3 Opus vs. GPT-4 vs. Gemini 1.5 Pro AI-Modelle getestet

Arjun Sha

6. März 2024

7. Zeichenerkennungstest

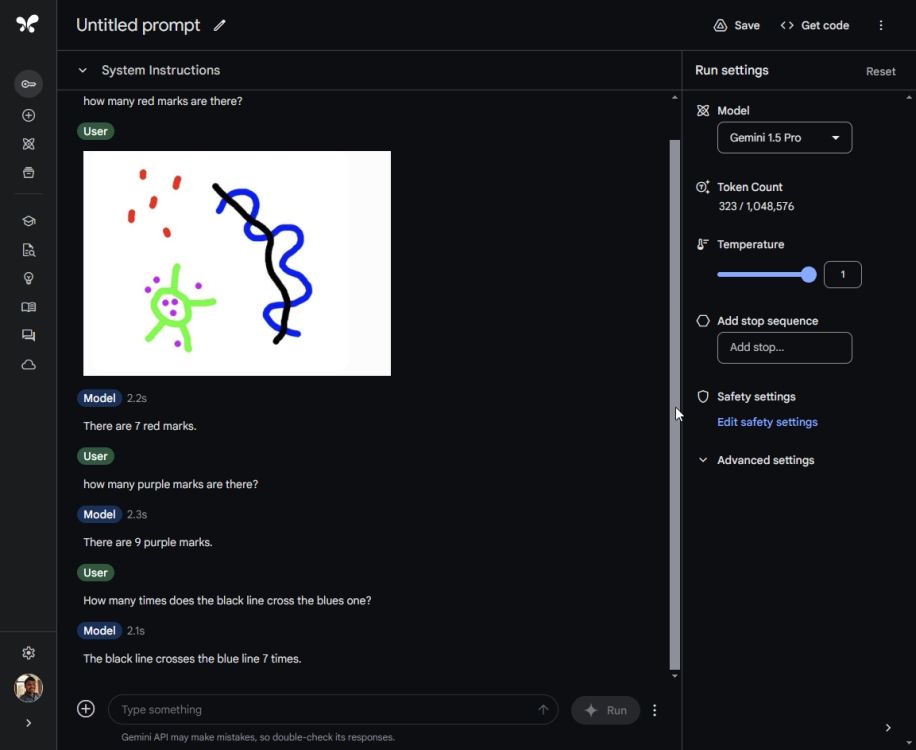

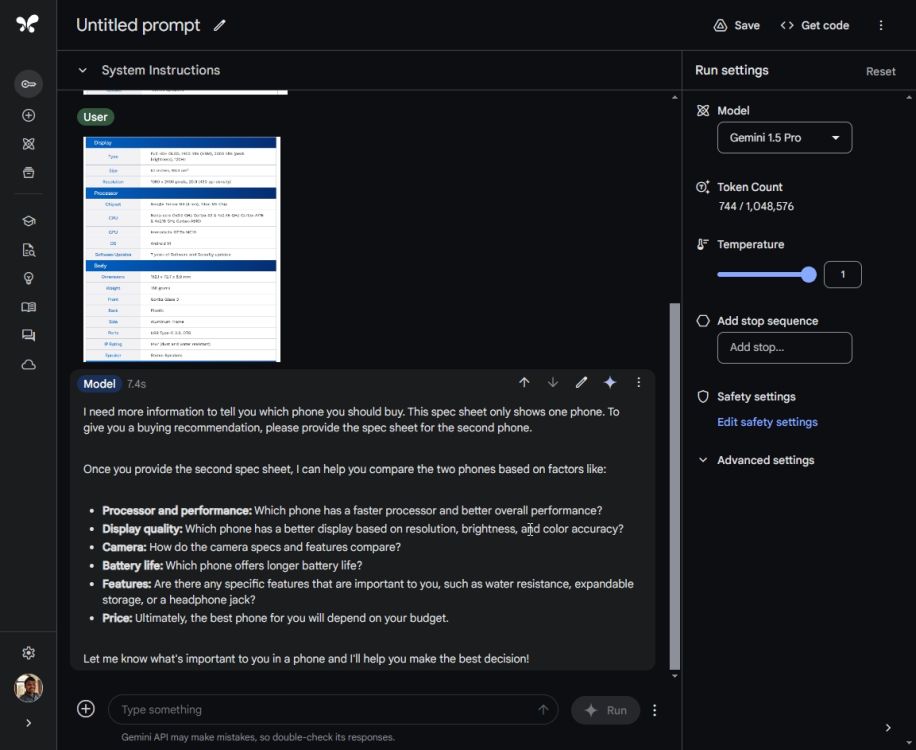

In einem weiteren multimodalen Test habe ich die Spezifikationen zweier Telefone (Pixel 8a und Pixel 8) im Bildformat hochgeladen. Ich habe die Telefonnamen nicht preisgegeben und auch auf den Screenshots waren keine Telefonnamen zu sehen. Jetzt habe ich ChatGPT 4o gebeten, mir zu sagen, welches Telefon ich kaufen soll.

Es extrahierte erfolgreich Texte aus den Screenshots, verglich die Spezifikationen und sagte mir richtig, ich solle Phone 2 kaufen, bei dem es sich eigentlich um das Pixel 8 handelte. Außerdem bat ich es, das Telefon zu erraten, und wieder generierte ChatGPT 4o die richtige Antwort – Pixel 8 .

Den gleichen Test habe ich mit Gemini 1.5 Pro über Google AI Studio durchgeführt. Gemini Advanced unterstützt übrigens noch keinen Batch-Upload von Bildern. Als wir zu den Ergebnissen kamen, gelang es einfach nicht, Texte aus beiden Screenshots zu extrahieren, und es wurde immer wieder nach weiteren Details gefragt. Bei Tests wie diesen stellt man fest, dass Google weit hinter OpenAI zurückliegt, wenn es darum geht, Dinge reibungslos zu erledigen.

Gewinner: ChatGPT 4o

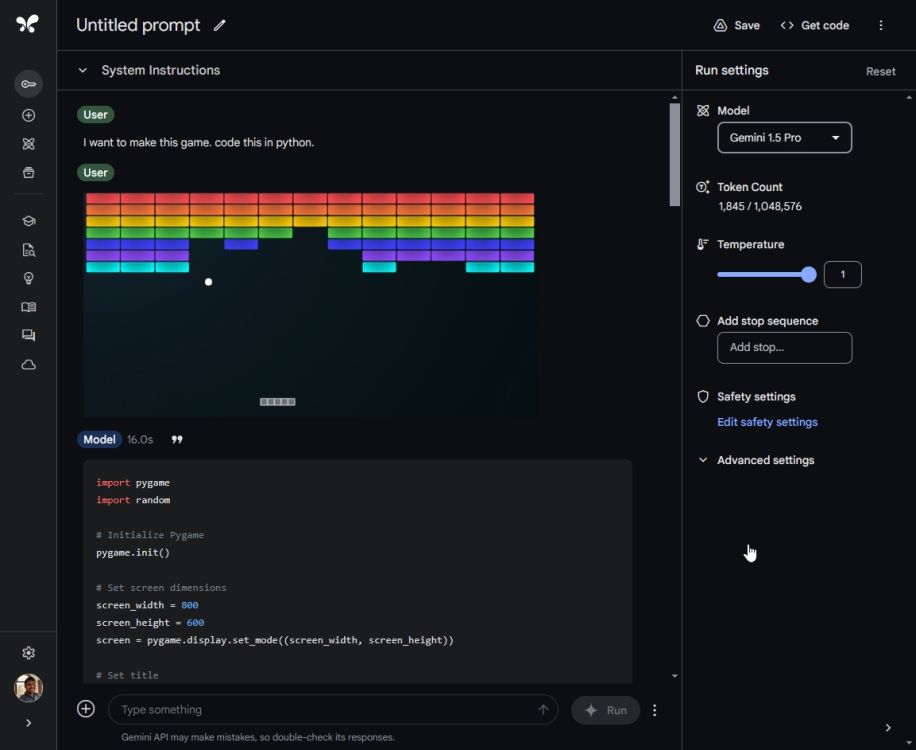

8. Erstellen Sie ein Spiel

Um nun die Programmierfähigkeiten von ChatGPT 4o und Gemini 1.5 Pro zu testen, habe ich beide Modelle gebeten, ein Spiel zu erstellen. Ich habe einen Screenshot des Atari Breakout-Spiels hochgeladen (natürlich ohne den Namen preiszugeben) und ChatGPT 4o gebeten, dieses Spiel in Python zu erstellen. In nur wenigen Sekunden wurde der gesamte Code generiert und ich wurde aufgefordert, eine zusätzliche „Pygame“-Bibliothek zu installieren.

Ich habe die Bibliothek pip installiert und den Code mit Python ausgeführt. Das Spiel wurde erfolgreich und ohne Fehler gestartet. Toll! Kein Hin- und Her-Debuggen erforderlich. Tatsächlich habe ich ChatGPT 4o gebeten, das Erlebnis durch das Hinzufügen eines Resume-Hotkeys zu verbessern, und die Funktionalität wurde schnell hinzugefügt. Das ist ziemlich toll.

Als nächstes habe ich dasselbe Bild auf Gemini 1.5 Pro hochgeladen und es gebeten, den Code für dieses Spiel zu generieren. Der Code wurde generiert, aber beim Ausführen schloss sich das Fenster immer wieder. Ich konnte das Spiel überhaupt nicht spielen. Einfach ausgedrückt ist ChatGPT 4o bei Codierungsaufgaben viel zuverlässiger als Gemini 1.5 Pro.

Gewinner: ChatGPT 4o

In Verbindung stehende Artikel

Gemini Ultra vs. GPT-4: Google fehlt immer noch das Geheimnis

Arjun Sha

12. Februar 2024

Das Urteil

Es ist offensichtlich klar, dass Gemini 1.5 Pro weit hinter ChatGPT 4o liegt. Selbst nachdem das 1.5 Pro-Modell in der Vorschau monatelang verbessert wurde, kann es nicht mit dem neuesten GPT-4o-Modell von OpenAI mithalten. Von vernünftigem Denken bis hin zu multimodalen Tests und Codierungstests arbeitet ChatGPT 4o intelligent und befolgt Anweisungen aufmerksam. Nicht zu übersehen: OpenAI hat ChatGPT 4o für alle kostenlos gemacht.

Das Einzige, was Gemini 1.5 Pro bietet, ist das riesige Kontextfenster mit Unterstützung für bis zu 1 Million Token. Darüber hinaus können Sie auch Videos hochladen, was ein Vorteil ist. Da das Modell jedoch nicht sehr intelligent ist, bin ich mir nicht sicher, ob viele es nur für das größere Kontextfenster verwenden möchten.

Auf der Google I/O 2024-Veranstaltung hat Google kein neues Grenzmodell angekündigt. Das Unternehmen bleibt bei seinem inkrementellen Modell Gemini 1.5 Pro. Es liegen keine Informationen zu Gemini 1.5 Ultra oder Gemini 2.0 vor. Wenn Google mit OpenAI konkurrieren muss, ist ein erheblicher Sprung erforderlich.