In einer aktuellen Studie veröffentlicht in npj Digitale MedizinForscher bewerteten die Fähigkeit von chatgpt, strukturierte Daten aus unstrukturierten klinischen Notizen zu extrahieren.

Studie: Eine kritische Bewertung der Verwendung von ChatGPT zum Extrahieren strukturierter Daten aus klinischen Notizen. Bildquelle: TippaPatt / Shutterstock.com

KI in der Medizin

Große sprachbasierte Modelle (LLMs), einschließlich Generative Pre-trained Transformer (GPT) und künstlicher Intelligenz (KI) wie ChatGPT, werden im Gesundheitswesen verwendet, um die Kommunikation zwischen Patient und Arzt zu verbessern.

Herkömmliche Ansätze zur Verarbeitung natürlicher Sprache (NLP) wie Deep Learning erfordern problemspezifische Annotationen und Modelltraining. Allerdings erschwert der Mangel an von Menschen kommentierten Daten in Verbindung mit den mit diesen Modellen verbundenen Kosten die Erstellung dieser Algorithmen.

Daher stellen LLMs wie ChatGPT eine praktikable Alternative dar, indem sie sich auf logisches Denken und Wissen stützen, um die Sprachverarbeitung zu unterstützen.

Über die Studie

In der vorliegenden Studie entwickeln Forscher eine LLM-basierte Methode zur Extraktion strukturierter Daten aus klinischen Notizen und zur anschließenden Umwandlung unstrukturierter Texte in strukturierte und analysierbare Daten. Zu diesem Zweck wurde das ChatGPT 3.50-Turbo-Modell verwendet, da es mit spezifischen Fähigkeiten der Künstlichen Allgemeinen Intelligenz (AGI) verbunden ist.

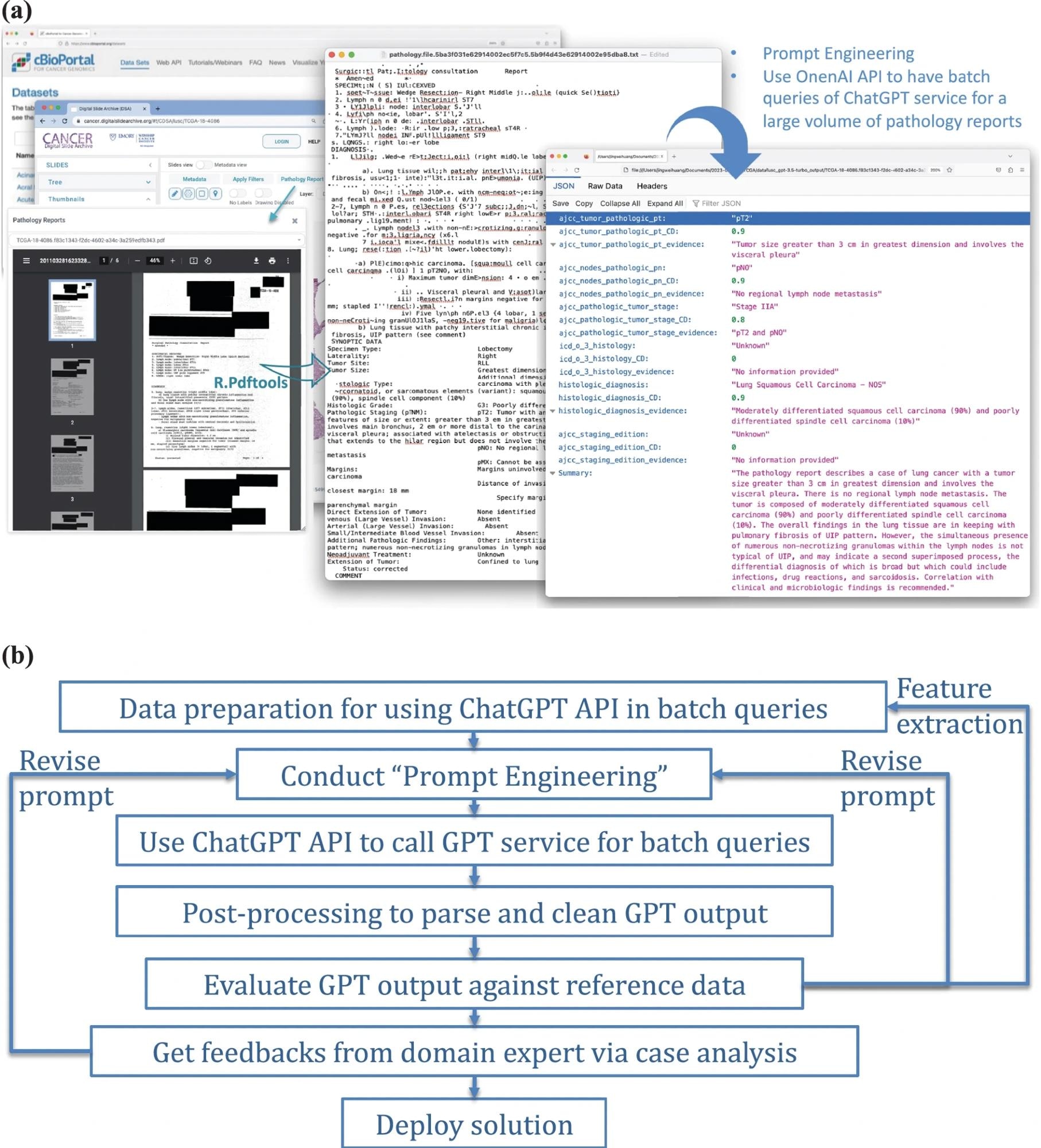

Ein Überblick über den Prozess und die Rahmenbedingungen der Verwendung von ChatGPT zur strukturierten Datenextraktion aus Pathologieberichten. a Veranschaulichung der Verwendung der OpenAI-API für Batch-Abfragen des ChatGPT-Dienstes, angewendet auf eine beträchtliche Menge klinischer Notizen – Pathologieberichte in unserer Studie. b Ein allgemeiner Rahmen für die Integration von ChatGPT in reale Anwendungen.

Insgesamt wurden 1.026 Lungentumor-Pathologieberichte und 191 pädiatrische Osteosarkomberichte aus dem Cancer Digital Slide Archive (CDSA), das als Trainingssatz diente, sowie dem Cancer Genome Atlas (TCGA), der als Testsatz diente, transformiert mit dem R-Programm Text schreiben. Anschließend wurden Textdaten mithilfe der OpenAI-API analysiert, die strukturierte Daten basierend auf bestimmten Eingabeaufforderungen extrahierte.

Die ChatGPT-API wurde verwendet, um Batch-Abfragen durchzuführen, gefolgt von einer Aufforderung zum Aufrufen des GPT-Dienstes. Die Nachbearbeitung umfasste das Parsen und Bereinigen der GPT-Ausgabe, die Bewertung der GPT-Ergebnisse anhand von Referenzdaten und das Einholen von Feedback von Fachexperten. Diese Prozesse zielten darauf ab, Informationen über das TNM-Stadium und den Histologietyp als strukturierte Attribute aus unstrukturierten Pathologieberichten zu extrahieren. Zu den ChatGPT zugewiesenen Aufgaben gehörten die Schätzung der Zielattribute, die Bewertung des Sicherheitsniveaus, die Identifizierung wichtiger Beweise und die Erstellung einer Zusammenfassung.

Von den 99 aus der CDSA-Datenbank erfassten Berichten wurden 21 aufgrund schlechter Scanqualität, nahezu leerem Dateninhalt oder fehlender Berichte ausgeschlossen. Dies führte zu insgesamt 78 echten Pathologieberichten, die zum Trainieren der Eingabeaufforderungen verwendet wurden. Zur Beurteilung der Modellleistung wurden 1.024 Pathologieberichte von cBioPortal eingeholt, von denen 97 aufgrund von Überschneidungen mit Trainingsdaten eliminiert wurden.

ChatGPT wurde angewiesen, die siebte Ausgabe des Cancer Staging Manual des American Joint Committee on Cancer (AJCC) als Referenz zu verwenden. Zu den analysierten Daten gehörten das Staging des Primärtumors (pT) und der Lymphknoten (pN), der histologische Typ und das Tumorstadium. Die Leistung von ChatGPT wurde mit der eines Schlüsselwortsuchalgorithmus und eines Deep-Learning-basierten Named Entity Recognition (NER)-Ansatzes verglichen.

Eine detaillierte Fehleranalyse wurde durchgeführt, um die Arten und möglichen Gründe für Fehlklassifizierungen zu identifizieren. Die Leistung der GPT-Version 3.50-Turbos und GPT-4 wurde ebenfalls verglichen.

Studienergebnisse

ChatGPT Version 3.50 erreichte eine Genauigkeit von 89 % bei der Extraktion pathologischer Klassifizierungen aus dem Lungentumor-Datensatz und übertraf damit den Schlüsselwortalgorithmus und NER Classified, die Genauigkeiten von 0,9, 0,5 bzw. 0,8 hatten. ChatGPT klassifizierte auch die Grade und den Randstatus in Osteosarkomberichten genau, mit einer Genauigkeitsrate von 98,6 %.

Die Modellleistung wurde durch das instruktive Eingabeaufforderungsdesign beeinträchtigt, wobei die meisten Fehlklassifizierungen auf das Fehlen spezifischer pathologischer Terminologien und falsche Interpretationen der TNM-Einstufungsrichtlinien zurückzuführen waren. ChatGPT extrahierte die Tumorinformationen genau und nutzte die Stadieneinteilungsrichtlinien des AJCC, um das Tumorstadium abzuschätzen. Allerdings wurden häufig falsche Regeln zur Unterscheidung von pT-Kategorien verwendet, beispielsweise wurde eine maximale Tumorgröße von zwei Zentimetern als T2 interpretiert.

Im Osteosarkom-Datensatz klassifizierte ChatGPT Version 3.50 den Randstatus und die Grade präzise mit einer Genauigkeit von 100 % bzw. 98,6 %. ChatGPT-3.50 zeigte im Laufe der Zeit auch in pädiatrischen Osteosarkom-Datensätzen eine konsistente Leistung; Allerdings wurden pT, pN, histologischer Typ und Tumorstadium häufig falsch klassifiziert.

Die Leistung der Klassifizierung des Tumorstadiums wurde anhand von 744 Fällen mit genauen Berichten und Referenzdaten bewertet, von denen 22 auf Fehlerfortpflanzung und 34 auf fehlerhafte Vorschriften zurückzuführen waren. Die Bewertung der Klassifizierungsleistung der histologischen Diagnose anhand von 762 Fällen ergab, dass 17 Fälle unbekannt waren oder keine Ergebnisse lieferten, was zu einer Abdeckungsrate von 0,96 führte.

Bei der ersten Modellevaluierung und der Prompt-Response-Überprüfung wurden ungewöhnliche Vorfälle festgestellt, etwa leere, nicht ordnungsgemäß gescannte oder fehlende Berichtsformulare, die ChatGPT in den meisten Fällen nicht erkennen konnte. Der GPT-4-Turbo übertraf das Vorgängermodell in fast jeder Kategorie und verbesserte dadurch die Leistung dieses Modells um über 5 %.

Schlussfolgerungen

ChatGPT scheint in der Lage zu sein, riesige Mengen klinischer Notizen zu verarbeiten, um strukturierte Daten zu extrahieren, ohne dass umfangreiche aufgabenbasierte menschliche Anmerkungen oder Modelldatenschulungen erforderlich sind. Zusammengenommen unterstreichen die Studienergebnisse das Potenzial von LLMs, unstrukturierte Gesundheitsinformationen in organisierte Darstellungen umzuwandeln, was letztlich die Forschung und klinische Entscheidungen in der Zukunft erleichtern kann.

Zeitschriftenreferenz:

- Huang, J., Yang, D.M., Rong, R., et al. (2024). Eine kritische Bewertung der Verwendung von ChatGPT zum Extrahieren strukturierter Daten aus klinischen Notizen. npj Digitale Medizin 7(106). doi:10.1038/s41746-024-01079-8