Wir leben bereits in einer Welt, in der virtuelle Assistenten problemlos (und sogar kokett) mit Menschen kommunizieren können. Doch Apples virtueller Assistent Siri hat mit einigen grundlegenden Dingen zu kämpfen.

Ich fragte Siri beispielsweise, wann die Olympischen Spiele dieses Jahr stattfinden, und sie spuckte mir schnell die korrekten Daten für die Sommerspiele aus. Als ich dann fragte: „Füge es meinem Kalender hinzu“, antwortete der virtuelle Assistent unvollkommen: „Wie soll ich es nennen?“ Die Antwort auf diese Frage wäre für uns Menschen offensichtlich. Apples virtueller Assistent war jedoch ratlos. Selbst als ich antwortete: „Olympische Spiele“, antwortete Siri: „Für wann soll ich es einplanen?“

Siri neigt dazu, zu schwächeln, da es ihm an Kontextbewusstsein mangelt, was seine Fähigkeit einschränkt, einem Gespräch wie ein Mensch zu folgen. Das könnte sich bereits am 10. Juni ändern, dem ersten Tag von Apples jährlicher Worldwide Developers Conference (WWDC). Der iphone-Hersteller wird voraussichtlich wichtige Updates für sein kommendes mobiles Betriebssystem vorstellen, das wahrscheinlich iOS 18 heißen wird und bei dem angeblich erhebliche Änderungen für Siri anstehen.

Apples virtueller Assistent sorgte für Aufsehen, als er 2011 mit dem iPhone 4S debütierte. Zum ersten Mal konnten Menschen mit ihren Telefonen sprechen und eine menschliche Antwort erhalten. Einige Android-Telefone boten vor Siri grundlegende Sprachsuche und Sprachaktionen, diese waren jedoch eher befehlsbasiert und wurden allgemein als weniger intuitiv angesehen.

Siri stellte einen großen Fortschritt in der sprachbasierten Interaktion dar und legte den Grundstein für nachfolgende Sprachassistenten wie Alexa von Amazon, den Assistant von google und sogar die Chatbots chatgpt von OpenAI und Gemini von Google.

Mach Platz, Siri, die multimodalen Assistenten sind da

Obwohl Siri die Menschen 2011 mit seiner sprachbasierten Erfahrung beeindruckte, sind seine Fähigkeiten von einigen gesehen als hinter denen seiner Konkurrenten zurückgeblieben. Alexa und Google Assistant sind gut darin, Fragen zu verstehen und zu beantworten, und beide haben sich auf andere Weise als Siri in Smart Homes durchgesetzt. Es scheint nur, dass Siri sein volles Potenzial nicht ausgeschöpft hat – obwohl seine Konkurrenten ähnliche Kritik einstecken mussten.

Im Jahr 2024 wird Siri zudem mit einem völlig anderen Wettbewerbsumfeld konfrontiert sein, das durch generative KI noch verstärkt wird. In den letzten Wochen haben OpenAI, Google und Microsoft eine neue Welle futuristischer virtueller Assistenten mit multimodalen Fähigkeiten vorgestellt, die eine Konkurrenz für Siri darstellen. Laut NYU-Professor Scott Galloway auf einer apple.com/us/podcast/the-prof-g-pod-with-scott-galloway/id1498802610″ target=“_blank“ rel=“noopener nofollow“ class=“c-regularLink“>aktuelle Folge seines Podcastsdiese jüngsten Updates haben das Zeug dazu, die „Alexa- und Siri-Killer“ zu werden.

Scarlett Johannson und Joquin Phoenix besuchten 2013 die Premiere von „Her“ bei einem Filmfestival. Im Jahr 2024 beschuldigt Johannson OpenAI, ihre Stimme ohne ihre Erlaubnis für seinen Chatbot repliziert zu haben.

Anfang des Monats stellte OpenAI sein neuestes KI-Modell vor. Die Ankündigung unterstrich, wie weit virtuelle Assistenten gekommen sind. In seiner Demo in San Francisco zeigte OpenAI, wie GPT-4o Zwei-Wege-Gespräche auf noch menschlichere Weise führen kann, einschließlich der Fähigkeit, den Tonfall zu verändern, sarkastische Bemerkungen zu machen, flüsternd zu sprechen und sogar zu flirten. Die vorgeführte Technologie zog schnell Vergleiche mit Scarlett Johanssons Charakter in der 2013 Hollywood-Drama „Her“in dem sich ein einsamer Schriftsteller in seine weiblich klingende virtuelle Assistentin verliebt, deren Stimme von Johansson stammt. Nach der Demo von GPT-4o beschuldigte die amerikanische Schauspielerin OpenAI, ohne ihre Erlaubnis eine Stimme für die virtuelle Assistentin geschaffen zu haben, die ihrer eigenen „unheimlich ähnlich“ klang. Open AI sagte, die Stimme sei nie so gemeint gewesen, dass sie Johanssons Stimme ähneln sollte.

Die Kontroverse hat anscheinend einige Funktionen von GPT-4o in den Schatten gestellt, wie etwa seine nativen multimodalen Fähigkeiten, was bedeutet, dass das KI-Modell Eingaben jenseits von Text verstehen und darauf reagieren kann, darunter Bilder, gesprochene Sprache und sogar Videos. In der Praxis kann GPT-4o mit Ihnen über ein Foto chatten, das Sie zeigen (indem Sie Medien hochladen), beschreiben, was in einem Videoclip passiert, und einen Nachrichtenartikel diskutieren.

Mehr lesen: Scarlett Johansson „verärgert“ über OpenAIs Chatbot, der „ihre“ Stimme nachahmt

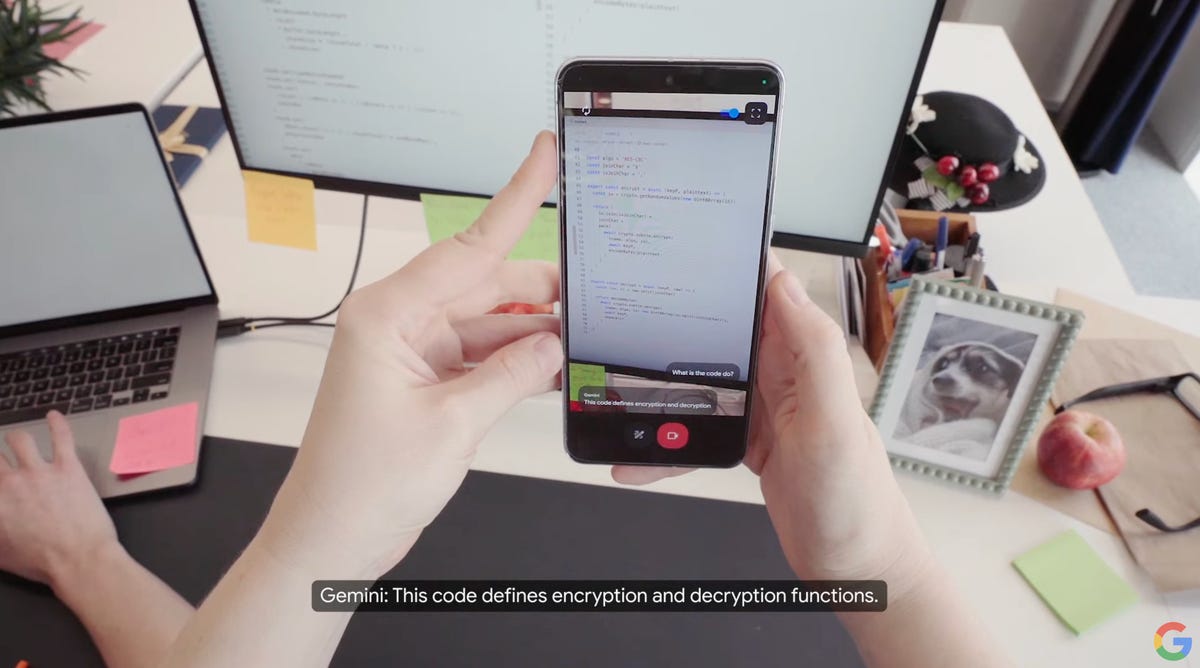

Einen Tag nach der Vorschau von OpenAI zeigte Google seine eigene multimodale Demo und enthüllte Project Astra – einen Prototyp, den das Unternehmen als „die Zukunft der KI-Assistenten“ bezeichnet hat. In einem Demo-Video erläuterte Google detailliert, wie Benutzer dem virtuellen Assistenten von Google mithilfe der Kamera ihres Smartphones ihre Umgebung zeigen und dann über Objekte in ihrer Umgebung sprechen können. Beispielsweise bat die Person, die mit Astra in dem vermutlichen Londoner Büro von Google interagierte, den virtuellen Assistenten von Google, ein Objekt zu identifizieren, das im Raum ein Geräusch erzeugt. Als Antwort zeigte Astra auf den Sprecher, der auf einem Schreibtisch saß.

Google hat Astra auf einem Telefon und auch auf einer Brille mit Kamera vorgeführt.

Googles Astra-Prototyp kann nicht nur seine Umgebung wahrnehmen, sondern sich auch Details merken. Als der Erzähler fragte, wo sie ihre Brille hingelegt hätten, konnte Astra sagen, wo sie zuletzt gesehen worden waren, und antwortete: „Auf der Ecke des Schreibtischs neben einem roten Apfel.“

Das Rennen um die Entwicklung spektakulärer virtueller Assistenten endet nicht bei OpenAI und Google. Elon Musks KI-Unternehmen xAI macht Fortschritte bei der Umwandlung seines Grok-Chatbots in einen Chatbot mit multimodalen Fähigkeiten, so öffentliche EntwicklerdokumenteIm Mai gab Amazon bekannt, dass es daran arbeite, Alexa, seinem Jahrzehnte alten virtuellen Assistenten, ein generatives KI-Upgrade zu verpassen.

Wird Siri multimodal?

Multimodale Konversations-Chatbots stellen derzeit den neuesten Stand der KI-Assistenten dar und bieten möglicherweise einen Einblick in die Zukunft der Bedienung unserer Telefone und anderer Geräte.

Apple hat noch keinen digitalen Assistenten mit multimodalen Fähigkeiten und ist damit im Rückstand. Der iPhone-Hersteller hat jedoch eine Studie zu diesem Thema veröffentlicht. Im Oktober diskutierte er Frettchenein multimodales KI-Modell, das verstehen kann, was auf Ihrem Telefonbildschirm passiert, und basierend auf dem, was es sieht, eine Reihe von Aufgaben ausführen kann. In der Papieruntersuchen Forscher, wie Ferret unter anderem erkennen und melden kann, was Sie sich ansehen, und Ihnen beim Navigieren in Apps helfen kann. Die Forschung deutet auf eine mögliche Zukunft hin, in der sich die Art und Weise, wie wir unsere iPhones und andere Geräte nutzen, völlig ändert.

Apple erkundet die Funktionalität eines multimodalen KI-Assistenten namens Ferret. In diesem Beispiel wird gezeigt, wie der Assistent einem Benutzer beim Navigieren in einer App hilft, wobei Ferret sowohl grundlegende als auch fortgeschrittene Aufgaben übernimmt, wie etwa die detaillierte Beschreibung eines Bildschirms.

Wo Apple sich hervortun könnte, ist in Sachen Datenschutz. Der iPhone-Hersteller hat Datenschutz schon lange als zentralen Wert bei der Entwicklung von Produkten und Dienstleistungen betrachtet und wird die neue Version von Siri als eine privatere Alternative zu seinen Konkurrenten anpreisen. entsprechend Die New York Times. Apple soll dieses Datenschutzziel erreichen, indem es Siris Anfragen auf dem Gerät verarbeitet und für komplexere Aufgaben auf die Cloud zurückgreift, diese werden jedoch in Rechenzentren mit von Apple hergestellten Chips verarbeitet, so ein Bericht des Wall Street Journal. Bericht.

Was einen Chatbot betrifft, steht Apple kurz vor dem Abschluss eines Vertrags mit OpenAI, um ChatGPT möglicherweise auf das iPhone zu bringen. entsprechend Bloomberg, ein möglicher Hinweis darauf, dass Siri nicht direkt mit ChatGPT oder Gemini konkurrieren wird. Anstatt Dinge wie das Schreiben von Gedichten zu tun, wird sich Siri auf Aufgaben konzentrieren, die es bereits erledigen kann, und darin besser werden. entsprechend Die New York Times.

Im Rahmen einer Demo auf der WWDC 2012 bat Scott Forstall, Senior Vice President für iOS-Software bei Apple, Siri, den Schlagdurchschnitt eines Baseballspielers nachzuschlagen.

Wie wird sich Siri verändern? Alle Augen sind auf Apples WWDC gerichtet

Traditionell hat Apple bei der Markteinführung absichtlich langsam vorgegangen und bei neuen Technologien lieber eine abwartende Haltung eingenommen. Diese Strategie hat oft funktioniert, aber nicht immer. Beispielsweise war das iPad nicht das erste Tablet, aber für viele, darunter auch CNET-Redakteure, ist es das beste Tablet. Andererseits kam Apples intelligenter Lautsprecher HomePod mehrere Jahre nach dem Amazon Echo und Google Home auf den Markt, konnte aber nie den Marktanteil seiner Konkurrenten erreichen. Ein aktuelleres Beispiel auf der Hardwareseite sind faltbare Telefone. Apple ist der einzige große Verweigerer. Jeder große Konkurrent – Google, Samsung, Honor, Huawei und sogar weniger bekannte Unternehmen wie Phantom – ist Apple zuvorgekommen.

Historisch gesehen hat Apple den Ansatz verfolgt, Siri in Intervallen zu aktualisieren, sagt Avi Greengart, leitender Analyst bei Techsponential.

„Apple war bei Siri schon immer programmatischer als Amazon, Google oder sogar Samsung“, sagte Greengart. „Apple scheint Siri in Scharen mit Wissen zu versorgen – in einem Jahr Sport, im nächsten Unterhaltung.“

Mit Siri wird Apple dieses Jahr voraussichtlich eher aufholen als neue Wege beschreiten. Dennoch wird Siri wahrscheinlich ein Hauptschwerpunkt von Apples kommendem Betriebssystem iOS 18 sein, das Gerüchten zufolge neue KI-Funktionen bringen soll. Es wird erwartet, dass Apple weitere KI-Integrationen in bestehende Apps und Funktionen wie Notizen, Emojis, Fotobearbeitung, Nachrichten und E-Mails vorführt. laut Bloomberg.

Siri kann auf der Series 9 und Ultra 2 gesundheitsbezogene Fragen beantworten.

Siri soll sich in diesem Jahr zu einem intelligenteren digitalen Helfer entwickeln. Apple trainiert seinen Sprachassistenten angeblich anhand großer Sprachmodelle, um seine Fähigkeit zu verbessern, Fragen präziser und ausgefeilter zu beantworten, heißt es in der Oktoberausgabe von Mark Gurmans Bloomberg-Newsletter PowerOn.

Die Integration großer Sprachmodelle sowie die Technologie hinter ChatGPT werden Siri in einen kontextbewussteren und leistungsfähigeren virtuellen Assistenten verwandeln. Siri könnte dadurch komplexere und differenziertere Fragen verstehen, aber auch präzise Antworten geben. Die diesjährige iPhone 16-Reihe wird voraussichtlich auch mit mehr Speicher ausgestattet sein, um neue Siri-Funktionen zu unterstützen, so die New York Times.

Mehr lesen: Was ist ein LLM und welche Verbindung besteht zwischen ihm und KI-Chatbots?

„Meine Hoffnung ist, dass Apple generative KI nutzen kann, um Siri die Fähigkeit zu geben, sich mehr wie ein aufmerksamer Assistent anzufühlen, der versteht, was Sie zu fragen versuchen, aber datenbasierte Systeme für datengebundene Antworten verwendet“, sagte Greengart gegenüber CNET.

Siri könnte auch bei der Ausführung mehrstufiger Aufgaben besser werden. Ein September Bericht des Information detailliert beschrieben, wie Siri auf einfache Sprachbefehle für komplexere Aufgaben reagieren könnte, wie etwa das Umwandeln einer Reihe von Fotos in ein GIF und das anschließende Senden an einen Ihrer Kontakte. Das wäre ein bedeutender Fortschritt in Siris Fähigkeiten.

„Apple definiert auch, wie iPhone-Apps funktionieren, und hat daher die Möglichkeit, Siri mit der Erlaubnis des Entwicklers anwendungsübergreifend zu verwenden. Dies eröffnet möglicherweise neue Möglichkeiten für eine intelligentere Siri, Aufgaben sicher in Ihrem Namen zu erledigen“, sagte Greengart.

Schau dir das an: Apples KI auf der WWDC wird eine andere Wendung nehmen

17 versteckte iOS 17-Funktionen, die Sie unbedingt kennen sollten

Alle Fotos der Kategorie anzeigen

Anmerkung der Redaktion: CNET hat mithilfe einer KI-Engine mehrere Dutzend Artikel erstellt, die entsprechend gekennzeichnet sind. Die Anmerkung, die Sie gerade lesen, ist Artikeln beigefügt, die sich inhaltlich mit dem Thema KI befassen, aber vollständig von unseren erfahrenen Redakteuren und Autoren erstellt wurden. Weitere Informationen finden Sie in unserem KI-Politik.