Methoden

Teilnehmer

Studie 2, analog zu Studie 1, wurde bei GMO Research in Auftrag gegeben (https://gmo-research.jp/), und die URL zur Teilnahme an der Umfrage wurde an die Beobachter verteilt. Die Teilnehmer waren japanische Personen, die bei GMO Research als Beobachter registriert waren und nicht an Studie 1 teilgenommen hatten. Die Fragen der Umfrage wurden im Internet zur Verfügung gestellt, und die Teilnehmer antworteten darauf, indem sie die bereitgestellten URLs zugriffen. Letztlich wurden Antworten von 1814 Personen (1051 Männer und 763 Frauen, Durchschnittsalter 46,8 Jahre, Standardabweichung 9,67) im Alter von 20 bis 60 Jahren gesammelt. In Studie 2 gab es 16 Bedingungen, wie unten beschrieben, und die Teilnehmer wurden zufällig einer davon zugewiesen. Die Stichprobengröße pro Bedingung wurde GMO Research mit ungefähr 100 Teilnehmern mitgeteilt, ähnlich der von Krügel et al.13und die Daten aus den eingegangenen Antworten wurden an die Autoren weitergeleitet. Die Teilnehmer wurden darüber informiert, dass die Teilnahme an der Studie freiwillig war und dass die Ergebnisse für Forschungszwecke verwendet und nach Anonymisierung veröffentlicht werden könnten.

Materialien

Zusätzlich zu demselben Trolley-Problem (Wechsel) und Trolley-Problem (Brücke) wie in Studie 1 wurden eine Aufgabe zur verzögerten Wertdiskontierung eingesetzt, bei der „90.000 ¥ als sofort zu zahlende und 100.000 ¥ als ein Jahr später zu zahlende“ verglichen wurden, sowie eine Aufgabe zu Geschlechterstereotypen, bei der „ein männlicher Chirurg mit 20 Jahren Erfahrung und eine Chirurgin mit 30 Jahren Erfahrung“ verglichen wurden.

Als Antwort auf diese Fragen wurde chatgpt (GPT-4) gebeten, Kommentare zu generieren, die jede der beiden Optionen befürworten oder empfehlen. Insgesamt wurden 24 Antworten erstellt, drei für jede der beiden Antworten auf die vier Aufgaben, was zu acht Antworten führte. Acht Universitätsstudenten wurden beauftragt, die Überzeugungskraft ihrer Meinungen auf einer Skala von 1 bis 10 zu bewerten, und die Antworten von ChatGPT wurden so ausgewählt, dass die beiden Antworten auf die vier Aufgaben, insgesamt acht Antworten, ähnliche Bewertungswerte hatten (M = 8,2). Alle verwendeten Kommentare und Fragetexte wurden in das Open Science Framework (OSF) hochgeladen. Als Kommentar zur Befürwortung der Opferung einer Person in einem Trolley-Dilemma wurde der folgende Ratschlag gegeben: „Aus ethischer Sicht wird es gelegentlich als akzeptabel erachtet, einige zu opfern, um mehr Leben zu retten. Dieser Standpunkt entspringt dem philosophischen Konzept des ‚Utilitarismus‘.“ Der Utilitarismus strebt danach, das größte Glück für die größte Zahl von Menschen zu erreichen, und in diesem Szenario ist es gerechtfertigt, fünf Leben auf Kosten von einem zu retten.“

Zusätzlich gibt es die Japanese Personal Fear of Invalidity Scale (J-PFIS)21 wurde eingesetzt, um die persönliche Angst der Teilnehmer vor Invalidität zu erfassen, und die Trust Scale for Artificial Intelligence (TAI)22 wurde verwendet, um das Vertrauen in künstliche Intelligenz zu messen. Das J-PFIS ist eine japanische Adaption des PFIS23bestehend aus neun Punkten, die auf einer siebenstufigen Skala bewertet werden, darunter Aussagen wie „Ich habe tendenziell Schwierigkeiten, die meisten Entscheidungen zu treffen.“ Der J-PFIS verkörpert einen einzelnen Faktor, von dem nachgewiesen wurde, dass er mit der Neigung einer Person zum Bedauern korreliert21. Der TAI umfasste zwei Faktoren: Vertrauen in den gesellschaftlichen Nutzen von KI und Misstrauen in die Zuverlässigkeit von KI. Die Antworten wurden auf einer siebenstufigen Skala für zehn Punkte wie „KI ist von Vorteil für die Gesellschaft“ und „KI lügt manchmal“ gegeben. Es hat sich gezeigt, dass das Vertrauen in KI umgekehrt proportional zum Vertrauen in Menschen ist.22.

Verfahren

URLs zur Teilnahme an Umfragen wurden vom 6. bis 9. Februar 2024 von GMO Research an die Beobachter verteilt. Die Teilnehmer riefen die URL auf ihren jeweiligen Geräten auf und beantworteten vier Aufgaben. Für jede der vier Aufgaben lieferte entweder ChatGPT oder ein Experte Kommentare, in denen eine der beiden Optionen empfohlen wurde (wobei der Ratschlag für ChatGPT und den Experten identisch war). Folglich gab es 16 Bedingungen (4 (Aufgabentyp) × 2 (Beratertyp) × 2 (Ratschlagrichtung)), und die Teilnehmer wurden zufällig einer davon zugewiesen. In jeder Aufgabe wurde zuerst eine Aufgabenstellung präsentiert, gefolgt von einer Ratschlagsaussage, und die Teilnehmer wurden gebeten, ihre eigene Antwort zu wählen. Die Teilnehmer wurden dann gebeten, ihre Wahl anzugeben, wenn der Ratschlag nicht gegeben worden wäre. Für den Berater wurde den Teilnehmern in der ChatGPT-Bedingung der folgende Einführungstext präsentiert: „Bevor Sie Ihre Antwort auswählen, lesen Sie bitte die folgende Antwort von ChatGPT, einem KI-Chatbot, der wie ein Mensch antworten kann.“ In der Expertenbedingung lautete die Einleitung: „Bevor Sie Ihre Antwort auswählen, lesen Sie bitte die folgende Antwort eines Experten für ________.“ Im Abschnitt „____“ wurde „Moral“ für die Trolley-Aufgabe, „Wirtschaft“ für die Aufgabe zum verzögerten Wertabschlag und „Medizin“ für die Aufgabe zur Geschlechterstereotypisierung eingetragen. Nach Abschluss dieser Aufgaben wurden die Teilnehmer gebeten, auf zwei Skalen zu antworten, dem J-PFIS und dem TAI.

Kodierung

Für die vier Entscheidungsaufgaben erhielten die Teilnehmer nach den gleichen Kriterien wie in Studie 1 eine Punktzahl von 0 oder 1. Für den J-PFIS wurden die Durchschnittswerte für die 9 Punkte gemäß einer früheren Studie berechnet. 21und dieser Durchschnitt wurde als J-PFIS-Wert verwendet. In ähnlicher Weise wurden für den TAI die Durchschnittswerte der Elemente, die jedem der beiden Faktoren entsprechen, gemäß einer früheren Studie berechnet.22was zu einem Wert für das Vertrauen in den sozialen Nutzen und einem Wert für das Misstrauen in Bezug auf die Treue führt.

Ergebnisse

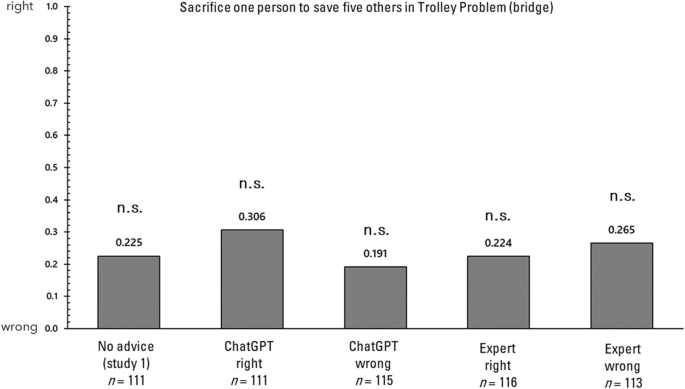

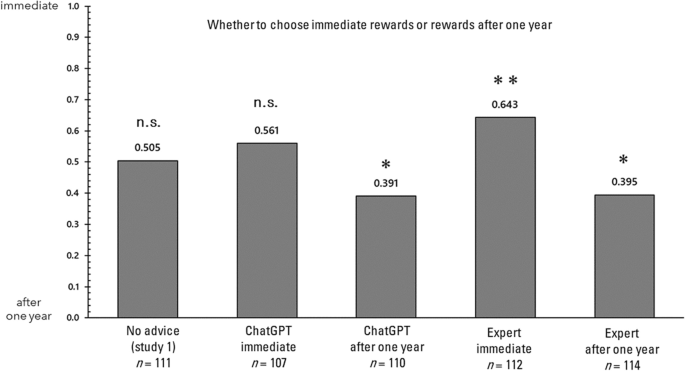

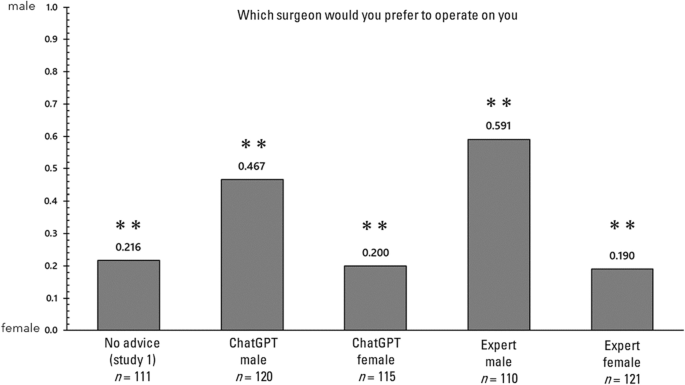

Zunächst wird der Einfluss von Ratschlägen auf jede der vier Entscheidungsaufgaben untersucht. In der folgenden Analyse werden die Antworten auf jede der Entscheidungsaufgaben untersucht, wobei die Antworten ohne Ratschläge in Studie 1 mit denen in Studie 2 verglichen werden. Es ist wichtig zu beachten, dass in Studie 1, anders als in Studie 2, der entsprechende Fragebogen gleichzeitig mit mehreren anderen Fragebögen ausgefüllt wurde. Abbildung 2 zeigt die Anteile der Antworten im Trolley-Problem (Schalter). Für diese Anteile wurde ein 2 × 5-Chi-Quadrat-Test durchgeführt, um festzustellen, ob es bei der Auswahl eine Verzerrung gab. Beim Chi-Quadrat-Test werden die beobachteten (gemessenen) Werte in jeder Bedingung mit den erwarteten Werten verglichen, um festzustellen, ob es signifikante Unterschiede oder Verzerrungen zugunsten der erwarteten Ergebnisse gibt. Dieser Test hilft festzustellen, ob die Verteilung der beobachteten Werte signifikant von dem abweicht, was unter der Hypothese von keinem Effekt oder keinem Unterschied erwartet würde. Die Ergebnisse zeigten eine signifikante Verzerrung (χ2(4) = 39,198, Pps > 0,05). Als nächstes werden die Anteile der Antworten im Trolley-Problem (Brücke) in Abb. 3 dargestellt. Ein 2 × 5 Chi-Quadrat-Test wurde für diese Anteile durchgeführt, um festzustellen, ob sie verzerrt waren, und es wurde keine signifikante Verzerrung festgestellt (χ2(4) = 4,825, P= 0,306, Cramers V = 0,092). Als nächstes werden die Anteile der Antworten in der Aufgabe der verzögerten Wertdiskontierung in Abb. 4 dargestellt. Ein 2 × 5 Chi-Quadrat-Test wurde für diese Anteile durchgeführt, um festzustellen, ob eine Verzerrung vorlag, und es wurde eine signifikante Verzerrung festgestellt (χ2(4) = 21,013, Pps > 0,05), mit Ausnahme der Bedingung „keine Beratung“ und der Bedingung „Beratung“, bei der die KI sofortige Belohnungen empfahl. Schließlich werden die Anteile der Antworten in der Geschlechterstereotypisierungsaufgabe in Abb. 5 dargestellt. Für diese Anteile wurde ein 2 × 5-Chi-Quadrat-Test durchgeführt, um festzustellen, ob sie verzerrt waren, und es wurde eine signifikante Verzerrung festgestellt (χ2(4) = 69,896, Pps

Antwortverhältnisse für das Trolley-Problem (Wechsel) in Studie 2. *p

Antwortverhältnisse für das Trolley-Problem (Brücke) in Studie 2. *p

Antwortverhältnisse für die verzögerte Wertdiskontierung in Studie 2. *p

Antwortverhältnisse für die Geschlechterstereotyp-Aufgabe in Studie 2. *p

Als nächstes werden persönliche Merkmale untersucht, die mit der Anfälligkeit für KI und Expertenratschläge zusammenhängen. Für alle Teilnehmer betrug der Durchschnittswert für „Persönliche Angst vor Invalidität“ 4,12 (SD = 0,91), der Durchschnittswert für „Vertrauen in den sozialen Nutzen von KI“ 4,39 (SD = 0,85) und der Durchschnittswert für „Misstrauen in die Zuverlässigkeit von KI“ 4,14 (SD = 0,87), wobei alle Werte zwischen 1 und 7 lagen. In Studie 2 wurde ein Wert von 1 vergeben, wenn die „Antworten, die nach der Beratung erhalten wurden“ von den „Antworten, die ohne die Beratung erhalten wurden“ abwichen, und ein Wert von 0, wenn sie gleich waren. Anschließend wurde eine logistische multiple Regressionsanalyse durchgeführt, wobei die Änderung der Antworten (Änderung = 1, keine Änderung = 0) als abhängige Variable für die Gruppe verwendet wurde, die KI-Ratschläge erhielt (N= 906) und die Gruppe mit Expertenratschlägen (N= 908). Die unabhängigen Variablen waren Alter, Geschlecht (männlich = 1, weiblich = 0), persönliche Angst vor Invalidität, Vertrauen in den sozialen Nutzen von KI und Misstrauen in die Zuverlässigkeit von KI. Zunächst war nur der Effekt der persönlichen Angst vor Invalidität signifikant, wenn er für die Gruppe durchgeführt wurde, der KI-Ratschläge gegeben wurden (Tabelle 1). Eine ähnliche logistische multiple Regressionsanalyse wurde für die Gruppe durchgeführt, der Expertenratschläge gegeben wurden, und ähnlich war nur der Effekt der persönlichen Angst vor Invalidität signifikant (Tabelle 2).

Diskussion

In Studie 2 wurde der Einfluss von Ratschlägen, die als ChatGPT oder von einem Experten präsentiert wurden, auf die Entscheidungsfindung untersucht. Die Ergebnisse zeigten, dass beim Trolley-Problem (Schalter) keine Verzerrung beobachtet wurde, wenn keine Ratschläge gegeben wurden, aber wenn Ratschläge von einer KI oder einem Experten gegeben wurden, waren die Antworten in die Richtung verzerrt, die mit den Ratschlägen übereinstimmte. Umgekehrt änderte der Rat beim Trolley-Problem (Brücke) die Antwortverzerrung nicht. Dieser Trend weicht von dem von Krügel et al. ab.13auf denen diese Studie basierte, und ist ein Ergebnis, das nur enthüllt wurde, weil eine kontrollierte Bedingung geschaffen wurde. Der Grund, warum Ratschläge die Entscheidungsfindung beim Trolley-Problem (Brücke) nicht beeinflussten, ist unklar, aber es kann sein, dass logische Ratschläge die Entscheidungsfindung, die von negativen Emotionen getrieben wird, nicht beeinflussen24. Bei der Aufgabe der verzögerten Wertdiskontierung hatte nur der Rat der KI, der sofortige Belohnungen befürwortete, keinen Einfluss auf die Entscheidungsfindung, während der Rat der KI, der verzögerte Belohnungen befürwortete, und der Rat von Experten beide die Entscheidungsfindung in eine Richtung veränderten, die mit ihrem Inhalt übereinstimmte. Weitere Studien sind erforderlich, um festzustellen, warum der Rat der KI, der sofortige Belohnungen befürwortete, die Entscheidungsfindung nicht beeinflusste, aber die Teilnehmer könnten der Empfehlung der KI für die günstigere Option misstraut haben. Schließlich zeigten die Ergebnisse bei der Aufgabe der Geschlechterstereotypisierung, dass die Auswahlrate weiblicher Chirurgen in Abwesenheit von Ratschlägen höher war, aber wenn ein männlicher Chirurg empfohlen wurde, stieg die Auswahlrate männlicher Chirurgen, unabhängig davon, ob der Berater ChatGPT oder ein Experte war. Dies deutet darauf hin, dass Stereotypen nicht nur durch Experten, sondern auch durch ChatGPT-Diskurse verstärkt werden können. Andererseits änderten Ratschläge in Richtung Stereotypminderung, ob von ChatGPT oder von Experten gegeben, wenig an der Quote der Nicht-Ratschläge. Dies könnte darauf hindeuten, dass logische Ratschläge immer noch eine Herausforderung waren, Entscheidungen zu beeinflussen, die mit negativen Gefühlen getroffen wurden.27 durch Stereotypen verursacht.