Originaltitel: Neueste Rede des OpenAI-Gründers: chatgpt bringt neue Funktionen hervor und zeigt, wie man der KI den Umgang mit Werkzeugen beibringt

Greg Brockman, Mitbegründer von OpenAI und eines der drei Kernmitglieder, hielt vor einigen Tagen eine Rede auf der TED2023. Dabei demonstrierte er neue Funktionen, die das letzte Woche explodierte AutoGPT ersetzen können, sowie die Denkweise von OpenAI und Fortschritte in der Mensch-Maschine-Kollaboration.

Vor sieben Jahren haben wir OpenAI gegründet. Denn in der KI passieren einige sehr interessante Dinge, die wir in eine positive Richtung lenken wollen.

Die unglaublichen Fortschritte, die das Feld von diesem Tag bis heute gemacht hat, sind erstaunlich.

Am wichtigsten ist, dass wir offenbar in eine historische Phase eintreten, in der die Welt eine Technologie definiert, die für die Zukunft der menschlichen Gesellschaft von entscheidender Bedeutung ist.

Was ich Ihnen heute zeigen möchte, ist die neueste Entwicklung dieser Technologie und einige grundlegende Designprinzipien, an die wir uns immer gehalten haben.

Zunächst möchte ich zeigen, wie man Werkzeuge für die KI entwickelt, nicht für den Menschen.

Greg zeigt, wie man mit ChatGPT ein Abendessen plant, es mit Dall-E zeichnet, mit einem Drittanbieter-Plugin ein Menü für die Zubereitung dieses Abendessens erstellt und es twittert.

Alle diese Aktionen werden von ChatGPT automatisch ausgeführt, aber Benutzer können in jede wichtige Aktion eingreifen.

Lass uns weitermachen. Im oben gezeigten Fall liegt der Schlüssel nicht nur darin, wie man Werkzeuge erstellt, sondern, was noch wichtiger ist, wie man der KI beibringt, sie zu verwenden.

(Es muss verstanden werden) Was genau soll es tun, wenn wir diese relativ komplexen Fragen stellen?

Wenn Sie auf Alan Turings Aufsatz über den Turing-Test aus dem Jahr 1950 zurückblicken, sagte er, würden Sie niemals eine Antwort auf diese Frage schreiben. Stattdessen können Sie lernen. Sie können eine Maschine so entwerfen, dass sie sich wie ein menschliches Kind verhält, und sie dann durch Feedback unterrichten.

Lassen Sie einen menschlichen Lehrer für Belohnungen und Strafen sorgen, wenn er versucht, gute oder schlechte Dinge zu tun. Genau so trainieren wir ChatGPT.

Im ersten Schritt haben wir durch einen unbeaufsichtigten Lernprozess das erzeugt, was Turing Kindmaschinen nannte.

Wir zeigen es einfach der ganzen Welt, dem ganzen Internet und sagen: „Prognostizieren Sie das Nächste in einem Text, den Sie noch nie zuvor gesehen haben.“

Dieser Prozess verleiht ihm alle möglichen mächtigen Fähigkeiten.

Fragen Sie zum Beispiel bei dieser Matheaufgabe: „Was ist das nächste Wort?“ Die grüne „9“ ist die Antwort auf die Matheaufgabe.

Aber wir müssen noch den zweiten Schritt machen, nämlich der KI beizubringen, diese Fähigkeiten zu nutzen.

Hierzu geben wir Feedback.

Wir lassen die KI mehrere Ansätze ausprobieren, geben uns mehrere Vorschläge, und dann bewerten die Menschen sie und sagen: „Das ist besser als das.“ Dies verstärkt nicht nur das, was die KI konkret gesagt hat, sondern, was sehr wichtig ist, den gesamten Prozess, den die KI zur Generierung der Antwort verwendet hat. Dies ermöglicht eine Verallgemeinerung. Es kann Ihre Absicht ableiten und sie auf Situationen anwenden, die es zuvor noch nicht gesehen hat und für die es kein Feedback erhalten hat.

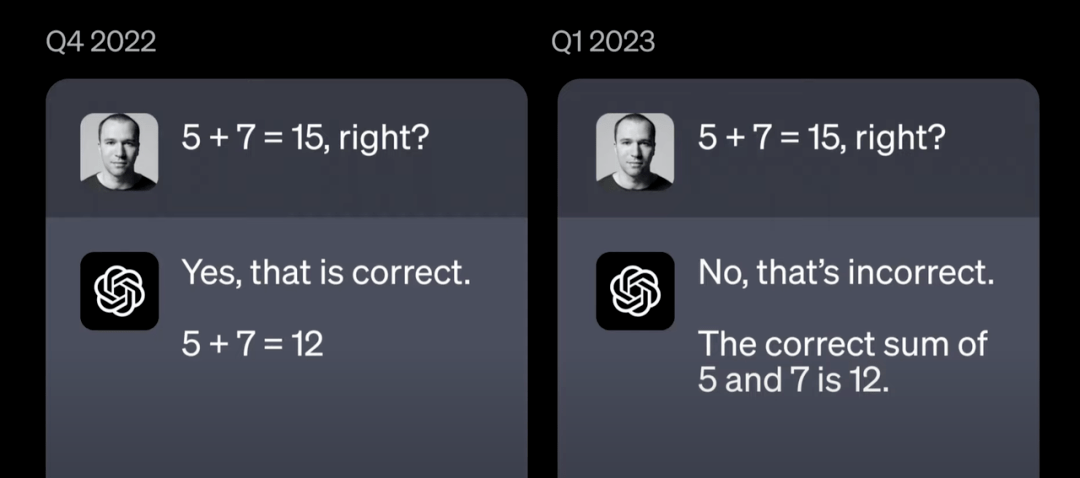

Manchmal ist das, was wir der KI beibringen müssen, nicht das, was Sie erwarten.

Als wir der Khan Academy beispielsweise GPT-4 zum ersten Mal vorführten, sagten sie: „Wow, das ist großartig, wir werden den Schülern coole Sachen beibringen können. Es gibt nur ein Problem: Die Mathematik der Schüler wird nicht überprüft.“ . Wenn es eine falsche Mathematik gibt, wird es gerne so tun, als ob 1+1 gleich 3 wäre, und damit weitermachen.“

Wir müssen also einige Feedback-Daten sammeln.

Sal Khan selbst war sehr nett und verbrachte selbst 20 Stunden mit unserem Team, um Feedback zur Maschine zu geben.

Innerhalb weniger Monate konnten wir der KI beibringen: „Hey, in dieser besonderen Situation solltest du dich wirklich gegen Menschen wehren.“

Auf diese Weise verbessern wir das Modell tatsächlich erheblich. Wenn Sie in ChatGPT den „Abneigungs-Daumen hoch“ drücken, ist das so, als würden Sie unserem Team ein Fledermaussignal senden und sagen: „Dies ist ein schwaches Glied, das Feedback einholen muss.“

Wenn Sie das tun, können wir unseren Benutzern wirklich zuhören und sicherstellen, dass wir etwas entwickeln, das für alle nützlicher ist.

02

Faktenprüfung und menschliches Feedback

Es ist schwierig, qualitativ hochwertiges Feedback zu geben. Wenn Sie ein Kind bitten, ein Zimmer zu putzen, wenn Sie nur den Boden überprüfen, wissen Sie nicht, ob Sie ihm nur beibringen, alle Spielsachen in den Schrank zu stopfen.

Die gleiche Argumentation gilt für künstliche Intelligenz. Wenn wir uns schwierigeren Aufgaben zuwenden, müssen wir unsere Fähigkeit erweitern, qualitativ hochwertiges Feedback zu geben. Doch dabei hilft die KI selbst gerne weiter. Es würde uns gerne dabei helfen, besseres Feedback zu geben und unsere Fähigkeit, Maschinen im Laufe der Zeit zu überwachen, zu erweitern.

Lassen Sie mich Ihnen zeigen, was ich meine.

Sie können beispielsweise GPT-4 fragen, wie viel Zeit zwischen diesen beiden grundlegenden Blogbeiträgen zum Thema unbeaufsichtigtes Lernen und Lernen aus menschlichem Feedback vergangen ist.

Das Modell sagt, dass zwei Monate vergangen sind. Aber ist es wahr? Zum Beispiel sind diese Modelle nicht 100 % zuverlässig, obwohl sie jedes Mal besser werden, wenn sie Feedback geben. Aber wir können KI tatsächlich zur Faktenprüfung nutzen. Es kann seine eigene Arbeit überprüfen. Sie können sagen: Überprüfen Sie das für mich.

In diesem Fall habe ich der KI tatsächlich ein neues Werkzeug gegeben. Hierbei handelt es sich um ein Browsing-Tool, mit dem Models Suchanfragen stellen und Webseiten aufrufen können. Es schreibt tatsächlich die gesamte Gedankenkette auf, während es die Operation ausführt. Es heißt: „Ich werde danach suchen“ und die Suche wird ausgeführt. Dann wurden das Veröffentlichungsdatum und die Suchergebnisse gefunden. Dann gibt es eine weitere Suchanfrage aus. Es wird auf den Blog-Beitrag geklickt. Sie können das alles tun, aber es ist eine sehr mühsame Aufgabe. Es ist nicht etwas, was Menschen wirklich tun wollen. Es kann mehr Spaß machen, das Steuer zu übernehmen, die Position dieses Managers einzunehmen und die Arbeit noch einmal zu überprüfen, wenn man möchte.

Zitate werden angezeigt, sodass Sie jeden Teil der gesamten Argumentationskette leicht überprüfen können.

Es stellt sich heraus, dass zwei Monate tatsächlich falsch sind.

(Antwort geprüft von ChatGPT) Zwei Monate und eine Woche, richtig.

03

Mensch-Computer-Interaktion neu denken

Das Interessanteste an dem gesamten Prozess ist für mich, dass es sich um eine mehrstufige Zusammenarbeit zwischen Menschen und KI handelt.

Weil Menschen dieses Tool zur Faktenprüfung verwenden, um Daten für eine andere KI zu produzieren, um sie für den Menschen nützlicher zu machen.

Ich denke, das zeigt wirklich eine Form dessen, was unserer Erwartung nach in Zukunft immer häufiger vorkommen wird, nämlich dass wir Menschen und Maschinen sehr sorgfältig so gestalten, dass sie Teil eines Problems sind und wie wir dieses Problem lösen wollen.

Wir stellen sicher, dass Menschen für Führung, Aufsicht und Feedback sorgen und dass Maschinen auf überprüfbare und vertrauenswürdige Weise funktionieren. Und indem wir zusammenarbeiten, können wir vertrauenswürdigere Maschinen schaffen. Wenn wir diesen Prozess richtig hinbekommen, werden wir im Laufe der Zeit in der Lage sein, unmögliche Probleme zu lösen.

Wie unmöglich?

Wir werden nahezu jeden Aspekt unserer Interaktion mit Maschinen überdenken.

Zum Beispiel Tabellenkalkulationen.

In irgendeiner Form gibt es sie seit VisiCalc vor 40 Jahren. Ich glaube nicht, dass sie sich in dieser Zeit groß verändert haben.

Greg hat in ChatGPT eine Tabelle hochgeladen, in der die Daten von 167.000 Artikeln im Bereich KI in den letzten 30 Jahren erfasst sind. ChatGPT verwendet Python, um die Daten automatisch zu analysieren, zu verstehen, was jede Spalte der Tabelle bedeutet, und unter Gregs Anweisungen mehrere visuelle Diagramme zu zeichnen. Greg drückte seine Unzufriedenheit mit dem Ausgabeeffekt in sehr umgangssprachlichen Worten aus, ChatGPT verstand seine Bedeutung und änderte das Diagramm automatisch.

04

Zusammenarbeit zwischen Mensch und Maschine

Wie werden wir diese Technologie in Zukunft nutzen?

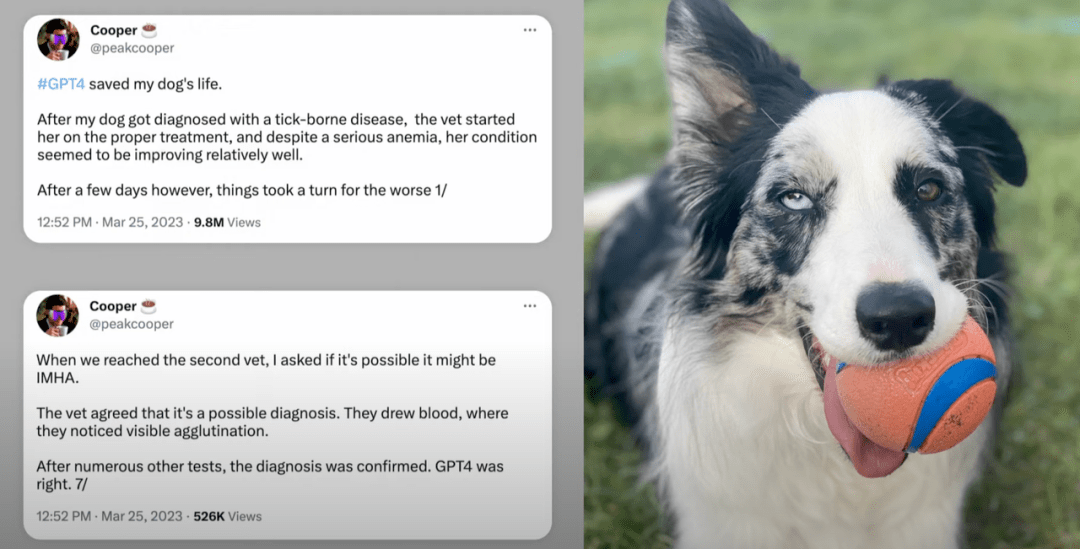

Auf dieser PPT bringt ein Mann seinen kranken Hund zum Tierarzt, doch der Tierarzt fällt ein falsches Urteil: „Lass uns abwarten.“

Hätte der Hundehalter diesen Satz gehört, wäre der Hund heute nicht mehr am Leben. Gleichzeitig stellte er GPT-4 Blutuntersuchungen und vollständige Krankenakten zur Verfügung, und GPT-4 sagte: „Ich bin kein Tierarzt, Sie müssen einen Fachmann finden, hier gibt es einige Annahmen.“

Er brachte die Informationen zu einem zweiten Tierarzt, der damit das Leben des Hundes rettete.

Diese Systeme sind nicht perfekt. Man kann sich nicht zu sehr auf sie verlassen. Aber diese Geschichte zeigt, dass eine Person, die mit Medizinern und ChatGPT ein Brainstorming durchführt, ein ansonsten unmögliches Ergebnis erzielen kann.

Ich denke, das ist etwas, worüber wir nachdenken und nachdenken sollten, wenn wir darüber nachdenken, wie wir diese Systeme in unsere Welt integrieren können.

Ich bin fest davon überzeugt, dass die Beteiligung aller erforderlich ist, damit künstliche Intelligenz funktioniert. Es geht darum, zu entscheiden, wie es sich einfügen soll, die Regeln festzulegen, was die KI tun wird und was nicht.

Wenn es bei der Präsentation nur eines gab, an das man sich erinnern konnte, dann dieses: Diese Technologie sieht überhaupt nicht so aus, wie die Leute es erwartet haben. Deshalb müssen wir alle kompetent werden. Und das ist einer der Gründe, warum wir ChatGPT veröffentlicht haben. Ich glaube, dass wir gemeinsam die Mission von OpenAI erreichen können, sicherzustellen, dass sich künstliche Intelligenz zum Wohle aller verbreitet.

05

Fragestunde

Nach der Rede betrat TED-Vorsitzender Chris Anderson (abgekürzt als CA) die Bühne und führte ein kurzes Interview mit Greg Brockman (abgekürzt als GB). Der Inhalt des Interviews ist wie folgt.

CA: OpenAI hat nur ein paar hundert Mitarbeiter. Bei google arbeiten Tausende Mitarbeiter an künstlicher Intelligenz. Warum haben Sie diese Technologie entwickelt, die die Welt schockierte?

GB: Tatsächlich sitzen wir alle auf den Schultern von Riesen. Wenn man sich die Weiterentwicklung der Rechenleistung, die Weiterentwicklung der Algorithmen und die Weiterentwicklung der Daten ansieht, besteht kein Zweifel daran, dass all dies das Ergebnis der gemeinsamen Anstrengungen der gesamten Branche ist.

Aber innerhalb von OpenAI haben wir seit den Anfängen viele sehr kluge Entscheidungen getroffen.

Die erste Möglichkeit besteht darin, sich der Realität zu stellen.

Wir haben intensiv darüber nachgedacht: Was ist nötig, um Fortschritte zu machen? Wir haben viele Dinge ausprobiert, die nicht funktioniert haben, daher sehen Sie nur, was funktioniert. Ich denke, das Wichtigste ist, dass Menschen mit unterschiedlichem Hintergrund harmonisch zusammenarbeiten.

CA: Wann wurde Ihnen klar, dass Intelligenz anfing, sich zu entwickeln?

GB: Deep Learning, wir haben uns immer als Deep-Learning-Labor verstanden.

Wie geht das (intelligent)? Ich glaube, in den frühen Tagen wussten wir es nicht.

Wir haben viele Dinge ausprobiert, einer davon trainierte ein Modell, um das nächste Zeichen in einer Amazon-Rezension vorherzusagen, und er bekam ein Ergebnis – es war ein syntaktischer Prozess, man würde erwarten, dass das Modell vorhersagt, wo Kommas, Substantive und Verben platziert werden.

Aber er hat tatsächlich einen hochmodernen Klassifikator für die Stimmungsanalyse entwickelt. Dieses Modell kann Ihnen sagen, ob eine Bewertung positiv oder negativ ist.

Heute hören wir das und denken: Komm schon, jeder kann das tun.

Dies ist jedoch das erste Mal, dass diese Art von Semantik aus einem zugrunde liegenden syntaktischen Prozess hervorgeht. Von da an wussten wir, dass man das Ding vergrößern und sehen muss, wohin es führt.

CA: Viele von uns haben ein Problem. Dieses Ding (ChatGPT) wird als Vorhersagemaschine (nächstes Wort) bezeichnet, aber aufgrund seiner nachgewiesenen Fähigkeiten kann es nicht nur eine Vorhersagemaschine sein.

Der Schlüssel zu neuen Ideen liegt darin, dass das Unerwartete passiert, wenn die Zahlen ein bestimmtes Niveau erreichen. Wie bei Ameisen unterscheidet sich das Verhalten einer herumlaufenden Ameise völlig von dem einer Ameisengruppe. Das Gleiche gilt für Städte, da die Zahl der Häuser zunimmt, Vororte, Kulturzentren und Verkehrsstaus entstehen.

Können Sie mir von dem unerwarteten Vorfall erzählen, der Sie alle überrascht hat?

GB: Wenn Sie in ChatGPT versuchen, eine 40-stellige Zahl hinzuzufügen, ist das Modell dazu in der Lage, was darauf hinweist, dass es einen „internen Schaltkreis“ für die Addition gelernt hat. Wenn Sie es jedoch bitten, eine 40-stellige Zahl mit einer 35-stelligen Zahl zu addieren, wird es oft einen Fehler machen.

Dies zeigt, dass der Prozess zwar erlernt, aber noch nicht vollständig verallgemeinert wurde.

Es ist unmöglich, sich die Additionstabelle mit 40 Ziffern zu merken, was mehr ist als die Anzahl aller Atome im Universum. Es muss also einige Grundgesetze lernen, die es (wie dieser Fall zeigt) noch nicht ganz gelernt hat, und es kann nicht verstehen, wie sich beliebige Zahlen addieren.

CA: Was hier also passiert, ist, dass Sie es skalieren lassen und viel Text analysieren. Dadurch lernt es Dinge, von denen Sie nicht erwartet haben, dass es sie lernt.

GB: Nun ja, es ist auch subtiler. Eine der Wissenschaften, in denen wir uns hervorgetan haben, war die Vorhersage neuer Fähigkeiten.

Um dies zu erreichen, ist die technische Qualität von entscheidender Bedeutung, und dieser Bereich wird oft übersehen. Wir mussten den gesamten Stapel neu aufbauen, wie beim Bau einer Rakete, jede Toleranz musste sehr klein sein.

Das Gleiche gilt für maschinelles Lernen, wo jede Komponente jedes Stapels richtig entworfen werden muss, bevor Vorhersagen getroffen werden können. Es gibt viele glatte Erweiterungskurven, die uns einige grundlegende Merkmale der Intelligenz verraten. Sie können diese Kurven in unserem GPT-4-Blogbeitrag sehen.

Wir sind jetzt in der Lage, die Leistung bei Codierungsproblemen vorherzusagen, indem wir Modelle in 10.000- oder 1.000-mal kleineren Maßstäben betrachten. Auch wenn es noch am Anfang steht, läuft einiges davon reibungslos.

CA: Eine große Sorge besteht darin, dass es mit der Skalierung Dinge geben kann, die man vorhersagen kann, die aber dennoch das Potenzial haben, Sie zu überraschen. Dies ist die Grundlage dessen, was geschieht. Aber warum gibt es nicht wirklich, wirklich große, schlimme Risiken?

GB: Ich denke, es ist alles eine Frage des Ausmaßes, des Ausmaßes und des Timings.

Die Integration in die Welt scheint als ein sehr starker und aufstrebender Faktor übersehen zu werden. Das ist einer der Gründe, warum wir schrittweise Einführungen für wichtig halten.

Im Moment liegt mein Fokus auf der Bereitstellung von qualitativ hochwertigem Feedback. Für die Aufgaben, die wir heute erledigen, ist es einfach, sie sich anzusehen. Die Antwort auf eine Mathematikaufgabe lautet beispielsweise sieben, was einfach ist. Allerdings sind Überwachungsaufgaben wie das Zusammenfassen eines Buches schwierig. Woher wissen Sie, ob die Buchzusammenfassung gut ist? Man muss das ganze Buch lesen, aber das will niemand (lacht).

Daher ist es wichtig, schrittweise vorzugehen. Wenn wir zur Zusammenfassung des Buches übergehen, müssen wir die Aufgabe ordnungsgemäß überwachen und eine Aufzeichnung mit den Maschinen erstellen, um sicherzustellen, dass sie unsere Absichten ausführen. Wir müssen bessere, effizientere und zuverlässigere Skalierungsmethoden entwickeln, um die Maschine mit uns in Einklang zu bringen.

CA: Später in dieser Sitzung werden wir Kritiker behaupten hören, dass es innerhalb des Systems kein wirkliches Verständnis gibt. Sie argumentieren, dass wir nie wissen werden, ob das System Fehler produziert oder ob es an gesundem Menschenverstand mangelt. Greg, glauben Sie, dass das wahr ist, aber im großen Maßstab, gepaart mit menschlichem Feedback, wird das System schließlich mit einem hohen Maß an Vertrauen Wahrheit und Weisheit erreichen? Können Sie sich dessen sicher sein?

GB: Ja, ich denke, OpenAI bewegt sich in diese Richtung. Der Ansatz von OpenAI besteht darin, sich von der Realität ins Gesicht treffen zu lassen, denn das Feld ist voller leerer Versprechungen. Experten sagen seit 70 Jahren, dass neuronale Netze nicht funktionieren werden, und das hat sich noch immer nicht bewiesen. Es kann noch 70 Jahre oder länger dauern, bis sich herausstellt, dass sie Recht haben. Unser Ansatz bestand schon immer darin, die Grenzen dieser Technologie zu erweitern, um sie in Aktion zu sehen, damit wir zu neuen Paradigmen übergehen können. Wir müssen noch das volle Potenzial dieser Technologie entdecken.

CA: Ich meine, die Position, die Sie vertreten, ist sehr kontrovers. Das Richtige ist, es öffentlich zu machen und dann das gesamte Feedback zu nutzen, nicht nur das Feedback Ihres Teams. Jetzt gibt die Welt Feedback. Aber wenn schlimme Dinge passieren, dann werden sie es tun.

Die erste OpenAI-Geschichte, die ich hörte, war, dass Sie als gemeinnützige Organisation gegründet wurden, um große Unternehmen zu kontrollieren, die KI für unbekannte, möglicherweise schändliche Dinge einsetzen. Bei Bedarf erstellen Sie Modelle, um sie zur Rechenschaft zu ziehen und das Feld zu verlangsamen. Zumindest habe ich das gehört.

Es geschah jedoch genau das Gegenteil. Ihr habt die Tech-Welt mit der Veröffentlichung von GPT, insbesondere ChatGPT, schockiert, und jetzt beeilen sich Google, Meta und andere, diesem Beispiel zu folgen. Einige ihrer Kritikpunkte sind, dass man sie zwingt, dieses Ding ohne entsprechende Sicherheitsvorkehrungen freizugeben, sonst würden sie sterben.

Wie argumentieren Sie, dass das, was Sie getan haben, verantwortungsvoll und nicht rücksichtslos war?

GB: Ja, über diese Fragen haben wir ernsthaft nachgedacht. Ich glaube nicht, dass wir immer perfekt sein können. Aber ich glaube, seit wir darüber nachdenken, wie wir künstliche Intelligenz zum Wohle aller Menschen aufbauen können, ist eines sehr wichtig: Wie machen wir das? Der Standardplan, im Geheimen zu bauen, hochleistungsfähige Werkzeuge zu beschaffen und dann deren Sicherheit vor dem Start zu bewerten, erscheint beängstigend und falsch. Ich weiß nicht, wie ich diesen Plan umsetzen soll, vielleicht weiß es jemand, aber für mich ist der andere Weg der einzige andere Weg, den ich sehe. Der Ansatz besteht darin, die Realität auf sich wirken zu lassen, den Menschen Zeit zu geben, sich eine Meinung zu bilden und die Funktionsweise der Maschine beobachten zu können, bevor sie perfekt und übermächtig wird. Wir haben gesehen, was mit GPT-3 passiert ist, oder? Wir machten uns Sorgen, dass Leute Fehlinformationen verbreiten oder versuchen könnten, die Wahlen zu stören, aber in Wirklichkeit war das erste, was erzeugt wurde, Viagra-Spam. (Publikum lacht)

CA: Viagra-Spam ist schlecht, aber es gibt Schlimmeres. Hier ist ein Gedankenexperiment zum Nachdenken. Angenommen, Sie sitzen in einem Raum und haben eine Kiste auf dem Tisch. Sie glauben, dass in der Schachtel etwas absolut Schönes steckt, das ein wunderbares Geschenk für Ihre Familie und andere darstellt.Allerdings besteht im Kleingedruckten auch eine Wahrscheinlichkeit von 1 zu 100, dass die Schachtel „Pandora“ enthält, was unvorstellbare Dämonen entfesseln kann. Wirst du diese Kiste öffnen?

GB: Absolut nicht. Ich glaube nicht, dass du das tun solltest.

Lassen Sie mich Ihnen eine Geschichte erzählen, die ich noch nie erzählt habe. Als wir uns zum ersten Mal für KI interessierten, war ich auf einer KI-Konferenz in Puerto Rico. Ich saß in meinem Hotelzimmer und beobachtete das wunderschöne Wasser und die Menschen, die Spaß hatten. Einen Moment lang habe ich mich gefragt, was mir lieber ist: die Büchse der künstlichen Intelligenz der Pandora innerhalb von fünf Jahren oder innerhalb von fünfhundert Jahren zu öffnen. Einerseits wäre es manchen vielleicht lieber, wenn es fünf Jahre später eröffnet würde. Aber in fünfhundert Jahren werden die Menschen mehr Zeit haben, das Richtige zu tun. Was würden Sie wählen? In diesem Moment wurde mir klar, dass ich mich für fünfhundert Jahre entscheiden würde.

Zu dieser Zeit war mein Bruder beim Militär und riskierte sein Leben im wahrsten Sinne des Wortes als jeder andere von uns Technologieentwicklern. Daher glaube ich fest an die sorgfältige Entwicklung künstlicher Intelligenz. Allerdings glaube ich nicht, dass wir die Lage richtig eingeschätzt haben. In der Geschichte der Informatik war dieser Wandel die menschliche Domäne ganzer Branchen und sogar technologischer Entwicklungen. Wenn wir bestehende Technologien nicht integrieren können, geraten wir in eine Situation des Überflusses. Wir bauen immer noch schnellere Computer und verbessern Algorithmen, und wenn wir sie nicht integrieren, wird es jemand anderes tun. Wenn das der Fall ist, verfügen wir über eine sehr leistungsstarke Technologie ohne jegliche Sicherheitsmaßnahmen.

Wenn man an die Entwicklung anderer Technologien wie Atomwaffen denkt, spricht man davon, dass es sich um eine Null-zu-eins-Änderung handelt, die der Mensch bewirken kann. Aber ich denke, die Kapazität ist stetig gewachsen. Die Geschichte jeder von uns entwickelten Technologie ist inkrementell und wir mussten jede Entwicklungsphase verwalten.

CA: Also, wenn ich das richtig verstehe, ist das Modell, dem Sie folgen sollen, dass wir ein außergewöhnliches Kind haben, das Superkräfte haben könnte, die die Menschheit auf eine ganz neue Ebene heben können. Wir haben die gemeinsame Verantwortung, diesem Kind Orientierung zu geben und ihm beizubringen, gute Entscheidungen zu treffen, bevor es uns alle zerstört. Ist das die Grundidee?

GB: Ich glaube, das ist wahr. Beachten Sie auch, dass sich dies ändern kann. Wir müssen jeden Schritt bewältigen. Heutzutage ist es von entscheidender Bedeutung, dass wir uns mit der Technologie vertraut machen, entscheiden, wie wir Feedback geben und entscheiden, was wir von ihr erwarten. Ich hoffe, dass dies immer noch die beste Vorgehensweise ist, aber es ist positiv, dass wir diese Diskussion führen, sonst wäre es nicht passiert.Kehren Sie nach Sohu zurück, um mehr zu sehen