Robert Triggs / Android Authority

ChatGPT ist für viele von uns zu einem unverzichtbaren kreativen Werkzeug geworden. So hochmodern es auch ist, ChatGPT leidet immer noch unter gelegentlichen Verlangsamungen, die dazu führen können, dass Sie Sekunden oder sogar mehr als eine Minute zwischen den Antworten warten müssen. Auch der Wechsel zum kostenpflichtigen ChatGPT-4-Modell wird die Sache nicht unbedingt beschleunigen. All dies wirft zwei wichtige Fragen auf: Warum ist ChatGPT so langsam und was können wir tun, um es zu verbessern?

Warum ist ChatGPT so langsam? Ein technischer Überblick

Calvin Wankhede / Android Authority

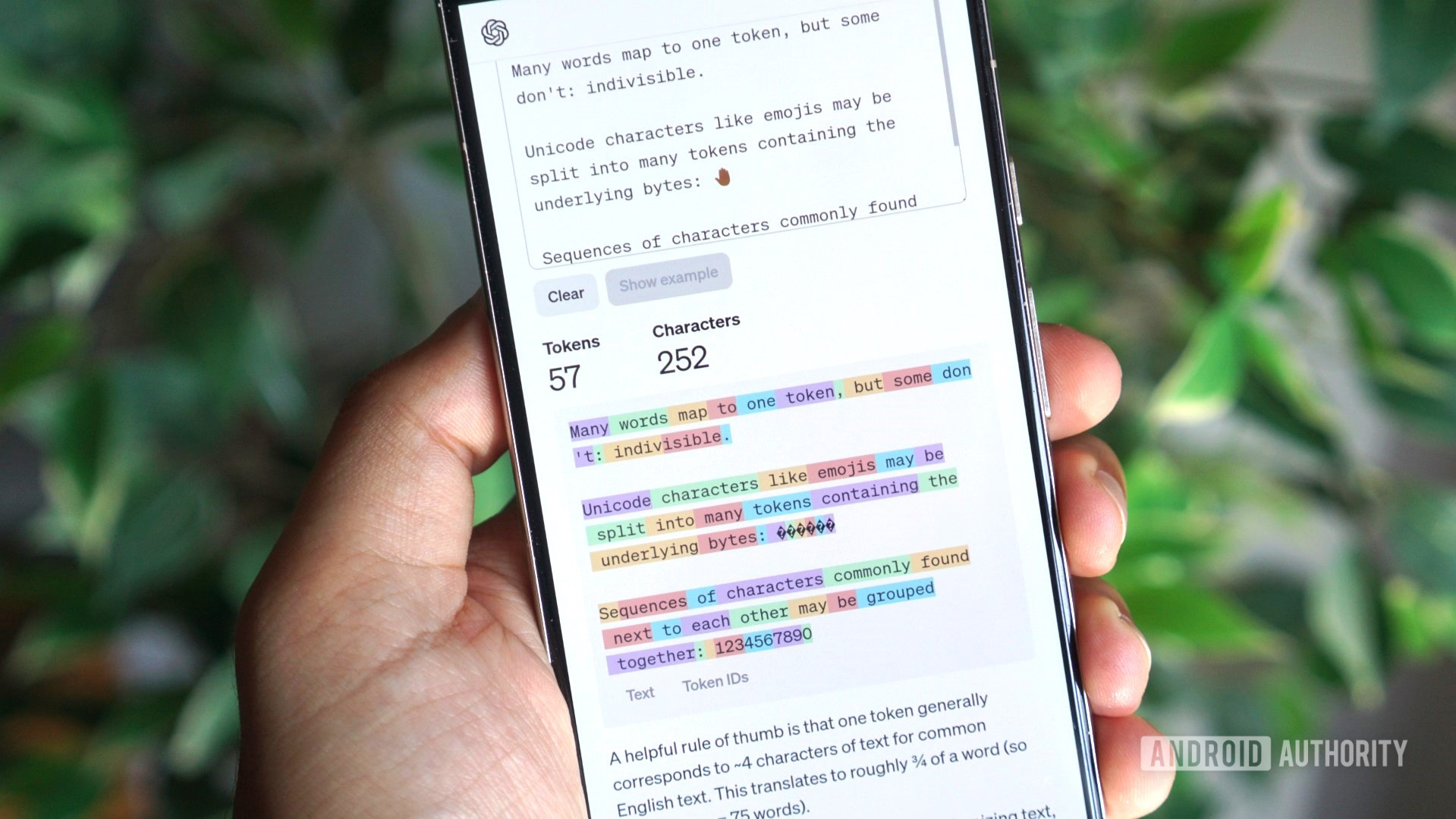

ChatGPT ist ein Beispiel für generative KI oder künstliche Intelligenz, die neue Inhalte generieren kann. Es handelt sich um einen Prozess, der erhebliche Mengen an Rechenleistung erfordert. Jedes Mal, wenn Sie dem Chatbot eine Nachricht senden, muss er diese entschlüsseln und eine neue Antwort generieren. Intern verarbeitet das zugrunde liegende Sprachmodell von ChatGPT Text als Token statt als Wörter. Sie können sich ein ChatGPT-Token als die grundlegendste Einheit der Nachricht des Chatbots vorstellen.

Sprachmodelle wie das, das ChatGPT antreibt, wurden auf Hunderten von Gigabyte Text trainiert, was bedeutet, dass sie die Muster der menschlichen Sprache und des Dialogs gelernt haben. Bei großen Textmengen kann es auch den Kontext und die Beziehung zwischen Wörtern und Sätzen lernen. Mithilfe dieses Trainings können wir das Modell dann bitten, völlig neuen Text zu generieren, den es noch nie zuvor gesehen hat.

Die zugrunde liegende Technologie von ChatGPT erfordert große Mengen an (begrenzter) Rechenleistung.

Jedes Mal, wenn Sie ChatGPT etwas fragen, stützt sich das zugrunde liegende Modell auf sein Training, um das nächste Wort oder Token in seiner Antwort vorherzusagen. Das Modell kann diese Wahrscheinlichkeitsberechnungen sequenzieren, um ganze Sätze und Textabschnitte zu bilden.

Jede Token-Vorhersage erfordert ein gewisses Maß an Rechenleistung, genau wie unser Gehirn manchmal innehalten kann, um Entscheidungen zu treffen. Der einzige Unterschied besteht darin, dass KI-Modelle, die auf leistungsstarken Servern laufen, typischerweise Hunderte von Token pro Sekunde vorhersagen können.

Was ChatGPT so langsam macht, ist einfach eine Frage der übermäßigen Nachfrage nach der begrenzten verfügbaren Rechenleistung. Auch das von Ihnen gewählte Sprachmodell hat Auswirkungen – fortgeschrittenere Modelle sind im Allgemeinen langsamer. Obwohl OpenAI keine genauen Zahlen veröffentlicht hat, kann man davon ausgehen, dass GPT-4 Turbo nicht so schnell reagiert wie das Standardmodell GPT-3.5.

ChatGPT-4 ist langsam, weil es das langsamere GPT-4-Turbo-Modell verwendet, bei dem Antwortgenauigkeit und -qualität Vorrang vor Geschwindigkeit haben. Das reguläre ChatGPT- oder GPT-3.5-Modell hat zu diesem Zeitpunkt seit weit über einem Jahr inkrementelle Updates erhalten, wodurch es viel schneller, aber ungenauer ist.

So verbessern Sie die Reaktionsgeschwindigkeit von ChatGPT

Nach der Erklärung, wie die Antworten von ChatGPT funktionieren, fragen Sie sich vielleicht, ob es eine Möglichkeit gibt, die Antworten zu beschleunigen. Glücklicherweise gibt es ein paar Dinge, die Sie versuchen können, um die Situation zu verbessern.

1. Probieren Sie einen anderen Browser, eine andere Verbindung und ein anderes Gerät aus

Bevor wir die Schuld direkt auf ChatGPT schieben, sollten wir versuchen, mögliche Gründe für die Verlangsamung auf unserer Seite auszuschließen. Ein falsch konfigurierter Browser oder eine falsch konfigurierte Internetverbindung könnten genauso gut der Grund für langsame ChatGPT-Antworten sein, es lohnt sich also, dort anzufangen.

Bevor Sie fortfahren, empfehlen wir Ihnen, die gespeicherten Cookies und Cache-Dateien Ihres Browsers zu löschen. Gehen Sie dazu auf die Einstellungsseite Ihres Browsers und suchen Sie nach einer Schaltfläche zum Zurücksetzen oder Löschen von Browserdaten. In Chrome beispielsweise ist es unter Einstellungen > Zurücksetzen > Stellen Sie die Einstellungen auf ihre ursprünglichen Standardwerte zurück > Einstellungen zurücksetzen. Nach dem Zurücksetzen Ihres Browsers müssen Sie sich erneut bei Ihrem ChatGPT-Konto anmelden.

2. Ist ChatGPT heute langsam? Überprüfen Sie die Statusseite von OpenAI

Calvin Wankhede / Android Authority

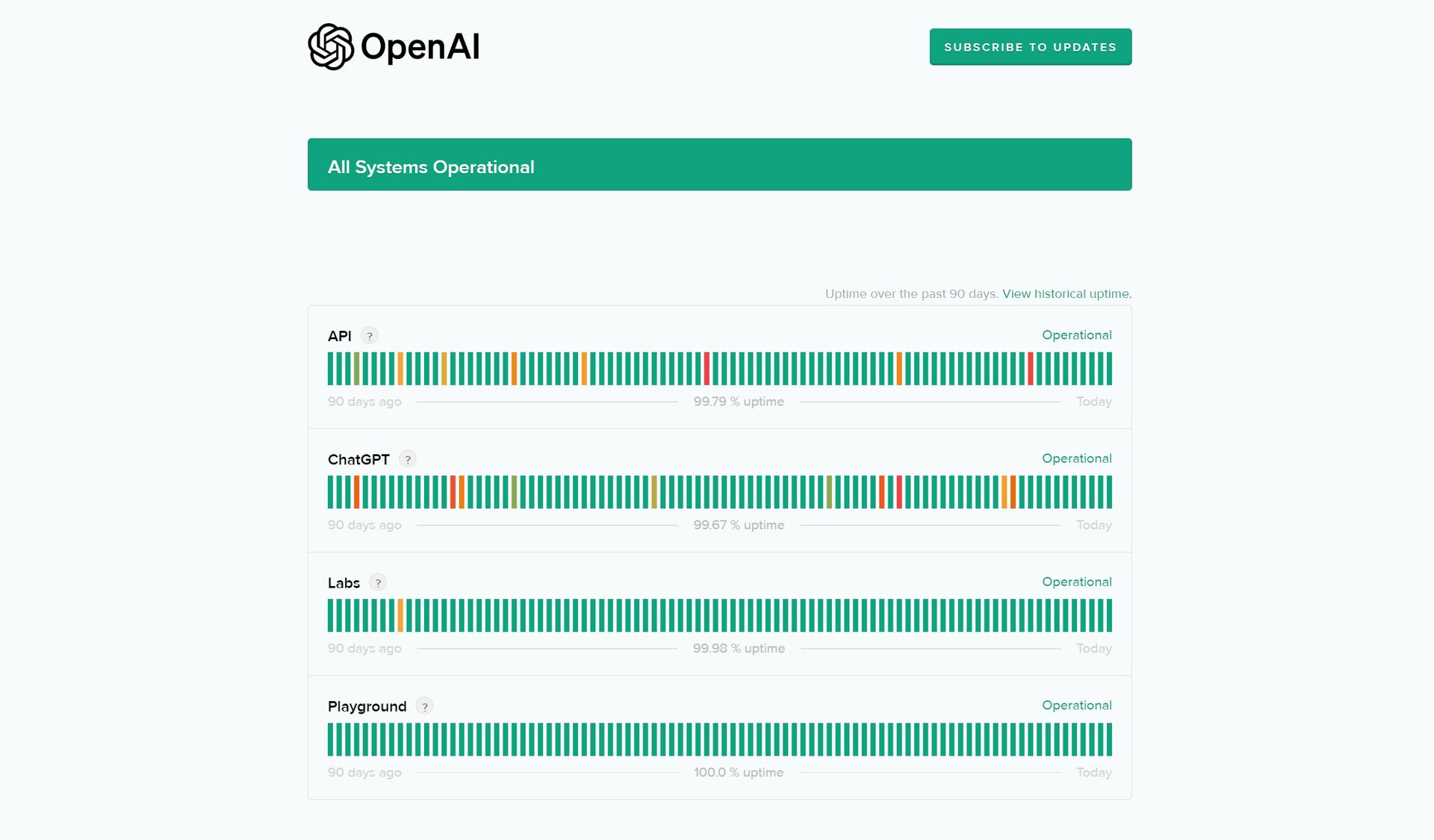

OpenAI unterhält eine offizielle Statusseite Das kann Ihnen sagen, ob ChatGPT derzeit nicht funktioniert oder Verlangsamungen auftreten. Dies ist der schnellste Weg, um festzustellen, ob der Dienst von einem größeren Ausfall betroffen ist oder Schwierigkeiten hat, mit der gestiegenen Benutzernachfrage Schritt zu halten.

Wenn auf der Statusseite ein Problem mit ChatGPT angezeigt wird, können Sie leider nichts dagegen tun. Die meisten Probleme werden innerhalb weniger Stunden gelöst, sodass Sie möglicherweise nicht lange warten müssen.

3. Suchen Sie nach einer aktiven VPN-Verbindung

Während ein VPN allein nicht unbedingt zu langsameren ChatGPT-Antworten führt, können Unternehmens- oder öffentliche VPNs den Chatbot auf subtile Weise beeinflussen. Insbesondere Unternehmens-VPNs können die Verbindung zu den Servern von ChatGPT blockieren oder stören.

Wenn Sie einen beliebten VPN-Dienst nutzen und eine Verbindung zu einem ausgelasteten Server herstellen, können die Server von ChatGPT ebenfalls eine Flut von Anfragen von einer einzelnen IP-Adresse erkennen. Dies könnte Anti-Spam-Maßnahmen oder eine Ratenbegrenzung auslösen, die die Geschwindigkeit drosselt, mit der Sie Nachrichten senden und empfangen können.

Die beste Vorgehensweise wäre, den Chatbot ohne VPN-Verbindung zu verwenden, sofern Sie derzeit eine aktiviert haben. Wir wissen bereits, dass ChatGPT Ihre Daten auf Kontoebene speichert, daher bietet die Verwendung eines VPN hier keinen Datenschutzvorteil.

4. Upgrade auf ChatGPT Plus

Calvin Wankhede / Android Authority

Wenn keine der vorherigen Lösungen für Sie funktioniert hat, liegt das möglicherweise daran, dass Sie ChatGPT eher dann verwenden, wenn es am stärksten ausgelastet ist. Und wenn Sie den Chatbot kostenlos nutzen, stehen Sie im Vergleich zu einem zahlenden Kunden auf der Prioritätenliste weiter unten. Wenn Ihnen Reaktionsgeschwindigkeit wirklich wichtig ist, könnte ein ChatGPT Plus-Abonnement Ihr letzter Ausweg sein, obwohl Sie zunächst den nächsten Abschnitt lesen sollten.

Mit einem ChatGPT Plus-Abonnement sparen Sie monatlich 20 US-Dollar, aber es bietet schnellere Antworten. In Zeiten hoher Nachfrage erhalten Sie außerdem vorrangigen Zugriff auf den Chatbot, was bei eventuellen Verzögerungen hilfreich sein sollte.

5. Verwenden Sie einen alternativen Chatbot mit schnelleren Reaktionszeiten

Calvin Wankhede / Android Authority

Während ChatGPT einst das einzige KI-Sprachtool auf dem Markt war, ist das nicht mehr der Fall. Nehmen Sie zum Beispiel Microsoft Copilot. Auch wenn es auf der gleichen GPT-Familie von Sprachmodellen basiert, kann es je nach Serverauslastung von ChatGPT einen Geschwindigkeitsvorteil haben. Aber meiner Erfahrung nach liefert Googles Gemini in der Regel schnellere Antworten als jeder GPT-basierte Chatbot.

Ebenso bieten eine Handvoll anderer generativer KI-basierter Tools wie Perplexity schnellere Antworten als ChatGPT. Dies liegt wahrscheinlich daran, dass herkömmliche Chatbots sich frühere Nachrichten aus Kontextgründen merken müssen, was die Komplexität von Token-Vorhersagen erhöhen kann. Kleinere Sprachmodelle liefern ebenfalls schnellere Antworten, allerdings auf Kosten der Antwortqualität.