1. Übersicht

Kunst, Kommunikation und unser Verständnis der realen Welt verändern sich rasant. Wenn wir auf die Geschichte der menschlichen Innovation zurückblicken, könnten wir die Erfindung des Rades oder die Entdeckung der Elektrizität als große Fortschritte betrachten. Heute findet eine neue Revolution statt – sie überbrückt die Kluft zwischen menschlicher Kreativität und maschinellem Rechnen. Genau das ist generative KI.

Generative Modelle verwischen die Grenzen zwischen Mensch und Maschine. Mit dem Aufkommen von Modellen wie GPT-4, die das Transformer-Modul verwenden, sind wir der natürlichen und kontextreichen Sprachgenerierung einen Schritt näher gekommen. Diese Fortschritte treiben Anwendungen in der Dokumentenerstellung, in Chatbot-Konversationssystemen und sogar in der Erstellung synthetischer Musik voran.

Jüngste Entscheidungen großer Technologieunternehmen unterstreichen seine Bedeutung. Microsoft hat die Cortana-App eingestellt und diesen Monat neueren generativen KI-Innovationen wie Bing Chat Priorität eingeräumt. Wie CEO Tim Cook feststellte, wendet apple auch einen großen Teil seines Forschungs- und Entwicklungsbudgets in Höhe von 2,26 Milliarden US-Dollar für generative künstliche Intelligenz auf.

In dieser Passage werden die Veränderungen beschrieben, die generative KI in der Kunst, Kommunikation und Realitätswahrnehmung mit sich bringen wird, sowie ihre Anwendungen in der Dokumentenerstellung, in Chatbot-Dialogsystemen und in der Musikkomposition. Gleichzeitig wurden auch die Investitionen und Entscheidungen großer Technologieunternehmen wie Microsoft und Apple in diesem Bereich erwähnt, die die Bedeutung generativer künstlicher Intelligenz in der aktuellen technologischen Entwicklung verdeutlichen.

2. Modell generieren

Die Geschichte der generativen KI beschränkt sich in der Tat nicht nur auf ihre Anwendungen, sondern befasst sich auch tiefgreifend mit ihrem Innenleben. Im Bereich der künstlichen Intelligenz sind diskriminative Modelle und generative Modelle zwei grundlegende Modelltypen, die jeweils unterschiedliche Rollen spielen.

Diskriminierende Modelle: Die Hauptaufgabe diskriminierender Modelle besteht darin, zwischen verschiedenen Kategorien zu unterscheiden oder Entscheidungen zu treffen. Sie funktionieren, indem sie die Merkmale und Muster der Eingabedaten lernen und dann auf der Grundlage dieser Merkmale neue Datenpunkte vorhersagen oder klassifizieren. Im täglichen Leben gehören viele Algorithmen für maschinelles Lernen, denen wir begegnen, zu diskriminierenden Modellen, wie zum Beispiel:

- Bildidentifikation: Identifizieren Sie Objekte in Bildern.

- Spracherkennung: Sprache in Text umwandeln.

- Spam-Filterung: Stellen Sie fest, ob es sich bei einer E-Mail um Spam handelt.

- medizinische Diagnose: Vorhersage von Krankheiten anhand von Symptomen und Testergebnissen.

Diskriminative Modelle werden häufig für Aufgaben wie Klassifizierung, Regression und Anomalieerkennung verwendet.

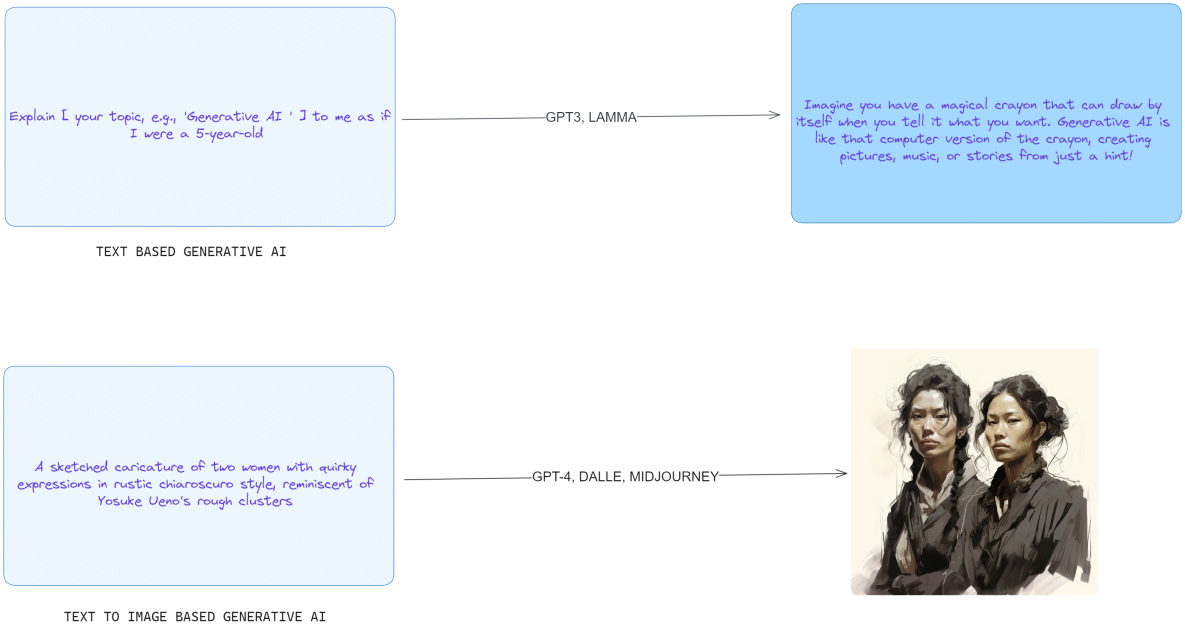

Generative Modelle: Im Gegensatz zu diskriminierenden Modellen besteht das Ziel generativer Modelle darin, neue Dateninstanzen zu generieren, die eine ähnliche Verteilung wie die Trainingsdaten aufweisen. Sie erklären oder prognostizieren nicht nur bestehende Daten, sondern können völlig neue Inhalte schaffen. Beispiele für generative Modelle sind:

- Bilderzeugung: Erzeugen Sie neue Bilder, die realistisch aussehen.

- Textgenerierung: Erstellen Sie ein Gedicht, eine Geschichte oder einen Dialog.

- Musiksynthese: Neue Musikwerke schaffen.

- Datenerweiterung: Generieren Sie zusätzliche Trainingsdaten, wenn Sie ein Modell für maschinelles Lernen trainieren.

Generative Modelle generieren Daten typischerweise auf der Grundlage einer Wahrscheinlichkeitsverteilung, was bedeutet, dass sie neue Instanzen generieren können, die der Verteilung der Trainingsdaten ähneln, jedoch neuen Inhalt haben.

midjourney)“/>

midjourney)“/>

3. Technologie hinter generativen Modellen

Die Existenz und Entwicklung generativer Modelle ist in der Tat größtenteils auf die Weiterentwicklung der Technologie tiefer neuronaler Netzwerke zurückzuführen. Deep Neural Networks (DNNs) sind Netzwerke, die aus mehreren Schichten künstlicher Neuronen bestehen und in der Lage sind, komplexe Muster und Darstellungen in Daten zu lernen, wodurch sie sich gut für generative Aufgaben eignen.

Wie werden diese generativen Modelle umgesetzt? Hier sind einige wichtige Punkte:

(1). tiefes neuronales Netzwerk: Generative Modelle nutzen typischerweise tiefe neuronale Netze, um hochdimensionale Darstellungen von Daten zu lernen. Diese Netzwerke sind in der Lage, Features automatisch zu extrahieren, ohne dass Feature-Extraktoren manuell entworfen werden müssen.

(2). Optimierung: Durch den Trainingsprozess werden die Gewichte des Netzwerks optimiert, um neue Dateninstanzen generieren zu können, die den Trainingsdaten ähneln.

(3). Generatives gegnerisches Netzwerk (GAN): GAN besteht aus zwei Schlüsselteilen: Generator (Generator) und Diskriminator (Diskriminator). Das Ziel des Generators besteht darin, realistische Daten zu erzeugen, während das Ziel des Diskriminators darin besteht, echte Daten von gefälschten Daten zu unterscheiden, die vom Generator erzeugt werden. Diese beiden Teile konkurrieren während des Trainingsprozesses miteinander, um die Leistungsverbesserungen des anderen voranzutreiben.

(4). Variationaler Autoencoder (VAE): VAE ist ein weiteres generatives Modell, das Eingabedaten über den Encoder einer Verteilung in einem latenten Raum zuordnet und dann über den Decoder Stichproben aus dieser Verteilung durchführt, um neue Daten zu generieren. Das Hauptmerkmal von VAE ist seine Fähigkeit, kontinuierliche Datenpunkte zu generieren und die Zufälligkeit des Generierungsprozesses zu steuern.

(5). Anwendungsbereiche: Generative Modelle werden in einer Vielzahl von Anwendungen verwendet, darunter künstlerisches Schaffen (z. B. Malerei und Stilübertragung), Musiksynthese, Spieldesign usw. Sie können neuartige Inhalte erstellen und die Entwicklung der Kreativwirtschaft fördern.

(6). Kreativität und Fantasie: Generative Modelle kopieren nicht nur vorhandene Daten, sie können völlig neue Instanzen von Daten erstellen, die noch nie zuvor existierten, was besonders in Bereichen wie Kunst und Design wertvoll ist.

4. Generative KI-Typen: Text-zu-Text, Text-zu-Bild

4.1 Transformator und LLM

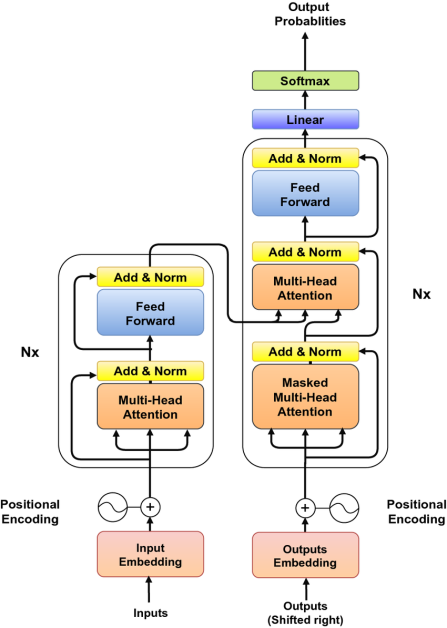

Der Artikel „Attention Is All You Need“ wurde vom google Brain-Team verfasst und stellt eine große Innovation in der Textmodellierung dar. Das in diesem Artikel vorgeschlagene Transformer-Modell verzichtet auf traditionelle komplexe Strukturen wie rekurrente neuronale Netze (RNN) und Faltungs-neuronale Netze (CNN), die auf Sequenzerweiterung basieren, und übernimmt stattdessen das innovative Konzept des Aufmerksamkeitsmechanismus. Der Kern dieses Mechanismus ist seine Fähigkeit, sich je nach Kontext dynamisch auf verschiedene Teile des Eingabetextes zu konzentrieren.

Einer der Hauptvorteile des Transformer-Modells ist seine Fähigkeit, leicht parallelisiert zu werden. Dies steht in scharfem Gegensatz zu herkömmlichen RNNs, deren Skalierbarkeit aufgrund ihrer inhärenten Sequenzverarbeitungseigenschaften eingeschränkt ist, insbesondere bei der Verarbeitung großer Datenmengen. Im Gegensatz dazu ist Transformer in der Lage, mehrere Teile der gesamten Sequenz gleichzeitig zu verarbeiten, was den Trainingsprozess erheblich beschleunigt und das Training großer Datensätze schneller und effizienter macht. Dieses bahnbrechende Design eröffnet neue Möglichkeiten im Bereich der Verarbeitung natürlicher Sprache und legt den Grundstein für zukünftige Forschung und Anwendungen.

Bei der Langtextverarbeitung ist nicht jedes Wort oder jeder Satz gleich wichtig. Der Aufmerksamkeitsmechanismus soll dieses Problem lösen. Er imitiert die Aufmerksamkeitsverteilung, wenn Menschen Sprache verstehen, d. h. die Aufmerksamkeit auf verschiedene Teile entsprechend der Bedeutung des Kontexts.

Bei der Langtextverarbeitung ist nicht jedes Wort oder jeder Satz gleich wichtig. Der Aufmerksamkeitsmechanismus soll dieses Problem lösen. Er imitiert die Aufmerksamkeitsverteilung, wenn Menschen Sprache verstehen, d. h. die Aufmerksamkeit auf verschiedene Teile entsprechend der Bedeutung des Kontexts.

Nehmen Sie den folgenden Satz als Beispiel: „Veröffentlichen Sie künstliche Intelligenz und Roboternachrichten.“ In diesem Satz enthalten verschiedene Wörter unterschiedliche Informationsmengen und Richtwirkungen. Bei der Verwendung des Aufmerksamkeitsmechanismus zur Vorhersage des nächsten Wortes analysiert das Modell den Kontext und identifiziert Schlüsselwörter, um zu entscheiden, welche Teile mehr Aufmerksamkeit verdienen.

- Der Begriff „Roboter“ kann Aufmerksamkeit erregen, da es sich um ein Schlüsselwort für ein bestimmtes Gebiet (einen Zweig der künstlichen Intelligenz) handelt. Bei der Vorhersage des nächsten Wortes könnte das Modell Wörter berücksichtigen, die sich auf Robotik, Anwendungen oder aktuelle Entwicklungen beziehen.

- Die Handlung „veröffentlichen“ kann darauf hinweisen, dass der folgende Inhalt mit Nachrichtenberichten, der Veröffentlichung von Forschungsergebnissen oder der Verbreitung von Informationen zusammenhängt. Daher könnte das Modell Wörter vorhersagen, die sich auf Artikel, Zeitschriften, Entdeckungen oder Ankündigungen beziehen.

Der Aufmerksamkeitsmechanismus bestimmt die Bedeutung jedes Wortes für die Vorhersage des nächsten Wortes, indem er jedem Wort im Satz eine Gewichtung (d. h. Aufmerksamkeitswert) zuweist. Wörter mit höherer Gewichtung haben einen größeren Einfluss auf die Vorhersagen des Modells. Auf diese Weise ist das Modell in der Lage, nicht nur lokale syntaktische und semantische Informationen, sondern auch weiter entfernte Abhängigkeiten zu erfassen, was besonders wichtig ist, wenn es um komplexe oder weit entfernte Sprachstrukturen geht.

Der Aufmerksamkeitsmechanismus in Transformers ist in der Tat sehr clever gestaltet und kann eine selektive Aufmerksamkeit für den Eingabetext erreichen. Dieser Mechanismus bewertet die Wichtigkeit verschiedener Teile des Textes und entscheidet, worauf man sich bei der Generierung einer Antwort konzentrieren soll. Dies unterscheidet sich völlig von der Art und Weise, wie frühere Architekturen wie RNN alle Eingabeinformationen in einen einzigen Zustand oder Speicher komprimierten.

Der Aufmerksamkeitsmechanismus funktioniert wie ein effizientes Schlüsselwert-Abrufsystem. Bei der Vorhersage des nächsten Wortes in einem Satz liefert jedes vorkommende Wort einen „Schlüssel“, der die potenzielle Relevanz des Wortes für die Vorhersageaufgabe angibt. Jedem Wort wird dann ein „Wert“ oder eine Gewichtung zugewiesen, basierend darauf, wie gut diese „Schlüssel“ mit dem aktuellen Kontext (oder der aktuellen Abfrage) übereinstimmen, und diese Gewichte arbeiten im Vorhersageprozess zusammen.

Dieses fortschrittliche Deep-Learning-Modell wurde in einer Vielzahl von Szenarien eingesetzt, von der Suchmaschinenoptimierung BERT von Google bis hin zu Copilot von GitHub, das die Leistungsfähigkeit großer Sprachmodelle (LLM) nutzt, um einfache Codeausschnitte in vollständigen Quellcode umzuwandeln.

Große Sprachmodelle (LLMs) wie GPT-4, Bard und LLaMA sind massive Strukturen, die dazu dienen, menschliche Sprache, Code und mehr zu dekodieren und zu generieren. Der Umfang dieser Modelle (von Milliarden bis Billionen Parametern) ist eines ihrer auffälligsten Merkmale. Diese LL.M.-Studierenden wurden auf riesigen Mengen an Textdaten geschult und beherrschten die Komplexität der menschlichen Sprache. Eine ihrer bemerkenswerten Fähigkeiten ist das „Few-Shot-Learning“, was bedeutet, dass sie im Vergleich zu herkömmlichen Modellen in der Lage sind, aus einer sehr kleinen Anzahl von Beispielen effektiv zu lernen und zu verallgemeinern.

4.2 Der Status großer Sprachmodelle (LLM) von Mitte bis Ende 2024

| Modellname | Entwickler | Parameter | Verfügbarkeit und Zugang | Bemerkenswerte Funktionen und Anmerkungen |

| GPT-4 | OpenAI | 1,5 Billionen | Nicht Open Source, nur API-Zugriff | Beeindruckende Leistung bei einer Vielzahl von Aufgaben. Kann Bilder und Text verarbeiten, maximale Eingabelänge 32.768 Token |

| GPT-3 | OpenAI | 175 Milliarden | Nicht Open Source, nur API-Zugriff | Nachgewiesene Fähigkeiten zum Lernen mit wenigen und keinen Versuchen. Führt Textvervollständigung in natürlicher Sprache durch. |

| BLÜHEN | BigScience | 176 Milliarden | Herunterladbares Modell, gehostete API verfügbar | Mehrsprachiges LLM, entwickelt durch globale Zusammenarbeit. Unterstützt 13 Programmiersprachen. |

| LaMDA | 173 Milliarden | Nicht Open Source, keine API oder Download | Auf Dialog trainiert, könnte lernen, über praktisch alles zu sprechen | |

| MT-NLG | Nvidia/Microsoft | 530 Milliarden | API-Zugriff nach Anwendung | Nutzt die transformerbasierte Megatron-Architektur für verschiedene NLP-Aufgaben. |

| Lama | Meta-KI | 7B bis 65B) | Herunterladbar per Anwendung | Ziel ist es, KI zu demokratisieren, indem Forschung, Regierung und Wissenschaft Zugang gewährt wird. |

4.3 Verwendung von LLM

LLM wird auf vielfältige Weise eingesetzt, unter anderem:

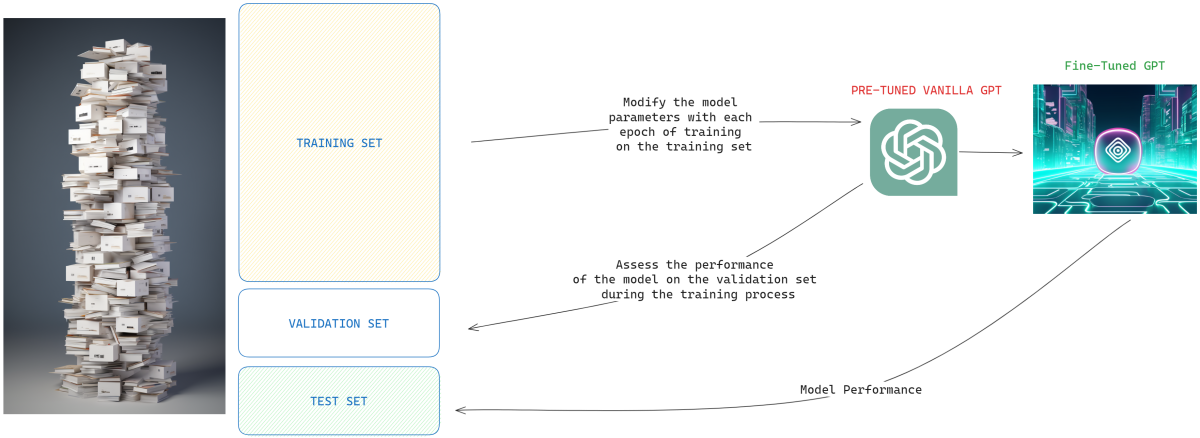

(1). Direkte Nutzung: Verwenden Sie einfach vorab trainierte LL.M. zur Textgenerierung oder -verarbeitung. Das Schreiben eines Blogbeitrags mit GPT-4 erfordert beispielsweise keine zusätzliche Feinabstimmung. (2). Feinabstimmung: Die Anpassung des vorab trainierten LL.M. an bestimmte Aufgaben wird als Transferlernen bezeichnet. Ein Beispiel ist die Anpassung von T5 zur Erstellung von Zusammenfassungen branchenspezifischer Dokumente. (3). Informationsabruf: Verwenden Sie LLM (wie BERT oder GPT) als Teil einer großen Architektur, um Systeme zu entwickeln, die Informationen abrufen und klassifizieren können.

chatgpt-Feinabstimmung“/>

chatgpt-Feinabstimmung“/>

4.4 Mehrere Aufmerksamkeitspunkte

Das Verlassen auf einen einzigen Aufmerksamkeitsmechanismus kann jedoch Einschränkungen haben. Verschiedene Wörter oder Sequenzen im Text können unterschiedliche Arten von Korrelationen oder Assoziationen haben. Hier kommt bullische Aufmerksamkeit ins Spiel. Anstelle eines Satzes von Aufmerksamkeitsgewichtungen verwendet die Multi-Head-Aufmerksamkeit mehrere Sätze von Aufmerksamkeitsgewichtungen, sodass das Modell umfassendere Beziehungen im Eingabetext erfassen kann. Jeder Aufmerksamkeits-„Kopf“ kann sich auf verschiedene Teile oder Aspekte der Eingabe konzentrieren, und ihr kombiniertes Wissen wird in der endgültigen Vorhersage verwendet.

4.5 ChatGPT: Das beliebteste generative künstliche Intelligenztool

Seit der Geburt von GPT im Jahr 2018 basiert das Modell im Wesentlichen auf 12 Schichten, 12 Aufmerksamkeitsköpfen und 12 Milliarden Parametern und wird hauptsächlich auf einem Datensatz namens BookCorpus trainiert. Es ist ein beeindruckender Auftakt und ein Blick in die Zukunft der Sprachmodelle.

GPT-2 wurde 2019 mit der vierfachen Anzahl an Ebenen und Aufmerksamkeitsköpfen eingeführt. Bemerkenswert ist, dass die Anzahl der Parameter auf 150 Millionen anstieg. Diese erweiterte Version wurde auf WebText trainiert, einem Datensatz mit 40 GB Text aus verschiedenen Reddit-Links.

GPT-96 wurde im März 2020 eingeführt und verfügt über 96 Schichten, 175 Aufmerksamkeitspunkte und 300 Millionen große Parameter. Was GPT-570 auszeichnet, sind seine vielfältigen Trainingsdaten, darunter CommonCrawl, WebText, englische Wikipedia, Buchkorpora und andere Quellen, insgesamt 570 GB.

Die Feinheiten der Funktionsweise von ChatGPT bleiben ein streng gehütetes Geheimnis. Es ist jedoch bekannt, dass der Prozess des „Reinforcement Learning from Human Feedback“ (RLHF) von entscheidender Bedeutung ist. Diese Technologie stammt aus dem frühen ChatGPT-Projekt und trägt dazu bei, das GPT-3.5-Modell zu verbessern, um es konsistenter mit schriftlichen Anweisungen zu machen.

Die Schulung von ChatGPT besteht aus einem dreistufigen Ansatz:

(1). Überwachte Feinabstimmung: beinhaltet die Kuratierung manuell geschriebener Dialogeingaben und -ausgaben, um das zugrunde liegende GPT-3.5-Modell zu verbessern. (2). Belohnungsmodellierung: Menschen ordnen verschiedene Modellergebnisse nach Qualität und helfen dabei, ein Belohnungsmodell zu trainieren, das jedes Ergebnis basierend auf dem Kontext des Gesprächs bewertet. (3). Verstärkungslernen: Der Dialogkontext dient als Hintergrund für die vom Basismodell vorgeschlagene Reaktion. Die Reaktion wird durch ein Belohnungsmodell bewertet und ein Algorithmus namens Proximal Policy Optimization (PPO) wird zur Optimierung des Prozesses verwendet.

5. Diffusions- und multimodale Modelle

Während Modelle wie VAEs und GANs ihre Ausgabe durch einen einzigen Generierungsprozess erzeugen und daher an das gebunden sind, was sie produzieren, führen Diffusionsmodelle das Konzept der „iterativen Verfeinerung“ ein. Auf diese Weise überprüfen und korrigieren sie Fehler in vorherigen Schritten und erzielen so nach und nach verfeinerte Ergebnisse.

Im Zentrum des Diffusionsmodells steht die Kunst der „Korruption“ und „Ausarbeitung“. Während der Trainingsphase werden typische Bilder nach und nach durch Hinzufügen unterschiedlicher Rauschpegel verfälscht. Diese verrauschte Version wird dann in das Modell eingespeist, das versucht, sie zu „entrauschen“ oder zu „entschädigen“. Nach vielen Durchgängen dieses Prozesses kann sich das Modell gut erholen und sowohl subtile als auch erhebliche Aberrationen verstehen.

5.1 Mitten in der Reise

Der Prozess der Generierung neuer Bilder aus Midjourney ist nach dem Training sehr interessant. Es beginnt mit völlig zufälligen Eingaben und wird anhand der Vorhersagen des Modells kontinuierlich verfeinert. Ziel ist es, mit möglichst wenigen Schritten ein sauberes Bild zu erhalten. Der Grad der Korruption wird durch den „Lärmplan“ gesteuert, einen Mechanismus, der steuert, wie viel Lärm in den verschiedenen Phasen angewendet wird. Scheduler in Bibliotheken wie „Diffusoren“ bestimmen die Art dieser verrauschten Versionen basierend auf etablierten Algorithmen.

Für viele Diffusionsmodelle ist UNet eine wichtige Säule ihrer Architektur – ein Faltungs-Neuronales Netzwerk, das auf Aufgaben zugeschnitten ist, bei denen die Ausgabe die räumlichen Dimensionen der Eingabe widerspiegeln muss. Es besteht aus Downsampling- und Upsampling-Schichten, die komplex miteinander verbunden sind, um die hochauflösenden Daten zu bewahren, die für die bildbezogene Ausgabe entscheidend sind.

5.2 VON-E 2

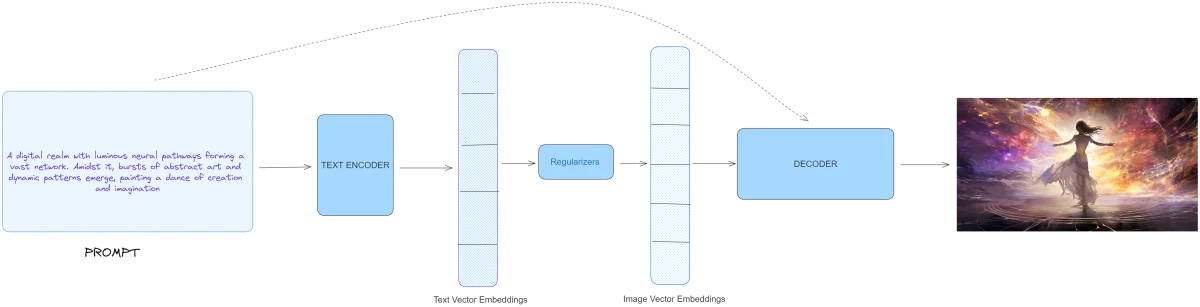

DALL-E 2 von OpenAI taucht tiefer in den Bereich generativer Modelle ein und zeichnet sich durch eine Kombination aus textuellen und visuellen KI-Funktionen aus. Es nimmt eine dreischichtige Struktur an:

DALL-E 2 demonstriert eine dreifache Architektur:

- .Text Encoder: Er wandelt Texthinweise in Konzepteinbettungen im latenten Raum um. Dieses Modell fängt nicht bei Null an. Als Grundlage dient der Contrastive Language-Image Pretraining (CLIP)-Datensatz von OpenAI. CLIP dient als Brücke zwischen visuellen und textuellen Daten, indem es visuelle Konzepte mithilfe natürlicher Sprache lernt. Durch einen Mechanismus namens kontrastives Lernen erkennt es Bilder und ordnet sie den entsprechenden Textbeschreibungen zu.

- . Prior: Die vom Encoder abgeleiteten Texteinbettungen werden anschließend in Bildeinbettungen umgewandelt. DALL-E 2 testete für diese Aufgabe autoregressive und Diffusionsmethoden, wobei letztere überlegene Ergebnisse zeigten. Autoregressive Modelle, wie sie in Transformers und PixelCNN zu sehen sind, generieren Ausgaben nacheinander. Andererseits wandeln Diffusionsmodelle wie das in DALL-E 2 verwendete zufällige Rauschen mithilfe von Texteinbettungen in vorhergesagte Bildeinbettungen um.

- . Decoder: Als Höhepunkt dieses Prozesses generiert dieser Teil die endgültige visuelle Ausgabe basierend auf Texthinweisen und Bildeinbettungen aus vorherigen Phasen. Der Decoder des DALL·E 2 verdankt seine Architektur einem anderen Modell, GLIDE, das ebenfalls realistische Bilder aus Texthinweisen erzeugen kann.

6. Anwendung generativer künstlicher Intelligenz

6.1 Textfeld

Beginnend mit Text wurde die generative KI durch Chatbots wie ChatGPT grundlegend verändert. Diese Entitäten stützen sich stark auf die Verarbeitung natürlicher Sprache (NLP) und große Sprachmodelle (LLMs), die die Fähigkeit erhalten, eine Reihe von Aufgaben auszuführen, von der Codegenerierung und Sprachübersetzung bis hin zur Zusammenfassung und Stimmungsanalyse. ChatGPT zum Beispiel hat eine breite Akzeptanz gefunden und ist für Millionen von Benutzern zu einem unverzichtbaren Tool geworden. Dies wird durch Konversations-KI-Plattformen, die auf großen Sprachmodellen wie GPT-4, PaLM und BLOOM basieren, weiter verbessert, die problemlos Text generieren, bei der Programmierung helfen und sogar mathematische Überlegungen liefern können.

Aus geschäftlicher Sicht werden diese Modelle von unschätzbarem Wert. Unternehmen nutzen sie für eine Vielzahl von Vorgängen, darunter Risikomanagement, Bestandsoptimierung und Bedarfsprognose. Einige bemerkenswerte Beispiele sind Bing AI, Googles BARD und die ChatGPT-API.

6.1 Kunst

Seit der Einführung von DALL-E 2 im Jahr 2022 hat die Welt der Grafik einen dramatischen Wandel durchgemacht. Diese Technologie kann Bilder basierend auf Textaufforderungen generieren, was künstlerische und berufliche Bedeutung hat. midjourney nutzt diese Technologie beispielsweise, um beeindruckend realistische Bilder zu erzeugen. Dieser kürzlich erschienene Artikel entmystifizierte Midjourney in einem detaillierten Leitfaden, der die Feinheiten der Plattform und ihre schnelle Entwicklung verdeutlichte. Darüber hinaus nutzen Plattformen wie Alpaca AI und Photoroom AI generative KI, um erweiterte Bildbearbeitungsfunktionen wie Hintergrundentfernung, Objektlöschung und sogar Gesichtswiederherstellung zu ermöglichen.

6.3 Videoproduktion

Auch wenn die Videoproduktion im Bereich der generativen künstlichen Intelligenz noch in den Kinderschuhen steckt, zeigt sie vielversprechende Fortschritte. Plattformen wie Imagen Video, Meta Make A Video und Runway Gen-2 erweitern die Grenzen des Möglichen, auch wenn eine wirklich authentische Ausgabe noch in Sicht ist. Diese Modelle bieten einen enormen Nutzen für die Erstellung digitaler menschlicher Videos, allen voran Anwendungen wie Synthesia und SuperCreator. Insbesondere bietet Tavus AI ein Alleinstellungsmerkmal, indem es personalisierte Videos an einzelne Zielgruppen liefert, was für Unternehmen ein Segen ist.

6.4 Code-Erstellung

Codierung ist ein integraler Aspekt unserer digitalen Welt, der auch von generativer künstlicher Intelligenz beeinflusst wird. Während ChatGPT ein beliebtes Tool ist, wurden mehrere andere Anwendungen der künstlichen Intelligenz für Codierungszwecke entwickelt. Diese Plattformen wie GitHub Copilot, Alphacode und CodeComplete fungieren als Codierungsassistenten und können sogar Code basierend auf Texteingaben generieren. Interessant ist, wie anpassungsfähig diese Tools sind. Codex, die treibende Kraft hinter GitHub Copilot, kann an den eigenen Programmierstil angepasst werden und unterstreicht das Personalisierungspotenzial generativer KI.

7. Fazit

Die Kombination menschlicher Kreativität mit maschinellem Computing ist zu einem unschätzbar wertvollen Werkzeug geworden, wobei Plattformen wie ChatGPT und DALL-E 2 weiterhin die Grenzen unserer Vorstellungskraft erweitern. Sie sind in der Lage, nicht nur Textinhalte, sondern auch visuelle Kunstwerke mit einem breiten und vielfältigen Anwendungsspektrum zu produzieren.

Doch wie bei jeder Technologie sind ihre ethischen Implikationen von entscheidender Bedeutung. Während generative KI ein endloses kreatives Potenzial mit sich bringt, müssen wir sie auch verantwortungsvoll nutzen und uns ihres Potenzials für Voreingenommenheit und Datenmanipulation bewusst sein.

Da Tools wie ChatGPT immer benutzerfreundlicher werden, ist jetzt der perfekte Zeitpunkt, es auszuprobieren und zu experimentieren. Ganz gleich, ob Sie Künstler, Programmierer oder Technikbegeisterter sind, das Gebiet der generativen künstlichen Intelligenz ist voller Möglichkeiten, die darauf warten, erkundet zu werden.