In einem Blog Post veröffentlicht letzte Woche, fragt Meta, „Wo sind die Roboter?“ Die Antwort ist einfach. Sie sind hier. Man muss nur wissen, wo man suchen muss. Es ist eine frustrierende Antwort. Ich erkenne das. Lassen wir Gespräche über Autos und Fahrerassistenz beiseite und konzentrieren wir uns nur auf Dinge, bei denen wir uns alle einig sind, dass es sich um Roboter handelt. Zunächst einmal kommt diese Amazon-Lieferung ohne Roboterunterstützung nicht zu Ihnen.

Eine relevantere Frage wäre: Warum gibt es nicht mehr Roboter? Und was noch wichtiger ist, warum gibt es im Moment nicht mehr Roboter in meinem Haus? Es ist eine komplexe Frage mit vielen Nuancen – ein Großteil davon hängt mit dem aktuellen Stand der Hardwarebeschränkungen rund um das Konzept eines „Allzweck“ -Roboters zusammen. Roomba ist ein Roboter. Es gibt viele Roombas auf der Welt, und das liegt vor allem daran, dass Roombas eine Sache gut machen (ein zusätzliches Jahrzehnt Forschung und Entwicklung hat dazu beigetragen, die Dinge von einem Zustand von „ziemlich gut“ voranzubringen).

Es geht weniger darum, dass die Prämisse der Frage fehlerhaft ist – es geht vielmehr darum, sie leicht umzuformulieren. „Warum gibt es nicht mehr Roboter?“ ist eine absolut berechtigte Frage für einen Nichtrobotiker. Als langjähriger Hardware-Fachmann beginne ich meine Antwort normalerweise dort. Ich habe in den letzten zehn Jahren genug Gespräche geführt, dass ich ziemlich zuversichtlich bin, dass ich das gesamte Gespräch über die vielen potenziellen Fehlerpunkte mit einem Robotergreifer monopolisieren könnte.

Metas Einstellung ist softwarebasiert, und das ist fair genug. In den letzten Jahren war ich Zeuge einer Explosion von Startups, die sich mit verschiedenen wichtigen Kategorien wie Robotic Learning, Deployment/Management und No- und Low-Code-Lösungen befassten. Ein immergrüner Gruß hier an die fast zwei Jahrzehnte der Forschung und Entwicklung, die in die Erstellung, Wartung und Verbesserung von ROS geflossen sind. Passenderweise wurde der langjährige Verwalter Open Robotics von Alphabet übernommen, das seine eigene Arbeit in der Kategorie durch die hausgemachten Bemühungen Intrinsic und Everyday Robots geleistet hat (die allerdings unverhältnismäßig stark von der organisationsweiten Ressourcenkürzung betroffen waren).

Meta/Facebook macht zweifellos seinen eigenen Anteil an Skunkworks-Projekten, die hin und wieder auftauchen. Ich habe bisher nichts gesehen, was darauf hindeutet, dass sie mit dem, was Alphabet/Google im Laufe der Jahre erforscht hat, vergleichbar sind, aber es ist immer interessant zu sehen, wie einige dieser Projekte ihre Köpfe herausschauen. In einer Ankündigung, von der ich stark vermute, dass sie mit der Verbreitung generativer KI-Diskussionen zusammenhängt, hat der Social-Media-Riese „zwei große Fortschritte in Richtung verkörperter KI-Agenten für allgemeine Zwecke, die in der Lage sind, herausfordernde sensomotorische Fähigkeiten auszuführen“, geteilt.

Hier direkt zitieren:

Ein künstlicher visueller Kortex (genannt VC-1): ein einzelnes Wahrnehmungsmodell, das zum ersten Mal eine Vielzahl von sensomotorischen Fähigkeiten, Umgebungen und Verkörperungen unterstützt. VC-1 wird anhand von Videos von Menschen trainiert, die alltägliche Aufgaben aus dem bahnbrechenden Ego4D-Datensatz ausführen, der von Meta AI und akademischen Partnern erstellt wurde. Und VC-1 erreicht oder übertrifft die bekanntesten Ergebnisse bei 17 verschiedenen sensomotorischen Aufgaben in virtuellen Umgebungen.

Ein neuer Ansatz namens adaptive (sensomotorische) Fähigkeitskoordination (ASC), der eine nahezu perfekte Leistung (98 Prozent Erfolg) bei der herausfordernden Aufgabe der robotergestützten mobilen Manipulation (Navigation zu einem Objekt, Aufnehmen, Navigieren zu einem anderen Ort, Platzieren des Objekts) erzielt Objekt, sich wiederholend) in physischen Umgebungen.

Bildnachweis: Meta

Zweifellos interessante Forschung, und ich freue mich darauf, einiges davon möglicherweise genauer zu untersuchen und weiterzumachen. Der Ausdruck „allgemeiner Zweck“ wird heutzutage viel herumgeworfen. Es ist ein ständig interessantes Gesprächsthema in der Robotik, aber nach der Enthüllung des Tesla-Bots hat es eine massive Verbreitung von humanoiden Allzweckrobotern gegeben, die aus dem Holzwerk kommen. Jahrelang haben mir Leute Dinge gesagt wie: „Sag was du willst über Musk, aber Tesla hat das Interesse an Elektrofahrzeugen neu geweckt“, und so denke ich im Moment mehr oder weniger über Optimus. Es hat eine wichtige doppelte Rolle gespielt, die Diskussion um den Formfaktor zu erneuern und gleichzeitig ein klares Bild zu bieten, auf das man hinweisen kann, wenn man erklärt, wie schwer dieses Zeug ist. Ist es möglich, die Erwartungen der Öffentlichkeit dramatisch zu steigern und sie gleichzeitig zu dämpfen?

Auch hier passen diese Gespräche gut zu all diesen GPT-Durchbrüchen. Dieses Zeug ist alles sehr beeindruckend, aber Rodney Brooks hat vor ein paar Wochen in genau diesem Newsletter die Gefahr der Vermischung recht gut formuliert: „Ich denke, die Leute sind zu optimistisch. Sie verwechseln Leistung mit Kompetenz. Sie sehen eine gute Leistung in einem Menschen, Sie können sagen, worin sie kompetent sind. Wir sind ziemlich gut darin, Menschen zu modellieren, aber dieselben Modelle gelten nicht. Sie sehen eine großartige Leistung von einem dieser Systeme, aber es sagt Ihnen nicht, wie es in einem angrenzenden Raum oder mit anderen Daten funktionieren wird.“

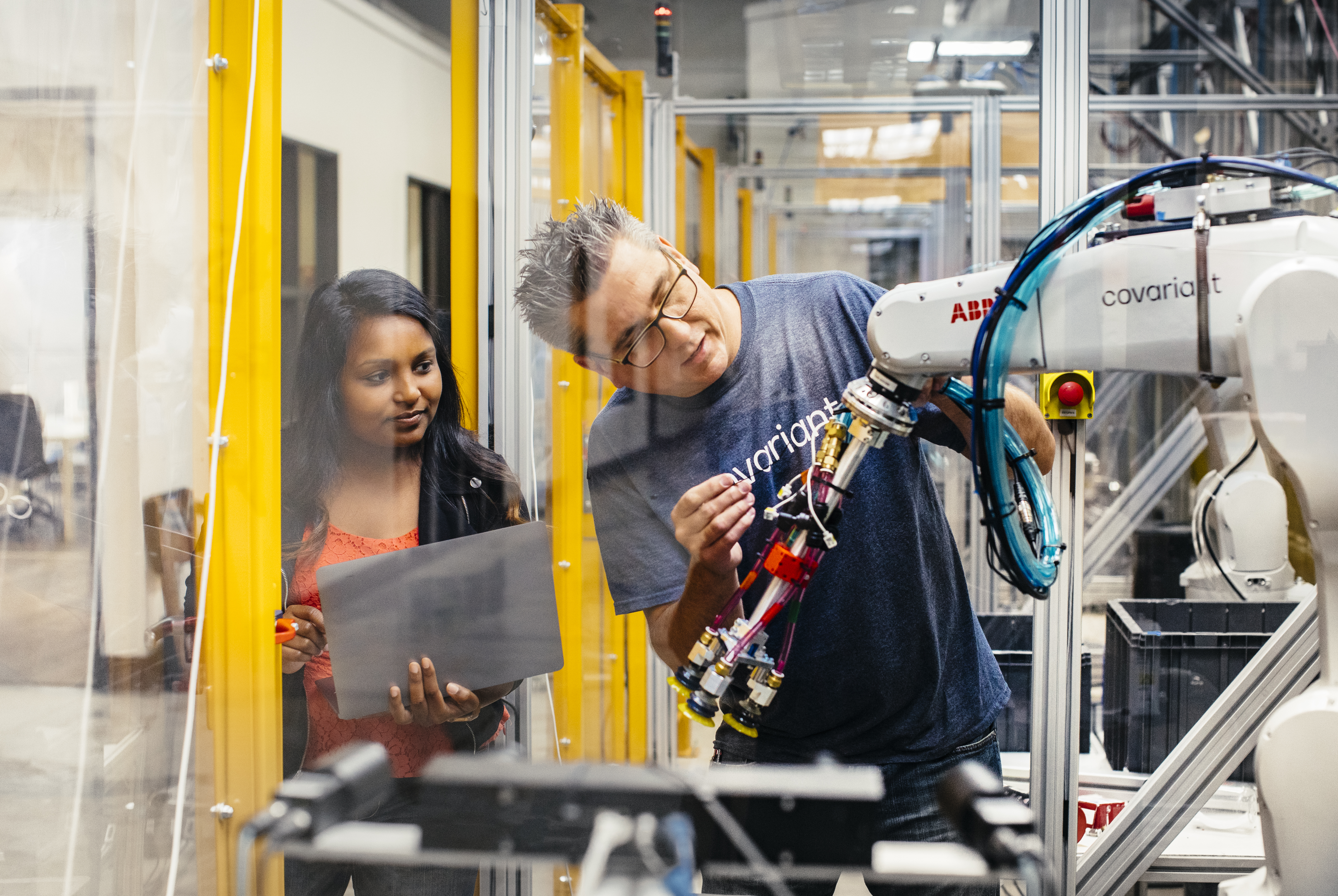

Bildnachweis: Kovariant

Das hat mich natürlich nicht davon abgehalten, die meisten Leute, mit denen ich auf der ProMat gesprochen habe, nach ihrer Meinung zur zukünftigen Rolle der generativen KI in der Robotik zu fragen. Die Antworten waren. . . breit gefächert. Einige zucken ab, andere sehen eine sehr reglementierte Rolle für die Technologie, und andere sind immer noch äußerst optimistisch, was das alles für die Zukunft bedeutet. Im Newsletter der letzten Woche bot Peter Chen, der CEO von Covariant (der gerade neue 75 Millionen US-Dollar gesammelt hat), einen interessanten Kontext zum Thema generalisierte KI:

Vor dem kürzlich erschienenen ChatGPT gab es viele KIs zur Verarbeitung natürlicher Sprache. Suchen, übersetzen, Stimmungserkennung, Spam-Erkennung – es gab jede Menge KIs für natürliche Sprache. Der Ansatz vor GPT besteht darin, dass Sie für jeden Anwendungsfall eine bestimmte KI darauf trainieren, indem Sie eine kleinere Teilmenge von Daten verwenden. Schauen Sie sich jetzt die Ergebnisse an, und GPT schafft im Grunde das Gebiet der Übersetzung ab, und es ist nicht einmal auf die Übersetzung trainiert. Der Ansatz des Basismodells ist im Grunde genommen, anstatt kleine Datenmengen zu verwenden, die spezifisch für eine Situation sind, oder ein Modell zu trainieren, das spezifisch für einen Umstand ist, trainieren wir ein großes Basis-generalisiertes Modell mit viel mehr Daten, sodass die KI allgemeiner ist.

Natürlich konzentriert sich Covariant derzeit stark auf das Picken und Platzieren. Es ist ehrlich gesagt eine Herausforderung, die groß genug ist, um sie lange Zeit zu beschäftigen. Aber eines der vielversprechenden Systeme wie dieses Angebot ist reales Training. Unternehmen, die echte Roboter haben, die echte Aufgaben in der realen Welt erledigen, bauen extrem leistungsfähige Datenbanken und Modelle darüber auf, wie Maschinen mit der Welt um sie herum interagieren (die Wände einer Forschungseinrichtung können in dieser Hinsicht einschränkend sein).

Es ist nicht schwer zu erkennen, wie viele der scheinbar unvereinbaren Bausteine, die von Forschern und Unternehmen gleichermaßen verstärkt werden, eines Tages zusammenkommen könnten, um ein wirklich universelles System zu schaffen. Wenn die Hardware und die KI auf diesem Niveau sind, wird es eine scheinbar unerschöpfliche Fundgrube an Felddaten geben, mit denen sie trainiert werden können. Ich gebe zu, dass ich bei ProMat ein wenig robotergesteuertes Dienstplanmischen und -abgleichen durchgeführt habe, um festzustellen, wie nah wir am aktuellen Stand der kommerziell erhältlichen Technologie sind.

Vorerst macht der Plattform-Ansatz durchaus Sinn. Mit Spot zum Beispiel verkauft Boston Dynamics Kunden effektiv ein iPhone-Modell. Zuerst produzieren Sie die erste Generation eines beeindruckenden Stücks Hardware. Als nächstes bieten Sie Interessenten ein SDK an. Wenn alles wie geplant läuft, kann dieses Produkt plötzlich Dinge tun, die sich Ihr Team nie hätte träumen lassen. Unter der Annahme, dass dabei keine Pistole an der Rückseite des Produkts angebracht werden muss (gemäß den Richtlinien von BD), ist das ein aufregender Vorschlag.

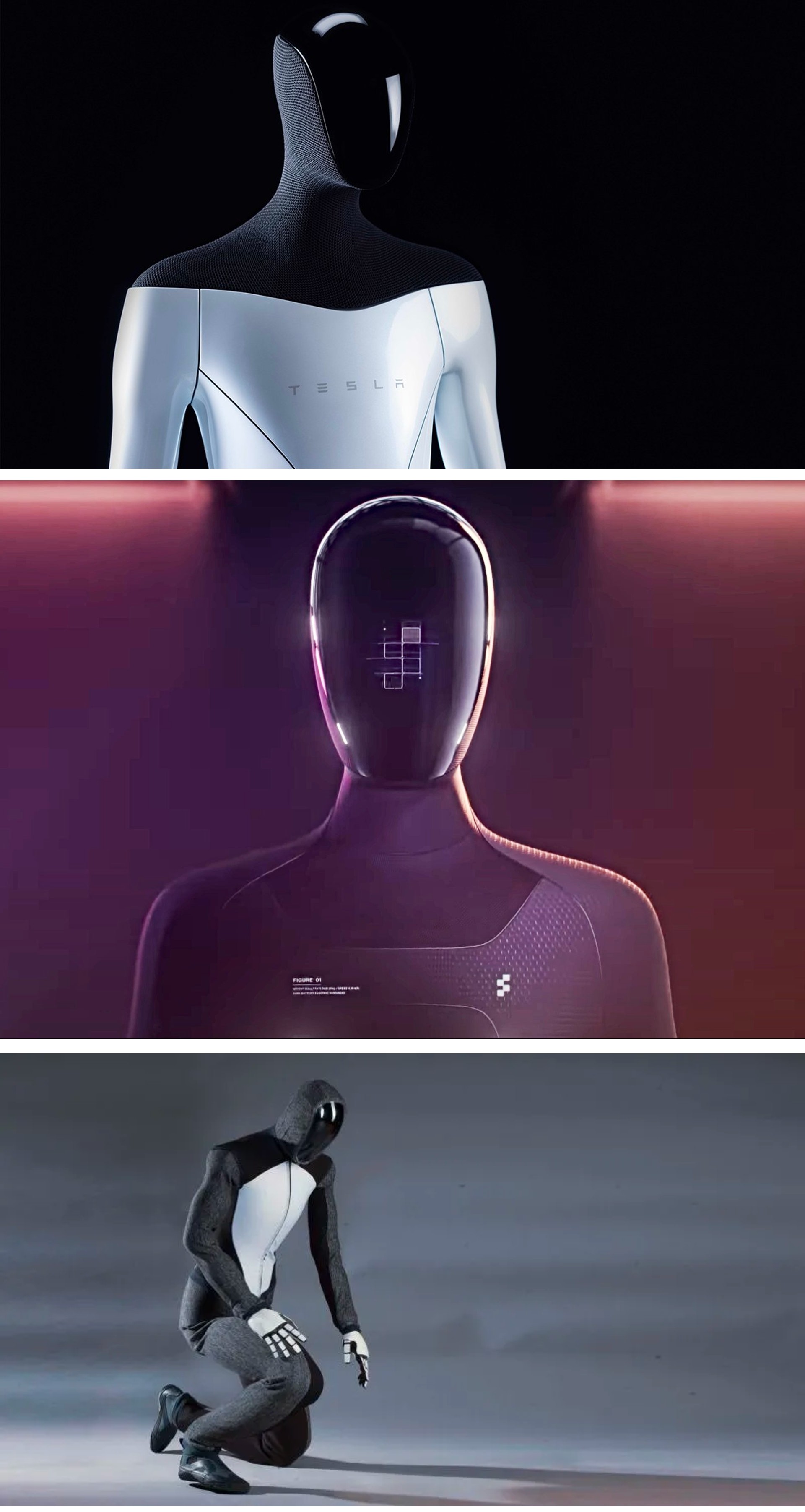

Bildnachweis: 1X

Es ist viel zu früh, um etwas Bestimmtes darüber zu sagen NEO-Roboter von 1X Technologies, abgesehen von der Tatsache, dass die Firma eindeutig hofft, genau in diesem Schnittpunkt zwischen Robotik und generativer KI zu leben. Sicherlich hat es in OpenAI einen mächtigen Verbündeten. Der Startup Fund des generativen KI-Giganten leitete eine 23,5-Millionen-Dollar-Runde, an der unter anderem auch Tiger Global teilnahm.

Der Gründer und CEO von 1X, Bernt Øivind Børnich, sagt: „1X ist begeistert, dass OpenAI diese Runde anführt, weil wir in unseren Missionen übereinstimmen: die durchdachte Integration neuer Technologien in das tägliche Leben der Menschen. Mit der Unterstützung unserer Investoren werden wir weitere bedeutende Fortschritte im Bereich der Robotik machen und den globalen Arbeitsmarkt erweitern.“

Eine interessante Anmerkung dazu (zumindest für mich) ist, dass 1X tatsächlich seit einer Minute herumkickt. Die norwegische Firma war bis vor kurzem als Halodi bekannt (genau vor einem Monat) prägnantes Rebranding. Sie müssen nur ein oder zwei Jahre zurückgehen, um zu sehen, wie die Anfänge den humanoiden Formfaktor annehmen, den das Unternehmen entwickelt hat für Gastronomie. Die Technologie scheint definitiv ausgefeilter zu sein als ihr Gegenstück von 2021, aber die Radbasis verrät, wie viel weiter zu gehen ist, um zu einer Version des Roboters zu gelangen, die wir sehen, wenn er rendert.

Übrigens, vielleicht bin ich es, aber hier scheint eine konvergente Entwicklung stattzufinden:

Bildnachweis: Tesla/Figure/IX — Collage des Autors

Von oben nach unten sind dies Renderings von Tesla Optimus, Abbildung 01, und 1X Neo. Offensichtlich keine direkten Kopien, aber sie sehen auf jeden Fall so aus, als könnten sie Cousins sein. Neo ist derjenige, der darauf besteht, einen Hoodie zu tragen, selbst zu formellen Anlässen. Hören Sie, ich bin kein Industriedesigner, aber was ist mit einem Cowboyhut oder so?

Bildnachweis: MIT CSAIL

Was sagen wir, wenn wir die Nachrichtenwoche mit zwei Forschungsprojekten beenden? Das erste ist ein lustiges aus dem MIT. Wenn Sie wirklich darüber nachdenken, ist Fußballspielen eine großartige Möglichkeit, die Fortbewegung zu testen. Es gibt einen Grund, warum der Robocup seit fast 20 Jahren aktiv ist. Im Fall von Dribblebot ist die Herausforderung jedoch unebenes Gelände – dazu gehören Dinge wie Gras, Schlamm und Sand.

Das sagt MIT-Professor Pulkit Agrawal:

Wenn Sie sich heute umsehen, sind die meisten Roboter auf Rädern. Aber stellen Sie sich vor, es gibt ein Katastrophenszenario, eine Überschwemmung oder ein Erdbeben, und wir möchten, dass Roboter Menschen bei der Suche und Rettung helfen. Wir brauchen die Maschinen, um über Gelände zu fahren, das nicht flach ist, und Roboter auf Rädern können diese Landschaften nicht durchqueren. Der springende Punkt beim Studium von Robotern mit Beinen ist es, sich in Gebiete zu begeben, die außerhalb der Reichweite aktueller Robotersysteme liegen.

Bildnachweis: UCLA

Das zweite Forschungsprojekt stammt von der Samueli School of Engineering der UCLA, die kürzlich erschienen Erkenntnisse aus seiner Arbeit rund um Origami-Roboter. Die Origami MechanoBots oder „OrigamiMechs“ verlassen sich auf Sensoren, die in ihre dünnen Polyester-Bausteine eingebettet sind. Der leitende Ermittler Ankur Mehta hat einige ziemlich weit hergeholte Pläne für die Technologie.

„Bei diesen Arten von gefährlichen oder unvorhersehbaren Szenarien, wie etwa während einer natürlichen oder von Menschen verursachten Katastrophe, könnten sich Origami-Roboter als besonders nützlich erweisen“, sagte er in einem an die Nachrichten gebundenen Beitrag. „Die Roboter konnten für Spezialfunktionen entworfen und sehr schnell nach Bedarf hergestellt werden. Auch wenn es sehr weit weg ist, könnte es Umgebungen auf anderen Planeten geben, in denen Erkundungsroboter, die für diese Szenarien unempfindlich sind, sehr wünschenswert wären.“

Es ist nicht ganz die Oberfläche der Venus, aber die Beute erkennende Fliegenfalle ist trotzdem ziemlich ordentlich.

Arbeitsplätze

In Ordnung, wie wäre es mit einer neuen Runde von Stellenangeboten? Ich plane, dies weiterhin regelmäßig in Stücken zu tun, auch in Zukunft. Der beste Weg, um aufgelistet zu werden, ist Folgen Sie mir auf LinkedIn und antworte auf Threads, in denen ich ankündige, dass ein neuer Job ansteht. Dies ist sicherlich nicht der effizienteste Weg, es zu tun, aber es hat für mich funktioniert, also werde ich den Kurs beibehalten.

Wie ich diese Woche bereits erwähnt habe, werde ich diejenigen priorisieren, die zuvor noch nicht vorgestellt wurden.

Roboterjobs für Menschen

Flucht (14 Rollen)

Apptronik (20 Rollen)

Geschicklichkeit (18 Rollen)

Fingerhut (3 Rollen)

Phantom-Auto (21 Rollen)

Heiligtum KI (15 Rollen)

Slamcore (5 Rollen)

Gewebt von Toyota (4 Rollen)

Bildnachweis: Bryce Durbin/TechCrunch

Komm, entdecke ferne Welten mit Actuator. Abonnieren Sie hier.